怎么做网站或APP企业网站建设套餐上海

前向神经网络中的权重初始化策略详解

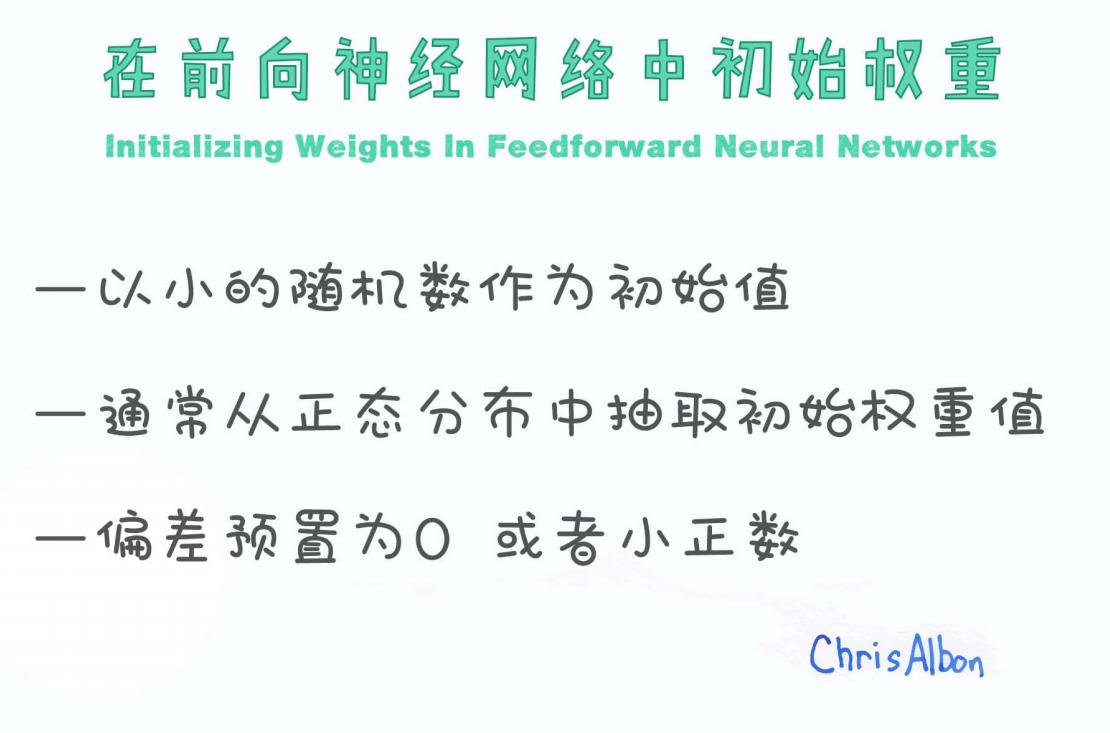

在神经网络模型中,“初始化”常常被认为只是模型训练前的一个小步骤,但它却可能决定了整个网络能否高效收敛,是否会出现梯度爆炸或消失的问题。今天,我们通过一张生动的手绘图,来拆解权重初始化的常见做法与其背后的逻辑。

图示来源与内容导读

首先来看这张图:

图中总结了神经网络中权重初始化的三大原则:

-

以小的随机数作为初始值

-

通常从正态分布中抽取初始权重值

-

偏差预置为 0 或小正数

这三条简单直白却非常关键,是深度学习中广泛实践的基础。

以小的随机数作为初始值

神经网络的每一层权重矩阵 WW,在初始化时不应为零或固定值,而应当是小幅度扰动的随机数。这是为了:

-

打破对称性(Symmetry Breaking):

如果所有神经元参数都相同,那么无论输入如何,它们的输出也将完全一样,导致网络无法学习有意义的特征。 -

保持梯度传播稳定:

如果初始化值太大,激活值或梯度可能会“爆炸”;如果太小,则可能“消失”。

常见做法:

-

从 [−0.1,0.1]、

这样的区间中均匀采样

-

或者从均值为 0、标准差为 0.01 的正态分布中采样

通常从正态分布中抽取初始权重值

多数深度学习框架(如 PyTorch、TensorFlow)都支持从正态分布中生成初始权重,例如:

但“正态分布”只是一个起点,后续研究提出了更加精细的初始化策略,如:

-

Xavier 初始化(Glorot Normal):

适用于

sigmoid或tanh激活函数。 -

He 初始化(Kaiming Normal):

适用于

ReLU激活函数。

目的:保持前向传播与反向传播时激活值与梯度的方差稳定,避免训练过程中“层数越深,问题越大”。

偏差预置为 0 或小正数

图中提到:“偏差预置为 0 或小正数”,这是因为:

-

偏置 bb 通常用于激活函数的平移,初始化为 0 不影响对称性打破;

-

某些情况下(如使用 ReLU),初始化为小正数可以让神经元更容易激活,减少“ReLU 死亡”。

举例来说,在 PyTorch 中初始化 bias 为零:

import torch.nn as nn

layer = nn.Linear(256, 128)

nn.init.zeros_(layer.bias)

实际代码演示(以 PyTorch 为例)

import torch.nn as nn

import torch.nn.init as init# 定义一个线性层

fc = nn.Linear(in_features=256, out_features=128)# Xavier 正态分布初始化(适合 sigmoid/tanh)

init.xavier_normal_(fc.weight)# 或 He 初始化(适合 ReLU)

init.kaiming_normal_(fc.weight, nonlinearity='relu')# 偏置初始化为0

init.zeros_(fc.bias)

这些初始化方式在 PyTorch 和 TensorFlow 中都非常方便使用,并已被集成到大多数高级 API 中。

总结

| 原则 | 解释 | 实践建议 |

|---|---|---|

| 小的随机数初始化 | 打破对称性,避免梯度爆炸 | 选取合适的分布和方差范围 |

| 正态分布采样 | 保持方差一致,收敛更快 | 根据激活函数选择 Xavier 或 He 初始化 |

| 偏置设置为0或小正数 | 不影响前期训练 | 通常设为0,ReLU中可用小正数 |

延伸阅读

-

《Understanding the difficulty of training deep feedforward neural networks》(Xavier 初始化的提出论文)

-

《Delving Deep into Rectifiers》(He 初始化论文)

-

PyTorch 官方文档:torch.nn.init

后记

虽然“初始化”只是神经网络训练前的一步,却直接影响到模型是否能够成功训练。如果你曾遇到“模型收敛特别慢”或者“训练结果一片混乱”的情况,不妨回头检查一下参数初始化方式。

如果你喜欢这类“理论 + 图解 + 实战”的内容,欢迎点赞、收藏或关注我,后续我还会更新不同初始化策略的对比实验与训练收敛曲线可视化分析!