导航滑动整屏网站品牌网站建设解决方案

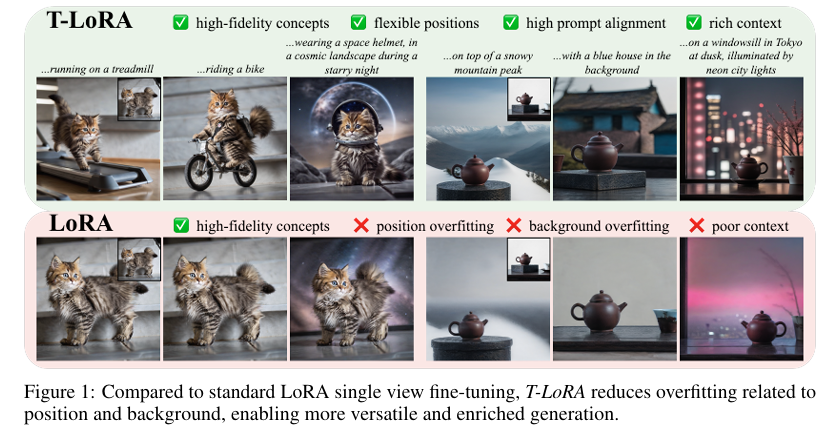

摘要:尽管扩散模型微调为定制预训练模型以生成特定对象提供了强大方法,但当训练样本有限时,模型常因过拟合问题导致泛化能力和输出多样性受损。本文聚焦于最具实用价值但极具挑战性的任务——仅使用单张概念图像实现扩散模型定制化。为此,我们提出一种名为T-LoRA(时序依赖低秩适配框架)的扩散模型个性化定制方法。研究发现,扩散过程中较高时间步的微调更易发生过拟合,因此需要一种对时间步敏感的微调策略。T-LoRA包含两大核心创新:(1)动态微调策略——根据扩散时间步调整受秩约束的参数更新;(2)权重参数化技术——通过正交初始化确保适配器组件间的独立性。大量实验表明,T-LoRA及其各组件在概念保真度与文本对齐度之间实现了更优平衡,性能显著优于标准LoRA及其他扩散模型个性化方法,充分展现了其在数据稀缺和资源受限场景下的应用潜力。代码已开源至:https://github.com/ControlGenAI/T-LoRA。Huggingface链接:Paper page,论文链接:2507.05964

研究背景和目的

研究背景

近年来,预训练的大规模文本到图像扩散模型在个性化内容生成方面取得了显著进展,这些模型能够生成高度特定和定制化的图像,如特定物体、风格或领域。然而,这些模型的个性化定制通常依赖于微调(fine-tuning)技术,即通过调整模型参数以生成用户指定的概念。尽管微调方法在生成高质量概念样本方面表现出色,但当训练样本数量有限时,模型容易陷入过拟合(overfitting),导致泛化能力下降和输出多样性受限。

过拟合问题在扩散模型中尤为突出,特别是在使用单张概念图像进行定制时。由于单张图像的背景、位置和姿态信息有限,模型在微调过程中容易“记忆”这些特定信息,从而无法生成多样化和灵活的场景结构。这不仅限制了模型的创造力,还降低了其在实际应用中的实用性。

研究目的

本研究旨在解决扩散模型在使用单张概念图像进行个性化定制时面临的过拟合问题。具体而言,研究的目标包括:

- 提出一种有效的微调策略:通过设计一种对扩散时间步敏感的微调策略,减少在高时间步(即噪声较大的步骤)的过拟合现象,同时保留模型在低时间步生成细节的能力。

- 引入低秩适配(Low-Rank Adaptation, LoRA)框架:在LoRA框架的基础上,提出一种时序依赖的低秩适配框架(T-LoRA),通过动态调整低秩矩阵的更新,实现更高效的模型个性化。

- 提升模型的泛化能力和输出多样性:通过实验验证,T-LoRA能够在保持概念保真度的同时,显著提高生成图像的文本对齐度和场景多样性。

- 探索正交初始化技术:提出一种正交初始化方法(Ortho-LoRA),确保适配器组件之间的独立性,进一步提升模型性能。

研究方法

数据集和实验设置

本研究使用了来自先前工作的25个概念,涵盖宠物、玩具、室内物品、配饰等多个类别。每个概念仅使用一张图像进行训练,以确保实验的挑战性和实用性。为了全面评估模型的性能,研究设计了多种文本提示,包括外观、位置和背景修改,以及复杂的复合提示。

实验中,研究采用了Stable Diffusion-XL模型作为基础模型,并在其上进行微调。为了比较不同方法的性能,研究还实现了标准LoRA、OFT、GSOFT和SVDiff等基线方法。

T-LoRA框架设计

T-LoRA框架的核心在于其时序依赖的低秩适配策略,具体包括以下两个关键创新:

- 动态微调策略(Vanilla T-LoRA):

- 时序依赖的秩掩码:通过定义一个与时间步相关的秩掩码,动态调整LoRA适配器在不同时间步的秩。具体而言,高时间步使用较低的秩,以减少过拟合;低时间步使用较高的秩,以保留细节生成能力。

- 线性递减函数:秩掩码的生成采用线性递减函数,确保在高时间步逐渐减少秩,而在低时间步保持高秩。

- 正交初始化技术(Ortho-LoRA):

- 正交矩阵初始化:通过奇异值分解(SVD)初始化LoRA适配器的权重矩阵,确保矩阵的正交性。这有助于减少不同时间步之间的信息干扰,提高模型的稳定性。

- 最后奇异值初始化:研究发现,使用随机矩阵的最后奇异值进行初始化,能够避免高奇异值导致的过拟合,同时保持模型的训练效率。

实验设计

为了全面评估T-LoRA的性能,研究设计了以下实验:

- 单图像定制实验:使用单张概念图像对模型进行微调,并生成多样化的图像以评估模型的泛化能力和输出多样性。

- 多图像定制实验:为了验证T-LoRA在数据量增加时的性能,研究还进行了多图像定制实验,比较T-LoRA与基线方法在不同数量训练图像下的表现。

- 用户研究:通过用户研究,评估生成图像在概念保真度和文本对齐度方面的主观感受。

研究结果

图像相似度和文本相似度

实验结果表明,T-LoRA在图像相似度(IS)和文本相似度(TS)方面均优于基线方法。具体而言:

- 图像相似度:T-LoRA在保持与基线方法相近的图像相似度的同时,显著提高了文本相似度。这表明T-LoRA能够在保持概念保真度的同时,更好地对齐文本提示。

- 文本相似度:在所有排名设置下,T-LoRA的文本相似度均显著高于LoRA和其他基线方法。这表明T-LoRA生成的图像更符合文本提示的要求。

多图像定制实验

在多图像定制实验中,T-LoRA同样表现出色。即使在使用单张图像进行训练时,T-LoRA的性能也优于使用多张图像训练的LoRA。这表明T-LoRA在数据稀缺的情况下仍能保持高效的模型个性化能力。

用户研究

用户研究结果显示,T-LoRA在概念保真度、文本对齐度和整体偏好方面均优于基线方法。具体而言:

- 概念保真度:用户认为T-LoRA生成的图像更准确地代表了原始概念。

- 文本对齐度:用户认为T-LoRA生成的图像更符合文本提示的要求。

- 整体偏好:在大多数情况下,用户更偏好T-LoRA生成的图像。

研究局限

尽管T-LoRA在扩散模型个性化方面取得了显著进展,但研究仍存在以下局限:

- 超参数选择:T-LoRA引入了一个新的超参数

r_min,用于控制低秩矩阵的最小秩。尽管研究发现将r_min设置为满秩的50%在大多数情况下表现良好,但最优选择可能因概念而异。未来研究需要探索更自适应的超参数选择方法。 - 训练时间:在较低的

r_min设置下,模型可能需要更长的训练时间或更复杂的秩调整策略。这增加了模型的训练成本,限制了其在资源受限场景下的应用。 - 计算开销:正交初始化技术(Ortho-LoRA)虽然提高了模型的稳定性,但也增加了计算开销。未来研究需要探索更高效的初始化方法,以减少计算成本。

- 多概念定制:本研究主要关注单概念定制,未来研究需要探索T-LoRA在多概念定制方面的性能,以满足更复杂的应用需求。

未来研究方向

针对上述研究局限,未来研究可以从以下几个方面展开:

- 自适应超参数选择:开发自适应的超参数选择方法,根据训练数据和模型性能动态调整

r_min和其他超参数,以提高模型的泛化能力和训练效率。 - 高效训练策略:探索更高效的训练策略,如渐进式训练、课程学习等,以减少训练时间和计算成本。

- 多模态初始化:研究多模态初始化方法,结合文本、图像等多种模态的信息,提高权重初始化的准确性和效率。

- 多概念定制:将T-LoRA框架扩展到多概念定制场景,探索如何同时定制多个概念并保持它们之间的独立性。

- 实际应用探索:将T-LoRA应用于实际场景中,如艺术创作、广告设计、虚拟试衣等,验证其在实际应用中的有效性和实用性。

总之,本研究提出的T-LoRA框架为扩散模型个性化提供了一种新的解决方案,通过时序依赖的低秩适配和正交初始化技术,显著提高了模型的泛化能力和输出多样性。未来研究可以进一步探索T-LoRA的优化方向和应用场景,推动扩散模型个性化技术的发展。