什么是双机热备系统?双机热备现在是否已经过时了?

一、双机热备的定义与核心机制

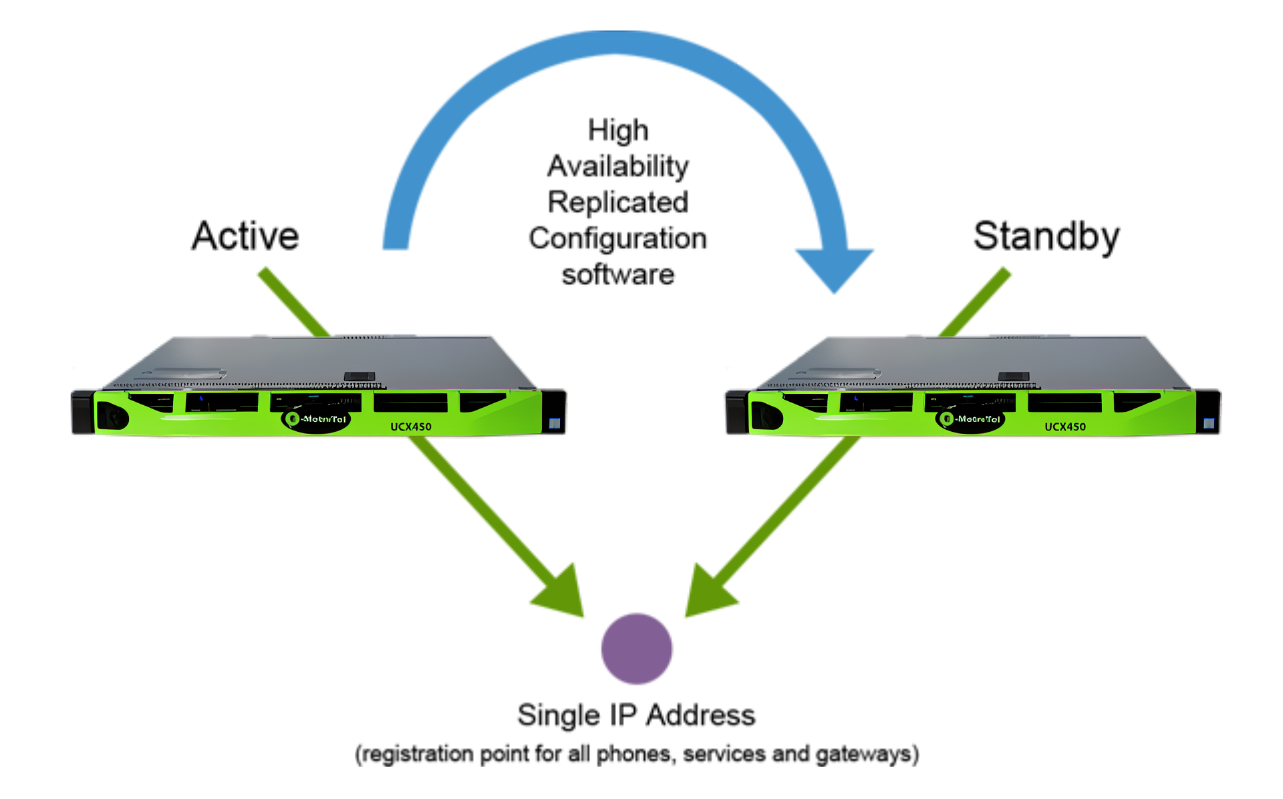

双机热备(Active-Standby HA) 是一种通过两台服务器(主备节点)实时同步数据或状态,在主节点故障时自动切换至备用节点的高可用性(High Availability, HA)方案。其核心目标是最小化业务中断时间(RTO)和保障数据零丢失(RPO=0)。

1. 工作原理

主节点(Active) 备节点(Standby)

├─ 运行业务服务 ├─ 实时同步数据(如数据库日志、内存状态)

└─ 对外提供服务 └─ 持续监控主节点健康状态

└─ 主节点故障时接管IP、挂载存储、启动服务

2. 关键技术

- 心跳检测(Heartbeat):通过专用网络链路周期性发送存活信号(如每1秒一次),超时判定主节点故障。

- 数据同步:

- 块级同步:DRBD(Linux)实时复制磁盘块变更。

- 应用级同步:数据库主从复制(如MySQL半同步)、文件系统镜像(如Windows DFS-R)。

- 故障切换(Failover):VIP漂移(Keepalived)、共享存储挂载(iSCSI/FC SAN)。

二、双机热备的适用性与局限性

1. 优势场景

| 场景 | 案例 | 选择理由 |

|---|---|---|

| 传统关键业务系统 | 银行核心交易系统、医院HIS系统 | 强一致性要求,无法接受分布式架构的最终一致性。 |

| 硬件资源有限 | 中小型企业本地机房(预算有限) | 仅需两台服务器,部署成本低。 |

| 垂直扩展型应用 | Oracle单实例数据库、老旧ERP系统 | 应用本身不支持水平扩展,依赖单机性能。 |

2. 核心缺陷

- 资源利用率低:备节点长期闲置(仅同步数据),硬件投资回报率(ROI)低。

- 扩展性差:无法横向扩展,性能受限于单节点硬件上限。

- 脑裂风险:网络分区时可能双主同时写数据,需依赖第三方仲裁(如Quorum Disk)。

- 存储单点故障:若依赖共享存储(SAN/NAS),存储设备故障将导致双机同时不可用。

三、双机热备是否过时?——现代高可用架构的演进

1. 传统双机热备的替代方案

| 方案 | 技术代表 | 对比优势 |

|---|---|---|

| 分布式集群 | Kubernetes、Cassandra、Ceph | 多节点自动负载均衡,无单点故障。 |

| 云原生高可用服务 | AWS RDS Multi-AZ、Azure SQL AlwaysOn | 全托管服务,跨可用区容灾,RTO<60秒。 |

| 超融合架构(HCI) | VMware vSAN、Nutanix | 存储与计算融合,节点故障自动迁移VM。 |

| 无状态服务+负载均衡 | Nginx/HAProxy + 容器化微服务 | 任意节点故障不影响整体服务,弹性扩缩容。 |

2. 双机热备的“过时”领域

- 互联网大规模服务:双机无法应对百万级并发,需分布式架构(如Redis Cluster、Kafka多副本)。

- 云原生应用:Kubernetes的Pod自动重启、Deployment多副本已内建高可用逻辑。

- 数据分析平台:Hadoop、Spark依赖多节点并行计算,双机架构无意义。

3. 双机热备的“不可替代”场景

- 强一致性数据库:Oracle RAC、SQL Server FCI仍依赖共享存储+双机热备架构。

- 边缘计算:恶劣网络环境下(如工厂车间),轻量级双机方案更易部署和维护。

- 合规性要求:金融、医疗等行业监管要求明确“主备容灾”模式,分布式架构可能不符合审计标准。

四、实践建议:如何选择高可用方案?

1. 决策树

2. 成本与复杂度权衡

| 方案 | 成本 | 运维复杂度 | 适用规模 |

|---|---|---|---|

| 双机热备 | 低 | 中 | 中小型关键业务 |

| Kubernetes集群 | 高 | 高 | 互联网级应用 |

| 云托管HA服务 | 中 | 低 | 公有云用户 |

| 超融合架构 | 中 | 中 | 企业私有云/混合云 |

五、总结

- 双机热备并未完全过时:在强一致性、边缘计算、合规场景仍是优选方案。

- 技术演进推动替代:云原生、分布式架构在弹性、成本、扩展性上更胜一筹。

- 混合架构趋势:传统双机热备可融入现代体系,如Oracle Data Guard + 云备份,实现多层次容灾。

最终建议:

- 老旧系统改造:维持双机热备,逐步迁移至容器化。

- 新建系统:优先考虑Kubernetes或云原生HA服务,避免技术债务。

- 合规场景:在满足审计要求的前提下,探索分布式一致性协议(如Raft)替代传统双机。