论文笔记(一百)GEN-0 / Embodied Foundation Models That Scale with Physical Interaction

GEN-0 / Embodied Foundation Models That Scale with Physical Interaction

- 文章概括

- 跨越智能阈值 Surpassing the Intelligence Threshold

- 机器人领域的扩展定律(Scaling Laws)

- 机器人领域不再受数据限制

- 绘制操作宇宙的全景图

- 面向互联网规模机器人数据的基础设施

- 预训练的科学

文章概括

引用:

@article{generalist2025gen0,author = {Generalist AI Team},title = {GEN-0: Embodied Foundation Models That Scale with Physical Interaction},journal = {Generalist AI Blog},year = {2025},note = {https://generalistai.com/blog/preview-uqlxvb-bb.html},

}

Generalist AI Team, "GEN-0: Embodied Foundation Models That Scale with Physical Interaction", Generalist AI Blog, Nov 2025.

主页:

原文: https://generalistai.com/blog/nov-04-2025-GEN-0

代码、数据和视频:

系列文章:

请在 《《《文章》》》 专栏中查找

宇宙声明!

引用解析部分属于自我理解补充,如有错误可以评论讨论然后改正!

多年来,机器人领域的基础模型主要依赖视觉-语言预训练作为扩大机器人能力规模的垫脚石,使我们能够从现有的大型多模态模型中迁移语义泛化的收益。但一直缺失的是:如何在机器人领域自身有效扩大大型多模态模型的训练规模——也就是建立“尺度扩展定律”,像其他领域(例如LLMs)那样,用更多算力与数据带来持续(且可预测)的机器人智能提升,并以此作为进步的根基。要做到这一点,需要一种能够推动新的感知-运动能力、带来行为泛化,并能随与真实物理世界交互所产生的海量且不断扩张的经验而共同成长的架构、训练流程与数据引擎。

为此,我们提出GEN-0:一类全新的具身基础模型,可直接基于高保真原始物理交互进行多模态训练。其架构既继承视觉与语言模型的优势,又超越它们——在本体上被设计为能够捕捉人类水平的反射反应与物理常识。其核心特性之一是“Harmonic Reasoning(谐振推理)”,即让模型在训练中无缝地“边思考,边行动”。我们先前的视频已展示了早期前身的一瞥能力;今天我们进一步表明:GEN-0不仅在基础能力上取得突破,而且这些能力还能随规模提升而“可扩展”:

-

跨越智能阈值——在前所未有的高数据量机器人训练范式下,我们在70亿参数处观察到一次“相变”:较小模型出现“僵化”,而更大的模型仍在持续提升。此后我们将GEN-0扩展至100亿以上参数规模,并观察到其对新任务的快速适应性,且所需的后训练愈来愈少。

-

尺度扩展定律——GEN-0呈现出强烈的扩展规律:更多的预训练数据与算力会在众多任务上持续(且可预测地)提升模型的后训练表现。

-

谐振推理——对语言聊天机器人而言,在回答之前“多想一会儿”是直接可行的;但对于在真实世界中行动的物理系统,这件事并不简单——物理世界不会暂停。为解决这一问题,谐振推理提出了一种全新的模型训练范式,在异步、连续时间的“感知token流”与“行动token流”之间建立“谐振式”的相互作用。这使我们无需依赖System1–System2架构或推理时引导,也能将规模扩展到非常大的模型。

-

跨机体——GEN-0的架构从设计之初就能适配不同类型的机器人。我们已在6自由度、7自由度以及16自由度以上的类人化机器人上完成了测试。

-

不再受数据限制——GEN-0在我们的自建机器人数据集上进行预训练,该数据集包含超过27万小时的真实世界多样化操控数据,并以每周一万小时的速度持续增长且在加速中。

-

预训练的科学——不同配比的预训练数据(来自多种来源,如数据工厂)会产出具备不同特性的GEN-0模型。我们分享了一些处于高数据量范式下的早期经验观察笔记,并说明这些现象如何回溯到具体的数据采集流程上。

我们认为,GEN-0标志着一个新时代的开端:在真实物理交互数据上,其能力可以可预测地随之扩展的具身基础模型——这种数据不仅来自文本、图像或仿真,而是来自真实世界。下面是GEN-0在全新任务中实际运行的一些视频:

https://generalistai.com/assets/videos/camera_pack_top.mp4

https://generalistai.com/assets/videos/phone_pack.mp4

https://generalistai.com/assets/videos/camera_pack_side.mp4

https://generalistai.com/assets/videos/camera_pack_robot_pov.mp4

https://generalistai.com/assets/videos/lego_build.mp4

https://generalistai.com/assets/videos/dexmate_fasteners.mp4

https://generalistai.com/assets/videos/box_pack_robot_pov.mp4

https://generalistai.com/assets/videos/box_pack_3x.mp4

将未见过的物体装进盒子(俯视视角)——这项任务用于评估模型的泛化能力和“物理常识”。具体来说,我们关注的是它在面对新物体高度多样的几何形状和物理属性时的推理能力——例如,在料箱中轻推并重新调整物体姿态以获得更好的抓取;根据物体的形状(以及如何更好地放入盒子)将其放在不同的位置;在盒子里推挤物体为其他物体腾出空间;以及从物体打滑的情况中恢复(例如一盒沉重的塑料回形针盒)。

跨越智能阈值 Surpassing the Intelligence Threshold

我们的扩展实验表明,GEN-0模型必须足够大,才能“吸收”海量的物理交互数据。我们观察到,在数据“超负荷”的情况下,小模型会出现类似“僵化”的现象,而更大的模型却能持续提升——这表明在模型智能容量上存在一次令人惊讶的“相变”:

- 10亿参数规模(1B)的模型在预训练阶段难以吸收复杂且多样的感知-运动数据——随着训练的推进,模型权重会逐渐丧失继续吸收新信息的能力。

- 60亿参数规模(6B)的模型开始真正从预训练中获益,并展现出较强的多任务能力。

- 70亿参数及以上规模(7B+)的模型能够真正“内化”大规模的机器人预训练数据,并且只需几千步的后续训练,就可以将这些能力有效迁移到下游任务中。

图1:在一个完全保留(即零样本)的长时域下游任务上,随着GEN-0模型尺寸的增大(以不同颜色表示),其在“下一步动作”验证集预测误差上的表现会得到提升(纵轴为预测误差,数值越低越好)。参数规模为1B的模型会较早且明显地出现“僵化”现象,而6B与7B模型在“吸收”预训练数据方面表现得更好。横轴表示预训练算力,并经过归一化处理,使GEN-0 7B对应的数值为1.01.01.0。

图1:在一个完全保留(即零样本)的长时域下游任务上,随着GEN-0模型尺寸的增大(以不同颜色表示),其在“下一步动作”验证集预测误差上的表现会得到提升(纵轴为预测误差,数值越低越好)。参数规模为1B的模型会较早且明显地出现“僵化”现象,而6B与7B模型在“吸收”预训练数据方面表现得更好。横轴表示预训练算力,并经过归一化处理,使GEN-0 7B对应的数值为1.01.01.0。

据我们所知,这是在机器人领域首次观察到模型“僵化”这一现象。此前研究之所以可能未能发现这一点,原因在于:(a) 机器人领域直到最近才进入高数据量范式;以及(b) 在这种范式下使用的模型规模也尚不足够大。在高数据量设置下,“僵化”现象先前已在LLM相关文献4,9中被观察到,但出现于规模小得多的模型上,其参数量约为O(10M)O(10\mathrm{M})O(10M),而非O(1B)O(1\mathrm{B})O(1B)。我们在机器人领域中发现这一“相变”却需要更大得多的模型规模,这一事实呼应了莫拉维克悖论:在人类看来毫不费力的感知与灵巧动作,其实比抽象推理需要高得多的计算复杂度。我们的实验表明,物理世界中的智能(即物理常识)在算力层面可能具有更高的“激活阈值”,而我们目前不过刚刚开始探索这一阈值之外的世界。

机器人领域的扩展定律(Scaling Laws)

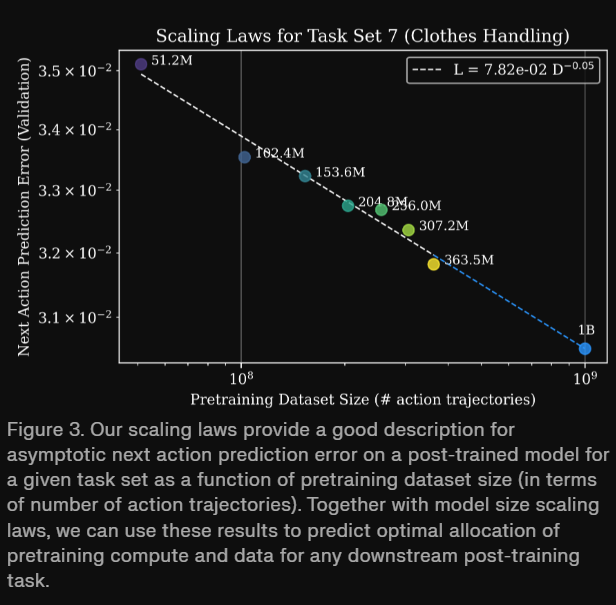

扩展定律通常在预训练阶段进行度量,如图1所示:该图展示了在预训练过程中,模型规模与算力在某个下游零样本任务上的关系。另一类扩展定律则关注:预训练所带来的收益如何在微调阶段持续存在。当模型规模足够大时,我们还观察到:预训练数据规模与下游后训练性能之间存在一种强烈的幂律关系(图3)。这一现象适用于我们所评估的全部任务,包括由合作伙伴与客户需求所启发的各类应用及其工作流程,涵盖广泛的工业领域——例如服装、制造、物流、汽车以及电子等。

更具体地说,我们选取了若干模型检查点(图2):这些检查点使用统一的训练流程在预训练数据集的不同子集上完成预训练;随后,我们在多任务、语言条件的数据上对这些检查点进行后训练,即在16个不同任务集合上同时进行有监督微调。我们发现:增加预训练量会在所有任务上提升下游模型的性能(图2)。

图2:随着预训练数据量的不断增大(以不同颜色表示),在后训练阶段,多任务模型在全部16个任务集合上的表现都会提升——具体体现在验证集损失(上方)以及下一步动作预测误差(下方4×44\times44×4网格)这两个指标上。这些任务包括用于评估灵巧度的任务(例如搭建乐高)、面向特定行业流程的任务(例如快餐打包),以及用于评估泛化能力的任务(例如“_ anything”类任务)。

图2:随着预训练数据量的不断增大(以不同颜色表示),在后训练阶段,多任务模型在全部16个任务集合上的表现都会提升——具体体现在验证集损失(上方)以及下一步动作预测误差(下方4×44\times44×4网格)这两个指标上。这些任务包括用于评估灵巧度的任务(例如搭建乐高)、面向特定行业流程的任务(例如快餐打包),以及用于评估泛化能力的任务(例如“_ anything”类任务)。

模型性能遵从一种可预测的幂律关系(见图3),借此我们可以回答如下问题:“要达到某个给定的下一步动作预测误差,需要多少预训练数据?”或者“在增加预训练数据的前提下,对于某个特定任务,我们可以用之‘兑换’多少后训练数据?” 在某个下游任务上,给定固定的数据与微调预算,并设预训练数据集的规模为可变的DDD,则该下游任务上的验证误差L(⋅)L(\cdot)L(⋅)可以通过如下形式的幂律关系进行预测:

L(D)=(Dc/D)αD.L(D) = (D_c / D)^{\alpha_{D}} \ . L(D)=(Dc/D)αD .

例如,在“Clothes Handling(衣物处理)”这一场景中(包括在真实工作环境中对衣物进行分类、理顺、扣纽扣以及悬挂等操作),只要给定10亿条动作轨迹,我们就可以预测模型在该任务上的表现。这些估计结果能够为与合作伙伴相关的任务讨论提供依据,并帮助评估:要达到某一特定性能水平,还需要增加多少数据。

机器人领域不再受数据限制

我们的基础模型是在前所未有的27万小时真实世界操作轨迹上训练而成的,这些数据来自全球数千个家庭、仓库与各类工作场所中涵盖多种活动的采集。目前,我们的机器人数据采集运营每周可以提供超过1万小时的新数据,而且这一速度仍在加快。这一切由一个全球性的硬件网络所支撑,其中包括数千台数据采集设备与机器人。

绘制操作宇宙的全景图

为扩展GEN-0的能力,我们正在构建有史以来规模最大、最为多样化的真实世界操作数据集,尽可能囊括人类能够想到的各类操作任务——从削土豆、拧螺栓,到家庭、面包房、自助洗衣店、仓库、工厂等各类场景中的操作。下面是我们为探索这一“操作宇宙”所构建的一个内部搜索工具示例:

https://generalistai.com/assets/images/data_search.mp4

面向互联网规模机器人数据的基础设施

要为此构建相应的运营与机器学习基础设施,绝非易事。针对这一规模的机器人模型与数据,我们自研了专用硬件、数据加载器以及网络基础设施(包括铺设新的专用互联网线路),以支撑来自全球各地多样化数据采集站点的上行带宽需求。我们谈判了多云服务合同,搭建了自定义的上传设备,将持续的多模态数据处理扩展到O(10K)O(10\mathrm{K})O(10K)个计算核心,并对数十PB级别的数据进行了压缩,采用前沿视频基础模型背后的数据加载技术,使系统在每一天的训练中都能“吸收”相当于6.85年真实世界操作经验的规模。

预训练的科学

通过大规模消融实验,我们发现:数据的质量与多样性比单纯的数据量更为重要;而经过精心设计的数据混合配比,会导向具有不同特性的预训练模型。例如,表1给出了在8个不同预训练数据集上训练得到的多种模型的性能指标,并展示了它们在10个长时域任务集合上微调后的下游影响;这些任务被划分为3组,用于评估不同维度:灵巧度、真实世界应用以及泛化能力。

性能度量基于验证预测均方误差MSEval=∣∣a⋆−a^∣∣22\text{MSE}_{\text{val}} = ||\mathbf{a}^{\star} - \hat{\mathbf{a}}||_2^2MSEval=∣∣a⋆−a^∣∣22以及反向Kullback–Leibler散度11(reverse KL),其中reverse KL更适合刻画“寻模行为”12,13。为估计reverse KL,我们采用Monte-Carlo估计器:策略通过在MMM个策略采样点a^mm=1M{\hat{\mathbf{a}}m}{m=1}^{M}a^mm=1M处构造单位方差高斯混合,诱导出经验分布

q=1M∑m=1MN(a;a^m,I)q=\frac{1}{M}\sum_{m=1}^{M}\mathcal{N}(\mathbf{a};\hat{\mathbf{a}}_m,\mathbf{I})q=M1∑m=1MN(a;a^m,I);

而数据/真实标注则在a⋆\mathbf{a}^\stara⋆处诱导出单位方差高斯分布p(a)=N(a;a⋆,I)p(\mathbf{a})=\mathcal{N}(\mathbf{a};\mathbf{a}^\star,\mathbf{I})p(a)=N(a;a⋆,I)。我们使用策略采样来近似该期望:

D^KL(q∣∣p)≈1M∑m=1M[logq(a^m)−logp(a^m)].\widehat{D}_{\mathrm{KL}}(q||p) \approx \frac{1}{M}\sum_{m=1}^{M}\Big[\log q(\hat{\mathbf{a}}_{m})-\log p(\hat{\mathbf{a}}_{m})\Big] \ . DKL(q∣∣p)≈M1m=1∑M[logq(a^m)−logp(a^m)] .

实验表明:同时具有较低预测误差与较低reverse KL的模型,在用于后训练的有监督微调(SFT)时往往表现更好;而具有较高预测误差但较低reverse KL的模型,在分布上往往更加多模态,这一特性有利于后续的强化学习训练。在大规模条件下采用多种数据采集策略,使我们能够持续进行A/B测试,从而判断哪类数据对预训练提升最大。