GradNorm

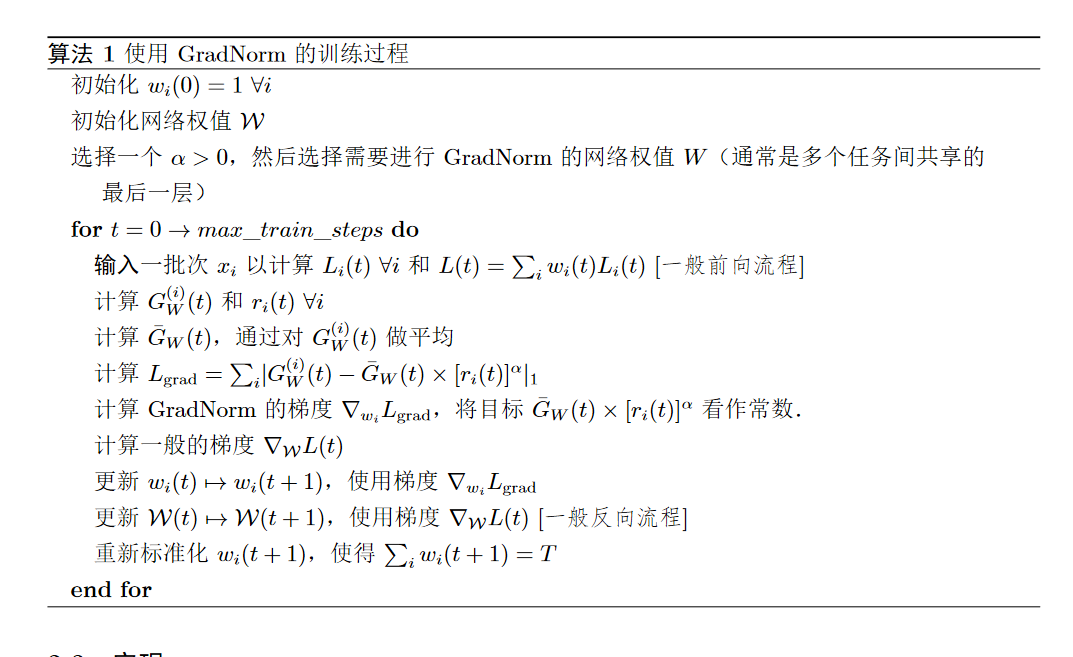

不同任务loss梯度的量级不同,造成有的task在梯度反向传播中占主导地位,模型过分学习该任务而忽视其它任务。此外,不同任务收敛速度不一致的,可能导致有些任务还处于欠拟合,可有些任务已经过拟合了。由于各任务在训练过程中自己的梯度量级和收敛速度也是动态变化的,所以很显然这样定值的w做并没有很好的解决问题。作者提出了一种可以动态调整loss的w的算法——GradNorm:

动态调整任务损失权重,通过学习每个任务的权重(在 loss 前乘以),使得各任务训练速率(loss 下降速率)保持平衡,从而缓解某些任务支配整个训练的问题。