【开发者导航】轻量可微调且开源的大语言模型家族:LLaMA

Hello大家好!我是助你打破信息差的

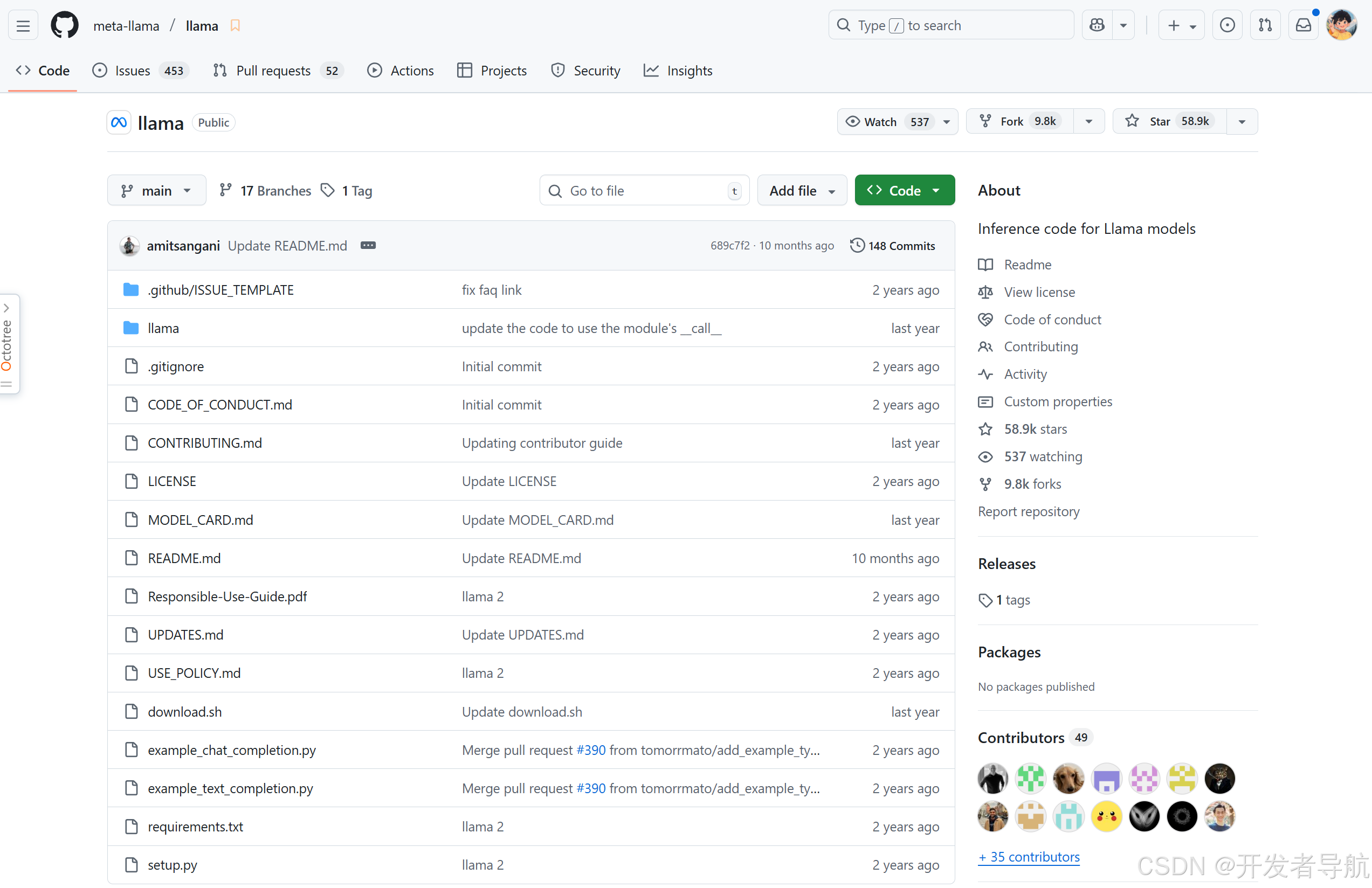

开发者导航。今天给大家分享的开源项目是【LLaMA】,一个【轻量可微调且开源的大语言模型家族工具】,希望这篇文章能够对你有所帮助。

想要体验大语言模型的强大功能,但又苦于高昂的云端服务费用或受限于闭源平台?Meta 推出的 LLaMA 系列为普通用户提供了灵活、可控的选择。它涵盖从 7B 到 70B 参数的多种规格,既能在消费级显卡上运行,也方便微调个性化模型。通过 LLaMA,开发者、研究者和爱好者可以构建聊天机器人、问答系统、内容生成工具,甚至训练垂直领域的专用模型,而无需依赖昂贵的闭源服务。

LLaMA 是什么?

LLaMA 是 Meta(Facebook 母公司)开源的大语言模型家族,面向研究和个人开发者提供不同规模的参数版本。它的设计理念是“轻量可运行、开源免费”,支持多语言输入,包括中文和英文。用户可以在本地或自建环境进行微调,结合社区提供的工具(如 Alpaca-LoRA)快速适配自己的需求。LLaMA 的开源生态成熟,便于开发者进行二次开发和实验,是学习和探索大语言模型的理想选择。

核心功能

LLaMA 的功能集中在灵活性、易用性和多场景适配上,适合研究者、开发者及爱好者。

- 多尺寸模型——提供 7B 至 70B 参数多种规格,可根据硬件选择适合的版本。

- 本地微调支持——兼容社区微调工具,普通用户也能快速定制模型。

- 多语言适配——支持中文、英文等主流语言的理解与生成。

- 聊天机器人开发——可用于构建对话系统,实现自然交流。

- 问答与知识检索——结合向量数据库或文档,生成个性化回答。

- 内容生成能力——可创作文本、文章、摘要或创意内容。

- 垂直领域模型训练——适合法律、医疗、金融等特定领域小模型微调。

- 开源生态丰富——社区提供大量工具、脚本和示例项目,方便二次开发。

使用场景

LLaMA 适合需要自主控制模型、微调定制或实验新算法的用户群体。

| 人群/角色 | 场景描述 | 推荐指数 |

|---|---|---|

| AI 开发者 | 构建聊天机器人或问答系统 | ★★★★★ |

| 研究人员 | 测试大语言模型微调与实验 | ★★★★★ |

| 内容创作者 | 自动生成文章、摘要、创意文本 | ★★★★☆ |

| 教育工作者 | 教学演示或训练特定领域模型 | ★★★★☆ |

| 技术爱好者 | 学习大语言模型原理与微调 | ★★★★★ |

操作指南

LLaMA 上手相对简单,社区工具丰富,可快速部署和微调。

- 从 GitHub 下载指定参数版本的模型。

- 配置运行环境(Python、PyTorch、CUDA 等)。

- 使用社区微调工具(如 Alpaca-LoRA)进行个性化训练。

- 准备输入数据或语料库进行模型适配。

- 测试生成输出,调整超参数优化效果。

- 可结合前端或 API 构建聊天机器人或问答系统。

- 若训练大模型,建议在具备 GPU 的环境下运行。

- 生成后可导出模型用于本地或服务器部署。

(初次使用建议从小型号开始,逐步熟悉微调流程。)

支持平台

LLaMA 支持 Windows、macOS 和 Linux 桌面及服务器环境。用户可以在本地 GPU 或云端服务器运行,也可结合 Python API 与自建前端实现应用部署。小型模型在普通显卡上可直接微调,大型模型则推荐多 GPU 或服务器环境。

产品定价

LLaMA 为 免费开源,用户可以自由下载、使用、微调或再分发。唯一可能产生成本的是运行环境,如 GPU 或云计算资源,用户需自行承担。

常见问题

Q:LLaMA 是否可以在普通电脑上运行?

A:小型号(7B)可在消费级显卡运行,大型号(30B、70B)建议多 GPU 或服务器环境。

Q:是否支持中文?

A:支持中文、英文及其他主流语言,生成效果取决于微调数据。

Q:与 GPT-4 相比如何?

A:LLaMA 免费开源、易于微调,但综合能力略低于 GPT-4,适合自定义和研究。

开发者小结

LLaMA 以开源、轻量、易微调为核心优势,适合希望自主控制大语言模型的用户。它特别适用于学习、研究、内容生成和构建垂直领域应用。相比闭源大模型,LLaMA 让普通用户也能在本地运行和微调,灵活性更高。对于追求极致性能或最前沿能力的用户,GPT-4 等闭源平台仍具有优势,但在开源生态、可定制性和学习研究场景中,LLaMA 是一个非常实用的选择。