CosyVoice 2 部署加速推理模型(Ubuntu 24.04)

前面的文章 https://blog.csdn.net/hjh2005/article/details/154354244 已经介绍了如何在 Windows 系统本地部署 CosyVoice 2,音频生成的速度比较慢,生成一段7秒左右的音频时间超过了7秒,这个性能用在实时语音交互的场景是不行的。

然后文章 https://blog.csdn.net/hjh2005/article/details/154479813 又介绍了在Windows 系统部署加速推理模型的方法,但是由于 Window 系统中 Docker 的 CUDA IPC 共享内存支持不好,导致推理的时候报错,所以只能转战 Linux 系统。

本文描述基于 Ubuntu 24.04.3 系统,同时参考 https://github.com/FunAudioLLM/CosyVoice/tree/main/runtime/triton_trtllm TensorRT-LLM 和 NVIDIA Triton 推理服务进行加速推理。

0、前置条件

1)科学上网:强烈建议想办法实现科学上网,不然连 NVIDIA 的很多安装包都无法安装;

2)显存:使用 TensorRT-LLM 部署 CosyVoice2-0.5B 模型,需要的显存显著增加,大概要7G左右,所以建议显存12G或以上;

3)磁盘:使用 Docker 安装,镜像加容器大概需要80G的空间,建议磁盘空间要大于80G;

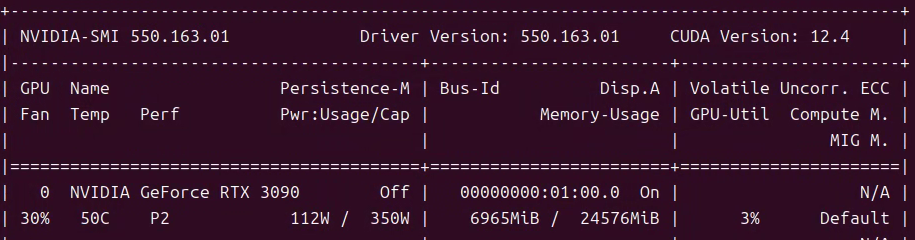

4)确保已经安装了 NVIDIA 显卡驱动: 在终端中执行:nvidia-smi 命令,如果看到类似以下界面则说明已经安装了驱动,否则请先安装最新的驱动:

5)安装 Docker:参考 https://docs.docker.com/engine/install/ubuntu/#install-using-the-repository 进行安装,建议先不要安装 Docker Desktop,我原来的 Ubuntu 22.04 安装了 Docker Desktop 后重启,无法进入系统了,所以重新安装了 24.04.3 系统,该系统自带 Nvidia 的驱动。

6)安装 NVIDIA Container Toolkit:如未安装此工具,Docker 容器将无法使用显卡资源,可能会报类似 Error response from daemon: could not select device driver "nvidia" with capabilities: [[gpu]] 的错误。安装方法参考:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html#with-apt-ubuntu-debian

7)安装 MiniConda:参考: