Anatomy-guided Pathology Segmentation

解剖引导病理分割(MICCAI会议)

Abstract(摘要)

病理结构在医学图像中通常表现为对患者预期解剖结构的偏离。尽管临床医生在诊断时会综合考虑解剖与病理之间的相互关系,但近期的深度学习算法往往只专注于识别二者之一,很少从这种联合视角来审视患者的身体。在本文中,我们开发了一种通用的分割模型,能够融合解剖信息与病理信息,旨在提升病理特征的分割准确性。我们提出的 解剖-病理交换(Anatomy-Pathology Exchange, APEx)训练方法 采用了一种基于查询的分割 Transformer,它将一个联合特征空间解码为用于人体解剖的查询表示,并通过一种混合策略将其交织到病理解码器中,从而实现以解剖信息引导的病理预测。通过这种方式,我们在 FDG-PET-CT 和胸部 X 光片的病理分割任务上均取得了当前最佳结果,相比强大的基线方法,性能提升最高达 3.3%。代码和模型将公开发布于:github.com/alexanderjaus/APEx。

Introduction(引言)

在长期的专业训练中,放射科医生深入学习了人体生物学和生理学知识,使他们能够识别健康个体及患病者解剖结构中的典型模式。多年的临床实践赋予医生一种能力:利用对身体结构的底层认知,将极其细微的视觉解剖异常与特定疾病准确关联起来。这种综合考虑组织解剖与病理的整体性方法,与当前大量自动病理分割模型形成了鲜明对比——后者通常只专注于狭窄的疾病类型,缺乏对身体结构的整体理解 [23,16]。

这些现有模型通常是端到端的语义分割学习器 [22,21],其设计思路源于自然图像领域,因此几乎可以不加区分地应用于从街景 [29] 到日常物体分割 [6,25] 等各种任务。然而,医学影像领域存在一个显而易见却常被忽视的连续性:其上下文始终是人体,始终包含患者的解剖结构。

尽管患者个体的解剖特征存在差异,但将解剖与病理关联起来用于放射学评估的医学先验却是恒定的。例如一些简单观察:“骨折必然发生在骨结构上”,或“肿瘤位置往往对应特定的解剖区域”。在识别病理时,当前的分割模型可能在训练过程中偶然捕捉到一些解剖-病理相关性,但这与主动利用解剖先验来指导病理识别的方向恰恰相反。

本着医生的工作流程精神,我们提出一个问题:显式学习到的人体解剖知识,能否提升模型预测病理结构的能力?

在本研究中,我们探索了多种策略,将解剖学知识(建模为解剖标签)融入模型,以改进病理预测。受医学专业人员培训方式的启发,我们提出了一种联合训练方案:通过我们提出的 APEx 架构,网络同时学习预测解剖结构和病理。

我们的主要贡献总结如下:

- 我们系统评估了多种将所学解剖知识融入病理分割模型的策略;

- 我们提出了一种基于查询的、联合解剖与病理的实例分割模型 APEx,该模型通过共享嵌入和查询混合机制,将解剖知识融入病理预测;

- 我们在两个不同的医学数据集上验证了 APEx 的性能,涵盖全身 FDG-PET-CT 和胸部 X 光片,涉及骨骼、器官和血管等多样化解剖结构,在联合解剖-病理识别任务上分别实现了 +2.0% 和 +3.3% 的性能提升。

相关工作:利用解剖学知识作为先验信息,已在一些先前的研究中得到探讨,其形式包括形状约束 [27,20,18]、预期纹理 [11] 或基于图谱(atlas-based)的分割模型 [10],以辅助分割任务。尽管这些工作大多旨在分割解剖结构本身,但已有部分研究开始尝试利用解剖先验来改进 X 光片中的病理检测 [17] 或 CT 图像中的结直肠癌分割 [28]。这些研究凸显了使用解剖先验的有益效果,但主要依赖于为特定应用场景手工设计的特征(例如,肠壁对于检测结直肠癌至关重要)。

在本工作中,我们并未沿用手工设计特征的思路,而是选择了一种更具数据驱动性且符合深度学习理念的方法:我们探究了通过学习获得的解剖特征在辅助病理分割中的有效性。这一方法摆脱了手工先验的局限性,并使我们能够充分利用近期发布的整体性解剖数据集 [26,12,24] 中所蕴含的知识。我们假设:利用解剖特征有助于将病理识别为对预期解剖结构的偏离。

2 方法

在本节中,我们首先介绍解剖与病理分割任务的学习设定,并通过一系列消融实验探索如何将解剖学知识融入模型训练。最后,我们提出所谓的解剖-病理交换(APEx)策略,以联合学习解剖与病理信息。

2.1 预备知识

我们将解剖与病理分割任务的形式化定义基于一个训练数据集:

D={(xi,ai,pi)}i=0N,

其中 xi∈R3×H×W 表示数据集中的第 i 张图像,ai∈[0,…,A]H×W 是对应的解剖结构标签(共 A 个类别),pi∈[0,…,P]H×W 是图像中的病理掩码(共 P 个类别)。训练好的模型目标是对新的、未见过的测试图像 xt,为每个像素预测正确的解剖类别 at 和病理类别 pt。

如果数据集提供的是实例级标注,我们会将方法扩展到实例感知(instance-aware) 的场景。此时,每个解剖掩码 ai 和病理掩码 pi 不仅包含类别信息,还包含实例信息。

为了探究解剖知识是否有助于识别“对预期解剖的偏离”,我们在两个不同领域考察两类任务:

- PET-CT 图像中的癌症语义分割

- 胸部 X 光片中的胸腔异常实例分割

为适应这些不同需求,我们选择使用 2D 模型(因 X 光片是 2D 的),并将 3D PET-CT 图像切片处理为 2D 图像。为同时满足语义分割和实例分割的要求,我们遵循近期分割领域的进展 [5,14,2,30],采用一种能统一处理两类任务的设计:即通过预测高维查询向量(query vectors),结合像素级嵌入(pixel-wise embeddings),对图像中的每个实例片段进行编码。这些查询随后用于对每个片段进行分类,同时包含该片段的类别和形状信息。作为实验起点,我们选择了 Mask2Former [5] 架构。该设定在图像模态和分割任务类型上均具有良好的灵活性。

2.2 融入所学解剖知识:路线图

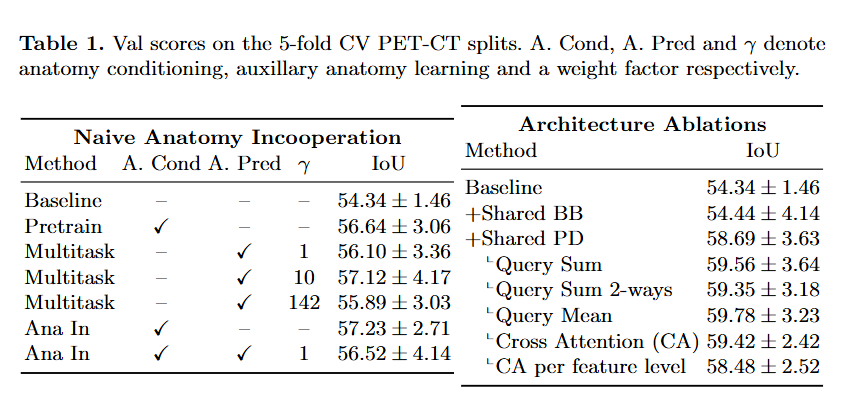

为研究如何将解剖知识融入模型训练,我们在 PET-CT 领域进行了五折交叉验证下的多项消融实验。基线对比模型是一个仅使用病理标签训练的 Mask2Former [5] 模型。表 1(左)报告了多种朴素解剖融合方法的 5 折验证 IoU 分数。

初步融合策略:

解剖预训练(Pretrain):首先在解剖标签上预训练模型,再微调病理任务。这带来了约 2.3% 的性能提升。

多任务预测(Multitask):接下来,我们尝试联合学习特征,采用多任务设置——将病理标签与解剖标签叠加,把病理视为一个额外的类别进行预测。尽管这种方法并不理想(因为 PET-CT 中同一像素在不同上下文中可能同时属于解剖结构和病理区域),但仍取得了与预训练相近的改进。然而,这种做法低估了病理的重要性。为此,我们引入加权损失函数,通过权重因子 γ 将病理类别的损失放大 10 倍或 142 倍(以匹配 142 个解剖类别的总影响)。10 倍加权效果较好,而 142 倍则表明权重选择十分敏感且困难。

解剖作为辅助输入(Anatomy as an Auxiliary Input):受基于图谱(atlas-based)分割方法的启发,我们将解剖标签与 PET-CT 图像一同输入模型,模拟一个理想的解剖图谱。该方法取得了与前述方法类似的结果。

架构消融实验:

上述分析表明,尽管解剖知识有助于提升病理预测,但其有效利用仍具挑战。因此,在第二轮实验中,我们假设:鉴于解剖与病理标签存在固有重叠,双头预测(two-head prediction)架构更为合适。

最初,我们仅在两个预测头之间共享 ResNet50 主干网络,但未见明显提升。关键改进在于:在解剖和病理预测任务之间共享 PixelDecoder(像素解码器)。这一改动显著提升了性能,IoU 指标提高了 超过 4%。这凸显了 PixelDecoder 在生成富含解剖与病理信息的像素嵌入中的核心作用,也反映了每个像素在此任务中兼具双重角色。

查询混合策略(Query Mixing Strategies):

最终,由于我们为解剖和病理分别使用了独立的 Transformer 解码器,我们进一步探索了通过查询交换实现信息交互的机制,以模拟解剖段与病理段之间的直接信息交流。

我们尝试了多种策略,包括非参数化的混合(如求和、求平均)以及更灵活的通信方式(如交叉注意力)。几乎所有策略都带来了正面效果,但没有一种明显优于其他。

我们由此得出结论:采用双头预测架构(一个用于解剖,一个用于病理),并共享像素嵌入空间,是至关重要的设计选择;在此基础上,允许不同解码器之间进行信息交互,可进一步提升性能。 最优的消融模型相比朴素基线,性能提升了约 5.44%。

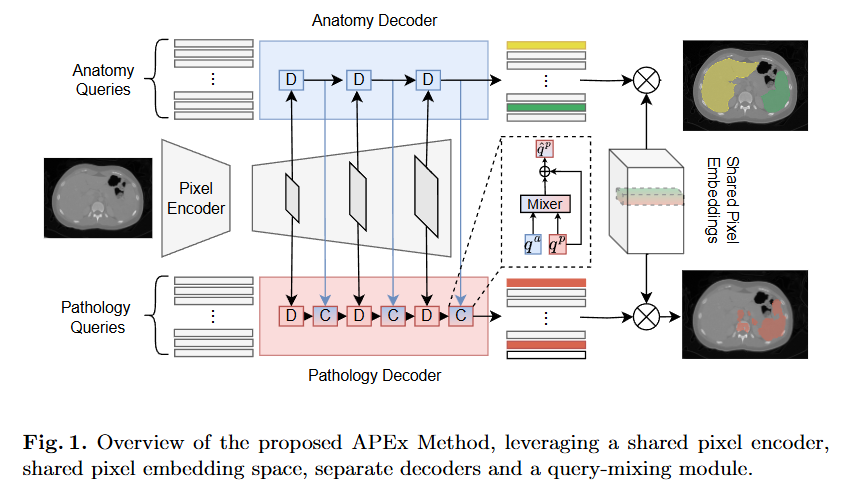

2.3 所提出的方法:APEx

APEx 基于一种基于查询的分割方法,同时利用解剖信息与病理信息。它通过在两个解码器之间交换信息来引入解剖上下文:一个解码器负责分割解剖结构,另一个负责分割病理区域。整体方法如图 1 所示。

提出的APEx方法概述:利用共享像素编码器、共享像素嵌入空间、独立解码器和查询混合模块。

共享嵌入架构(Shared Embedding Architecture)

给定一张标准的 2D 图像 x∈R3×H×W,我们首先使用一个特征提取器 fextr(以 ResNet50 [9] 为参数化骨干网络)对其进行编码,得到多尺度特征图:

fextr(x)={Fi}i=0n,Fi∈RHi×Wi,

其中空间分辨率逐层递减(即 Hi>Hi+1, Wi>Wi+1)。随后,这些特征图通过一个像素解码器(Pixel Decoder)进行解码。我们选择使用 Deformable DETR [30] 作为像素解码器,生成一组增强后的像素嵌入:

{Ji}i=0n,Ji∈Rd×Hi×Wi.

解剖与病理解码器(Anatomy and Pathology Decoders)

我们的架构动机在于:分别为解剖类别和病理类别计算独立的查询向量,并允许解剖查询影响病理查询,同时将反向影响限制在共享的嵌入空间内。

每个增强后的像素嵌入图 Ji 会被两组解码函数访问:

- {fiana(⋅)}i=1n 用于解剖解码,

- {fipath(⋅)}i=1n 用于病理解码。

这些查询向量从随机初始化但可学习的参数开始:q0ana 和 q0path,并通过以下方式迭代更新:

qi+1ana=fiana(qiana,Ji),

qi+1path=fipath(qipath,Ji).

训练过程中,这些查询会被优化。解码器 fi(⋅) 遵循标准的掩码 Transformer 设置:查询首先通过一个交叉注意力层,关注对应尺度 i 的联合嵌入,然后经过自注意力层和前馈网络。

为了让病理分支 {fipath(⋅)} 显式地遵循所学的解剖查询,我们接下来设计了一种从解剖到病理的信息通信策略。

解剖到病理的通信策略(Anatomy-to-Pathology Communication Strategy)

医务人员掌握大量关于人体的知识,而当前的病理分割模型并不具备这些知识。除了通过共享像素嵌入实现的隐式信息交换外,我们进一步提出在每个病理解码步骤 fipath(⋅) 之后引入一个混合模块 fimix(⋅)。该模块将来自解码器第 i 层的病理查询 qipath 与来自解剖解码器的解剖查询 qiana 进行融合:

q^ipath=fimix(qiana,qipath).

这里,q^ipath 是经过解剖信息增强后的病理查询,能够通过某种混合策略捕获解剖上下文。我们在实验中并未发现某一种混合策略具有绝对优势,因此建议:要么采用查询平均这类非参数化方法,要么使用交叉注意力混合模块。

在这种非对称架构中,解剖信息会影响病理专用的查询,而解剖分支则对任何病理信息保持“无感”(agnostic),仅反映患者特定的解剖细节,从而为病理评估提供一个可靠的基础先验。这一设计优于一种次优方案——即让解剖分支也反过来被病理信息更新(参见表 1 中的 “Query Sum 2-ways”)。

联合解剖与病理分割(Joint Anatomy and Pathology Segmentation)

将上述所有组件整合为完整的 APEx 流程,我们通过以下点积运算预测解剖与病理片段:

outana=J0⋅qn−1ana,

outpath=J0⋅q^n−1path.

查询向量随后通过一个简单的分类器,为预测出的每个片段分配对应的解剖或病理类别。所有组件的参数——包括 fextr、fana、fpath 和 fmix——均通过加权交叉熵损失和二值掩码损失进行端到端优化,分别作用于解剖预测 outana 和病理预测 outpath。

3 实验与结果

数据集

为评估我们方法的广泛适用性,我们在两个截然不同的医学影像领域开展了实验:FDG-PET-CT 和 胸部 X 光片(Chest X-Ray)。

在 FDG-PET-CT 领域:由于目前尚无同时包含完整解剖标注和病灶标注的综合数据集,我们将两个独立数据集进行了合并:

- autoPET [7]:提供病灶(如肿瘤)的手动标注;

- Atlas 数据集 [12]:提供详细的解剖结构标注。

我们排除了无病理表现的患者,原因是在 PET 图像中,用于癌症检测的二分类器准确率已非常高(≥95%)。本研究使用了 185 例 3D 体积数据进行五折交叉验证,并额外保留了一个包含 125 例癌症患者的测试集。为适配所选的 2D 模型设定,我们将 3D 图像沿轴向切片,并将 CT 和 PET 图像沿通道维度堆叠(第三通道留空)。

在 X 光片领域:我们在 ChestXDet [15] 数据集上评估方法性能,该数据集包含 13 类胸腔异常病理。为训练解剖分割模型,我们使用在 PaxRay++ [24] 数据集上预训练的模型,为 ChestXDet 生成解剖伪标签(pseudo-labels)。我们同样采用五折交叉验证进行评估,并在训练过程中剔除不含病理的图像。

基线与方法

在跨领域模型评估中,我们根据各验证集上的性能确定最佳候选模型。若官方提供测试集,则使用官方划分;否则使用我们预先保留的测试集。

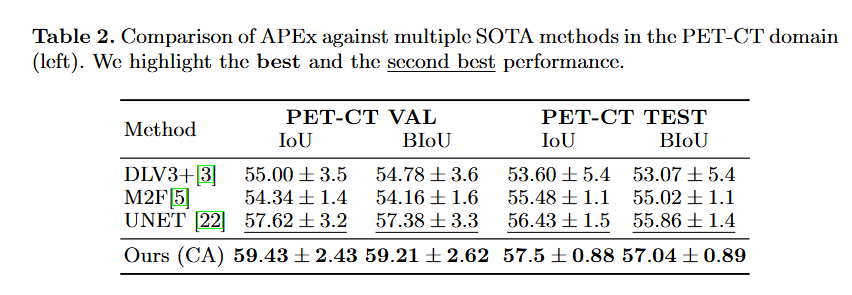

- 在 PET-CT 上,我们将 APEx 与多个成熟的 2D 分割基线进行对比,包括 UNet [22]、DeepLabV3+ [3] 和 Mask2Former [5]。所有模型均使用相同的数据和训练流程,以确保公平比较,从而隔离“引入解剖知识”所带来的影响。

- 在胸部 X 光片上,我们在实例分割任务中与 PointRend [13]、MaskDINO [14] 和 Mask2Former [5] 进行比较。

- 对于 APEx 的具体架构,我们选择 交叉注意力查询混合器(Cross-Attention Query Mixer),因为在初步消融实验中(见表 1),它在保持较低标准差的同时表现出竞争力。

3.1 语义分割与实例分割结果

PET-CT 结果:

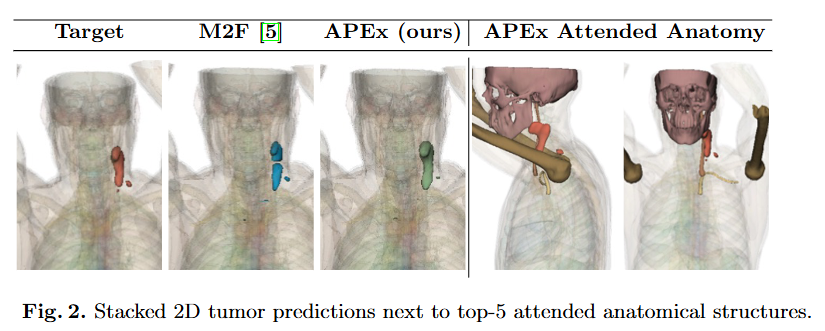

表 2 报告了前述基线模型与我们方法在 IoU(交并比)和 Boundary IoU(BIoU,更关注边界精度)[4] 上的性能。所有模型均使用 LVM-MED 权重 [19] 初始化,以确保公平性。结果表明,我们的方法在五折验证集和独立测试集上均显著优于多个强基线模型。图 2 展示了定性结果,以及在交叉注意力查询混合步骤中被关注最多的前 5 个解剖结构。

ChestXDet 结果:

表 3 展示了在相同骨干网络下,不同 SOTA 实例分割方法的性能。我们的方法相比 Mask2Former 基线,mAP(平均精度均值)提升了约 3.75%。在 13 种病理中,我们的方法在 12 种上取得了最佳或次佳性能,优于近期的 Transformer 架构和经典 CNN 模型。详细结果与可视化示例见附录。

图 2 说明:左侧为堆叠的 2D 肿瘤预测结果,右侧显示在查询混合过程中注意力权重最高的前 5 个解剖结构(例如肝脏、骨骼等),直观体现了模型如何利用相关解剖区域来指导病理预测。

表 2. PET-CT 领域 APEx 与多种 SOTA 方法的对比(左)。最佳与次佳结果已标出。

| 方法 | PET-CT 验证集 | PET-CT 测试集 |

|---|---|---|

| IoU / BIoU | IoU / BIoU | |

| DLV3+ [3] | 55.00 ± 3.5 / 54.78 ± 3.6 | 53.60 ± 5.4 / 53.07 ± 5.4 |

| M2F [5] | 54.34 ± 1.4 / 54.16 ± 1.6 | 55.48 ± 1.1 / 55.02 ± 1.1 |

| UNET [22] | 57.62 ± 3.2 / 57.38 ± 3.3 | 56.43 ± 1.5 / 55.86 ± 1.4 |

| Ours (CA) | 59.43 ± 2.43 / 59.21 ± 2.62 | 57.5 ± 0.88 / 57.04 ± 0.89 |

表 3. ChestXDet [15] 数据集结果。最佳结果加粗,次佳结果加下划线。

| 病理 mAP | MRCNN [8] | CascCRCNN [1] | PointRend [13] | MskDino [14] | M2F [5] | Ours (CA) |

|---|---|---|---|---|---|---|

| 验证集 | 13.98 ± 0.40 | 14.64 ± 0.44 | 15.33 ± 0.82 | 16.44 ± 1.43 | 16.57 ± 0.67 | 17.16 ± 0.63 |

| 测试集 | 13.72 ± 0.41 | 13.86 ± 0.70 | 15.14 ± 0.44 | 14.38 ± 0.74 | 13.87 ± 0.53 | 17.20 ± 0.33 |

Conclusion(结论)

我们提出了一种利用解剖学信息来改进病理分割的新方法,并在两个不同领域(涵盖多样化解剖结构和病理类型)中验证了“解剖引导”这一通用理念的有效性。除了带来性能上的提升,我们所提出的 APEx 方法还促进了解剖信息的传递与融合,确保病理分割结果能够充分结合患者自身的解剖特征,从而更贴近放射科医生数十年来形成的临床诊断工作流程

Q:病理结构在医学图像中通常表现为对患者预期解剖结构的偏离,什么是偏离?

A:

原句解析:

“病理结构在医学图像中通常表现为对患者预期解剖结构的偏离。”

我们可以拆解来看:

“预期解剖结构”:指的是在健康状态下,人体某个部位正常应有的形态、位置、大小、密度或信号特征。例如:

- 肺部在X光片上应该是透亮的;

- 肝脏在CT上应有特定的轮廓和均匀的密度;

- 骨骼应连续、无断裂、无异常增生。

“偏离”(deviation):在这里不是指“错误”,而是指与正常状态相比出现的异常变化。这种“偏离”就是疾病(病理)的表现。

举几个具体例子帮助理解:

正常(预期解剖) 病理(偏离) 医学图像表现 肺野清晰、透亮 肺炎 X光片上出现片状高密度影(原本该透亮的地方变白了)→ 偏离正常 颅骨完整连续 颅骨骨折 CT显示骨皮质中断、错位 → 偏离正常连续性 肝脏边缘光滑、密度均匀 肝癌 CT/MRI上出现边界不清的低密度/异常强化肿块 → 偏离正常形态与信号 心脏大小适中 心力衰竭 X光显示心脏明显增大 → 偏离正常尺寸范围 所以,“偏离” = 异常 = 疾病的影像学表现。

为什么这个观点重要?

传统AI模型往往直接学习“哪里是肿瘤”“哪里是病灶”,但不理解“为什么那里是病灶”。而医生判断病灶,其实是基于对“正常应该长什么样”的深刻理解——一旦看到不符合预期的区域,就会怀疑是病变。

这篇论文的核心思想就是:让AI也学会先理解“正常解剖”,再通过识别“偏离”来发现病理,从而更像人类医生那样思考。

✅ 简单总结:

“偏离” = 相对于健康人体解剖结构的异常改变,而这种异常正是疾病在影像上的体现。