【AI学习-comfyUI学习-文生图-各个部分学习-第一步】

【AI学习-comfyUI学习-文生图-各个部分学习-第一步】

- 1,前言

- 2,说明

-

- 1,comfyUI介绍

- 2,running hub

- 3,流程

-

-

- (1)进入网址,注册登录

- (2)调用模块

-

- 1)空白模板

- 2)列表查找

- 3)左键双击

- (3)连线

- (4)输出 提示词

- 1-正面提示词

- 2-负面提示词

- (5)生成图片

-

- 4,模块介绍

-

- 🧩 1. **Checkpoint加载器(简易)**

- 🟩 2. **CLIP文本编码器(正向提示)**

- 🟥 3. **CLIP文本编码器(负向提示)**

- 🔳 4. **空Latent**

- ⚙️ 5. **K采样器(KSampler)**

- 🧩 6. **VAE解码(VAE Decode)**

- 🖼️ 7. **预览图像**

- 💾 8. **保存图像(Save Image)**

- 🧠 总体流程总结

- 5,细节部分

- 6,使用的工作流

- 7,总结

1,前言

最近,学习comfyUI,这也是AI的一部分,想将相关学习到的东西尽可能记录下来。

2,说明

1,comfyUI介绍

ComfyUI的好处,就像搭积木一样,可以方便快速调用模型(Node(节点)),生成自己想要的的图片,甚至图片。

(1)既然是积木,有些模块就能组装在一起,有些就是不行的,我们可能先要熟悉模型,知道积木的性质和特点。

(2)之后要知道如何连接,谁和谁可以连接,怎么样连接,连接和后如何做。

(3)一个搭好的积木,我们就可以使用了,就像已经组装好的锤子,下次我们直接使用就行了,当然在这里我们叫它“Workflow(工作流)”

ComfyUI 是一个非常强大的 可视化 AI 工作流管理工具,主要用于图像生成(尤其是基于 Stable Diffusion、FLUX、SDXL 等模型)以及图像编辑、视频生成、合成数据制作等。它用「节点(Node)」的方式把复杂的模型推理过程可视化,就像搭积木一样,你可以自由地组合模型、提示词、采样器、后处理模块等,实现几乎任意的 AI 生成流程。

| 名称 | 说明 |

|---|---|

| Node(节点) | 每个节点代表一个功能模块,例如加载模型、输入图片、加噪、采样、输出结果等。 |

| Workflow(工作流) | 多个节点按照数据流连接起来,就形成一个完整的生成流程。工作流可以保存为 .json 文件。 |

| Prompt(提示词) | 用于控制生成内容的文字描述,支持正向提示词(positive)和反向提示词(negative)。 |

| LoRA / Checkpoint / VAE | 加载不同的权重模型以改变风格或生成领域。 |

| ControlNet / T2I-Adapter | 用于根据输入图像(例如姿态、线稿、深度图)来控制生成结果。 |

2,running hub

因为自己没有高级的电脑,所以使用网络的服务器,网上有很多的,我这里选用了RunningHub,当有自己喜好的或者自己硬件设备更充足的,自己电脑也可的,但是配置方面可能会很蛮烦的。

所以使用网络的其实省去配置过程,算是好处,但是坏处是也是要花钱的,像租赁费的感觉。

连接:https://www.runninghub.ai/

3,流程

(1)进入网址,注册登录

登录上述网址。连接:https://www.runninghub.ai/

然后点击开始创作,不过之前可能确实要先冲一些钱。

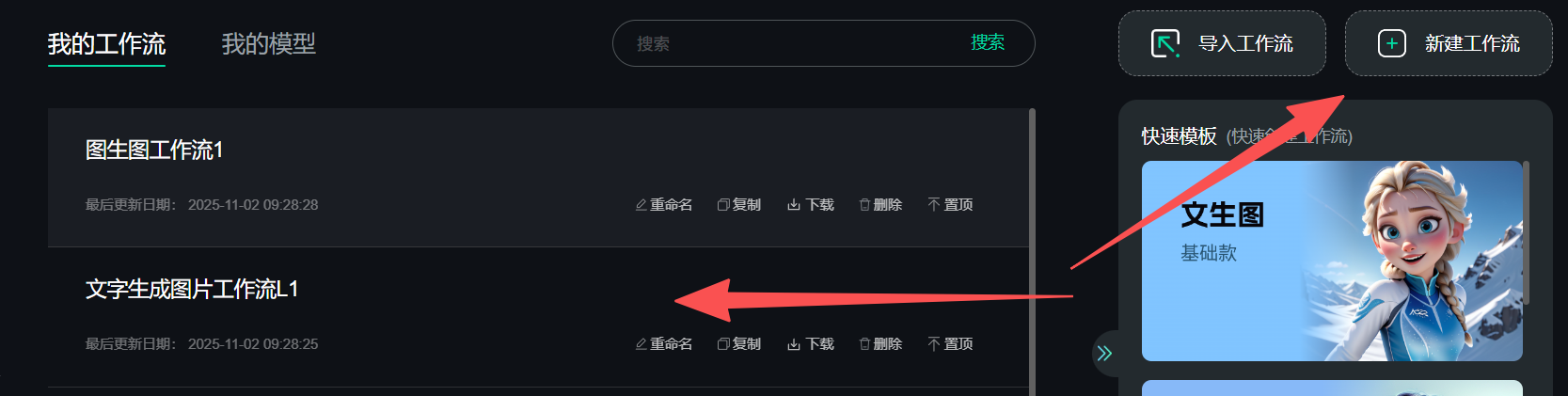

如下图,新建工作流,因为首次进入,可能是空白,我这里是已经有了直接用。