2025年江西省职业院校技能大赛“大数据应用与服务”竞赛样题

2025年江西省职业院校技能大赛"大数据应用与服务”竞赛样题

🔷博主介绍

致力于网络安全(漏洞挖掘、攻防实战)、Linux 内核系统(底层原理与性能调优)、区块链技术(Web3 安全与智能合约审计)、Python 语言应用(自动化攻防工具开发)、软件开发(全栈安全开发)等新一代信息技术领域的技术研究与干货分享,坚持以

极简篇幅承载硬核知识的创作理念,为技术爱好者提供高效、深度、可落地的阅读体验。CSDN认证网络安全领域优质创作者、网络安全博客专家认证、阿里云专家博主。

🌐各大技术专栏推荐

| 专栏名称 | 专栏介绍 |

|---|---|

| 网络安全攻防之道 | 为网络安全从业者、白帽黑客与技术爱好者打造的攻防知识阵地。深度剖析漏洞利用与防御的技术细节,实战演练渗透测试全流程,输出可落地的攻防策略,陪你在攻防对抗中持续进阶。 |

| Linux 系统运维:从底层原理到企业级实战 | 这里是 Linux 系统运维的实战修炼场:从系统初始化到高可用架构,从命令行魔术到自动化运维利器,深度拆解 CentOS/Ubuntu 在企业级业务、云原生环境中的运维密码。带你穿透系统底层逻辑,掌握性能调优、故障秒级定位、自动化脚本开发的硬核技能,进阶成为能扛住业务压力的 Linux 运维专家 |

| 【VulnHub 靶场攻防】从漏洞复现到实战渗透 | 不管你是刚入门的渗透新人,还是想强化实战能力的安全工程师,都能在这儿找到匹配的靶场练手项目。我们聚焦可复现的漏洞利用技巧,结合 Nmap、Metasploit、BurpSuite 等工具实战演示,帮你把靶场经验转化为真实渗透能力,一步步成长为能在实战中 “打怪升级” 的渗透高手 |

| 博主年度总结与收获 | 这里是旺仔 Sec 的创作成长日记!作为 CSDN 认证的网络安全优质创作者,我把每一年的技术深耕、创作思考、成长突破都浓缩在这儿 —— 从漏洞分析的技术沉淀,到内容创作的经验复盘,再到从工程师到博主的身份进阶,每一篇总结都是 “技术探索 + 创作感悟” 的双料干货 |

文章目录

- 2025年江西省职业院校技能大赛"大数据应用与服务”竞赛样题

- 题1 大数据平台搭建与运维

- 1、大数据平台搭建与运维——Hadoop集群搭建(8分)

- 2、大数据平台搭建与运维——Hive搭建(6分)

- 3、大数据平台搭建与运维——Spark安装配置(6分)

- 题2 数据库配置维护

- 4、数据库配置维护——数据库配置(3分)

- 5、数据库配置维护——创建数据库和表(3分)

- 6、数据库配置维护——维护数据表(4分)

- 题3 数据获取与清洗

- 7、数据获取与清洗——数据获取(6分)

- 8、数据获取与清洗——HDFS文件上传下载(4分)

- 题4 数据标注

- 9、使用python进行数据标注(10分)

- 题5 数据统计与数据清洗

- 10、数据统计与数据清洗——处理异常数据(6分)

- 11、数据统计与数据清洗——数据统计(9分)

- 题6 数据分析与可视化

- 12、数据分析与可视化——数据分析(5分)

- 13、数据分析与可视化——数据可视化(15分)

- 题7 业务分析与方案设计

- 14、业务分析与方案设计——业务分析(5分)

- 15、业务分析与方案设计——报表分析(5分)

题1 大数据平台搭建与运维

【主观题开始】

1、大数据平台搭建与运维——Hadoop集群搭建(8分)

在Linux下安装搭建完全分布式Hadoop集群。在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络,启动环境。

(1)创建/opt/module目录,在master主节点将/data目录下的JAVA安装包解压到master节点的/opt/module目录下,并远程拷贝至slave1、slave2相同目录下。在master主节点将/data目录下的Hadoop安装包解压到/opt/module目录下。最后查看master、slave1、slave2节点/opt/module目录下的内容并截图。

(2)在各节点的/etc/profile文件中配置JDK环境变量JAVA_HOME和PATH的值,并让配置文件立即生效,之后分别在master、slave1、slave2节点使用“java -version”查看JAVA版本,检测JAVA是否安装成功,并将结果截图。

(3)根据下表修改core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml、workers、hadoop-env.sh、yarn-env.sh配置文件,以及HDFS与YARN的启动和关闭脚本。最后将各配置文件添加的内容截图。

| 配置文件 | 配置内容 |

|---|---|

| core-site.xml | ①设置HDFS的连接地址为master节点,端口为8020 ②设置HDFS的临时路径为/opt/module/hadoop-3.1.4/tmp |

| hdfs-site.xml | ①设置Secondary NameNode的HTTP访问地址为slave1,端口号50090 ②设置HDFS文件块的副本数为3。 |

| mapred-site.xml | ①设置执行MapReduce作业的框架为yarn ②设置MapReduce作业历史服务JobHistoryServer监听的地址为master,端口为10020。 ③设置MapReduce作业历史服务JobHistoryServer的Web 应用程序监听地址为master,端口为19888。 |

| yarn-site.xml | ①设置yarn资源管理器(ResourceManager)的主机名为master ②设置ResourceManager监听的地址和端口为master:8032 ③设置NodeManager上可以运行的辅助服务(yarn.nodemanager.aux-services),启用MapReduce作业的shuffle服务 |

| workers | 工作节点为slave1、slave2 |

| hadoop-env.sh | 配置Hadoop运行环境,添加Java的环境变量 |

| yarn-env.sh | 配置YARN框架运行环境,添加Java的环境变量 |

| start-dfs.sh stop-dfs.sh | 指定namenode、datanode、secondarynamenode各个组件的运行用户为root |

| start-yarn.sh stop-yarn.sh | 指定resourcemannager、nodemanager组件的运行用户为root |

(4)在master节点上使用scp命令将配置完的Hadoop安装目录远程拷贝至slave1和slave2相同目录下,之后查看slave1和slave2的/opt/module目录结构并将查看结果截图。

(5)在3个节点的/etc/profile文件中配置Hadoop环境变量(HADOOP_HOME)和PATH的值,并让配置文件立即生效。将3个节点的/etc/profile文件中添加的内容截图。

(6)在主节点格式化集群,成功格式化之后在主节点依次启动HDFS、YARN服务、JobHistoryServer服务,并查看3个节点的进程,将查看结果截图。

(7)在HDFS上创建/user/input目录,并将master节点/etc/profile文件上传到HDFS的/user/input目录下,最后查看/user/input目录下的文件内容并截图。

(8)将/user/input目录下的hosts文件权限调整为776,最后查看/user/input目录下的文件内容并截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)Java安装包:

“wget -P /data http://house.tipdm.com/JS-Competition/software/jdk-8u281-linux-x64.tar.gz”。

(2)Hadoop安装包:

“wget -P /data http://house.tipdm.com/JS-Competition/software/hadoop-3.1.4.tar.gz”。

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过wget命令可将安装包下载至“/data”目录下,完整路径为“/data/hadoop-3.1.4.tar.gz”。

(3)若想切换至slave1或slave2节点,可以打开新的Linux终端窗口,然后输入“ssh slave1”或“ssh slave2”即可切换到对应的节点。

【答案提交】

根据赛题提供的“答案报告1.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告1.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【主观题结束】

【主观题开始】

2、大数据平台搭建与运维——Hive搭建(6分)

在Linux下安装搭建Hive数据仓库。在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络,启动环境。

【注意!!主观题3使用主观题2中提供的实训环境进行操作】

(1)创建/opt/module目录,将/data目录下的Hive安装包解压到/opt/module目录下,查看/opt/module目录下的内容并截图。

(2)进入Hive安装目录的conf目录,使用cp命令拷贝hive-env.sh.template文件并重命名为hive-env.sh,在该文件中配置Hadoop环境变量,并将文件添加的内容截图。

(3)在Hive安装目录的conf目录下新建hive-site.xml配置文件并添加内容,将添加的内容截图。

| 配置参数 | 描述 | 参数值 |

|---|---|---|

| hive.metastore.warehouse.dir | 元数据库位置 | hdfs://master:8020/user/hive/warehouse |

| javax.jdo.option.ConnectionURL | 元数据库的链接信息 | jdbc:mysql://master:3306/hive?createDatabaseIfNotExist=true |

| javax.jdo.option.ConnectionDriverName | 连接数据库驱动 | com.mysql.cj.jdbc.Driver |

| javax.jdo.option.ConnectionUserName | 连接数据库用户名称 | root |

| javax.jdo.option.ConnectionPassword | 连接数据库用户密码 | 123456 |

(4)将/data目录下的MySQL驱动mysql-connector-java-8.0.30.jar复制到Hive安装目录的lib目录,同时将该lib目录下的jline-2.12.jar复制到各节点的Hadoop安装目录的/share/hadoop/yarn/lib/目录中。

(5)删除Hive安装目录的lib目录下的guava-19.0.jar包,并将Hadoop安装目录的/share/hadoop/common/lib/目录中的guava-27.0-jre.jar复制至Hive安装目录的lib目录下。查看Hive安装目录的lib目录下guava jar包名称并截图。

(6)在master主节点的/etc/profile文件中配置Hive环境变量HIVE_HOME和PATH的值,并让配置文件立即生效,将配置内容截图。

(7)初始化Hive元数据库,之后依次启动Hadoop集群、MySQL服务和Hive元数据服务,在master节点使用jps查看进程,并将结果截图。

(8)进入Hive CLI在Hive中创建一个名为company的数据库,并在该数据库下创建一个名为emp的内表,创建后查看该表的表结构信息并截图。表字段名称及类型设计参考下表。

| 字段名称 | 字段类型 | 字段说明 |

|---|---|---|

| empno | int | 员工编号 |

| ename | string, | 员工姓名 |

| job | string | 职位 |

| mgr | int | 直属领导编号 |

| hiredate | string | 入职日期 |

| sal | int | 工资 |

| comm | int | 奖金 |

| deptno | int | 部门编号 |

(9)将/data目录下的emp.txt文件内容导入company数据库的emp表中,最后查看emp表的所有数据并截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)Hive安装包:

“wget -P /data http://house.tipdm.com/JS-Competition/software/apache-hive-3.1.2-bin.tar.gz”。

(2)mysql连接驱动包:

“wget -P /data http://house.tipdm.com/JS-Competition/software/mysql-connector-java-8.0.30.jar”。

(3)emp.txt数据文件:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/emp.txt”。

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过“JAVAHOME”指令可返回JAVA的安装目录;通过“JAVA_HOME”指令可返回JAVA的安装目录;通过“JAVAHOME”指令可返回JAVA的安装目录;通过“HADOOP_HOME”指令可返回Hadoop的安装目录。

(3)通过 wget 命令可将安装包下载至“/data”目录下,完整数据路径为“/data/apache-hive-3.1.2-bin.tar.gz”。

【答案提交】

根据赛题提供的“答案报告2.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告2.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【主观题结束】

【主观题开始】

3、大数据平台搭建与运维——Spark安装配置(6分)

在Linux下安装搭建完全分布式Spark集群。在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络,启动环境。

【注意!!主观题3使用主观题2中提供的实训环境进行操作】

(1)创建/opt/module,在master节点将/data目录下的spark-3.2.1-bin-hadoop3.2.tgz安装包解压到/opt/module目录下,解压后查看/opt/module目录下的内容并将查看结果截图。

(2)切换到/opt/module/spark-3.2.1-bin-hadoop3.2/conf目录下,使用cp命令拷贝spark-env.sh.template文件后更名为spark-env.sh,拷贝workers.template文件后更名为workers,查看/opt/module/spark-3.2.1-bin-hadoop3.2/conf目录下的内容并截图。

(3)在spark-env.sh文件中进行修改,配置JAVA_HOME安装目录及Hadoop的配置文件目录,指定standalone模式运行时的Master进程运行在master节点上,指定Master进程内部通信端口号为7077,SPARK的WEB UI端口为8085。

(4)在workers文件中进行修改,指定standalone模式运行时Worker进程需要分别在master、slave1、slave2节点上运行。

(5)在master节点上将Spark安装目录远程拷贝到slave1、slave2节点的/opt/module路径下,之后查看slave1和slave2的/opt/module目录结构并将查看结果截图。

(6)在master节点修改/etc/profile文件,设置Spark环境变量(SPARK_HOME)和PATH的值,并使环境变量生效。将配置文件添加的内容截图。

(7)启动Spark集群,使用jps查看master节点、slave1节点、slave2节点的进程(启动Spark集群前需先启动Hadoop集群),将3个节点的进程结果截图。

(8)进入spark-shell交互式命令行界面,从整数数据集合Array(1, 2, 3, 4, 5, 6)中创建出RDD,RDD名称为numberRDD,然后对numberRDD中的每个元素进行平方操作,并将结果赋值给squaredRDD,最后输出处理后的squaredRDD所有数据并截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

Spark安装包:

“wget -P /data http://house.tipdm.com/JS-Competition/software/spark-3.2.1-bin-hadoop3.2.tgz”。

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过“JAVAHOME”指令可返回JAVA的安装目录;通过“JAVA_HOME”指令可返回JAVA的安装目录;通过“JAVAHOME”指令可返回JAVA的安装目录;通过“HADOOP_HOME”指令可返回Hadoop的安装目录。

(3)通过 wget 命令可将安装包下载至“/data”目录下,完整数据路径为“/data/spark-3.2.1-bin-hadoop3.2.tgz”。

【答案提交】

根据赛题提供的“答案报告3.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告3.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【主观题结束】

题2 数据库配置维护

【主观题开始】

4、数据库配置维护——数据库配置(3分)

本任务需要在Linux下中完成MySQL数据库配置,请使用root用户完成相关配置,具体要求如下。

注:进入实训平台,初始化网络后,请先复制wget指令在终端运行,以更新系统镜像源文件CentOS-Base.repo,再操作以下题目!

(1)将/data目录下的mysql-community.repo文件复制到YUM仓库的配置文件/etc/yum.repos.d/,查看/etc/yum.repos.d/目录下内容并截图。

(2)加载MySQL镜像源并使用yum命令下载安装mysql-community-server,将安装成功的结果截图。

(3)在/var/log/mysqld.log文件中查询MySQL初始密码,并使用初始密码登录MySQL,将成功登录的界面截图。

(4)使用初始密码登录MySQL后,先将密码修改为符合MySQL8.x密码规则的复杂密码,之后再修改密码规则并将密码改为简单密码123456。

(5)修改密码后退出MySQL,使用修改之后的密码重新登录MySQL,赋予root用户外部连接权限。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)更新系统镜像源文件:

“wget -O /etc/yum.repos.d/CentOS-Base.repo http://house.tipdm.com/JS-Competition/software/CentOS-Base.repo”

(2)MySQL源文件:

“wget -P /data http://house.tipdm.com/JS-Competition/software/mysql-community.repo”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过wget命令可将安装包下载至“/data”目录下,完整路径为“/data/mysql-community.repo”。

【答案提交】

根据赛题提供的“答案报告4.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告4.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

5、数据库配置维护——创建数据库和表(3分)

【注意!!主观题6使用主观题5中提供的实训环境进行操作】

酒店表(hotel_all)字段如下表所示。

| 字段 | 类型 | 中文含义 |

|---|---|---|

| id | int | 酒店编号 |

| hotel_name | varchar | 酒店名称 |

| city | varchar | 城市 |

| province | varchar | 省份 |

| level | varchar | 星级 |

| room_num | int | 房间数 |

| score | double | 评分 |

| shopping | varchar | 评论数 |

评论表(comment_all)字段如下表所示。

| 字段 | 类型 | 中文含义 |

|---|---|---|

| id | int | 评论编号 |

| name | varchar | 酒店名称 |

| commentator | varchar | 评论人 |

| score | double | 评分 |

| comment_time | datetime | 评论时间 |

| content | varchar | 评论内容 |

(1)在数据库中创建“hotel”数据库,并使用该数据库,将操作指令截图。

(2)根据已给到的sql文件comment_all_data.sql和hotel_all_data.sql,执行这两份sql文件,在hotel数据库中创建表并导入数据。分别查看hotel_all表和comment_all表的表结构信息,并截图。

(3)通过select查询语句,查询hotel_all表和comment_all表两张表的数据记录数并截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)hotel_all_data.sql:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/hotel_all_data.sql”

(2)comment_all_data.sql:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/comment_all_data.sql”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过wget命令可将安装包下载至“/data”目录下,完整路径为“/data/hotel_all_data.sql”。

【答案提交】

根据赛题提供的“答案报告5.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告5.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

6、数据库配置维护——维护数据表(4分)

【注意!!主观题6使用主观题5中提供的实训环境进行操作】

基于第5题中创建的hotel_all表和comment_all表及插入的表数据,对数据表进行维护,具体要求如下。

(1)查询hotel_all表中不同星级的酒店数量,并按照酒店数量降序排序,将查询结果截图。

(2)查询comment_all表中评分小于等于3分的酒店名称及对应的评论数量并截图。

(3)查询hotel_all表中商圈包含“机场”字符串且评分大于等于4.5的酒店名称,并将结果截图。

(4)更新comment_all表,将2022年10月1日之后(包含2022年10月1日)评论并且评分小于2分的评论的评论人名称更改为“匿名用户”,查询评论人名称为“匿名用户”的评论数量进行验证并截图。

(5)删除hotel_all表中星级为高档型,且房间数小于100的酒店信息,删除后查看表的数据记录数并将结果截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)hotel_all_data.sql:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/hotel_all_data.sql”

(2)comment_all_data.sql:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/comment_all_data.sql”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过wget命令可将安装包下载至“/data”目录下,完整路径为“/data/hotel_all_data.sql”。

【答案提交】

根据赛题提供的“答案报告6.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告6.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

题3 数据获取与清洗

【主观题开始】

7、数据获取与清洗——数据获取(6分)

基于手机产品评论数据文件(iphone15_jd_comments.csv),按照题目要求使用Python技术完成下列任务。

(1)读取iphone15_jd_comments.csv,打印查看数据的记录数并截图。

(2)统计每一列的缺失值情况,输出统计结果并截图;针对数据的缺失值,删除缺失值所在的行,打印查看缺失值处理后的数据记录数并截图。

(3)针对数据的重复值,根据“content”列进行去重,保留最后一次出现的重复值,打印查看重复值处理后的数据记录数并截图。

(4)将“creationTime”、“referenceTime”两列转成日期时间格式类型,并打印查看data所有列的数据类型并截图。

(5)从“referenceTime”列中提取出日期,如“2024-01-01”,存储于“referenceDate”列,打印查看“referenceDate”列的最早购买日期和最晚购买日期并截图。

【文件获取】

使用wget命令获取文件(运行引号中的所有代码可将文件上传到实训平台)。

(1)iphone15_jd_comments.csv:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/iphone15_jd_comments.csv”

【说明】

通过wget命令可将文件下载至“/data”目录下,如iphone15_jd_comments.csv完整路径为“/data/iphone15_jd_comments.csv”。

【答案提交】

根据赛题提供的“答案报告7.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告7.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

8、数据获取与清洗——HDFS文件上传下载(4分)

在当今激烈的商业竞争环境中,企业的成功往往取决于其人力资源管理的效能。了解员工的工作状态、表现和需求,才能制定更有效的人力资源管理策略。HR_data1.csv和HR_data2.csv数据中包含了员工的满意度、项目数量、月均工作时长、工龄、有否有工伤、是否离职、过去5年内是否晋升、工作部门和工资等级的数据字段,请根据提供的人力资源信息,使用Hadoop HDFS文件系统操作指令完成下列任务(实现本任务前需要先启动Hadoop集群)。

(1)在HDFS中创建/HR/analysis目录和/HR/employee目录,查看/HR目录下的内容并截图。

(2)将/data目录下的“HR_data1.csv”和“HR_data2.csv”文件内容合并上传至/HR/analysis目录的HR_data.csv文件中(数据文件需要先上传到平台的/data目录下),查看/HR/analysis目录下的内容并截图。

(3)将HDFS的/HR/analysis/HR_data.csv文件复制到/HR/employee目录下,以备份原始数据文件,复制后查看/HR/employee目录下的内容并截图。

(4)将HDFS的/HR/employee/HR_data.csv文件下载至Linux本地的/data目录下,并查看Linux本地/data目录下的内容。

(5)删除HDFS的/HR/analysis目录,删除后查看/HR目录下的内容并截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

(1)HR_data1.csv文件

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/HR_data1.csv”

(2)HR_data2.csv文件

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/HR_data2.csv”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过“JAVAHOME”指令可返回JAVA的安装目录;通过“JAVA_HOME”指令可返回JAVA的安装目录;通过“JAVAHOME”指令可返回JAVA的安装目录;通过“HADOOP_HOME”指令可返回Hadoop的安装目录。

(3)通过 wget 命令可将安装包下载至“/data”目录下,如完整数据路径为“/data/HR_data1.csv”。

【答案提交】

根据赛题提供的“答案报告8.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告8.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

题4 数据标注

【主观题开始】

9、使用python进行数据标注(10分)

在数据科学和机器学习领域,数据标注是一个至关重要的步骤。数据标注是指为数据集中的每个样本添加正确的标签或注释,以便训练机器学习模型或进行其他类型的分析。在情感分析和时间序列分析等任务中,数据标注通常涉及为文本数据添加情感标签或时间标签,了解客户的情感倾向和评论的季节性特征,可以更好地了解客户需求,改善服务质量,并制定更有效的营销策略。

(1)基于python技术,根据标注规则对“hotel_comment.csv”数据中的“评论信息”列进行情感标注,并将标注结果存储于数据的“情感”列中,在确认每条评论文本均已完成情感标注后,统计不同情感的评论数量并输出统计结果。

具体的标注规则如下。

①“分数”值大于等于0.6,则评论数据“情感”列的值标注为【积极】。

②“分数”值大于0.4小于0.6,则评论数据“情感”列的值标注为【中性】。

③“分数”值小于等于0.4,则评论数据“情感”列的值标注为【消极】。

(2)基于python技术,新建“季度”列,根据“评论日期”进行数据标注,确保对每条评论文本都进行数据标注后,统计不同季度的评论数量并打印输出。

具体标注规则如下。

①评论日期在1~3月,则评论数据“季度”列的值标注为【第一季度】。

②评论日期在4~6月,则评论数据“季度”列的值标注为【第二季度】。

③评论日期在7~9月,则评论数据“季度”列的值标注为【第三季度】。

④评论日期在10~12月,则评论数据“季度”列的值标注为【第四季度】。

【数据获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将数据上传到实训平台)。

hotel_comment.csv:

“wget -P /data http://house.tipdm.com/JS-Competition/data/hotel_comment.csv”。

【说明】

通过wget命令可将数据文件下载至“/data”目录下,完整数据路径为“/data/hotel_comment.csv”。

【答案提交】

根据赛题提供的“答案报告9.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告9.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

题5 数据统计与数据清洗

【主观题开始】

10、数据统计与数据清洗——处理异常数据(6分)

【注意!!主观题10使用主观题8中提供的实训环境进行操作】

hotel_data.csv存储了不同酒店商家的信息,文件中的表字段如下表所示。

| 字段 | 类型 | 中文含义 |

|---|---|---|

| id | int | 酒店编号 |

| hotel_name | varchar | 酒店名称 |

| city | varchar | 城市 |

| province | varchar | 省份 |

| level | varchar | 星级 |

| room_num | int | 房间数 |

| score | double | 评分 |

| shopping | varchar | 评论数 |

将hotel_data.csv文件上传至HDFS文件系统的/opt目录下(若没有该目录,则自行创建)。编写MapReduce程序,实现以下功能:过滤首行标题行,删除酒店星级(level)为空的数据并对数据记录进行去重,将清洗后的数据输出到HDFS中/output1目录下,最后使用hdfs命令结合wc指令,查看HDFS文件系统中/opt/hotel_data.csv文件的行数,以及清洗后的/output1/part-r-00000文件的行数,将查看结果截图。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

hotel_data.csv文件

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/hotel_data.csv”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过“JAVAHOME”指令可返回JAVA的安装目录;通过“JAVA_HOME”指令可返回JAVA的安装目录;通过“JAVAHOME”指令可返回JAVA的安装目录;通过“HADOOP_HOME”指令可返回Hadoop的安装目录。

(3)通过 wget 命令可将安装包下载至“/data”目录下,如完整数据路径为“/data/hotel_data.csv”。

【答案提交】

根据赛题提供的“答案报告10.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告10.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

11、数据统计与数据清洗——数据统计(9分)

【注意!!主观题11使用主观题8中提供的实训环境进行操作】

基于处理后的hotel_newdata.csv文件,将其上传至HDFS文件系统的/opt目录下。编写一个或多个MapReduce程序,实现以下功能:

过滤首行标题行,统计每种星级不同商圈的的酒店平均评分,并将结果保存到HDFS中/output2_1目录中,将/output2_1目录下的输出文件按照平均评分进行降序排序,最后将结果保存到HDFS中/output2_2目录下,并在控制台同步打印输出结果并截图,打印输出结果如“星级名称_商圈名称的平均评分为:XX”。

【文件获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将文件上传到实训平台)。

hotel_newdata.csv文件

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/hotel_newdata.csv”

【说明】

(1)登录平台后需先在Linux终端执行命令“initnetwork”,或双击桌面上名称为“初始化网络”的图标,初始化实训平台网络。

(2)通过“JAVAHOME”指令可返回JAVA的安装目录;通过“JAVA_HOME”指令可返回JAVA的安装目录;通过“JAVAHOME”指令可返回JAVA的安装目录;通过“HADOOP_HOME”指令可返回Hadoop的安装目录。

(3)通过 wget 命令可将安装包下载至“/data”目录下,如完整数据路径为“/data/hotel_newdata.csv”。

【答案提交】

根据赛题提供的“答案报告11.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告11.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

题6 数据分析与可视化

【主观题开始】

12、数据分析与可视化——数据分析(5分)

招聘信息数据可以揭示不同企业的招聘渠道和招聘方式。求职者可以通过分析招聘信息数据,选择合适的招聘平台、企业官网或招聘会等渠道进行求职,提高找到理想工作的机会。通过研究招聘信息数据,求职者可以了解企业对候选人的面试流程、评价标准和重点关注的技能。这有助于求职者针对性地准备面试内容,展现自己的优势和匹配度,提升在面试中的表现和竞争力。请根据提供的招聘信息,编写相关Python代码完成下列任务。

(1)导入相关库,读取“new_job_info.csv”数据,展示前3行招聘数据信息。

(2)根据“公司行业”进行分组,分别对“岗位名”列进行计数,对“工资水平”列计算平均值,以统计每个行业的岗位需求数量和平均工资水平。根据需求数量进行降序排序,并输出需求量排名前5的行业及平均工资水平。

(3)根据“公司人数”进行分组,分别对“工资水平”列计算平均值,对“公司名”列进行计数,以展示不同体量企业的薪资水平和用人需求。

(4)统计出每个工作地点中工资水平最高的岗位名(即每个工作地点都对应一个岗位,该岗位是这个工作地点工资水平最高的),以了解不同工作地点高薪资岗位所需的专业技能。按照工资水平进行降序排序后,查看前10条数据并截图。

【数据获取】

使用wget命令获取数据(在终端中运行引号中的所有代码可将数据上传到实训平台)。

new_job_info.csv:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/new_job_info.csv”。

【说明】

通过wget命令可将数据文件下载至“/data”目录下,完整数据路径为“/data/new_job_info.csv”。

【答案提交】

根据赛题提供的“答案报告12.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告12.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

13、数据分析与可视化——数据可视化(15分)

【注意!!主观题13使用主观题12中提供的实训环境进行操作】

现有产品评论数据文件(comment_topic.xlsx),文件中的数据字段说明如下表所示。

| content | 评论内容 | nickname | 用户昵称 |

|---|---|---|---|

| creationTime | 评论时间 | location | 所在地区 |

| score | 评分 | days | 从购买到评论的间隔天数 |

| userClient | 用户使用的客户端 | referenceDate | 购买日期 |

| productColor | 产品颜色 | content_words | 评论词语列表 |

| productSize | 产品内存大小 | topic_label | 主题类别 |

| referenceTime | 购买时间 |

根据产品评论数据,按照题目要求使用Python技术完成下列任务。

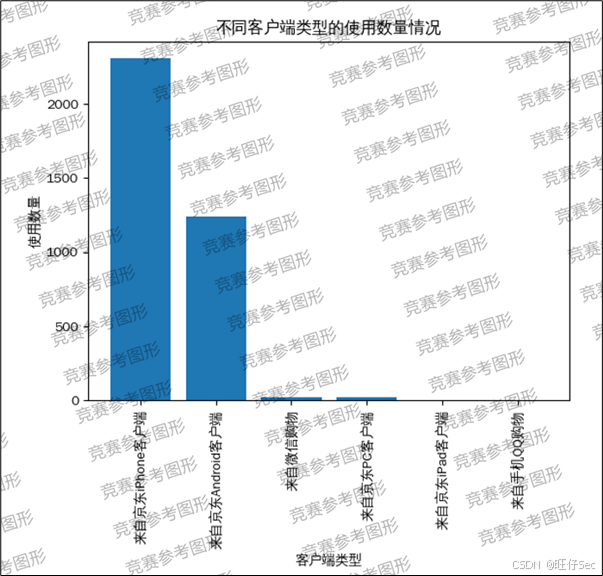

(1)读取comment_topic.xlsx文件,对“userClient”列的数据进行处理,处理规则如下,最后统计不同客户端类型的使用数量并输出结果。

①若userClient等于2,则userClient值修改为“来自京东iPhone客户端”;

②若userClient等于4,则userClient值修改为“来自京东Android客户端”;

③若userClient等于21,则userClient值修改为“来自微信购物”;

④若userClient等于0,则userClient值修改为“来自京东PC客户端”;

⑤若userClient等于29,则userClient值修改为“来自京东iPad客户端”;

⑥若userClient等于28,则userClient值修改为“来自手机QQ购物”。

(2)根据不同客户端类型的使用数量结果,绘制柱状图进行可视化展示。

参数设置要求:

①标题设置为“不同客户端类型的使用数量情况”;

②x轴标签设置为“客户端类型”,y轴标签设置为“使用数量”;

③x轴上的标签旋转90度。

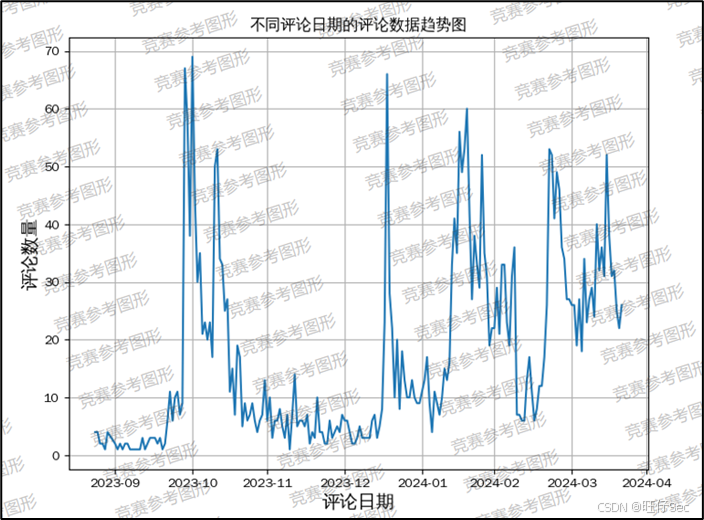

(3)从评论时间“creationTime”列中提取出日期作为新的一列“creationDate”,统计不同评论日期的评论数量,统计结果按照评论日期进行升序排序,最后绘制折线图进行可视化展示。

参数设置要求:

①标题设置为“不同评论日期的评论数据趋势图”;

②x轴标签设置为“评论日期”,y轴标签设置为“评论数量”;

③背景显示网格线。

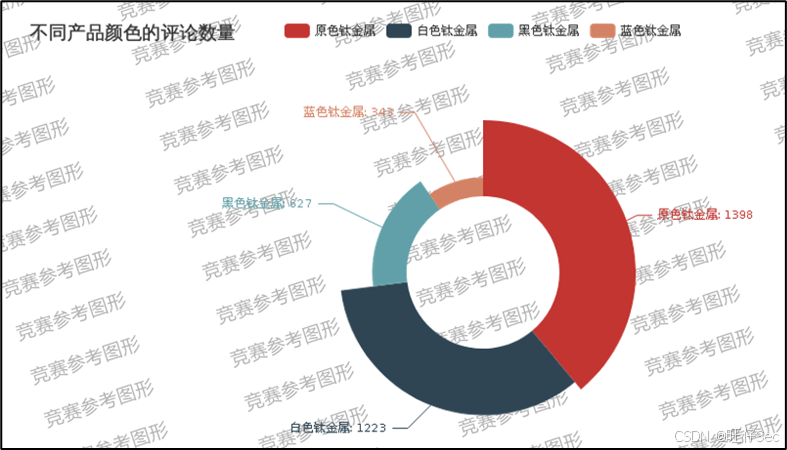

(4)统计不同产品颜色的评论数量,使用pyecharts库绘制南丁格尔玫瑰图进行可视化展示。

参数设置要求:

①设置饼图的半径范围,内半径为30%,外半径60%;

②南丁格尔玫瑰图展示类型为:使用半径大小来表示数据的大小;

③饼图的标题设置为“不同产品颜色的评论数量”;

④饼图的标签数值显示为“产品颜色:评论数量”;

⑤将图表渲染保存为成一个html文件,文件路径设置为“/root/jupyter_notbook/pie.html”。

(5)新增“评价属性”列,score分数为1,则评价属性值为“差评”;score分数为2或3,则评价属性值为“中评”;score分数为4或5,则评价属性值为“好评”。根据“评价属性”列进行分组,统计不同评价属性的评论数量并输出结果。

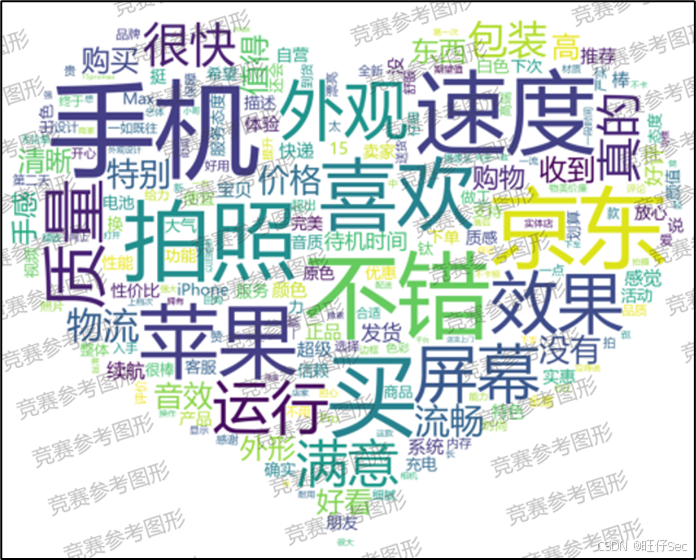

(6)仅筛选出好评的评论数据,基于“content_words”列统计出每个评论词语的词频,最后使用词云图进行好评词频的可视化展示。

参数设置要求:

①词云图的背景图片设置为“/data/aixin.jpg”;

②字体路径设置为“/data/msyh.ttc”;

③背景颜色设置为白色。

【数据获取】

使用wget命令获取文件(运行引号中的所有代码可将安装包上传到实训平台)。

(1)comment_topic.xlsx:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/comment_topic.xlsx”。

(2)aixin.jpg:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/aixin.jpg”。

(3)msyh.ttc:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/msyh.ttc”。

【说明】

(1)通过wget命令可将文件下载至“/data”目录下,如comment_topic.xlsx完整路径为“/data/comment_topic.xlsx”。

(2)在可视化图表中,中文字体可设置为“WenQuanYi Zen Hei”。

【答案提交】

根据赛题提供的“答案报告13.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告13.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

题7 业务分析与方案设计

【主观题开始】

14、业务分析与方案设计——业务分析(5分)

【注意!!主观题14使用主观题12中提供的实训环境进行操作】

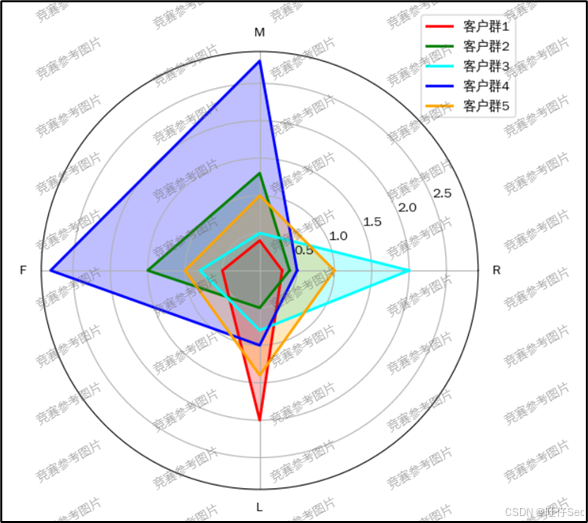

某金融APP通过分析客户的行为数据,希望了解不同客户群体的使用习惯和偏好,以便制定更有针对性的营销策略。user.csv文件是五个不同客户群体(客户群1至客户群5)在四个维度上的行为特征数据:最近一次登录天数(R)、消费金额(M)、登录次数(F)和注册会员天数(L)。

(1)请使用python读取user.csv文件,将第一列设为索引,并使用matplotlib库绘制客户群体雷达图,参考图如下。

请根据图表和数据,分析并回答以下问题。

(2)阐述哪个客户群体的平均入会时长最久?

(3)根据图表,描述客户群4的行为特征表现,并提出针对该群体的营销策略,提升该客户群体的满意度,促进该客户群体的消费。

【数据获取】

使用wget命令获取文件(运行引号中的所有代码可将安装包上传到实训平台)。

user.csv:

“wget -P /data http://house.tipdm.com/JS-Competition/data/JX2024/user.csv”。

【说明】

(1)通过wget命令可将文件下载至“/data”目录下,如user.csv完整路径为“/data/user.csv”。

(2)使用matplotlib绘制可视化图表时,中文字体参数“font.sans-serif”需设置为“WenQuanYi Zen Hei”。

【答案提交】

根据赛题提供的“答案报告14.docx”文档,将最终的答案命令与运行结果的截图整理入文档,并由队长以“考生1准考证号-答案报告14.docx”命名提交。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

【主观题开始】

15、业务分析与方案设计——报表分析(5分)

请基于本地电脑的电子表格软件WPS Excel对相关数据进行统计分析、可视化分析等操作。

(1)请基于数据“短视频平台达人信息数据.xlsx”在新的工作表创建数据透视表,以查看不同性别对于不同类型的视频发布数量(行为类型,列为性别),工作表重命名为“数据透视表”;并在新的工作表使用数据透视图中的堆叠条形图展示统计结果,要求对图形设置合适的标题、坐标轴标题和图例,工作表重命名为“数据透视图”。将结果文件另存为“15-1结果.xlsx”。

(2)员工考核的目的是发掘与有效利用员工的能力,通过考核对员工给予公正的评价与待遇,如奖惩、升迁。企业部门管理中,销售经理的综合评分是由五个能力评分构成的,其中销售能力占整体的35%,沟通能力占20%,服务能力占15%,协作能力占10%,组织能力占20%。请基于公式或函数计算数据“销售经理能力考核表.xlsx”中每一位销售经理的综合评分(结果保留两位小数),并划分其评分等级。

具体的等级划分依据以下标准:[90,100]为优秀,[80,90)为良好,[0,80)为一般。最后在同一画布绘制所有销售经理各个能力评分的雷达图,要求对雷达图设置合适的标题、坐标轴和图例,坐标轴范围为[50,100]。最后将结果文件另存为“15-2结果.xlsx”。

【数据获取】

下载附件中的数据并解压。

【答案提交】

将完成的两个结果文件放在文件夹中,文件夹以“准考证号-答案报告15”命名,并将文件夹压缩成ZIP压缩包,压缩包以“考生1准考证号-答案报告15”命名,如“XXX答案报告15.zip”。答案以【考生1】账号提交的答案为准,若使用其他队员账号提交答案,或是以其他队员准考证号命名提交答案,视为无效提交。

【标签】问答题

【主观题结束】

🤵♂️ 个人博客主页: @旺仔Sec的博客主页

WeChat公众号:鹏璃安全

✍🏻 博主身份:网络安全兼技能大赛工程师(NISP、CISP、华为IE、IP、redhat、软考等职业证书报考可找我报考!)

🐋 希望大家多多支持,我们一起进步!😄

如果文章对你有帮助的话, 欢迎评论 💬点赞👍🏻 收藏 📂加关注(各大技能大赛参考答案链接如下)

🖥️:软件测试技能大赛参考答案

🙌:软件测试—单元自动化接口测试参考答案

👻:区块链技术应用技能大赛参考答案

🚀:大数据应用开发职业院校竞赛答案参阅

🔎:GZ100移动应用设计与开发参考答案

✍:GZ031应用软件系统开发参考答案

☠:网络安全职业技能大赛任务解析