large-scale-DRL-exploration代码阅读(三)

我们计算出注意力分布,并根据分布对输入信息进行加权求平均,这个结果是注意力,他后续怎么使用,他是一个标量吗?

🧩 1️⃣ 注意力结果不是一个标量!

这是一个很常见的误区。

我们来明确:

注意力机制产生两个主要输出:

(1) 注意力分布(attention weights)

(2) 加权求和后的向量(attention output)

-

对于每个 query(例如一个节点),这个向量告诉你它“关注”每个 key 的程度。

-

每一行加起来 = 1

-

这个分布可以用于可视化模型“在看哪里”,或用于解释性分析(explainability)。

✅ 加权求和后的结果 (attention output)

这才是 注意力层真正的输出。

也就是:对每个 query 节点,把所有 key 对应的 value 向量加权求平均。

结果是一个向量,不是标量!

🧠 2️⃣ 输出向量是如何使用的?

这个输出(每个节点一个向量)会被后续网络继续处理。比如在你的 EncoderLayer 里:

🔍 3️⃣ 举个直观例子

假设你有 3 个节点,输入特征如下:

| 节点 | 原始特征 (128维) | 含义 |

|---|---|---|

| A | [a₁, a₂, …] | 自身信息 |

| B | [b₁, b₂, …] | 邻居节点信息 |

| C | [c₁, c₂, …] | 另一个节点信息 |

经过注意力机制后,节点 A 的新特征是:

hA=αA,AVA+αA,BVB+αA,CVC

其中:

-

α 是 A 对各节点的注意力权重(总和=1)

-

V 是 value 向量

因此:

-

如果 α_{A,B} 高,表示 A 强烈“关注”B 的特征;

-

h_A 中就更多融合了 B 的信息。

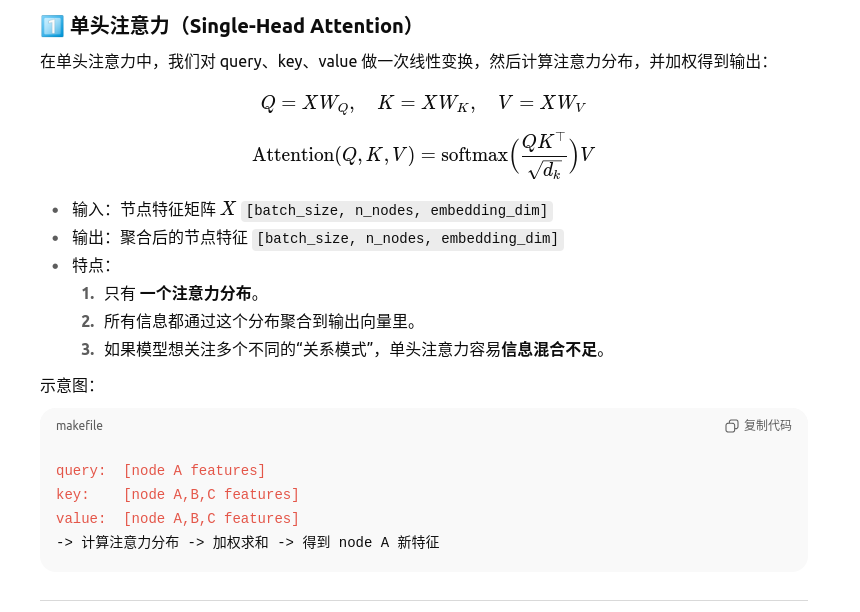

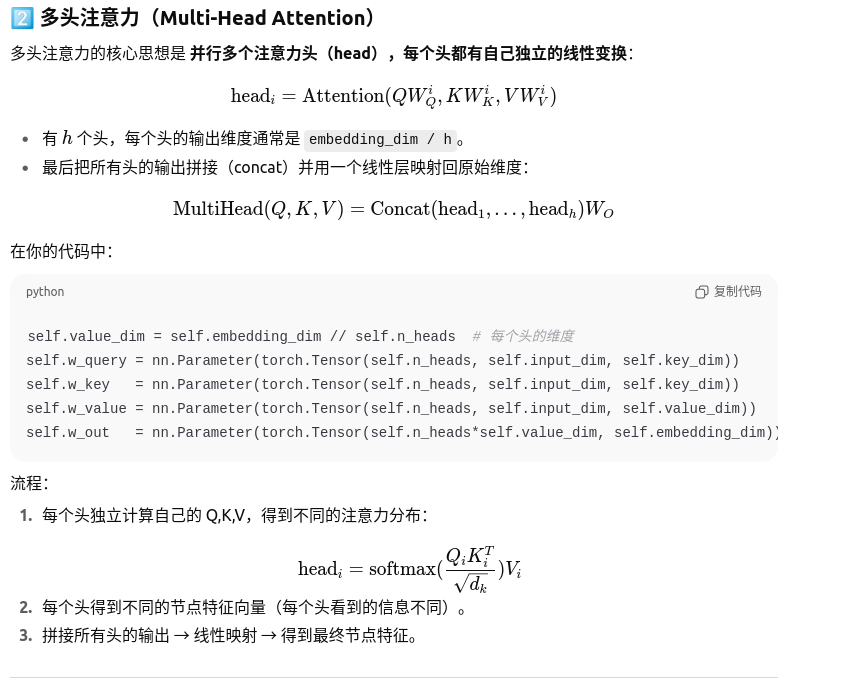

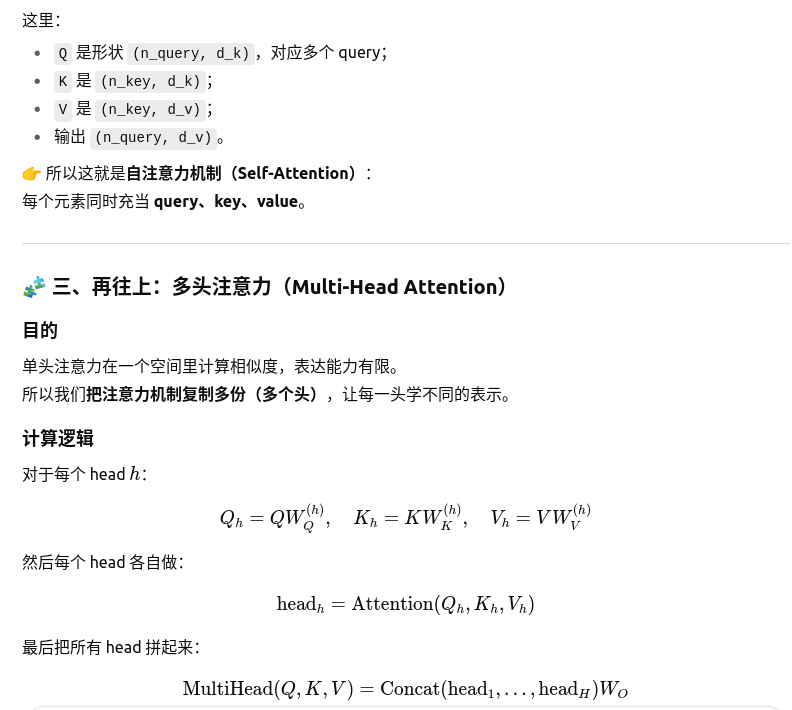

单多对比

✅ 直观理解

单头注意力:

-

就像一个人看问题时只用 一双眼睛,只能专注于一种模式。

-

如果你想同时关注局部邻居和全局趋势,单头可能抓不到。

多头注意力:

-

就像一个人有 多双眼睛,每双眼睛关注不同的方面:

-

头1关注局部节点关系

-

头2关注全局结构

-

头3关注节点度或特定邻居信息

-

-

最后把所有头的观察结果融合,形成更丰富的节点特征。

🔹 优势对比表

| 特性 | 单头注意力 | 多头注意力 |

|---|---|---|

| 注意力模式 | 单一 | 多种 |

| 信息表达能力 | 容易受限 | 更丰富 |

| 参数量 | 少 | 多 |

| 计算量 | 小 | 大(可并行化) |

| 表达全局与局部 | 不容易同时捕捉 | 能同时捕捉 |

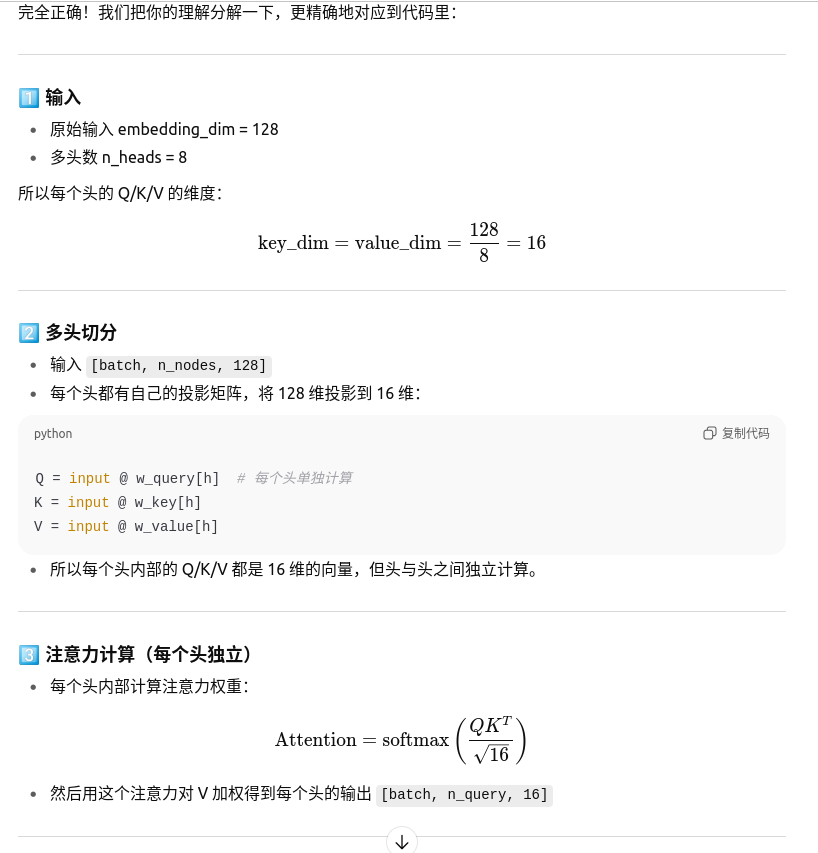

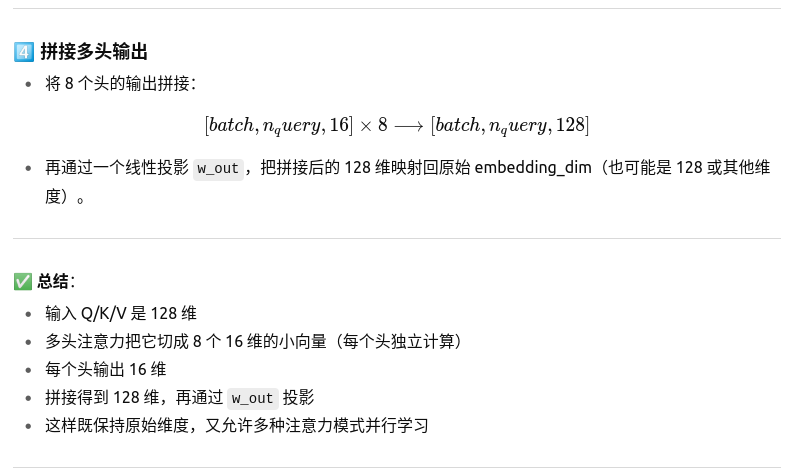

也就是说我的输入是128维的Q,K,V;但是我利用了多头注意力机制,一共八个头,现在我有128/8个Q,K,V,他们是128维的分割开的,各自并行计算,然后再拼接起来?

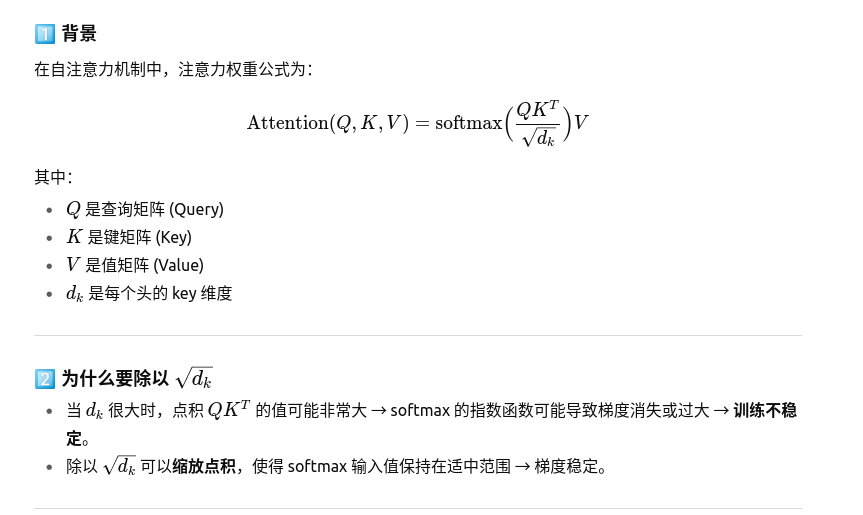

self.norm_factor = 1 / math.sqrt(self.key_dim)

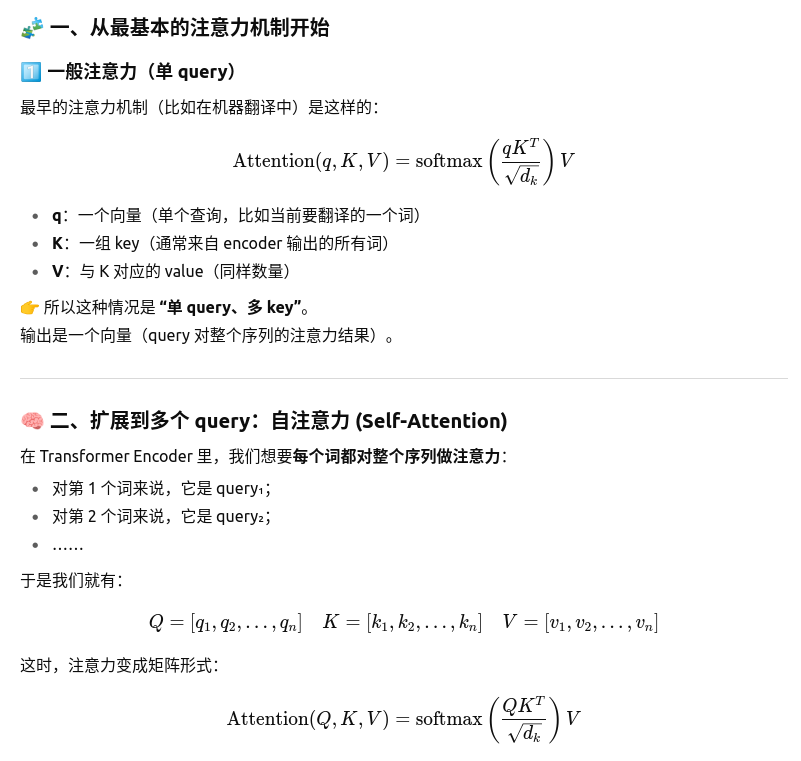

这个不是单头注意力机制吗 怎么会有多个key 和query

你说得对,这段 SingleHeadAttention 的确是单头注意力(Single-Head Attention),但“多个 key 和 query”并不是说多头,而是因为每个样本可能包含多个元素需要做注意力计算。

具体说明:

-

batch 维度 (

n_batch)-

代表同时处理的样本数量,比如 32 个图/序列同时计算。

-

-

query 维度 (

n_query)-

每个样本里有多少个 query。

-

比如在图节点选择任务里,每个图里可能有 1 个“当前节点”作为 query,也可能有多个 query 节点同时计算。

-

-

key 维度 (

n_key)-

每个样本里 key 的数量,也就是注意力要看的元素数量。

-

比如图里一个节点有多个邻居节点作为 key。

-

-

embedding 维度 (

n_dim)-

query/key/value 的特征维度,这里就是节点特征向量的长度。

-

输入可以有许多。输入可以作为 q k v ,所以n_key 就是输入的个数

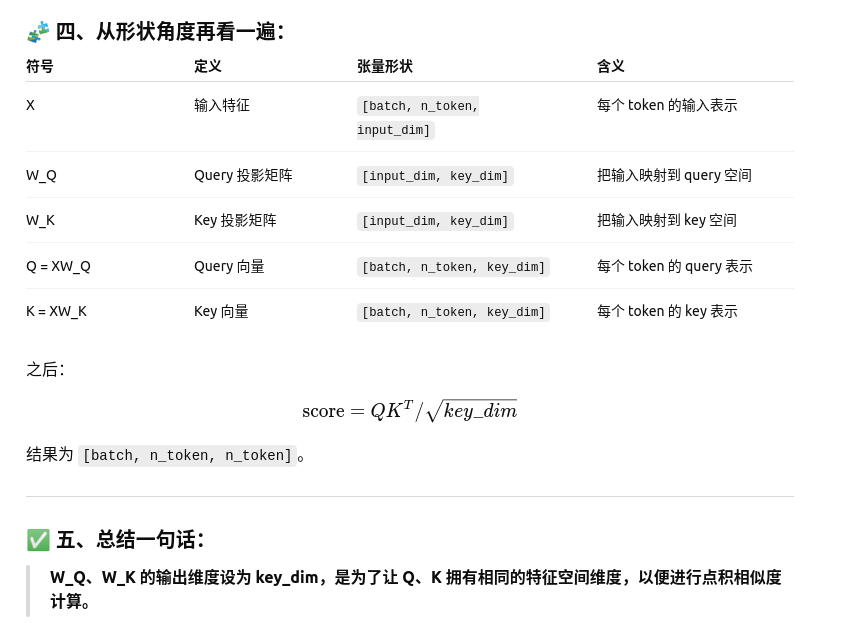

k_flat = k.reshape(-1, n_dim)

这两行代码的作用是把多维张量展平,方便矩阵乘法,具体解释如下:

假设 k 和 q 的原始形状分别是:

k: [n_batch, n_key, n_dim]

q: [n_batch, n_query, n_dim]

-

n_batch:批量大小 -

n_key:每个样本中 key 的数量 -

n_query:每个样本中 query 的数量 -

n_dim:特征维度

-

k_flat变成[n_batch * n_key, n_dim] -

q_flat变成[n_batch * n_query, n_dim]

这样做的原因是方便一次性用矩阵乘法 torch.matmul 对所有 query/key 做线性映射

Q = torch.matmul(q_flat, self.w_query) # [n_batch*n_query, key_dim]

K = torch.matmul(k_flat, self.w_key) # [n_batch*n_key, key_dim]

之后再用 .view() 恢复成 [n_batch, n_query, key_dim] 或 [n_batch, n_key, key_dim],方便后续计算注意力。

-1 表示自动推算维度

-

-1:表示让 PyTorch 自动推算这一维度的大小 -

n_dim:指定第二维是n_dim(每个 key 的特征维度保持不变)

self.norm_factor = 1 / math.sqrt(self.key_dim)

作用:防止 Q·K^T 由于 key_dim 太大而导致 softmax 输出过于集中,梯度消失。

维度总结

✅ 五、总结一句话:

| 向量 | 矩阵乘法 | 输出维度 | 目的 |

|---|---|---|---|

| Q = XW_Q | [input_dim, key_dim] | key_dim | 把输入映射到匹配空间 |

| K = XW_K | [input_dim, key_dim] | key_dim | 把输入映射到匹配空间 |

| V = XW_V | [input_dim, value_dim] | value_dim | 把输入映射到输出空间 |

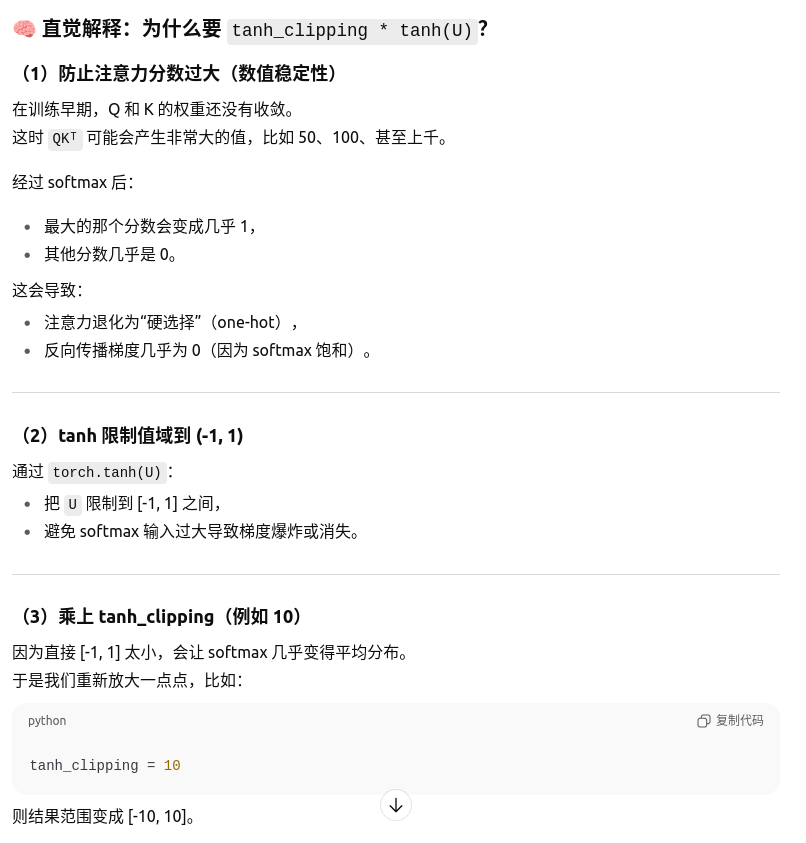

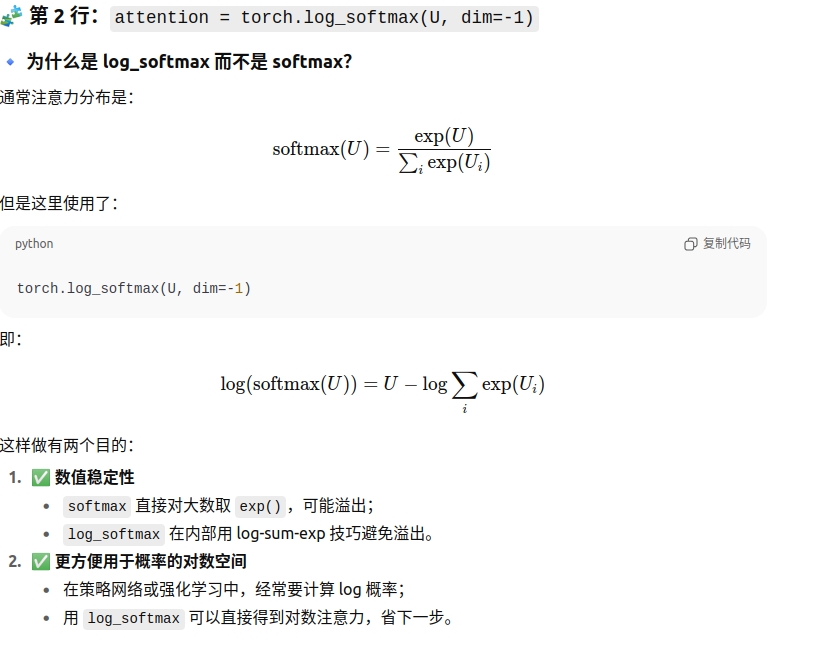

🔹 masked_fill 做了什么

masked_fill(mask == 1, -1e8) 的意思是:

把所有被 mask 掉的位置(mask == 1)的打分

U替换为一个极小的数(比如 -1e8)

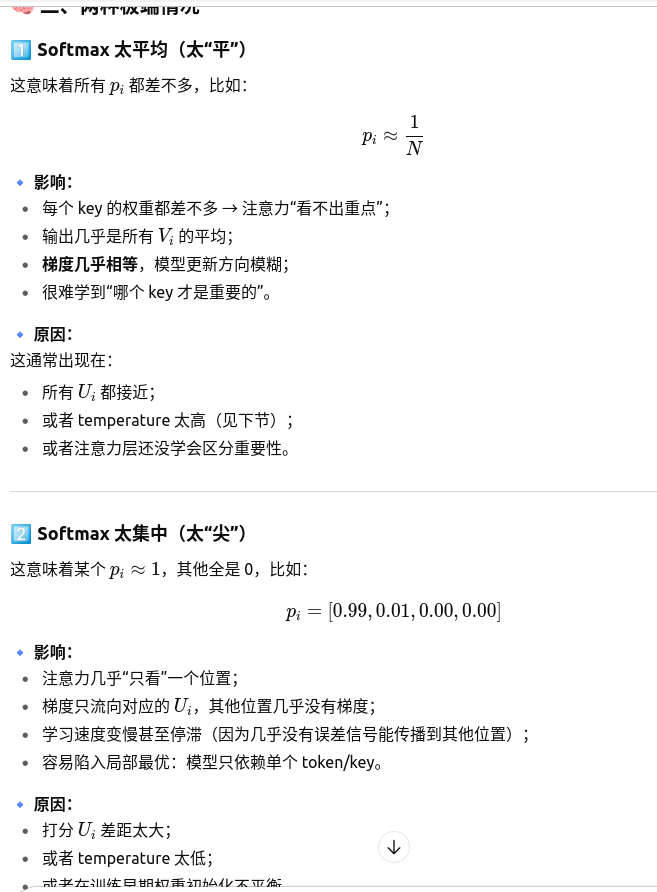

softmax() 太平均或者太集中,怎么影响梯度

刚刚的单头注意力机制一般查询不是一个吗,这里的多头注意力机制q不是一个了?,而是自注意力机制

🧠 四、回到你的问题总结一下

| 机制类型 | Query 的数量 | 特点 | 是否共享 Q,K,V 来源 | 是否有多头 |

|---|---|---|---|---|

| 单头注意力(经典) | 1 个 query | 计算单个 query 对一组 keys 的注意力 | Q≠K,V | ❌ |

| 自注意力(Self-Attention) | 多个 query(每个元素一个) | 每个位置都做注意力,建模内部依赖 | Q=K=V | ❌ |

| 多头自注意力(Multi-Head Self-Attention) | 多个 query,每个头有独立子空间 | 并行多个注意力头,表达力更强 | Q=K=V | ✅ |

💡 用一句话概括:

“单头注意力”只计算一个 query 对若干 key 的关注;

“自注意力”扩展成多个 query,每个元素都去看整个序列;

“多头注意力”再进一步,让多个独立的子空间同时看序列。

单头注意力机制可以有多个查询吗

可以,但要区分单头和自注意力的概念:

1️⃣ 单头注意力(Single-Head Attention)

-

核心定义:每个头只用一个注意力计算空间。

-

查询数量:

-

理论上,单头注意力可以同时计算多个 query 对同一组 key 的注意力,也就是 Q 可以是一个矩阵。

-

例如在机器翻译中,一个 batch 内每个 query 都可以并行计算注意力,只要还是“单个头”,输出维度就是 value 维度。

-

换句话说,单头注意力和 query 数量不是严格一一对应的关系,“单头”强调的是 只有一个注意力空间(embedding 维度不拆分)。

2️⃣ 自注意力(Self-Attention)

-

Q = K = V,通常每个位置都是一个 query。

-

单头也可以做自注意力,只是没有拆成多头,不同子空间的学习能力有限。

3️⃣ 多头注意力(Multi-Head Attention)

-

每个头都是一个独立的注意力空间。

-

Q 可以是多个 query,每个头并行处理这些 query,然后再拼接。

-

这样可以捕捉序列中不同角度的依赖关系。

✅ 总结:

-

单头注意力 ≠ 只能有一个 query

-

单头注意力强调的是“只有一个注意力子空间”。

-

**可以同时计算多个 query 的注意力,只是所有 query 在同一个头里计算”。