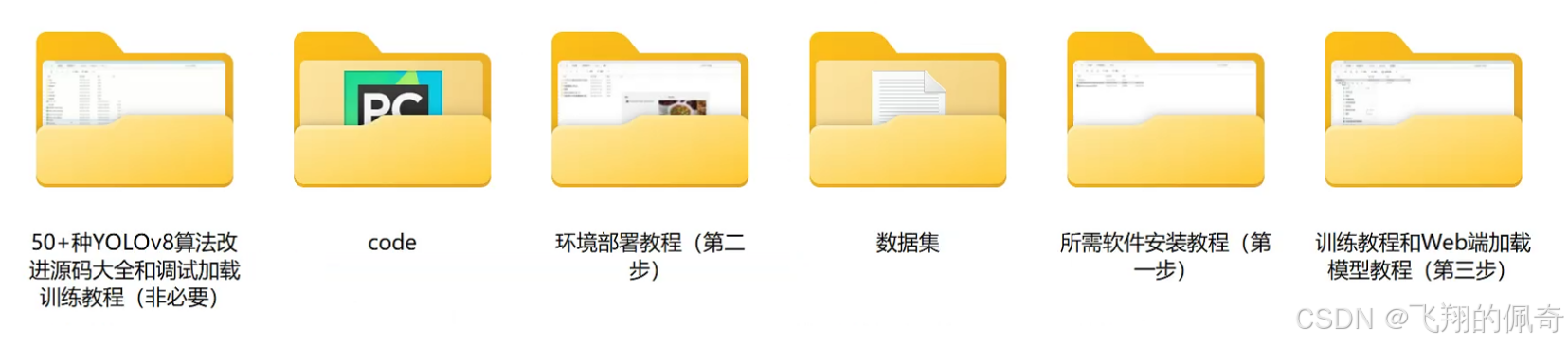

【完整源码+数据集+部署教程】 植物组织分割系统源码&数据集分享 [yolov8-seg-LSKNet等50+全套改进创新点发刊_一键训练教程_Web前端展示

背景意义

研究背景与意义

随着农业科技的不断进步,植物组织的精确分割与识别在植物生物学、农业生产和生态研究中显得尤为重要。植物组织的分割不仅能够帮助科学家深入理解植物的生长机制,还能为病虫害防治、作物育种及生物技术的应用提供重要的数据支持。近年来,深度学习技术的迅猛发展为图像处理领域带来了新的机遇,尤其是在实例分割任务中,YOLO(You Only Look Once)系列模型因其高效性和准确性而受到广泛关注。YOLOv8作为该系列的最新版本,结合了更为先进的特征提取和处理能力,为植物组织的分割提供了新的解决方案。

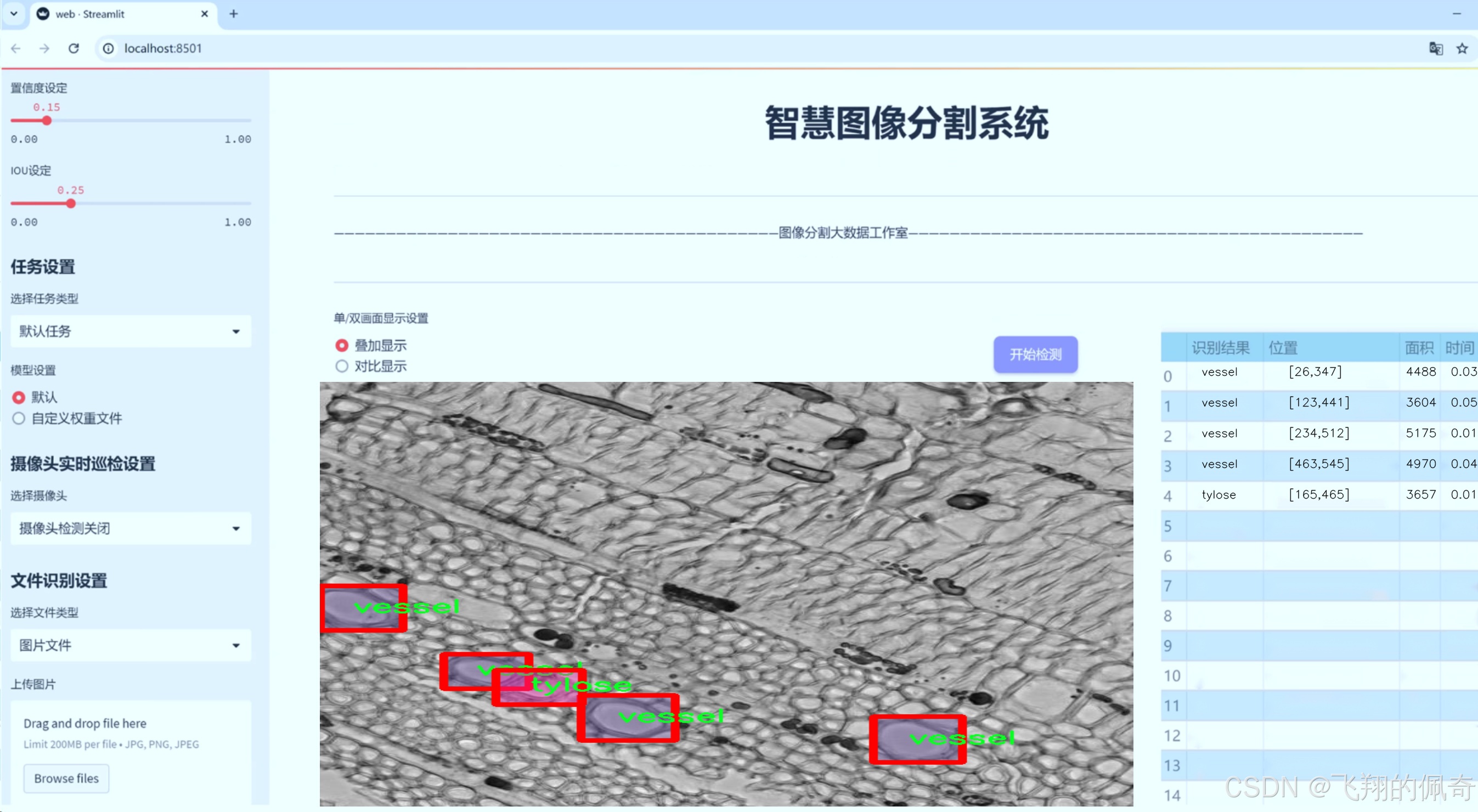

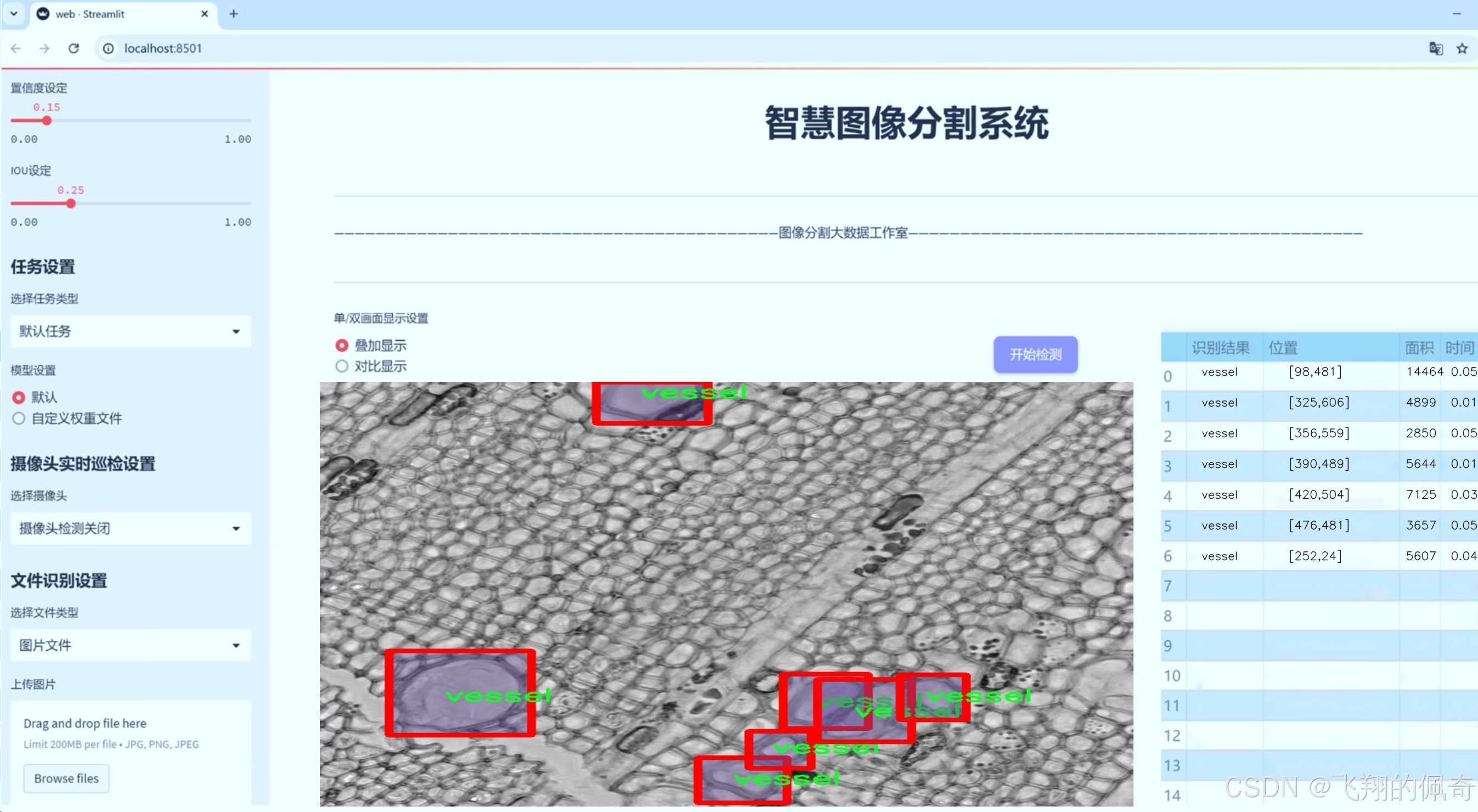

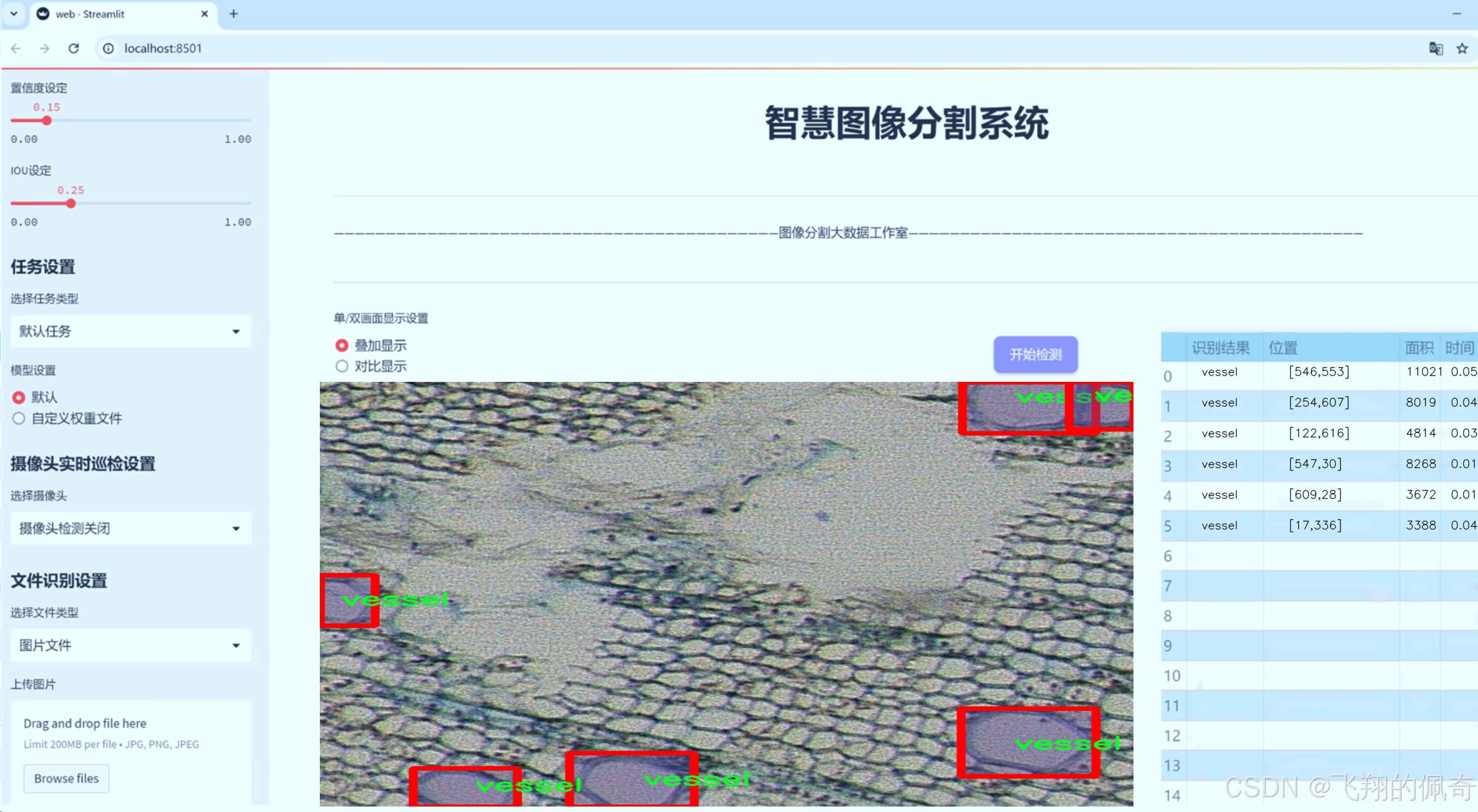

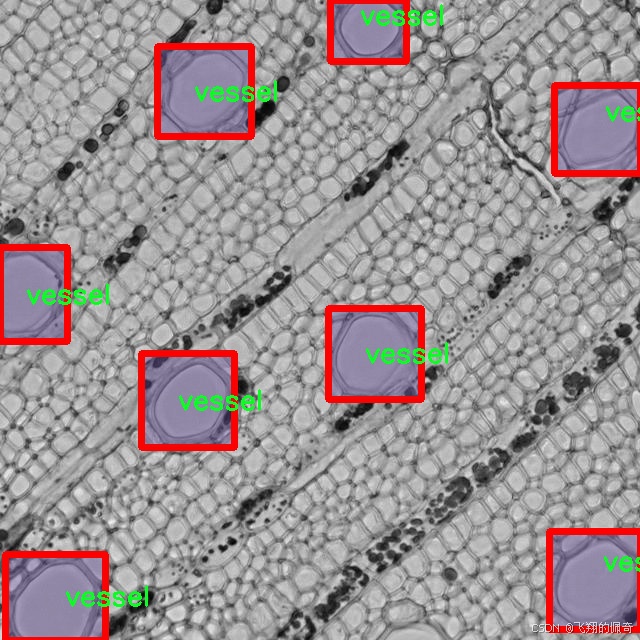

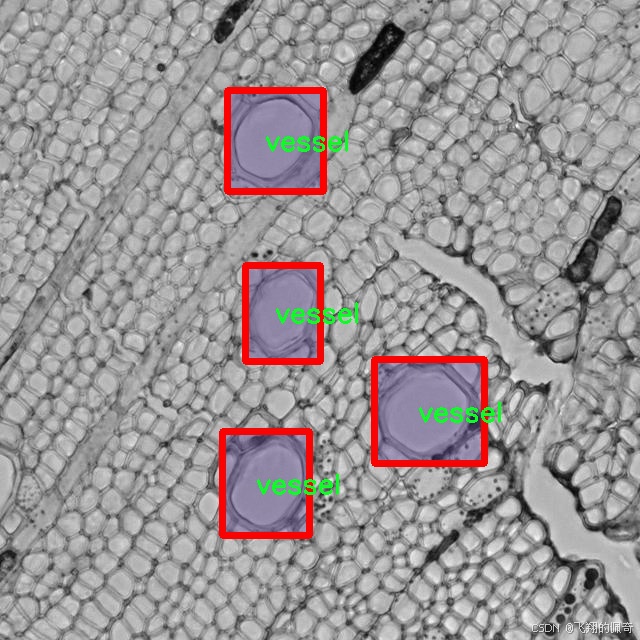

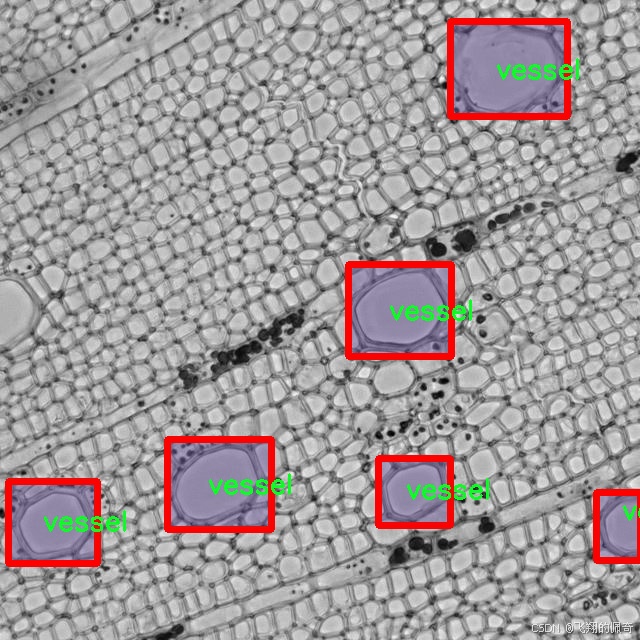

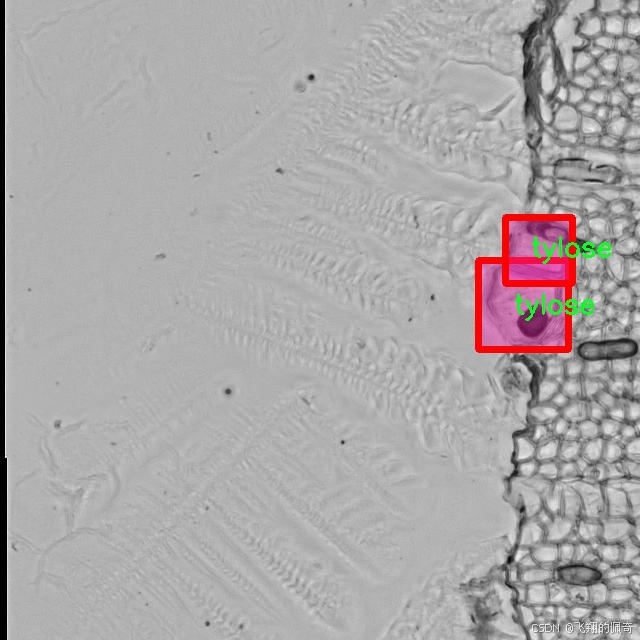

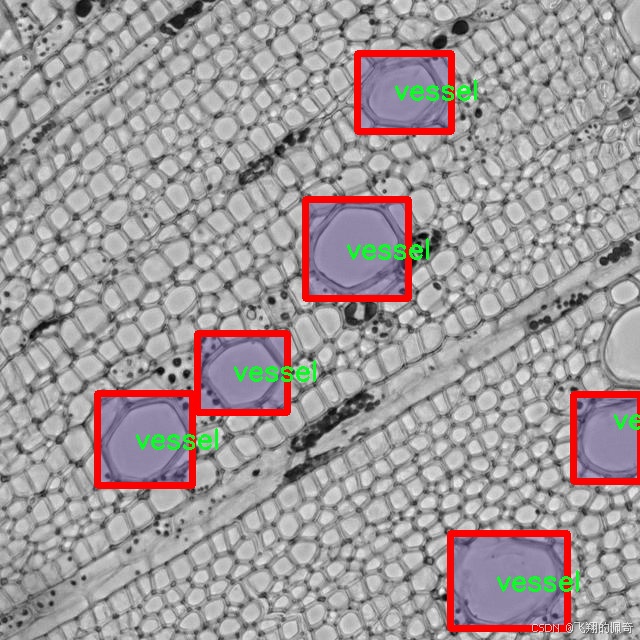

本研究旨在基于改进的YOLOv8模型,构建一个高效的植物组织分割系统,专注于两类植物组织的识别与分割:tylose(木质部细胞)和vessel(导管)。本研究所使用的数据集包含1800幅640x640像素的图像,涵盖了这两类植物组织的实例。这一数据集的构建不仅为模型的训练提供了丰富的样本,也为后续的研究提供了基础。通过对这些图像的分析与处理,研究者能够更好地理解植物组织的结构特征及其在植物生长中的功能。

在农业生产中,tylose的形成与植物的抗逆性密切相关,而vessel则是植物水分和养分运输的关键结构。对这两类组织的准确分割与识别,不仅有助于科学家深入研究植物的生理特性,还能为农业生产提供科学依据,帮助农民在实际生产中作出更为合理的决策。例如,通过监测tylose的分布情况,农民可以评估植物的健康状况,从而及时采取相应的管理措施;而对vessel的分析则可以帮助研究者理解植物在不同环境条件下的适应机制。

此外,随着数据科学和人工智能技术的不断发展,基于深度学习的图像分割技术在生物医学、环境监测等领域也展现出了广泛的应用前景。通过对植物组织的分割与分析,研究者可以将这一技术推广至其他生物体的组织分割任务中,推动生物科学研究的进步。

综上所述,基于改进YOLOv8的植物组织分割系统不仅具有重要的学术价值,还在实际应用中具有广泛的前景。通过对tylose和vessel的深入研究,我们能够为植物生物学、农业生产及生态保护提供更为精确的数据支持,进而推动可持续农业的发展。未来的研究将继续探索如何进一步优化模型性能,提高分割精度,以满足更为复杂的实际应用需求。

图片效果

数据集信息

数据集信息展示

在植物组织分割的研究领域,准确识别和分割不同类型的组织对于深入理解植物生理及其生长机制至关重要。本研究采用的数据集名为“2-3images_640x640”,该数据集专门设计用于训练和改进YOLOv8-seg模型,以实现高效的植物组织分割。数据集的核心特点在于其针对特定植物组织的细致标注,涵盖了两种主要类别:tylose(木栓细胞)和vessel(导管)。这两种组织在植物的水分运输和营养分配中扮演着重要角色,因此,准确的分割不仅能够提高模型的性能,还能为植物生物学的研究提供有力的数据支持。

数据集中的每个图像均经过精心挑选和处理,分辨率为640x640像素,确保了细节的清晰可见。这样的分辨率在进行深度学习训练时,能够有效地保留植物组织的微观结构特征,使得模型在学习过程中能够捕捉到更为细致的特征信息。每个图像都配有相应的标注文件,标注中详细列出了tylose和vessel的具体位置及其边界信息,这为YOLOv8-seg模型的训练提供了坚实的基础。

在数据集的构建过程中,研究团队采用了多种图像采集技术,以确保数据的多样性和代表性。这些图像来源于不同的植物样本,涵盖了不同的生长阶段和环境条件,确保了模型在实际应用中的鲁棒性。此外,数据集中的图像还经过了适当的增强处理,如旋转、缩放和亮度调整,以进一步提升模型的泛化能力。这种多样化的训练数据将有助于模型在面对未见过的样本时,依然能够保持较高的分割精度。

在进行模型训练时,YOLOv8-seg的结构优势将被充分发挥。该模型以其高效的特征提取能力和实时处理能力,能够快速处理大量图像数据,并在每个图像中准确识别出tylose和vessel。这种快速的处理能力对于植物组织的实时监测和分析尤为重要,能够为科研人员提供及时的反馈,助力植物生长研究和相关应用的推进。

此外,数据集的设计还考虑到了未来的扩展性。随着研究的深入,可能会有更多的植物组织类别需要被纳入到分割系统中。因此,数据集的构建不仅仅是为了当前的研究需求,也为后续的研究奠定了基础。研究人员可以在此基础上不断添加新的类别和样本,以不断提升模型的性能和适用范围。

综上所述,“2-3images_640x640”数据集在植物组织分割的研究中,扮演着不可或缺的角色。通过精心设计和多样化的样本选择,该数据集为YOLOv8-seg模型的训练提供了丰富的资源,使得模型能够在复杂的植物组织分割任务中表现出色。随着研究的不断深入,该数据集的价值将愈加凸显,为植物科学的进步贡献力量。

核心代码

```python

class BasePredictor:"""BasePredictor 类是用于创建预测器的基类。它负责设置模型、处理输入数据、执行推理并保存结果。"""def __init__(self, cfg=DEFAULT_CFG, overrides=None, _callbacks=None):"""初始化 BasePredictor 类。参数:cfg (str, optional): 配置文件的路径,默认为 DEFAULT_CFG。overrides (dict, optional): 配置覆盖,默认为 None。"""self.args = get_cfg(cfg, overrides) # 获取配置self.save_dir = get_save_dir(self.args) # 获取保存结果的目录if self.args.conf is None:self.args.conf = 0.25 # 默认置信度阈值为 0.25self.done_warmup = False # 是否完成模型预热if self.args.show:self.args.show = check_imshow(warn=True) # 检查是否可以显示图像# 初始化模型相关属性self.model = Noneself.data = self.args.data # 数据配置self.imgsz = None # 图像大小self.device = None # 设备(CPU/GPU)self.dataset = None # 数据集self.vid_path, self.vid_writer = None, None # 视频路径和写入器self.plotted_img = None # 绘制的图像self.data_path = None # 数据路径self.source_type = None # 数据源类型self.batch = None # 批次数据self.results = None # 推理结果self.transforms = None # 数据转换self.callbacks = _callbacks or callbacks.get_default_callbacks() # 回调函数self.txt_path = None # 文本路径callbacks.add_integration_callbacks(self) # 添加集成回调def preprocess(self, im):"""在推理之前准备输入图像。参数:im (torch.Tensor | List(np.ndarray)): 输入图像,支持张量或列表格式。返回:torch.Tensor: 处理后的图像张量。"""not_tensor = not isinstance(im, torch.Tensor) # 检查是否为张量if not_tensor:im = np.stack(self.pre_transform(im)) # 预处理图像im = im[..., ::-1].transpose((0, 3, 1, 2)) # BGR 转 RGB,格式转换im = np.ascontiguousarray(im) # 确保内存连续im = torch.from_numpy(im) # 转换为张量im = im.to(self.device) # 移动到指定设备im = im.half() if self.model.fp16 else im.float() # 转换为 fp16 或 fp32if not_tensor:im /= 255 # 归一化到 [0.0, 1.0]return imdef inference(self, im, *args, **kwargs):"""对给定图像执行推理。参数:im (torch.Tensor): 输入图像张量。返回:结果: 推理结果。"""return self.model(im, augment=self.args.augment) # 使用模型进行推理def __call__(self, source=None, model=None, stream=False, *args, **kwargs):"""对图像或流执行推理。参数:source: 数据源。model: 模型。stream: 是否为流模式。返回:结果: 推理结果。"""self.stream = streamif stream:return self.stream_inference(source, model, *args, **kwargs) # 流推理else:return list(self.stream_inference(source, model, *args, **kwargs)) # 合并结果def stream_inference(self, source=None, model=None, *args, **kwargs):"""在摄像头输入上进行实时推理,并将结果保存到文件。参数:source: 数据源。model: 模型。返回:生成器: 推理结果生成器。"""# 设置模型if not self.model:self.setup_model(model)# 设置数据源self.setup_source(source if source is not None else self.args.source)# 预热模型if not self.done_warmup:self.model.warmup(imgsz=(1, 3, *self.imgsz)) # 预热模型self.done_warmup = Truefor batch in self.dataset: # 遍历数据集path, im0s, vid_cap, s = batch # 获取批次数据# 预处理im = self.preprocess(im0s)# 推理preds = self.inference(im, *args, **kwargs)# 处理结果self.results = self.postprocess(preds, im, im0s)# 可视化、保存和写入结果for i in range(len(im0s)):self.write_results(i, self.results, (path[i], im, im0s[i]))yield from self.results # 生成推理结果def setup_model(self, model, verbose=True):"""初始化 YOLO 模型并设置为评估模式。参数:model: 模型参数。verbose: 是否输出详细信息。"""self.model = AutoBackend(model or self.args.model,device=select_device(self.args.device, verbose=verbose),fp16=self.args.half) # 设置模型self.device = self.model.device # 更新设备self.model.eval() # 设置为评估模式

代码核心部分说明:

- BasePredictor 类:这是一个用于执行推理的基类,包含初始化、预处理、推理和结果处理等功能。

- 预处理函数:负责将输入图像转换为适合模型输入的格式,包括归一化和设备转换。

- 推理函数:调用模型进行推理,返回结果。

- 流推理函数:支持实时推理,可以处理视频流或摄像头输入。

- 模型设置函数:初始化模型并设置为评估模式,确保模型准备好进行推理。

这些核心部分构成了 YOLO 推理的基础逻辑,能够处理不同类型的输入并输出推理结果。```

这个文件是Ultralytics YOLO(You Only Look Once)模型的预测引擎,主要用于在各种输入源(如图像、视频、网络摄像头等)上进行目标检测和预测。文件的结构和功能可以分为几个主要部分。

首先,文件中包含了一个类BasePredictor,这是一个基础预测器类,负责处理预测过程中的各种操作。类的初始化方法__init__中,首先获取配置参数,并设置保存结果的目录。它还定义了一些重要的属性,如模型、数据集、设备等,准备进行预测。

在BasePredictor类中,有多个方法负责不同的功能。preprocess方法用于对输入图像进行预处理,将图像转换为适合模型输入的格式。inference方法则执行实际的推理过程,调用模型进行预测。postprocess方法用于对模型的输出进行后处理,以便于后续的结果处理。

write_results方法负责将预测结果写入文件或目录中,并可选地将边界框绘制到图像上。show方法则使用OpenCV显示图像,方便用户查看实时结果。

文件中还定义了stream_inference方法,用于实时流媒体的推理,支持从摄像头或视频流中获取数据并进行处理。这个方法会处理每一帧图像,进行预处理、推理和后处理,并将结果保存或显示。

在设置模型的过程中,setup_model方法会初始化YOLO模型并将其设置为评估模式。这个过程确保模型准备好进行推理。

文件中还包含了一些用于回调的功能,允许在特定事件发生时执行用户定义的函数,比如在预测开始或结束时。这为用户提供了灵活性,可以根据需要扩展功能。

总的来说,这个文件实现了YOLO模型的预测功能,支持多种输入源和输出格式,能够高效地进行目标检测,并提供了丰富的可视化和结果保存选项。

```python

import torch

import torch.nn as nn

import math

import itertoolsclass Attention4D(nn.Module):"""实现4D注意力机制的类"""def __init__(self, dim=384, key_dim=32, num_heads=8, attn_ratio=4, resolution=7, act_layer=nn.ReLU, stride=None):super().__init__()self.num_heads = num_heads # 注意力头的数量self.scale = key_dim ** -0.5 # 缩放因子self.key_dim = key_dim # 键的维度self.resolution = resolution if stride is None else math.ceil(resolution / stride) # 分辨率# 定义卷积层用于生成查询、键、值self.q = nn.Conv2d(dim, num_heads * key_dim, kernel_size=1)self.k = nn.Conv2d(dim, num_heads * key_dim, kernel_size=1)self.v = nn.Conv2d(dim, num_heads * attn_ratio * key_dim, kernel_size=1)# 注意力偏置参数self.attention_biases = nn.Parameter(torch.zeros(num_heads, resolution ** 2, resolution ** 2))self.register_buffer('attention_bias_idxs', self._create_attention_bias_idxs(resolution))def _create_attention_bias_idxs(self, resolution):"""创建注意力偏置索引"""points = list(itertools.product(range(resolution), range(resolution)))idxs = []for p1 in points:for p2 in points:offset = (abs(p1[0] - p2[0]), abs(p1[1] - p2[1]))idxs.append(offset)return torch.LongTensor(idxs).view(len(points), len(points))def forward(self, x):"""前向传播"""B, C, H, W = x.shape # 获取输入的形状q = self.q(x).view(B, self.num_heads, -1, self.resolution ** 2).permute(0, 1, 3, 2) # 查询k = self.k(x).view(B, self.num_heads, -1, self.resolution ** 2).permute(0, 1, 2, 3) # 键v = self.v(x).view(B, self.num_heads, -1, self.resolution ** 2).permute(0, 1, 3, 2) # 值# 计算注意力权重attn = (q @ k) * self.scale + self.attention_biases[:, self.attention_bias_idxs]attn = attn.softmax(dim=-1) # 归一化# 计算输出x = (attn @ v).permute(0, 1, 3, 2).reshape(B, -1, self.resolution, self.resolution)return xclass EfficientFormerV2(nn.Module):"""EfficientFormerV2模型的实现"""def __init__(self, layers, embed_dims, num_classes=1000):super().__init__()self.num_classes = num_classesself.patch_embed = nn.Conv2d(3, embed_dims[0], kernel_size=3, stride=2, padding=1) # 初始嵌入层# 构建网络的各个阶段self.network = nn.ModuleList()for i in range(len(layers)):stage = self._create_stage(embed_dims[i], layers[i])self.network.append(stage)def _create_stage(self, dim, layers):"""创建网络的一个阶段"""blocks = []for _ in range(layers):blocks.append(Attention4D(dim)) # 添加注意力块return nn.Sequential(*blocks)def forward(self, x):"""前向传播"""x = self.patch_embed(x) # 嵌入输入for block in self.network:x = block(x) # 通过网络的每个阶段return x# 示例:创建模型并进行前向传播

if __name__ == '__main__':model = EfficientFormerV2(layers=[2, 2, 2], embed_dims=[32, 64, 128]) # 创建模型inputs = torch.randn((1, 3, 640, 640)) # 随机输入outputs = model(inputs) # 前向传播print(outputs.shape) # 输出形状

代码说明:

- Attention4D类:实现了一个4D注意力机制,包括查询、键、值的生成和注意力权重的计算。

- EfficientFormerV2类:定义了EfficientFormerV2模型的结构,包括嵌入层和多个注意力块的组合。

- 前向传播:在

forward方法中实现了输入数据的处理流程。

该代码片段保留了模型的核心结构和功能,去除了不必要的部分,便于理解和使用。```

这个程序文件实现了一个名为EfficientFormerV2的深度学习模型,主要用于计算机视觉任务。代码中定义了多个类和函数,构成了整个模型的结构和功能。

首先,文件导入了一些必要的库,包括PyTorch和一些数学函数,以及一些用于构建模型的工具函数。接着,定义了一些与模型相关的超参数,如不同版本的EfficientFormer的宽度和深度,这些参数会影响模型的复杂度和性能。

接下来,定义了多个类来构建模型的不同部分。Attention4D类实现了一个四维注意力机制,能够处理输入的特征图,并通过卷积和归一化层进行处理。这个类中包含了多个重要的组件,如查询、键、值的生成,以及注意力权重的计算。

LGQuery类用于生成局部查询,Attention4DDownsample类则实现了带有下采样功能的注意力机制。这些类的设计使得模型能够在不同的分辨率下有效地提取特征。

Embedding类负责将输入图像的通道数转换为嵌入维度,使用卷积层和归一化层进行处理。Mlp类实现了一个多层感知机(MLP),通过1x1卷积进行特征变换。

AttnFFN和FFN类则分别实现了带有注意力机制的前馈网络和普通的前馈网络,前者在特征处理时结合了注意力机制,后者则是传统的MLP结构。

eformer_block函数用于构建EfficientFormer的基本块,结合了注意力机制和前馈网络。EfficientFormerV2类是整个模型的核心,负责将各个部分组合在一起,形成完整的网络结构。

在模型的初始化过程中,根据输入的层数、嵌入维度、下采样参数等构建网络结构,并在需要时添加归一化层。forward方法定义了模型的前向传播过程,输入图像经过嵌入层和多个网络块的处理,最终输出特征。

此外,文件还定义了一些函数用于创建不同版本的EfficientFormer模型(如S0、S1、S2和L),并提供了加载预训练权重的功能。最后,在主程序中,创建了不同版本的模型实例,并对随机生成的输入数据进行了前向传播,输出了每个模型的特征图尺寸。

整体来看,这个文件实现了一个高效的视觉模型,结合了注意力机制和前馈网络,适用于各种计算机视觉任务。

```python

import torch

from functions.dcnv3_func import DCNv3Function, dcnv3_core_pytorch# 输入和输出的尺寸参数

H_in, W_in = 8, 8 # 输入的高度和宽度

N, M, D = 2, 4, 16 # N为批量大小,M为通道数,D为特征维度

Kh, Kw = 3, 3 # 卷积核的高度和宽度

remove_center = False # 是否移除中心点

P = Kh * Kw - remove_center # 卷积核的总点数

offset_scale = 2.0 # 偏移量的缩放因子

pad = 1 # 填充大小

dilation = 1 # 膨胀率

stride = 1 # 步幅

# 计算输出的高度和宽度

H_out = (H_in + 2 * pad - (dilation * (Kh - 1) + 1)) // stride + 1

W_out = (W_in + 2 * pad - (dilation * (Kw - 1) + 1)) // stride + 1# 设置随机种子

torch.manual_seed(3)@torch.no_grad()

def check_forward_equal_with_pytorch_double():# 创建输入、偏移量和掩码input = torch.rand(N, H_in, W_in, M * D).cuda() * 0.01offset = torch.rand(N, H_out, W_out, M * P * 2).cuda() * 10mask = torch.rand(N, H_out, W_out, M, P).cuda() + 1e-5mask /= mask.sum(-1, keepdim=True) # 归一化掩码mask = mask.reshape(N, H_out, W_out, M * P)# 使用PyTorch的核心函数计算输出output_pytorch = dcnv3_core_pytorch(input.double(),offset.double(),mask.double(),Kh, Kw, stride, stride, Kh // 2, Kw // 2, dilation, dilation, M, D, offset_scale, remove_center).detach().cpu()# 使用自定义的DCNv3函数计算输出output_cuda = DCNv3Function.apply(input.double(),offset.double(),mask.double(),Kh, Kw, stride, stride, Kh // 2, Kw // 2, dilation, dilation, M, D, offset_scale,im2col_step=2, remove_center).detach().cpu()# 检查两个输出是否相近fwdok = torch.allclose(output_cuda, output_pytorch)max_abs_err = (output_cuda - output_pytorch).abs().max() # 最大绝对误差max_rel_err = ((output_cuda - output_pytorch).abs() / output_pytorch.abs()).max() # 最大相对误差print('>>> forward double')print(f'* {fwdok} check_forward_equal_with_pytorch_double: max_abs_err {max_abs_err:.2e} max_rel_err {max_rel_err:.2e}')if __name__ == '__main__':check_forward_equal_with_pytorch_double() # 执行前向一致性检查

代码说明:

- 导入必要的库:导入PyTorch和自定义的DCNv3函数。

- 设置输入参数:定义输入图像的尺寸、卷积核的尺寸、通道数等参数。

- 计算输出尺寸:根据输入尺寸和卷积参数计算输出的高度和宽度。

- 随机种子:设置随机种子以确保结果可复现。

- 前向一致性检查函数:

check_forward_equal_with_pytorch_double函数用于检查自定义DCNv3实现与PyTorch实现的输出是否一致。它生成随机输入、偏移量和掩码,并计算两种实现的输出,最后比较它们的相似性。 - 主程序:在主程序中调用前向一致性检查函数。```

这个程序文件是一个用于测试深度学习中可微分卷积操作的代码,主要是针对DCNv3(Deformable Convolutional Networks v3)进行的实现和验证。程序的结构主要包括几个函数,用于检查前向和反向传播的正确性,以及性能测试。

首先,程序导入了一些必要的库,包括PyTorch和一些数学函数。接着,定义了一些常量,例如输入和输出的高度和宽度、卷积核的大小、填充、步幅等。这些参数是卷积操作的基本配置,影响卷积的输出尺寸和计算方式。

程序中定义了多个函数来进行不同的测试。check_forward_equal_with_pytorch_double和check_forward_equal_with_pytorch_float函数分别用于检查使用双精度和单精度浮点数时,DCNv3的前向传播输出是否与PyTorch的标准实现相同。它们通过生成随机输入、偏移量和掩码,调用自定义的DCNv3函数和PyTorch的实现,比较输出结果,并计算最大绝对误差和相对误差。

接下来的check_backward_equal_with_pytorch_double和check_backward_equal_with_pytorch_float函数则用于验证反向传播的梯度计算是否一致。这些函数同样生成随机数据,并计算梯度,然后比较自定义实现和PyTorch实现的梯度是否相近。

最后,check_time_cost函数用于测量DCNv3在特定输入大小和参数下的前向传播时间。它重复执行前向传播操作,并计算平均时间,以评估性能。

在主程序部分,依次调用这些测试函数,首先检查前向传播的正确性,然后验证反向传播的梯度一致性,最后进行性能测试。通过这些测试,开发者可以确保自定义的DCNv3实现与PyTorch的标准实现一致,并且在性能上满足需求。

```python

import numpy as np

import scipy.linalgclass KalmanFilterXYAH:"""简单的卡尔曼滤波器,用于在图像空间中跟踪边界框。状态空间为8维 (x, y, a, h, vx, vy, va, vh),包含边界框中心位置 (x, y),宽高比 a,高度 h 及其对应的速度。物体运动遵循恒定速度模型。"""def __init__(self):"""初始化卡尔曼滤波器模型矩阵,设置运动和观测的不确定性权重。"""ndim, dt = 4, 1. # 状态维度和时间步长# 创建卡尔曼滤波器模型矩阵self._motion_mat = np.eye(2 * ndim, 2 * ndim) # 运动矩阵for i in range(ndim):self._motion_mat[i, ndim + i] = dt # 设置速度部分self._update_mat = np.eye(ndim, 2 * ndim) # 更新矩阵# 运动和观测的不确定性权重self._std_weight_position = 1. / 20 # 位置不确定性权重self._std_weight_velocity = 1. / 160 # 速度不确定性权重def initiate(self, measurement):"""从未关联的测量创建跟踪。参数----------measurement : ndarray边界框坐标 (x, y, a, h),包含中心位置 (x, y),宽高比 a 和高度 h。返回-------(ndarray, ndarray)返回新的跟踪的均值向量 (8维) 和协方差矩阵 (8x8维)。未观测的速度初始化为0均值。"""mean_pos = measurement # 位置均值mean_vel = np.zeros_like(mean_pos) # 速度均值初始化为0mean = np.r_[mean_pos, mean_vel] # 合并位置和速度均值# 计算协方差矩阵的标准差std = [2 * self._std_weight_position * measurement[3], # 高度方向位置不确定性2 * self._std_weight_position * measurement[3], # 高度方向位置不确定性1e-2, # 宽高比不确定性2 * self._std_weight_position * measurement[3], # 高度方向位置不确定性10 * self._std_weight_velocity * measurement[3], # 高度方向速度不确定性10 * self._std_weight_velocity * measurement[3], # 高度方向速度不确定性1e-5, # 宽高比速度不确定性10 * self._std_weight_velocity * measurement[3] # 高度方向速度不确定性]covariance = np.diag(np.square(std)) # 生成协方差矩阵return mean, covariancedef predict(self, mean, covariance):"""执行卡尔曼滤波器预测步骤。参数----------mean : ndarray先前时间步的8维状态均值向量。covariance : ndarray先前时间步的8x8维状态协方差矩阵。返回-------(ndarray, ndarray)返回预测状态的均值向量和协方差矩阵。"""# 计算运动协方差std_pos = [self._std_weight_position * mean[3], # 高度方向位置不确定性self._std_weight_position * mean[3], # 高度方向位置不确定性1e-2, # 宽高比不确定性self._std_weight_position * mean[3] # 高度方向位置不确定性]std_vel = [self._std_weight_velocity * mean[3], # 高度方向速度不确定性self._std_weight_velocity * mean[3], # 高度方向速度不确定性1e-5, # 宽高比速度不确定性self._std_weight_velocity * mean[3] # 高度方向速度不确定性]motion_cov = np.diag(np.square(np.r_[std_pos, std_vel])) # 运动协方差矩阵# 预测均值和协方差mean = np.dot(mean, self._motion_mat.T) # 更新均值covariance = np.linalg.multi_dot((self._motion_mat, covariance, self._motion_mat.T)) + motion_cov # 更新协方差return mean, covariancedef update(self, mean, covariance, measurement):"""执行卡尔曼滤波器校正步骤。参数----------mean : ndarray预测状态的均值向量 (8维)。covariance : ndarray状态的协方差矩阵 (8x8维)。measurement : ndarray4维测量向量 (x, y, a, h),其中 (x, y) 是中心位置,a 是宽高比,h 是高度。返回-------(ndarray, ndarray)返回测量校正后的状态分布。"""projected_mean, projected_cov = self.project(mean, covariance) # 投影到测量空间# 计算卡尔曼增益chol_factor, lower = scipy.linalg.cho_factor(projected_cov, lower=True, check_finite=False)kalman_gain = scipy.linalg.cho_solve((chol_factor, lower),np.dot(covariance, self._update_mat.T).T,check_finite=False).Tinnovation = measurement - projected_mean # 计算创新# 更新均值和协方差new_mean = mean + np.dot(innovation, kalman_gain.T) # 更新均值new_covariance = covariance - np.linalg.multi_dot((kalman_gain, projected_cov, kalman_gain.T)) # 更新协方差return new_mean, new_covariance

代码说明

- KalmanFilterXYAH 类:实现了一个简单的卡尔曼滤波器,用于跟踪图像中的边界框,状态空间包含位置、宽高比、高度及其速度。

- 初始化方法:设置运动和观测的不确定性权重,并构建运动和更新矩阵。

- initiate 方法:从测量数据创建新的跟踪对象,返回均值和协方差矩阵。

- predict 方法:根据当前状态的均值和协方差进行预测,返回预测后的均值和协方差。

- update 方法:根据新的测量数据更新状态,返回校正后的均值和协方差。```

这个程序文件实现了一个简单的卡尔曼滤波器,用于在图像空间中跟踪边界框。文件中定义了两个类:KalmanFilterXYAH和KalmanFilterXYWH,分别用于处理不同格式的边界框数据。

KalmanFilterXYAH类用于处理包含中心位置(x, y)、长宽比(a)和高度(h)的边界框,状态空间是8维的,包含位置、长宽比、高度及其对应的速度。该类的构造函数初始化了运动模型和观测模型的矩阵,并设置了运动和观测的不确定性权重。

initiate方法用于从未关联的测量值创建一个新的跟踪对象。它接受一个包含边界框坐标的测量值,并返回初始化的状态均值和协方差矩阵。状态均值由测量值和零速度组成,协方差矩阵则基于测量值的标准差计算。

predict方法执行卡尔曼滤波的预测步骤,基于先前的状态均值和协方差,返回预测的状态均值和协方差矩阵。

project方法将状态分布投影到测量空间,返回投影后的均值和协方差。multi_predict方法是该预测步骤的向量化版本,能够同时处理多个状态。

update方法执行卡尔曼滤波的校正步骤,结合预测的状态和新的测量值,返回更新后的状态均值和协方差。gating_distance方法计算状态分布与测量值之间的门控距离,帮助判断测量值是否与当前状态匹配。

KalmanFilterXYWH类继承自KalmanFilterXYAH,用于处理包含中心位置(x, y)、宽度(w)和高度(h)的边界框。它重写了initiate、predict和project方法,以适应新的状态表示。

总体而言,这个文件实现了一个灵活的卡尔曼滤波器,能够根据不同的边界框格式进行跟踪,适用于计算机视觉中的目标跟踪任务。

```python

import numpy as np

import torchdef box_iou(box1, box2, eps=1e-7):"""计算两个边界框之间的交并比(IoU)。参数:box1 (torch.Tensor): 形状为 (N, 4) 的张量,表示 N 个边界框。box2 (torch.Tensor): 形状为 (M, 4) 的张量,表示 M 个边界框。eps (float, optional): 避免除以零的小值,默认为 1e-7。返回:(torch.Tensor): 形状为 (N, M) 的张量,包含 box1 和 box2 中每对边界框的 IoU 值。"""# 获取边界框的坐标(a1, a2), (b1, b2) = box1.unsqueeze(1).chunk(2, 2), box2.unsqueeze(0).chunk(2, 2)# 计算交集面积inter = (torch.min(a2, b2) - torch.max(a1, b1)).clamp_(0).prod(2)# 计算 IoU = 交集 / (面积1 + 面积2 - 交集)return inter / ((a2 - a1).prod(2) + (b2 - b1).prod(2) - inter + eps)def bbox_iou(box1, box2, xywh=True, eps=1e-7):"""计算边界框之间的交并比(IoU),支持 (x, y, w, h) 和 (x1, y1, x2, y2) 格式。参数:box1 (torch.Tensor): 形状为 (1, 4) 的张量,表示单个边界框。box2 (torch.Tensor): 形状为 (n, 4) 的张量,表示 n 个边界框。xywh (bool, optional): 如果为 True,输入框为 (x, y, w, h) 格式;否则为 (x1, y1, x2, y2) 格式。默认为 True。eps (float, optional): 避免除以零的小值,默认为 1e-7。返回:(torch.Tensor): 计算得到的 IoU 值。"""# 转换坐标格式if xywh: # 从 (x, y, w, h) 转换为 (x1, y1, x2, y2)(x1, y1, w1, h1), (x2, y2, w2, h2) = box1.chunk(4, -1), box2.chunk(4, -1)b1_x1, b1_x2, b1_y1, b1_y2 = x1 - w1 / 2, x1 + w1 / 2, y1 - h1 / 2, y1 + h1 / 2b2_x1, b2_x2, b2_y1, b2_y2 = x2 - w2 / 2, x2 + w2 / 2, y2 - h2 / 2, y2 + h2 / 2else: # 直接使用 (x1, y1, x2, y2) 格式b1_x1, b1_y1, b1_x2, b1_y2 = box1.chunk(4, -1)b2_x1, b2_y1, b2_x2, b2_y2 = box2.chunk(4, -1)# 计算交集面积inter = (b1_x2.minimum(b2_x2) - b1_x1.maximum(b2_x1)).clamp_(0) * \(b1_y2.minimum(b2_y2) - b1_y1.maximum(b2_y1)).clamp_(0)# 计算并集面积union = (b1_x2 - b1_x1) * (b1_y2 - b1_y1 + eps) + (b2_x2 - b2_x1) * (b2_y2 - b2_y1 + eps) - inter + eps# 返回 IoU 值return inter / uniondef mask_iou(mask1, mask2, eps=1e-7):"""计算两个掩码之间的交并比(IoU)。参数:mask1 (torch.Tensor): 形状为 (N, n) 的张量,N 是真实对象的数量,n 是图像宽度和高度的乘积。mask2 (torch.Tensor): 形状为 (M, n) 的张量,M 是预测对象的数量,n 是图像宽度和高度的乘积。eps (float, optional): 避免除以零的小值,默认为 1e-7。返回:(torch.Tensor): 形状为 (N, M) 的张量,表示掩码的 IoU。"""intersection = torch.matmul(mask1, mask2.T).clamp_(0) # 计算交集union = (mask1.sum(1)[:, None] + mask2.sum(1)[None]) - intersection # 计算并集return intersection / (union + eps) # 返回 IoU

代码说明:

- box_iou: 计算两个边界框之间的交并比(IoU),支持批量处理。

- bbox_iou: 计算单个边界框与多个边界框之间的 IoU,支持不同的坐标格式(xywh 和 xyxy)。

- mask_iou: 计算两个二进制掩码之间的 IoU,适用于分割任务。

这些函数是目标检测和分割任务中非常核心的部分,主要用于评估模型的性能。```

这个程序文件是用于计算和评估模型性能的各种指标,主要应用于目标检测和分类任务。文件中定义了多个函数和类,分别用于计算不同的指标,如交并比(IoU)、平均精度(AP)、混淆矩阵等。

首先,文件中导入了一些必要的库,包括数学库、警告处理、路径处理、绘图工具、NumPy和PyTorch等。接着,定义了一些常量和函数,用于计算边界框的交集、并集以及不同类型的IoU(如GIoU、DIoU、CIoU等)。这些函数的输入通常是边界框的坐标,输出则是相应的IoU值或交集面积。

接下来,文件中定义了多个类,主要包括ConfusionMatrix、Metric、DetMetrics、SegmentMetrics、PoseMetrics和ClassifyMetrics等。这些类封装了不同的评估指标和方法,便于在模型训练和评估过程中使用。

ConfusionMatrix类用于计算和更新混淆矩阵,提供了处理分类和检测任务的功能。它包含方法来处理预测结果、绘制混淆矩阵以及打印矩阵信息。

Metric类用于计算YOLOv8模型的评估指标,包括精度、召回率和平均精度等。它提供了多个属性和方法,用于获取不同的评估结果。

DetMetrics类是一个用于计算目标检测指标的工具类,提供了处理预测结果、计算平均精度和返回结果字典等功能。

SegmentMetrics类则用于计算分割任务的指标,结合了目标检测和分割的评估方法。

PoseMetrics类扩展了SegmentMetrics,用于计算姿态估计的指标。

最后,ClassifyMetrics类用于计算分类任务的指标,包括Top-1和Top-5准确率。它提供了处理目标和预测的功能,并计算相应的准确率。

整体而言,这个程序文件为目标检测、分割和分类任务提供了全面的评估指标计算功能,便于开发者在训练和测试模型时进行性能评估。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式