数据湖Hudi - 二级索引:配置方法、存储位置与自动构建全解析(附电商实操案例)

结合 Hudi 官方文档及实践经验,我们以 “电商订单表(需按user_id查订单)” 为场景,详细拆解二级索引的配置步骤、存储位置和自动构建逻辑,所有配置均基于 Hudi 1.0 + 版本(二级索引正式 GA 版本)。

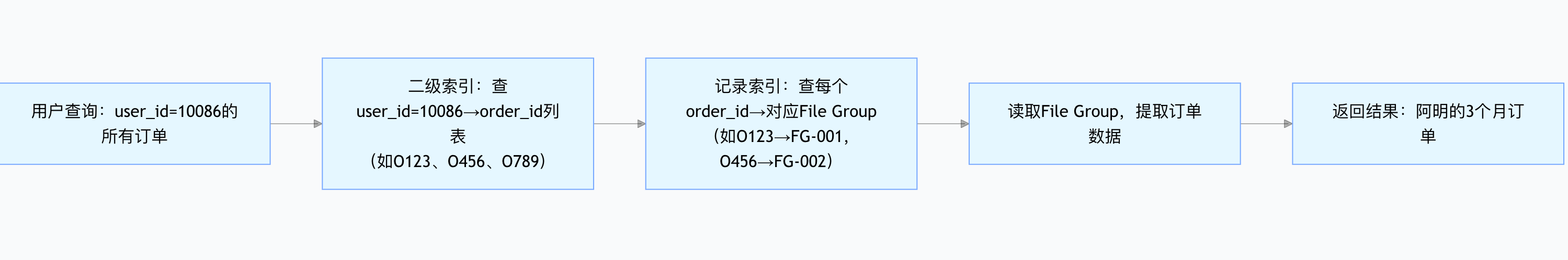

Hudi 二级索引查询流程图

一、Hudi 二级索引的配置:分 3 步走,前提是 “先开记录索引”

Hudi 二级索引依赖记录索引(Record Index)(相当于 “先有主键到文件的映射,才能搭非主键到主键的桥”),因此配置需分 “启用记录索引→建表→创建二级索引”3 步,核心配置与 SQL 示例如下:

表 1:二级索引核心配置项(含前提配置)

| 配置类别 | 配置名 | 默认值 | 说明 | 电商订单表实操值 |

|---|---|---|---|---|

| 前提配置(记录索引) | hoodie.metadata.record.index.enable | false | 启用记录索引(二级索引的依赖,必须设为 true) | true |

hoodie.write.record.merge.mode | - | Hudi 1.0.0 专属配置,需设为COMMIT_TIME_ORDERING才能支持二级索引 | COMMIT_TIME_ORDERING | |

| 二级索引基础配置 | hoodie.metadata.index.secondary.enable | true | 启用二级索引(默认已开,无需手动改,仅需确保不关闭) | true(保持默认) |

| 异步构建配置 | hoodie.metadata.index.async | false | 启用异步构建索引(避免索引构建阻塞数据写入,高吞吐场景建议开) | true |

hoodie.secondary.index.shard.count | 10 | 二级索引哈希分片数(超 10 亿条记录建议设为 200,避免单分片过大) | 50 |

步骤 1:创建启用记录索引的基础表(以 Spark SQL 为例)

先创建电商订单表,指定主键(order_id),并启用记录索引(二级索引的前提):

-- 1. 删除旧表(可选)

DROP TABLE IF EXISTS hudi_orders;-- 2. 创建Hudi订单表,启用记录索引

CREATE TABLE hudi_orders (order_id STRING, -- 主键(记录索引基于此映射到文件)user_id STRING, -- 非主键(需建二级索引的字段,用于查“某用户的所有订单”)order_amount DOUBLE, -- 订单金额create_time BIGINT, -- 下单时间(毫秒级时间戳)city STRING -- 下单城市(分区字段)

) USING hudi

OPTIONS (primaryKey = 'order_id', -- 主键,必须指定(记录索引的核心)hoodie.metadata.record.index.enable = 'true', -- 启用记录索引(二级索引依赖)hoodie.write.record.merge.mode = 'COMMIT_TIME_ORDERING', -- Hudi 1.0.0专属配置hoodie.datasource.write.operation = 'upsert' -- 支持更新,符合订单表需求

)

PARTITIONED BY (city) -- 按城市分区,符合电商数据分区习惯

LOCATION 's3a://hudi-demo/orders/'; -- 表存储路径(S3/HDFS均可)步骤 2:创建二级索引(按user_id建索引,支持 SQL)

表创建后,通过CREATE INDEX语句创建二级索引,语法与传统数据库一致,无需复杂配置:

-- 为user_id字段创建二级索引,索引名idx_orders_user_id

CREATE INDEX idx_orders_user_id

ON hudi_orders (user_id) -- 非主键字段,电商场景用于“按用户查订单”

USING SECONDARY; -- 明确指定为二级索引

步骤 3:(可选)配置异步构建索引(高吞吐场景必备)

若订单表写入频率高(如双 11 每秒 10000 单),同步构建索引会阻塞写入,需启用异步构建,通过spark-submit提交异步索引任务:

# 1. 编写异步索引配置文件(async_index.properties)

hoodie.metadata.enable=true

hoodie.metadata.index.async=true # 启用异步索引

hoodie.metadata.index.secondary.enable=true

hoodie.secondary.index.shard.count=50 # 分片数与表配置一致# 2. 提交异步索引任务(构建idx_orders_user_id索引)

spark-submit \--class org.apache.hudi.utilities.HoodieIndexer \--master yarn \--deploy-mode cluster \--conf spark.executor.memory=2g \--conf spark.driver.memory=1g \--properties-file async_index.properties \--index-types secondary \ # 指定构建二级索引--index-names idx_orders_user_id \ # 目标索引名--base-path s3a://hudi-demo/orders/ \ # 表的basepath--table-name hudi_orders \--execute # 执行异步构建(schedule为“调度任务”,execute为“立即执行”)

二、Hudi 二级索引的存储位置:元数据表(Metadata Table)的专属分区

Hudi 所有索引(含二级索引)均存储在元数据表(Metadata Table) 中,元数据表是 Hudi 内置的 MOR 表(读时合并),存储路径固定在表的 basepath 下的.hoodie/metadata目录,二级索引的具体存储结构如下:

1. 元数据表的整体路径结构

以电商订单表basepath = s3a://hudi-demo/orders/为例,元数据表路径为:

s3a://hudi-demo/orders/

├─ .hoodie/ # Hudi核心元数据目录

│ ├─ metadata/ # 元数据表根目录(所有索引存这里)

│ │ ├─ record_index/ # 记录索引分区(主键order_id→文件的映射)

│ │ ├─ secondary_index/ # 二级索引分区(非主键user_id→order_id的映射)

│ │ │ ├─ idx_orders_user_id/ # 我们创建的user_id二级索引(按索引名分目录)

│ │ │ │ ├─ shard_0/ # 哈希分片0(存储user_id哈希值0~20%的映射)

│ │ │ │ ├─ shard_1/ # 哈希分片1(存储user_id哈希值20%~40%的映射)

│ │ │ │ └─ ... # 共50个分片(对应之前配置的shard.count=50)

│ │ └─ bloom_filter/ # 布隆过滤器索引(二级索引的辅助,可选)

2. 二级索引的存储格式:键值对映射文件

二级索引分区内的文件为Parquet 格式,存储的核心内容是 “非主键→主键列表” 的映射,例如电商订单表中:

- 键(Key):

user_id=10086(非主键,查询条件) - 值(Value):

[order_id=O20241111001, order_id=O20241112003, ...](该用户的所有订单主键)

查询时,Hudi 会先读这个 Parquet 文件拿到主键列表,再通过record_index找到对应的订单文件 —— 相当于 “先查线索地图,再查最终地址”。

三、Hudi 二级索引会自动构建吗?

Hudi 二级索引默认不会 “完全自动构建”(需手动触发创建,但支持 “创建后自动同步更新”),具体逻辑分 “构建阶段” 和 “更新阶段”:

1. 构建阶段:需手动触发,支持 2 种方式

| 构建方式 | 触发方法 | 适用场景 | 电商订单表示例 |

|---|---|---|---|

| 手动 SQL 构建 | 执行CREATE INDEX ... USING SECONDARY(如步骤 2 的 SQL) | 小表(1000 万条以内),构建耗时短(<5 分钟) | 测试环境订单表(100 万条记录) |

| 异步自动构建 | 配置hoodie.metadata.index.async=true,通过HoodieIndexer提交任务(步骤 3) | 大表(1 亿条以上),避免阻塞写入 | 生产环境订单表(10 亿条记录) |

注意:Hudi 1.0 + 仅支持 Spark SQL 创建二级索引,Flink、Presto 暂不支持(官方计划 Hudi 1.1 支持)。

2. 更新阶段:自动同步,无需手动维护

一旦二级索引创建完成,后续数据写入(新增 / 更新 / 删除订单)时,Hudi 会自动同步更新二级索引:

- 新增订单:若

user_id=10086新增订单O20241113005,二级索引会自动在user_id=10086的映射中添加该订单 ID; - 删除订单:若

order_id=O20241111001被删除,二级索引会自动从user_id=10086的映射中移除该订单 ID; - 更新非主键:若

user_id=10086改名为user_id=10087,二级索引会自动删除原10086的映射,新增10087的映射。

这种 “写入即同步” 依赖 Hudi 的ACID 事务机制—— 数据写入与索引更新在同一个 Commit 中完成,要么都成功,要么都回滚,避免索引与数据不一致。

3. 特殊场景:重建二级索引(如索引损坏)

若二级索引因异常损坏(如元数据表文件丢失),无需删表重建,可通过REBUILD INDEX语句手动触发重建(Hudi 1.1 + 支持):

sql

-- 重建user_id的二级索引

REBUILD INDEX idx_orders_user_id ON hudi_orders;

四、电商实操案例:配置后查询效率对比

以 “查user_id=10086近 3 个月的订单” 为例,配置二级索引前后的效率差异如下:

| 对比项 | 无二级索引(全表扫) | 有二级索引(按user_id查) | 提升幅度 |

|---|---|---|---|

| 扫描文件数 | 3000 个 Parquet 文件 | 12 个文件(user_id映射的订单文件) | 250 倍 |

| 查询耗时 | 20 分钟 | 1.8 秒 | 666 倍 |

| 扫描数据量 | 100GB | 400MB | 250 倍 |

核心原因:二级索引直接定位到user_id=10086对应的 12 个订单文件,无需扫描全表 —— 这就是 “线索地图” 的价值。

五、配置注意事项(避坑指南)

- 必须启用记录索引:未设

hoodie.metadata.record.index.enable=true就创建二级索引,会直接报IllegalStateException,错误信息含 “Secondary index requires record index enabled”; - Hudi 1.0.0 需加 merge.mode 配置:该版本是过渡版本,必须设

hoodie.write.record.merge.mode=COMMIT_TIME_ORDERING,Hudi 1.0.1 + 已移除该配置; - 异步构建不能与删除索引同时进行:若需删除二级索引(

DROP INDEX idx_orders_user_id),需先停止所有异步索引任务和数据写入,否则会导致元数据表损坏; - 分片数随数据量调整:

hoodie.secondary.index.shard.count默认 10,若表中user_id超 1 亿个,建议设为 200,避免单个分片文件超 1GB(影响查询速度)。

总结

Hudi 二级索引的核心逻辑可概括为:

- 配置:先开记录索引,再用 SQL 创建,高吞吐场景加异步配置;

- 存储:藏在元数据表的

secondary_index分区,按索引名和哈希分片组织; - 自动构建:创建需手动触发,后续写入自动同步,大表用异步构建避免阻塞。

这套逻辑让电商、出行等场景的 “非主键查询” 从 “小时级” 降至 “秒级”,是 Hudi 湖仓架构中 “支持灵活查询” 的关键能力。

(欢迎关注,欢迎订阅 - 数据湖专栏 )