Xinference 算力推理平台选型分析与算力计算指南

Xinference 算力推理平台选型分析与算力计算指南

一、前言

在企业级 AI 应用落地过程中,推理平台的选择直接决定了系统性能、数据安全、成本效益和可扩展性。

对于制造业等对数据隐私、业务连续性要求极高的行业,理想的推理平台必须满足 本地化部署、开源可控、硬件兼容、推理性能高、弹性伸缩、行业适配、国际化支持 七大核心需求。

Xinference 正是为应对这些挑战而设计的新一代企业级 AI 推理平台,在制造业、金融、能源等关键行业已有成熟落地案例。

官网 https://xorbits.cn/

二、企业推理平台核心需求清单

| 序号 | 需求项 | 具体说明 | 为什么重要 |

|---|---|---|---|

| 1 | 本地化/私有化部署 | 所有数据与推理过程在企业自有基础设施内完成,不依赖公有云 | 保障数据安全与隐私,满足行业合规(如等保、工业信息安全) |

| 2 | 开源属性 | 基于开源框架构建,可自由修改与二次开发 | 避免厂商锁定,降低长期维护成本,提升技术可控性 |

| 3 | 硬件适配 | 深度支持国产 GPU(华为昇腾、寒武纪 MLU)+ 兼容 NVIDIA GPU | 应对供应链安全要求,降低对单一硬件生态依赖 |

| 4 | 推理性能 | 高并发、低延迟,优化问答类业务 | 保证用户体验,满足实时决策场景 |

| 5 | 伸缩能力 | 从单节点到大规模集群的平滑扩展 | 适应业务波动,提高资源利用率 |

| 6 | 行业适配 | 支持制造业术语理解、设备运维问答等 | 提升模型在垂直场景的可用性与准确性 |

| 7 | 国际化支持 | 多语言处理(含小语种)、跨区域部署 | 满足跨国企业业务需求,提升全球化竞争力 |

三、Xinference 平台简介

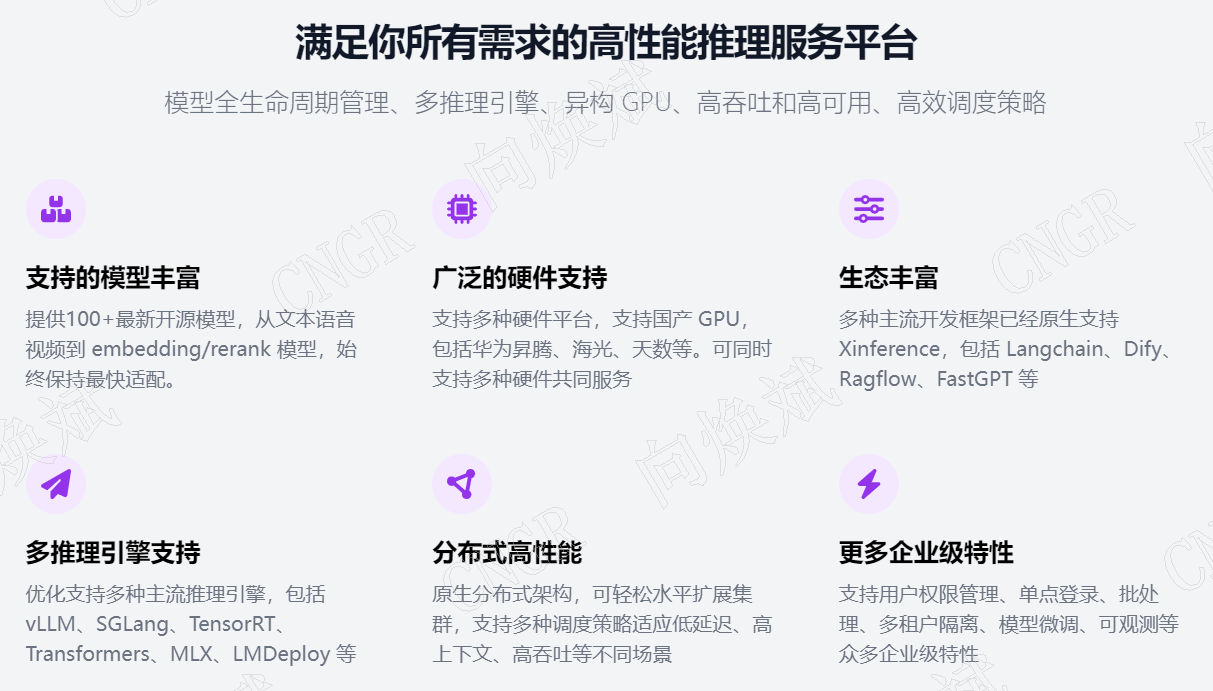

Xinference 是一个企业级开源推理平台,专注于提供高性能、低成本、可扩展的 AI 推理解决方案。其核心优势包括:

- 多框架支持:兼容 TensorFlow、PyTorch、ONNX、PaddlePaddle 等

- 多硬件调度:支持国产 GPU、NVIDIA GPU、CPU 混合部署

- 低延迟优化:动态批处理、算子融合、模型缓存

- 高可用架构:支持集群化部署与自动故障转移

- 灵活扩展:通过 API 与 SDK 轻松对接企业业务系统

四、需求匹配分析(Xinference 如何满足七大需求)

| 需求项 | Xinference 实现方式 | 优势说明 |

|---|---|---|

| 本地化/私有化部署 | 提供完整离线部署包,支持物理机、虚拟机、私有云环境 | 数据不出本地,满足制造业保密要求 |

| 开源属性 | 核心代码开源(Apache 2.0 许可),模块化架构 | 可自由定制与二次开发,避免供应商锁定 |

| 硬件适配 | 已完成华为昇腾、寒武纪 MLU、NVIDIA GPU 深度适配 | 支持异构计算,最大化资源利用率 |

| 推理性能 | 自研推理引擎优化高并发场景,延迟可低至毫秒级 | 特别适合智能问答、实时质检等场景 |

| 伸缩能力 | 支持 Kubernetes 编排,可动态扩缩容 | 业务高峰期自动扩容,低谷期释放资源 |

| 行业适配 | 预置制造业知识图谱接口,支持专业术语增强 | 可直接对接 MES、SCADA 等工业系统 |

| 国际化支持 | 内置多语言 NLP 模型,支持跨语言推理 | 满足跨国企业多语言客服、多区域部署需求 |

五、Xinference vs 其他推理平台对比

| 特性维度 | Xinference | TensorRT | vLLM | Ollama |

|---|---|---|---|---|

| 部署模式 | 支持私有化/本地化部署 | 需自行集成部署 | 需自行部署 | 单机部署为主 |

| 开源属性 | 开源(Apache 2.0) | 部分开源 | 开源(MIT) | 开源(MIT) |

| 硬件适配 | 国产 GPU + NVIDIA + CPU | 主要支持 NVIDIA | 主要支持 NVIDIA | 主要支持 NVIDIA/CPU |

| 推理性能 | 高(动态批处理+算子优化) | 极高(深度 GPU 优化) | 高(连续批处理) | 中等(面向单机) |

| 伸缩能力 | 强(K8s 集群化) | 弱(单节点优化) | 中(支持多卡) | 弱(单节点) |

| 行业适配 | 提供制造业等垂直场景插件 | 通用优化,无行业插件 | 通用优化 | 通用优化 |

| 国际化支持 | 多语言模型与跨语言推理 | 无内置多语言优化 | 需自行集成多语言模型 | 需自行集成 |

| 易用性 | 高(可视化管理 + SDK) | 低(需 CUDA 开发经验) | 中(命令行+API) | 高(简单 CLI) |

结论:

- 若企业需要国产硬件适配+本地化部署+行业定制,Xinference 是最佳选择。

- 若仅追求极致性能且硬件环境为 NVIDIA GPU,TensorRT 或 vLLM 更适合。

- Ollama 适合快速原型验证,但不适合大规模生产部署。

六、企业算力需求计算指南

很多企业在部署推理平台时不确定需要多少算力,下面提供一套实用的计算方法:

1. 明确业务指标

- 并发用户数(同时请求的用户量)

- 每秒请求数(QPS)

- 可接受延迟(如 500ms)

- 模型类型与大小

- 输入数据尺寸

2. 算力计算公式

所需算力 (FLOPS) = 模型复杂度 (FLOPs/请求) × QPS × 冗余系数(1.2~1.5)

所需显存 = 模型大小 × 批次大小 × 1.5(预留空间)

3. 制造业问答系统示例

假设条件:

- 模型:BERT-base(110M 参数,~180 GFLOPs/请求)

- 并发用户:500

- 每用户每分钟提问 5 次

- 延迟要求:< 500ms

计算过程:

- QPS = 500 × 5 ÷ 60 ≈ 41.7

- 所需算力 = 180 GFLOPs × 41.7 × 1.5 ≈ 11.3 TFLOPs

- 所需显存 = 400MB × 32 × 1.5 ≈ 19.2 GB

推荐配置:

- NVIDIA A100(40GB)单卡

- 或华为昇腾 910(32GB)单卡

- 或 2 × NVIDIA A6000(48GB)

七、总结与建议

Xinference 凭借本地化部署、开源可控、硬件兼容性强、高性能推理、弹性伸缩、行业适配、国际化支持七大优势,成为制造业等关键行业 AI 推理平台的首选。

建议:

- 制造业企业可优先考虑 Xinference 私有化部署方案

- 初期可采用单节点验证,随后扩展至集群

- 结合模型量化、蒸馏、缓存等技术进一步优化性能与成本