Decision Tree Model|决策树模型

-----------------------------------------------------------------------------------------------

这是我在我的网站中截取的文章,有更多的文章欢迎来访问我自己的博客网站rn.berlinlian.cn,这里还有很多有关计算机的知识,欢迎进行留言或者来我的网站进行留言!!!

-----------------------------------------------------------------------------------------------

一、决策树模型的定义

决策树模型是一种经典的机器学习算法,它通过一系列的条件判断来对数据进行分类或回归预测。通俗来说,决策树模型就像是一张“问题树”,从根节点开始,通过回答一系列简单的问题,逐步向下分支,最终到达叶节点得出结论。

通俗理解:

判断一个人是否会喜欢某部电影,决策树可能会先问“这部电影是喜剧片吗?”“这部电影的导演是谁?”等问题,根据回答逐步缩小范围,最终得出结论。

二、决策树分类流程图

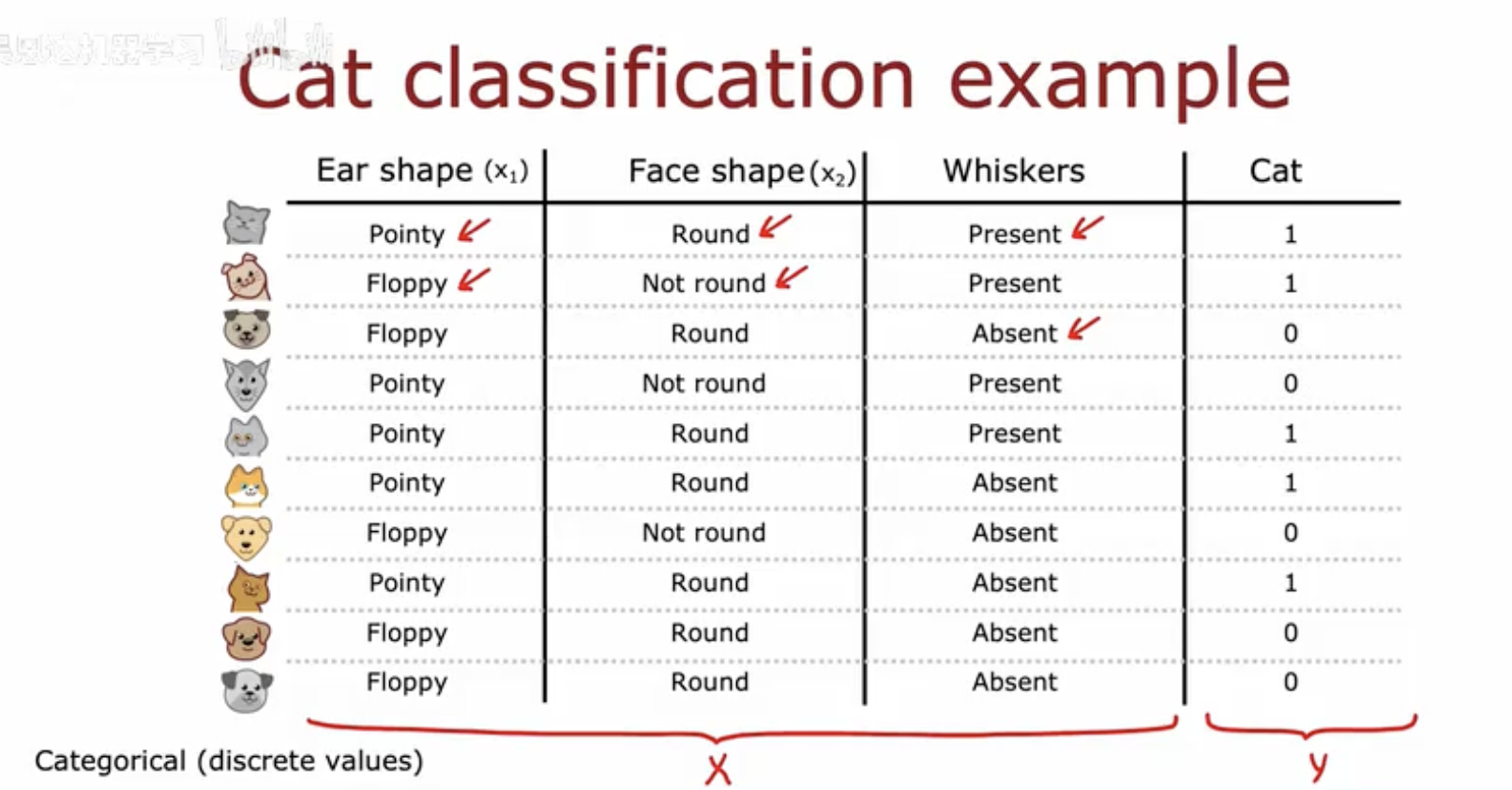

猫分类数据集示例

这幅图片展示了一个猫分类的例子,使用决策树模型进行分类。图片中包含一个表格,表格有四列:耳形(x1)、脸型(x2)、胡须(x3)和猫(y)。

-

耳形(x1):分为“尖尖的(Pointy)”和“下垂的(Floppy)”两种类型。

-

脸型(x2):分为“圆形(Round)”和“非圆形(Not round)”两种类型。

-

胡须(x3):分为“有(Present)”和“无(Absent)”两种类型。

-

猫(y):是分类的目标变量,取值为0或1,代表是否为猫。

表格中列出了不同特征组合的实例,以及它们对应的分类结果(是否为猫)。例如,第一行显示一个耳形为“尖尖的”,脸型为“圆形”,胡须“有”的实例被分类为猫(y=1)。

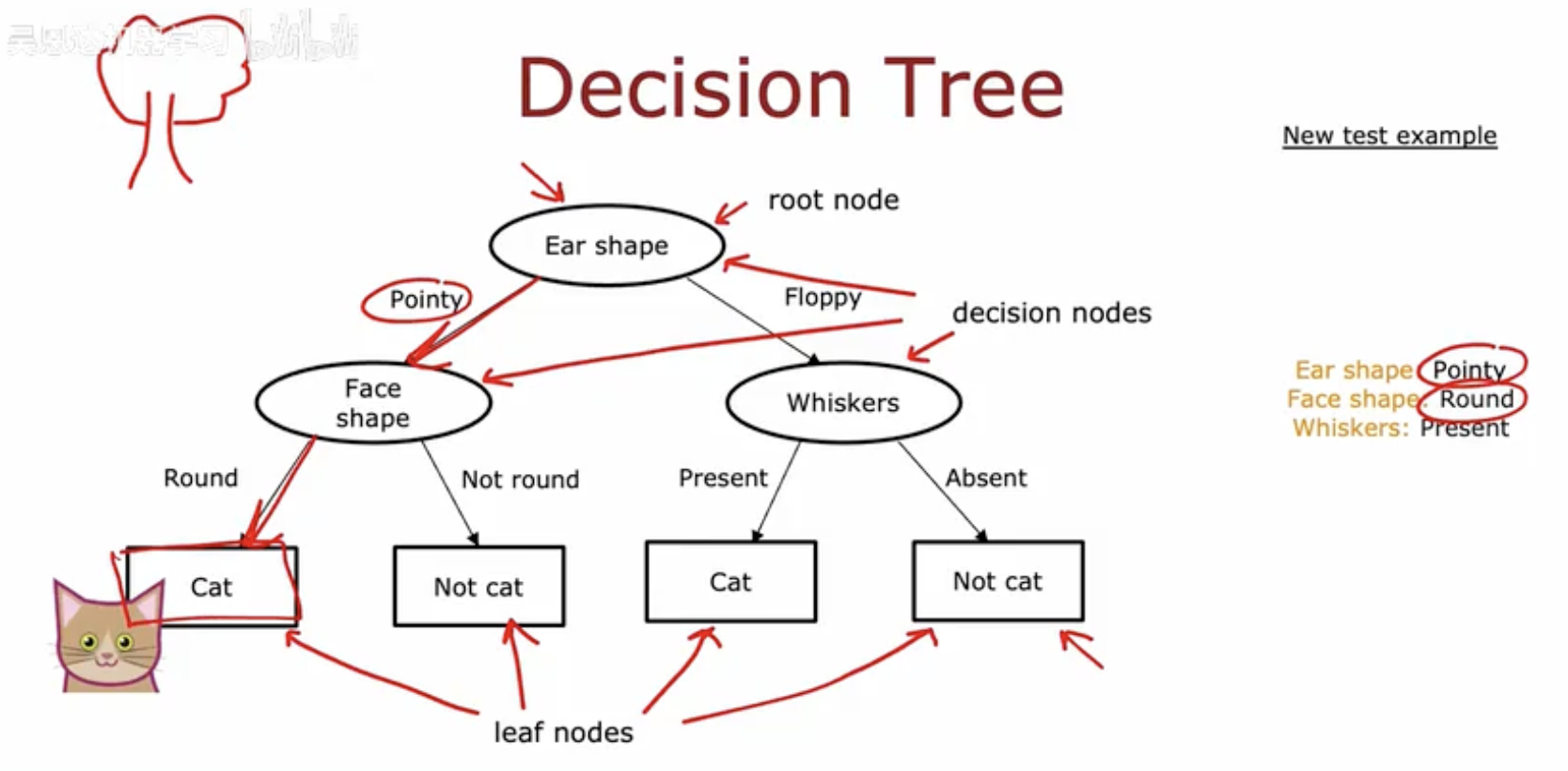

这幅图详细展示了一个决策树的结构和如何使用它来分类一个新的测试实例。

-

根节点(Root Node):

-

决策树从根节点开始,这里是“耳形(Ear shape)”。

-

根节点是决策树的起点,它根据一个特征(这里是耳形)来分裂数据。

-

-

决策节点(Decision Nodes):

-

从根节点分出两个分支,分别对应“尖尖的(Pointy)”和“下垂的(Floppy)”耳形。

-

决策节点根据特定的特征值来决定数据应该沿着哪条路径继续。

-

-

内部节点(Internal Nodes):

-

在“尖尖的(Pointy)”分支下,进一步根据“脸型(Face shape)”来分裂,分为“圆形(Round)”和“非圆形(Not round)”。

-

在“下垂的(Floppy)”分支下,直接根据“胡须(Whiskers)”来分裂,分为“有(Present)”和“无(Absent)”。

-

-

叶节点(Leaf Nodes):

-

叶节点是决策树的终点,它们不进行进一步的分裂,而是给出最终的分类结果。

-

在这个例子中,叶节点的分类结果是“猫(Cat)”或“非猫(Not cat)”。

-

-

新测试实例(New Test Example):

-

图中右侧标注了一个新的测试实例,其特征为“耳形:尖尖的,脸型:圆形,胡须:有”。

-

这个实例将被用来通过决策树进行分类。

-

-

分类路径(Classification Path):

-

根据新测试实例的特征,从根节点开始,沿着决策树的分支向下,直到到达叶节点。

-

对于这个实例,路径是:耳形(尖尖的)→ 脸型(圆形)→ 胡须(有),最终到达叶节点“猫(Cat)”。

-

因此,根据决策树的规则,这个新测试实例被分类为“猫”。

-

这幅图清晰地展示了决策树如何通过一系列的决策节点来对数据进行分类,以及如何应用这个模型来预测新实例的类别。

三、多样化决策树模型比较

图片内容整理

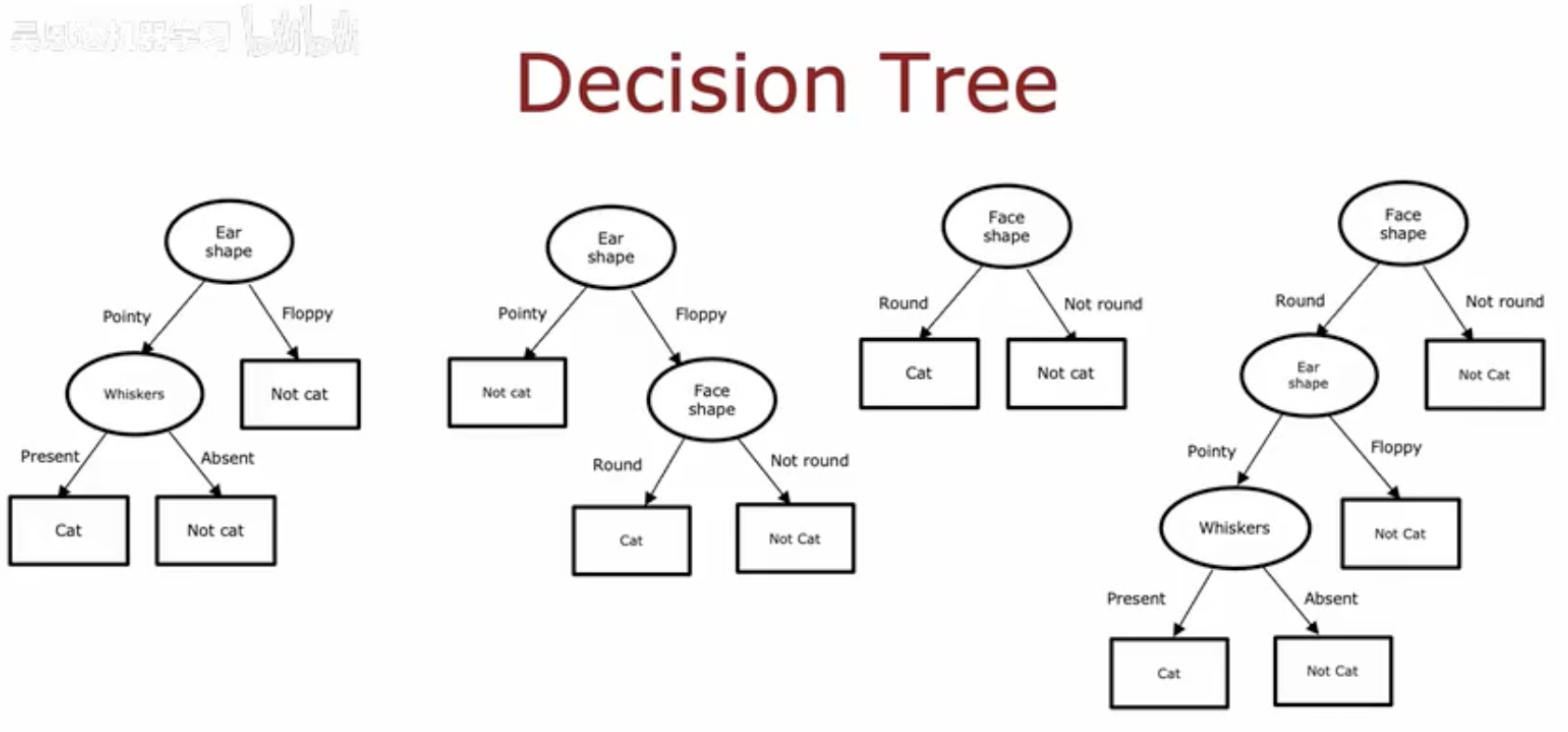

这幅图片展示了四种不同的决策树结构,它们都使用相同的特征集(耳形、脸型和胡须)来对猫进行分类。每个决策树的结构如下:

-

第一个决策树:

-

根节点:耳形(Ear shape)

-

分支:尖尖的(Pointy)和下垂的(Floppy)

-

尖尖的耳形进一步根据胡须(Whiskers)分为有(Present)和无(Absent)

-

分类结果:有胡须为猫(Cat),无胡须为非猫(Not cat)

-

下垂的耳形直接分类为非猫(Not cat)

-

-

第二个决策树:

-

根节点:耳形(Ear shape)

-

分支:尖尖的(Pointy)和下垂的(Floppy)

-

尖尖的耳形直接分类为非猫(Not cat)

-

下垂的耳形根据脸型(Face shape)分为圆形(Round)和非圆形(Not round)

-

分类结果:圆形为猫(Cat),非圆形为非猫(Not cat)

-

-

第三个决策树:

-

根节点:脸型(Face shape)

-

分支:圆形(Round)和非圆形(Not round)

-

圆形脸型直接分类为猫(Cat)

-

非圆形脸型根据耳形(Ear shape)分为尖尖的(Pointy)和下垂的(Floppy)

-

分类结果:尖尖的为猫(Cat),下垂的为非猫(Not cat)

-

-

第四个决策树:

-

根节点:脸型(Face shape)

-

分支:圆形(Round)和非圆形(Not round)

-

圆形脸型根据耳形(Ear shape)分为尖尖的(Pointy)和下垂的(Floppy)

-

分类结果:尖尖的为猫(Cat),下垂的为非猫(Not cat)

-

非圆形脸型直接分类为非猫(Not cat)

-

为什么会出现各种决策树

出现各种决策树的原因包括:

-

数据的不同划分:在构建决策树时,可能会根据数据的不同划分方式来选择不同的特征作为根节点或决策节点。

-

特征的重要性:不同的特征可能对分类结果的影响不同,决策树可能会根据特征的重要性来选择分裂点。

-

随机性:在某些决策树算法中,如随机森林,会引入随机性来生成不同的决策树。

-

过拟合与欠拟合:决策树的深度和复杂度会影响其对训练数据的拟合程度。

哪个决策树更好

至于哪个决策树更好,这取决于几个因素:

-

准确率:在训练集和测试集上分类准确率更高的决策树通常被认为是更好的。

-

泛化能力:能够更好地泛化到未见过的数据的决策树是更优的选择。

-

解释性:在某些情况下,决策树的解释性也很重要,更简单的树可能更容易解释。

通常,单一决策树可能会受到数据噪声和异常值的影响,导致过拟合。因此,实践中可能会使用集成学习方法(如随机森林、梯度提升树等),结合多个决策树的预测结果,以提高模型的稳定性和准确性。

-----------------------------------------------------------------------------------------------

这是我在我的网站中截取的文章,有更多的文章欢迎来访问我自己的博客网站rn.berlinlian.cn,这里还有很多有关计算机的知识,欢迎进行留言或者来我的网站进行留言!!!

-----------------------------------------------------------------------------------------------