人工智能学习:什么是NLP自然语言处理

一、什么是自然语言处理

自然语言处理(Natural Language Processing, 简称NLP)是计算机科学与语言学中关注于计算机与人类语言间转换的领域,主要目标是让机器能够理解和生成自然语言,这样人们可以通过语言与计算机进行更自然的互动。

对于自然语言来说,处理的数据主要就是人类的语言,例如:汉语、英语、法语等,该类型的数据不像我们前面接触过的结构化数据、或者图像数据可以很方便的进行数值化。

自然语言处理的主要任务包括:

语音识别:将语音信号转化为文本

文本分析:从文本中提取有意义的信息,包括情感分析、主题提取等

机器翻译:自动将一种语言的文本翻译为另一种语言

语法分析:分析句子的语法结构,识别句子中的各个成分(如主语、谓语、宾语等)

命名实体识别(NER):识别文本中的重要实体,如人名、地点名、组织名等

对话系统:使计算机能够与人类进行自然流畅的对话,如智能助手、聊天机器人等

自动摘要:从大量文本中提取出最关键信息并生成简洁的摘要

二、自然语言处理的发展简史

早期(1950s-1960s)

NLP的起源可以追溯到20世纪50年代。当时,计算机还处于非常初期的发展阶段,但人们已经开始探索如何让计算机理解和生成自然语言

- 1950年代:

- 艾伦·图灵(Alan Turing)提出了“图灵测试”,即通过对话测试机器是否能表现得像人类一样智能。这为后来的自然语言处理研究奠定了哲学基础。

- 1954年:

- 第一个机器翻译系统——IBM的自动翻译系统(如英法翻译)出现。它基于规则,并且采用词汇替换的方法。

- 1960年代:

- 计算机科学家开始研究更复杂的语言理解问题,如句法分析和语法规则的形式化。

- 乔治·拉科夫和诺姆·乔姆斯基提出了生成语法理论,后来成为计算语言学的重要基础。

- 1950年代:

规则基础的时代(1970s-1980s)

这一时期的自然语言处理依赖于手工设计的规则,主要关注语言的语法结构和句法分析

- 1970年代:

- 自然语言处理的研究开始关注如何将句子分解为成分,并分析这些成分之间的关系(句法分析)。

- 人们发展出了一些基于规则的语法框架,例如上下文无关语法(CFG)。

- 1980年代:

- 专家系统和知识表示成为计算机语言理解的重点。许多早期的应用系统使用知识库和推理规则来模拟专家的决策过程。

- 1970年代:

统计方法的兴起(1990s)

90年代初,统计方法的引入为NLP带来了革命性的变化,尤其是随着机器学习的应用,NLP从规则驱动转向数据驱动的方法

- 1990年代:

- 隐马尔可夫模型(HMM)、最大熵模型、条件随机场(CRF)等统计方法逐渐成为主流,机器学习方法开始用于语音识别、词性标注、命名实体识别等任务。

- 1990年,IBM的Candide项目推出了统计机器翻译系统,标志着机器翻译的统计方法时代的到来。

- 1997年:

- Google首次提出基于大规模数据和概率模型的自然语言处理方法,开启了基于数据学习的新时代。

- 1990年代:

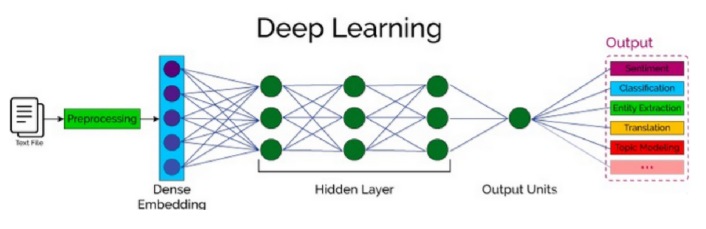

深度学习和神经网络时代(2010s-至今)

2010年代以来,深度学习技术的快速发展为NLP带来了前所未有的突破。深度神经网络(尤其是卷积神经网络(CNN)和循环神经网络(RNN))成为自然语言处理的核心技术

- 2013年:

- Word2Vec模型由Google的研究团队提出,用于将词汇映射到低维向量空间中,显著提高了语义相似性建模的效果。

- 2014年:

- 深度学习和神经网络开始广泛应用于NLP,尤其是递归神经网络(RNN)和长短期记忆网络(LSTM)在文本生成和机器翻译任务中的广泛应用。

- 2018年:

- BERT(Bidirectional Encoder Representations from Transformers)由Google推出,彻底改变了NLP领域。BERT采用了Transformer架构,能够进行双向上下文建模,在多个NLP任务中实现了当时最先进的性能。

- 2020年以后:

- 随着GPT-3(由OpenAI发布)等大规模预训练语言模型的问世,NLP的能力大幅提升。GPT-3凭借其1750亿个参数,能够生成高质量的文本,翻译、写作、对话等任务都能得到很好的解决。

- 2013年:

当前与未来发展(2020s以后)

- 大规模语言模型:如GPT系列、BERT系列、T5、PaLM等,已经在文本生成、自动摘要、智能对话等任务上达到了接近人类的水平。

- 多模态学习:越来越多的研究开始结合NLP和视觉、语音等其他模态,推动跨模态理解的研究。

- 低资源语言处理:如何让机器理解低资源语言(例如少数民族语言、方言等)仍然是NLP的一个重要挑战。

- 伦理和偏见问题:随着模型越来越强大,NLP研究者也在关注模型的伦理性、透明性、公平性以及减少偏见的挑战。

三、自然语言处理的应用场景

搜索与信息检索:

- 搜索引擎:NLP技术是现代搜索引擎的核心。它帮助理解用户查询的意图,并返回最相关的搜索结果

- 企业搜索:在企业内部的文档、数据库中进行信息检索,提高工作效率

- 学术搜索:在学术文献库中进行搜索,帮助研究人员查找相关论文

机器翻译:

- 跨语言交流:帮助不同语言的人们进行交流,例如 Google Translate 等翻译工具

- 文档翻译:将文档从一种语言翻译成另一种语言,用于商业、法律、科技等领域

- 网站翻译:实时翻译网页内容,方便用户浏览不同语言的网站

聊天机器人与虚拟助手:

- 客户服务:自动化处理客户咨询,提供 24/7 的在线服务,降低人力成本

- 智能助手:如 Siri、Alexa、Google Assistant 等,帮助用户完成各种任务,例如设置提醒、播放音乐、查询信息等

- 医疗助手:提供健康咨询、预约挂号等服务,方便患者就医

语音识别与语音合成:

- 语音识别:将语音转换为文本,用于:

- 语音输入:通过语音输入文本

- 语音搜索:通过语音进行搜索

- 语音控制:通过语音控制设备

- 语音合成:将文本转换为语音,用于:

- 语音助手:将信息通过语音输出

- 有声读物:将文本转换为有声读物

- 语音导航:提供语音导航

- 语音识别:将语音转换为文本,用于:

内容生成:

- 文本摘要:自动生成长文本的摘要

- 文章生成:自动撰写文章

- 代码生成:根据自然语言描述生成代码