谷歌引入开源全栈 AI 代理栈:借助 Gemini 2.5 和 LangGraph 实现多步网络搜索、反思与综合

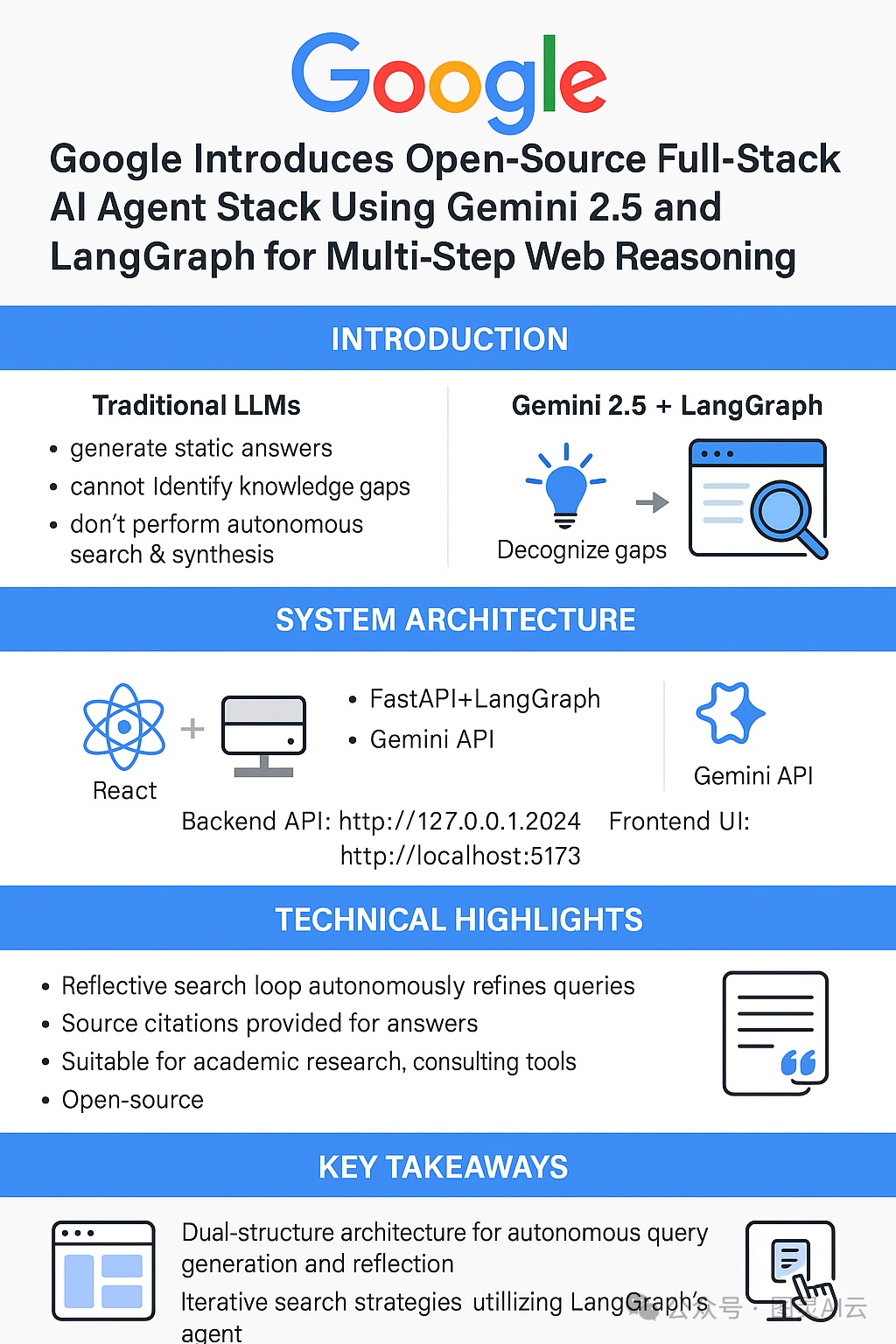

对话式 AI 已迅速从基础聊天机器人框架中发展起来。然而,大多数大型语言模型(LLM)仍存在一个关键限制——它们仅依据静态训练数据生成回复,缺乏自我识别知识空白或执行实时信息综合的能力。因此,这些模型常常给出不完整或过时的答案,尤其在涉及不断演变或小众话题时。

为解决这些问题,AI 代理必须超越被动查询。它们需要识别信息空白,执行自主网络搜索,验证结果,并完善回复——有效模仿人类研究助手的工作方式。

谷歌 与来自 Hugging Face 及其他开源社区的贡献者合作,开发了一款旨在解决该问题的全栈研究代理栈。该系统采用React 前端和FastAPI + LangGraph 后端构建,将语言生成与智能控制流及动态网络搜索相结合。

研究代理栈利用Gemini 2.5 API处理用户查询,生成结构化搜索词。随后,它通过谷歌搜索 API执行递归搜索 - 反思循环,验证每个结果是否充分回答了原始查询。这一迭代过程持续进行,直至代理生成经过验证、来源可靠的回复。

架构概览:开发者友好且可扩展

• 前端 :采用Vite + React构建,提供热重载和清晰的模块分离。

• 后端 :由Python(3.8 +)、FastAPI 和 LangGraph 驱动,实现决策控制、评估循环和自主查询优化。

• 关键目录 :代理逻辑位于

backend/src/agent/graph.py,而 UI 组件则在frontend/下进行结构化组织。• 本地设置 :需要 Node.js、Python 和 Gemini API 密钥。通过

make dev运行,或分别启动前端 / 后端。• 端点 :

• 后端 API:

http://127.0.0.1:2024• 前端 UI:

http://localhost:5173

这种分离关注点的设计确保开发者可轻松修改代理行为或 UI 展示,使该项目适合全球研究团队和技术开发者。

技术亮点与性能

• 反思循环 :LangGraph 代理评估搜索结果,识别覆盖空白,自主优化查询,无需人工干预。

• 延迟回复综合 :AI 在收集足够信息前暂不生成答案。

• 来源引用 :答案中嵌入原始来源的超链接,提升可信度和可追溯性。

• 用例 :适用于对准确性和验证性要求较高的学术研究、企业知识库、技术支持机器人和咨询工具。

为何重要:迈向自主网络研究的一步

该系统展示了如何将自主推理和搜索综合直接整合到 LLM 工作流程中。代理不仅响应请求,还会调查、验证和适应。这反映了 AI 开发的一个更广泛转变:从无状态问答机器人到实时推理代理。

该项目使北美、欧洲、印度和东南亚等地区的开发者、研究人员和企业能够以最少的设置部署 AI 研究助手。借助 FastAPI、React 和 Gemini API 等全球可访问工具,该项目有望得到广泛应用。

结论

通过结合谷歌的 Gemini 2.5 与 LangGraph 的逻辑编排,该项目在自主 AI 推理领域取得突破。它展示了如何在不牺牲准确性和可追溯性的情况下自动化研究工作流程。随着对话式代理的不断发展,像这样的系统为智能、可信且开发者友好的 AI 研究工具树立了标杆。

详见:

1. https://github.com/google-gemini/gemini-fullstack-langgraph-quickstart