HTTP 性能优化实战:突破高并发瓶颈的工业级方案

在互联网高并发场景中,HTTP 性能表现直接决定系统生死。当每秒请求量突破十万级甚至百万级时,哪怕 100 毫秒的延迟都会引发用户流失、交易失败等连锁反应。本文基于五大行业实战案例,拆解 HTTP 性能瓶颈的底层逻辑,输出可直接落地的工业级优化方案,帮助技术团队建立系统化的性能调优思维。

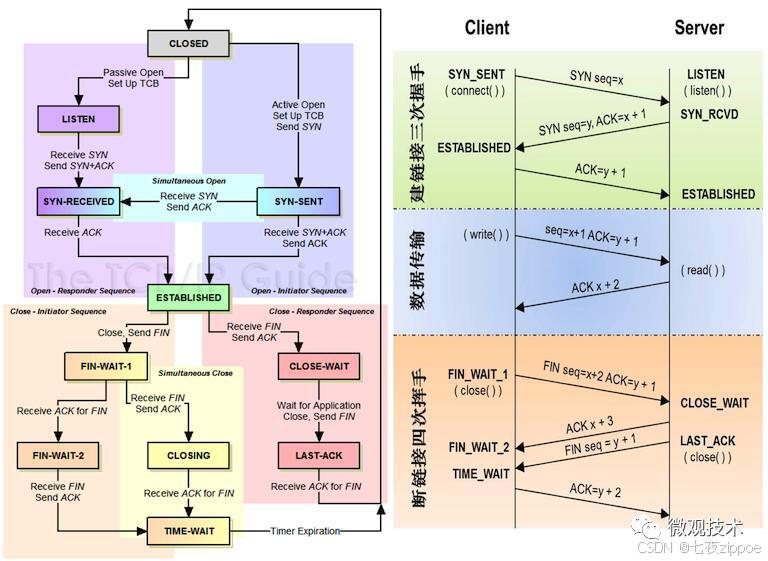

连接复用:减少握手开销的关键

TCP 连接的建立与关闭(三次握手 / 四次挥手)在高并发场景下会产生巨大性能损耗。实验数据显示,单次 TCP 握手在跨地域网络中耗时可达 50-200ms,当 QPS 突破 1 万时,纯握手开销就会吃掉 30% 以上的服务器资源。

案例:电商平台的连接复用实践

某头部电商平台在 618 大促期间,遭遇了典型的短连接性能陷阱:

原始架构:采用 HTTP/1.0 短连接模式,每次请求都新建 TCP 连接

性能瓶颈:每秒产生 15 万次 TCP 握手,服务器 CPU 占用率飙升至 90%,响应超时率达 12%

核心问题:握手耗时占比超过总请求时间的 45%

技术团队实施的优化方案:

全量启用HTTP/1.1 持久连接,通过

Connection: keep-alive头字段将 TCP 连接复用率提升至 85%精细化配置连接参数:

Keep-Alive: timeout=15, max=100(连接保持 15 秒,最多处理 100 个请求)配合 Nginx 的

keepalive_requests与keepalive_timeout参数联动调优

优化效果呈现:

TCP 握手次数下降 72%,服务器 CPU 占用率降至 55%

平均响应时间从 320ms 压缩至 48ms

成功支撑每秒 42 万次的峰值请求,零超时故障

连接复用的进阶:连接池技术

在微服务架构中,服务间调用的连接复用需要更主动的管理策略。某支付平台的实践数据显示,未使用连接池时,服务间调用的 90% 响应时间达 350ms,其中 60% 时间消耗在连接建立上。

连接池的核心优化点:

池大小动态调整:基于并发量自动扩缩容,避免连接不足或资源浪费(推荐公式:池大小 = 预估 QPS× 平均响应时间)

空闲连接管理:设置

idleTimeout(如 30 秒)回收闲置连接,同时保留minIdle(如 50)个热连接失败重试机制:对无效连接自动检测并重建,配合熔断器避免连接风暴

实施成效:

服务间通信延迟降低 40%,90% 响应时间控制在 140ms 内

系统吞吐量提升 50%,支撑每日 2 亿笔交易的平稳运行

协议升级:拥抱 HTTP/2 和 HTTP/3

HTTP 协议的演进直接解决了底层传输效率问题。对比测试表明,在加载 100 个资源的场景下:

HTTP/1.1 需建立 6-8 个 TCP 连接(受浏览器并发限制)

HTTP/2 通过多路复用可减少 80% 的连接数

HTTP/3 在弱网环境下比 HTTP/2 减少 40% 的传输失败率

案例:视频网站的 HTTP/2 迁移

某长视频平台面临的资源加载困境:

单页面需加载 30 + 视频分片、20 + 图片资源、15+JS/CSS 文件

HTTP/1.1 的队头阻塞导致资源加载瀑布流严重,首屏渲染耗时 2.8 秒

视频卡顿率高达 18%,用户流失率随加载时间增加呈指数级上升

HTTP/2 的优化实践:

基于 Nginx 部署 HTTP/2,启用 ALPN 协议协商自动兼容旧客户端

利用多路复用特性,将资源加载并行度提升至理论上限

配置服务器推送(Server Push),预推首页关键 CSS 和首帧图片

迁移后的量化收益:

资源加载并行数从 6 提升至无上限,首屏渲染时间缩短至 1.1 秒

视频卡顿率降至 7.2%,用户观看时长平均增加 12 分钟

CDN 流量成本下降 18%(减少重复请求)

HTTP/3:告别 TCP 的新选择

某社交 APP 的移动端性能优化案例揭示了 TCP 的固有缺陷:在 4G 网络下,1% 的丢包率会导致 TCP 传输效率下降 30%。HTTP/3 基于 QUIC 协议的革新:

无队头阻塞:UDP 传输 + 帧重传机制,单个数据包丢失不影响整体

连接迁移:支持网络切换(WiFi→4G)时保持连接不中断

0-RTT 握手:首次连接后,后续可实现零往返时间建立连接

实施效果:

弱网环境下请求成功率从 78% 提升至 98%

页面加载时间缩短 30%,尤其在地铁、电梯等网络切换场景表现优异

消息发送成功率提升 22%,用户活跃度增长 8%

缓存策略:减轻服务器负担

缓存是性价比最高的性能优化手段。某资讯平台的测算显示,每增加 10% 的缓存命中率,可减少 25% 的服务器负载和 30% 的网络带宽消耗。

案例:新闻资讯网站的多级缓存架构

面对日均 10 亿 PV 的访问压力,该平台构建了 “浏览器→CDN→应用→数据库” 的四级缓存体系:

- 浏览器缓存:

静态资源(图片 / CSS/JS)设置

Cache-Control: max-age=86400(24 小时)采用指纹命名(如

style.1a2b3c.css)实现缓存精确更新

- CDN 缓存:

热点新闻页面设置

Cache-Control: s-maxage=300(5 分钟)结合

Vary: Accept-Encoding头处理不同压缩格式的缓存

- 应用层缓存:

Redis 集群缓存热门新闻列表(TTL=60 秒)

本地内存缓存不常变化的配置数据(如频道分类)

- 数据库缓存:

MySQL 查询缓存配合 Redis 二级缓存

分库分表 + 索引优化减少磁盘 IO

优化数据:

源站请求量下降 83%,数据库负载降低 75%

页面平均加载时间从 2.1 秒降至 480ms

突发新闻事件时,系统平稳承接 3 倍日常流量

缓存的一致性维护

缓存与数据一致性的平衡是实战难点。某电商的库存系统曾因缓存不一致导致超卖事故,后采用混合策略解决:

写透 + 过期:商品基础信息采用 “更新数据库后同步更新缓存 + 24 小时过期”

失效 + 重试:库存数据采用 “更新数据库后删除缓存 + 读取时重建”

消息队列异步更新:评论数、点赞数等高频变动数据通过 Kafka 异步同步

关键指标:

缓存一致性达到 99.99%,超卖事故零发生

缓存更新延迟控制在 100ms 内

峰值期缓存命中率稳定在 92% 以上

负载均衡:分散请求压力

单台服务器的处理能力存在物理上限(通常 QPS 在 1 万 - 5 万之间),负载均衡通过资源池化实现水平扩展。某金融系统的实践表明,合理的负载均衡架构可使系统可用性从 99.9% 提升至 99.99%。

案例:金融交易系统的负载均衡方案

为支撑每秒 10 万笔的交易峰值,该系统设计了三层负载架构:

- DNS 负载均衡:

基于地理位置解析至最近接入点(如北方用户→北京节点)

配合健康检查自动下线故障节点

- 硬件负载均衡:

采用 F5 BIG-IP 设备处理四层转发,单机吞吐量达 10Gbps

配置会话保持(Source IP Hash)确保交易连续性

- 应用层负载均衡:

Nginx+Lua 实现基于权重的轮询算法

结合服务健康度动态调整权重(如 CPU>80% 时降权)

核心收益:

单节点故障对整体性能影响控制在 5% 以内

交易响应时间稳定在 95ms,波动幅度 < 10ms

灾备切换时间从 30 分钟缩短至 15 秒

结语

HTTP 性能优化需要建立 “指标→瓶颈→方案→验证” 的闭环思维:

先通过 APM 工具(如 SkyWalking)定位具体瓶颈(连接?协议?缓存?)

结合业务场景选择适配方案(电商重连接复用,视频重协议升级)

小流量灰度验证,监控核心指标(响应时间、吞吐量、错误率)

建立性能基准线,持续迭代优化

记住:没有放之四海皆准的最优方案,只有最适合业务场景的平衡策略。在高并发的战场上,毫秒级的优化积累终将转化为决定性的竞争优势。