玩机日记 12 在PVE Windows11上部署本地AI模型,使用群晖反代https转发到外网提供服务,配合沉浸式翻译插件翻译网页

1、Windows11部署LM Stuido

LM Studio - Discover, download, and run local LLMs

安装好之后打开,点击右下角齿轮修改语言为简体中文

搜索下载想要部署的模型,比如deepseek r1 14b,因为我稍后要配置翻译服务,所以我选择下载了qwen 2.5 14b(有12g显存就部署14b模型,如果是8g显存就部署8b或者7b模型)

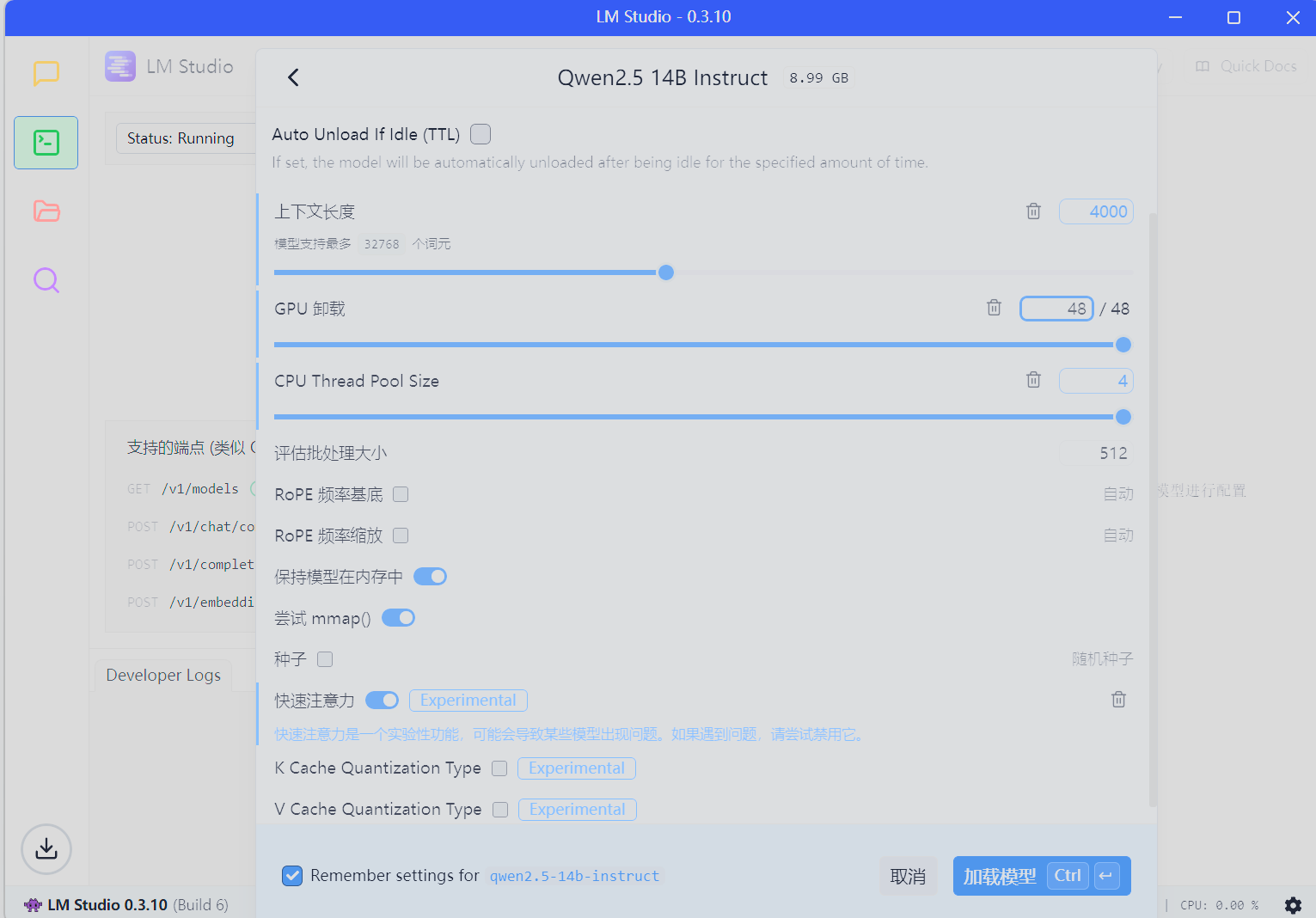

选择要加载的模型,手动选择加载参数

gpu和cpu拉满,快速注意力也可以打开,点击加载模型

配置一下api接口,这些选项建议都打开

模型启动之后就可以跟它聊天了,可以看到聊天时gpu几乎满载了,显存也几乎满了

2、群晖配置反向代理,使用ssl进行加密

之前我们已经配置了主路由的端口转发,把所有1024-65535的端口都转给群晖(或者dmz主机)

玩机日记9 PVE安装黑群晖-CSDN博客

接下来只要把群晖的1234端口转给Windows11,就可以从外网访问api了,转发顺序就是主路由--->群晖--->Windows11

配置反向代理服务器

主机名就填Windows11的IP

转到自定义标题,添加WebSocket,点击保存

3、配置沉浸式反应插件

安装插件

打开LM Stuido,复制模型名称

进入插件配置,翻译服务,添加OpenAI兼容服务

api就输入 https://你的.域名:1234/v1/chat/completions

模型选择设置更多模型,填入刚才复制的模型名称

选择刚刚添加到模型,点击测试服务

显示验证成功

退回到翻译服务,启用我们刚刚配置的服务,并设为默认

4、测试翻译

电脑测试可以成功翻译

手机浏览器如果用edge或者雨见浏览器等配置了沉浸式翻译,也是可以用的