XXL-JOB——源码分析解读(1)

摘要

本文深入分析了XXL-JOB框架的设计思考与优化设计,探讨了其不使用Lombok的@Data注解的原因,包括明确控制代码结构、避免依赖侵入、增强可维护性和调试便利性、保持编译清晰以及遵循项目历史和团队编码规范。文章还详细介绍了XXL-JOB的优化设计,包括数据库优化、执行优化、服务启动类以及执行器原理等内容,旨在提升框架的性能、可维护性和兼容性。同时,文章还讨论了XXL-JOB在真实项目部署中的数据库部署模式、并发能力以及任务状态类型等关键问题。

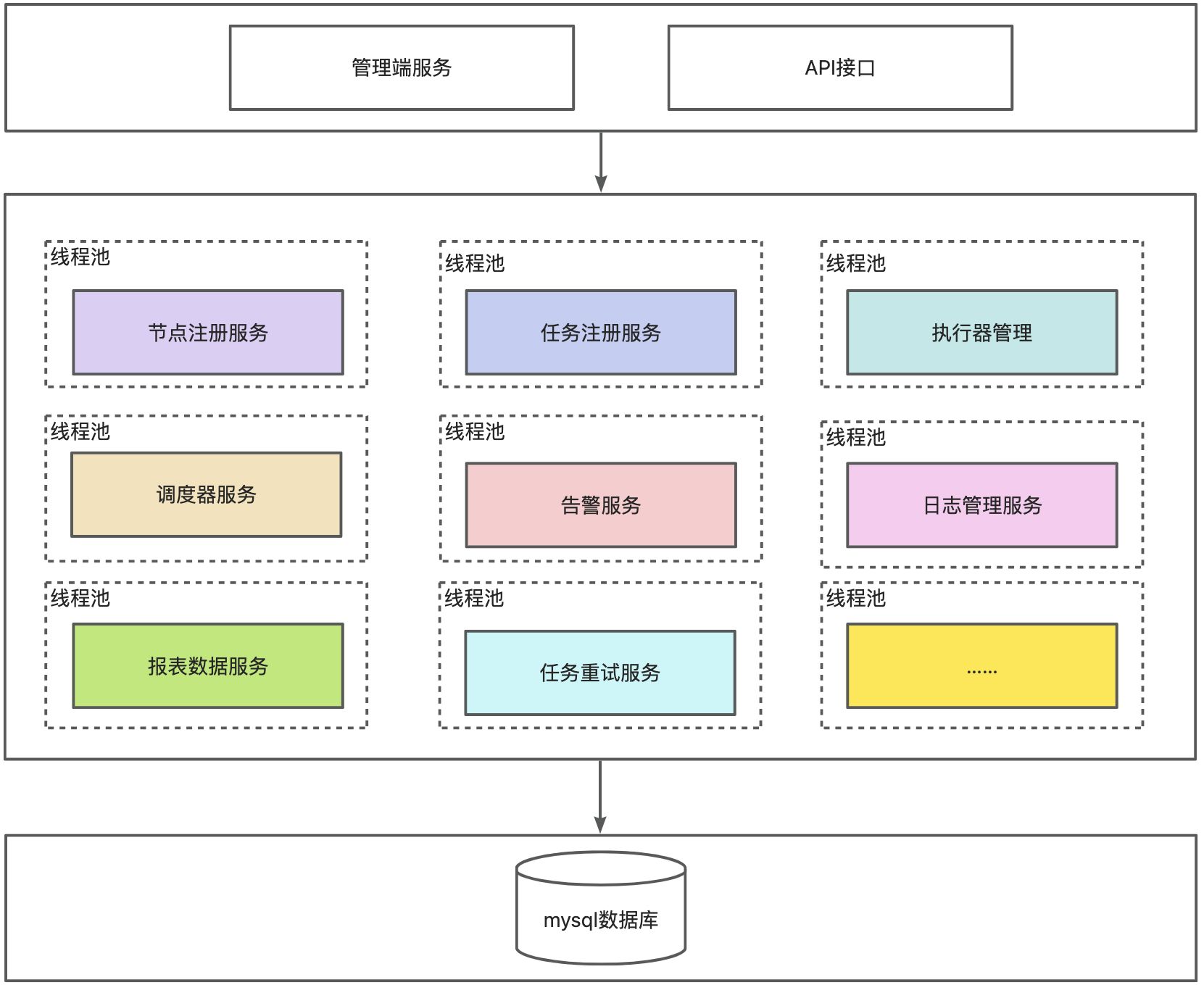

1. XXL-JOB 功能架构设计

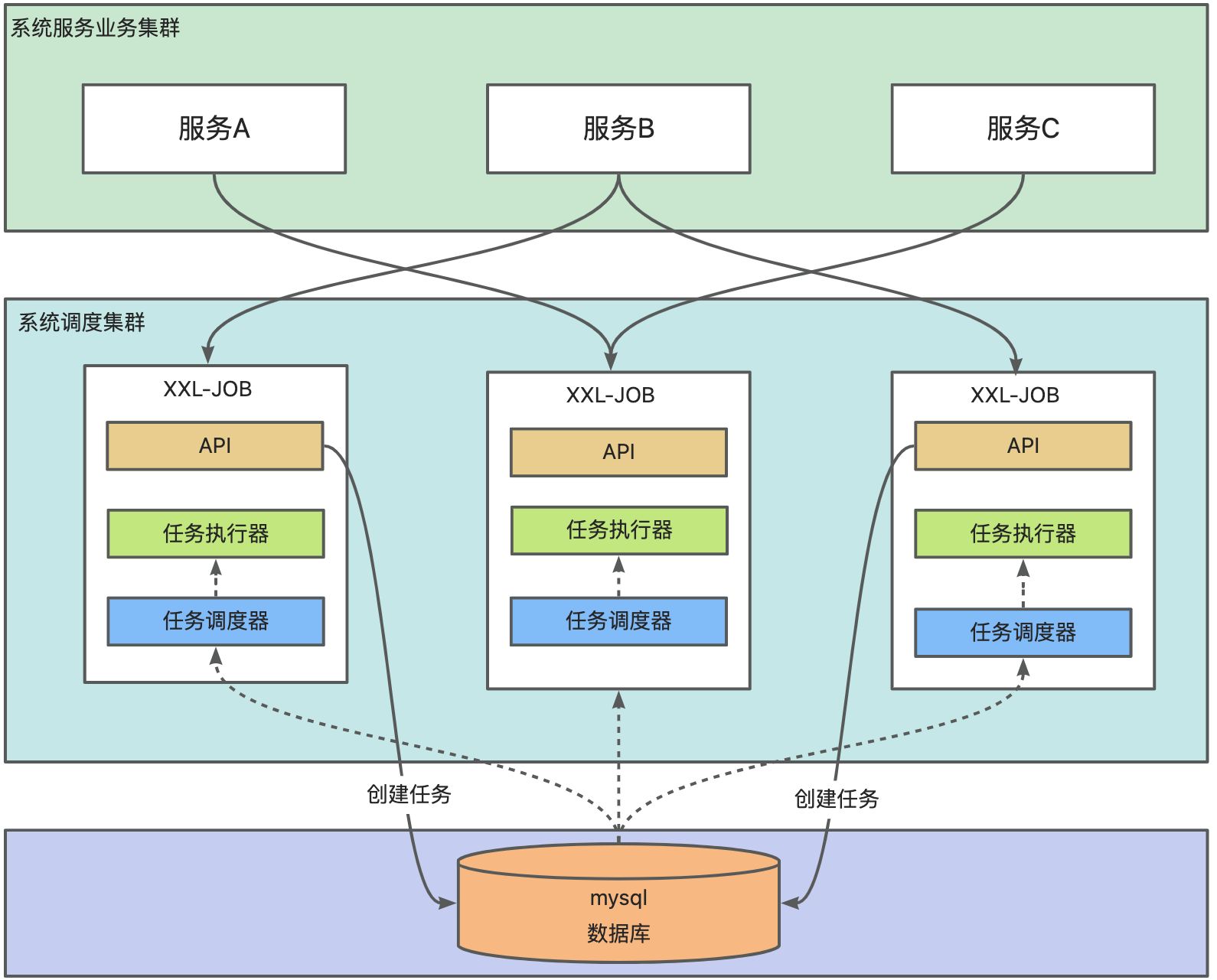

2. xxl-job 真实项部署数据库是单节点还是的主从模式或者集群模式?

在真实生产环境中,XXL-JOB 调度中心的数据库部署可以根据业务规模和可靠性需求选择不同模式,下面是几种常见部署方式对比和推荐:

2.1. ✅ 单节点数据库部署(常见于中小型系统)

特点:

- 使用单个 MySQL 实例(如 RDS、裸机、Docker等)。

- 配合调度中心的分布式部署(多个 admin 节点 + 多个执行器节点),数据库保持唯一。

优点:架构简单、部署成本低。

缺点:数据库单点风险。

👉 这种方式已经能满足绝大多数中小型企业调度需求。

2.2. ✅ 主从(读写分离)部署

特点:

- 使用 MySQL 主从架构。

- XXL-JOB 调度中心所有写操作(如任务注册、日志写入)走主库。

- 若自己改造代码,部分读操作可以配置读库(需自己分库读写)。

优点:减轻主库压力、提高查询性能。

缺点:需要自行维护读写分离逻辑(原生 XXL-JOB 不支持自动分库分表)。

2.3. ✅ 主主复制 / 高可用集群

特点:

- 通过 MySQL + MGR(Group Replication)、TiDB、PolarDB 等实现强一致 + 高可用。

- 保证数据库层面的故障自动切换。

优点:强一致、高可用、无主点。

缺点:架构复杂、成本较高。

2.4. ⚠️ 需要注意:

- XXL-JOB 并不支持多数据源或多库分布式部署,调度中心所有节点必须连接同一个数据库(IP 一致)。

- 多个 XXL-JOB Admin 实例启动时,会通过

xxl_job_lock表加行锁防止重复调度(这依赖数据库强一致)。

2.5. ✅ 官方推荐:

一个调度中心 + 一个数据库 + 多个执行器节点 的部署结构已可满足大多数需求。数据库推荐 MySQL 8.x 单实例 或主从读写分离。

2.6. ✅ 补充建议:

如果你希望做到数据库层的高可用:

- 推荐使用 MySQL 主从 + Keepalived + VIP 实现切换。

- 或者使用 阿里云 PolarDB、腾讯 TDSQL、AWS RDS 多可用区 等。

3. 一个调度中心 + 一个数据库 + 多个执行器节点并发能力?

XXL-JOB 的任务并发能力,取决于多个因素,下面是详细分析。

3.1. ✅ 理论架构下的并发模型

“一个调度中心 + 一个数据库 + 多个执行器” 是官方推荐的架构,其并发量主要由以下几个部分决定:

关键影响因素:

| 模块 | 限制说明 |

| 调度中心线程数 | 默认:10(可调,影响触发并发数) |

| 执行器数 | 每个执行器是一个 Spring Boot 服务,可水平扩展多个实例 |

| 每个 Job 的并发策略 | JobHandler 默认是串行执行(可配置为并行) |

| 数据库写入能力 | 任务触发和日志写入都依赖数据库,瓶颈主要在数据库 QPS |

| 网络和机器性能 | 网络延迟 + 机器负载决定实际并发能力 |

3.2. ✅ 默认配置的并发能力(粗略估算)

| 模块 | 数量/配置 | 并发能力估计 |

| 调度线程 |

| 每秒可触发约 100~500 个任务(任务触发非常轻量) |

| 执行器节点 | 5 个节点(假设) | 每个节点可并发处理 10~100 个任务(视线程池) |

| 数据库写入 | MySQL 单实例(较好配置) | 可支持每秒 500~2000 次插入操作(主要是日志写入) |

⏱ 估算实际可支撑并发量为:1000~5000 个任务/分钟(轻量级任务)

3.3. ✅ 如何提升并发能力?

| 优化点 | 建议 |

| 🔧 增加执行器节点数 | 执行器可无限水平扩展,提高处理能力 |

| 🔧 扩大执行器线程池 | 每个执行器默认线程池为 |

| 🔧 JobHandler 设置为并行执行 | BlockStrategy 选择 |

| 🔧 数据库优化 | 日志表分表,使用 SSD,开启 binlog async,避免成为瓶颈 |

| 🔧 批量触发任务 | 尽量减少调度频率,比如将多个数据放一个 Job 处理 |

| 🔧 调度中心线程提升 | 增加调度线程数,如 |

3.4. ✅ 极限高并发案例(社区实际案例)

有用户反馈(在 XXL-JOB 社区 / GitHub Issues):单调度中心 + 10 个执行器节点,执行 2W+ 个小任务/小时(平均每分钟 300+ 任务),稳定运行。

但同时也指出:

- 日志表每秒写入过多会拖慢性能,需要分表;

- 任务执行应尽可能轻量化,避免任务阻塞线程。

3.5. ✅ xxl-job并发模型总结

| 模块 | 默认配置并发 | 可扩展性 |

| 调度中心 | 每秒触发数百任务 | 可调线程数提升能力 |

| 执行器 | 默认串行执行 | 增加线程池 + 节点 |

| 整体瓶颈 | 数据库(写日志) | 分表 + 高性能实例解决 |

4. 在 XXL-JOB 中,快慢线程池原理?

在 XXL-JOB 中,快慢线程池是为了应对不同任务执行耗时差异而设计的关键调度机制,目的是提升系统整体调度吞吐量并避免任务阻塞。

4.1. 快慢线程池是什么?

在 ExecutorBizImpl.java 中,XXL-JOB 内部定义了两个任务执行线程池:

| 名称 | 说明 | 默认线程数 |

| fastTriggerPool | 快任务线程池,用于快速执行任务 | 200 |

| slowTriggerPool | 慢任务线程池,用于慢任务排队执行 | 100 |

这两个线程池是通过 JobThreadPoolHelper 管理并区分处理的。

4.2. 线程池选择逻辑

- 不是基于每次任务执行的耗时判断快慢;

- 而是基于过去 1 分钟内该 Job 超时次数是否超过 10 次 进行判断。

| 条件 | 行为 |

| 某个 | 使用 |

| 超时次数 > 10 次 | 视为慢任务,使用 |

该机制设计在 JobTriggerPoolHelper 中,通过 jobTimeoutCountMap 来跟踪每个 Job 的执行超时情况。

4.2.1. 调用链如下:

com.xxl.job.admin.core.thread

└── com.xxl.job.admin.core.thread.JobTriggerPoolHelper#addTrigger // 线程池判断和分配4.2.2. 判断标准:

在 Job 执行完成后,根据耗时做出分类:

// choose thread pool

ThreadPoolExecutor triggerPool_ = fastTriggerPool;

AtomicInteger jobTimeoutCount = jobTimeoutCountMap.get(jobId);

if (jobTimeoutCount!=null && jobTimeoutCount.get() > 10) { // job-timeout 10 times in 1 mintriggerPool_ = slowTriggerPool;

}🟡 核心点: 是根据 Job 执行完的耗时动态判断放入哪个线程池(不是事先就区分的)。

4.3. 为什么要分快慢线程池?

| 原因 | 解释 |

| ✅ 提高吞吐量 | 快任务不被慢任务拖住,避免线程池被“长任务”堵死 |

| ✅ 减少延迟 | 快任务能迅速执行,不用等待慢任务释放线程 |

| ✅ 防止雪崩 | 大量慢任务堆积时不会影响短小高频任务的执行 |

| ✅ 易于调优 | 可以分别调整快慢线程池大小,适配不同业务负载 |

4.4. ✅ 快慢线程池对用户的影响

| 项目 | 说明 |

| ✅ 无需手动配置 | 用户不需要主动声明某个任务是“快”或“慢”,系统自动判断 |

| ✅ 影响任务排队策略 | 若线程池已满,任务将排队执行,慢任务线程池更容易出现排队 |

| ✅ 可通过参数调优 | 可以在 |

示例配置(executor 端):

xxl.job.executor.fastTriggerPoolSize=200

xxl.job.executor.slowTriggerPoolSize=1005. XXL-JOB 的优化设计

如果一个系统中的任务需要不断扫描数据库,且随着时间推移,数据量不断增大,这种情况可能会导致性能瓶颈。为了应对这种问题。

5.1. xxl-job数据库优化

在 XXL-JOB 中,数据库通常是单点部署的,但也可以通过一些方法实现高可用性,以避免单点故障影响任务调度的稳定性。具体情况如下:

5.1.1. 默认使用单点数据库

XXL-JOB默认依赖一个单一数据库实例来存储任务信息(包括任务配置、执行日志、任务状态等)。- 在单节点部署中,如果数据库发生故障,整个调度系统将无法正常工作,任务调度会受到影响。

- 对于小规模应用或任务调度不关键的场景,单点数据库通常是足够的,部署简单且易于维护。

5.1.2. 可以使用主从复制或高可用数据库集群

- 为了保证数据库的高可用性,

XXL-JOB可以部署在数据库主从复制或集群环境中,例如使用 MySQL 的主从复制、读写分离,或者使用 MySQL Cluster、MySQL Group Replication 等集群方案。 - 这样可以提高数据库的容错能力,在主库出现问题时,数据库服务可以自动切换到从库,从而保证调度系统的连续性。

5.1.3. 高可用方案:使用数据库中间件或云数据库

- 一些企业级数据库中间件(如 MyCAT)可以实现数据库读写分离和故障转移,可以在

XXL-JOB与数据库之间增加中间件层,利用中间件的高可用特性实现数据库的容灾。 - 也可以使用云数据库,如阿里云 RDS、AWS RDS 等,这些服务通常支持自动故障转移、备份恢复等功能,能够实现数据库的高可用,减少单点故障的影响。

5.1.4. 分布式任务调度的高可用性

XXL-JOB本身支持调度中心(Admin)和执行器(Executor)多节点集群部署,以提高调度系统的整体高可用性。- 在高可用的配置下,即使某个执行器节点故障,任务也可以被分配到其他节点执行,从而保证任务的正常运行。数据库作为任务数据存储核心,可以使用高可用方案来进一步保障稳定性。

5.1.5. 避免单点的注意事项

- 配置数据库高可用时,需要确保调度中心(

XXL-JOB Admin)能够感知数据库的主从切换,并且在切换过程中不会造成任务数据丢失或任务状态不一致。 - 使用高可用数据库时,还需要考虑调度日志、任务配置等数据的同步,确保在数据库切换时数据的一致性。

XXL-JOB 默认使用单点数据库,但在生产环境下,可以通过主从复制、高可用数据库集群或数据库中间件来提升数据库的容错能力,从而实现高可用部署。

5.2. xxl-job执行器优化

可以从以下几个方面着手优化:

- 减少扫描量(增量扫描、分页)、

- 提升查询效率(分区、索引、归档)、

- 缓解数据库压力(缓存、分片、异步处理)

- 以及适当的数据存储选择。

5.2.1. 使用增量扫描

- 问题描述:如果每次都扫描整个数据库,数据量增大时会导致查询越来越慢。

- 解决方案:使用增量扫描技术,只处理自上次扫描后新增或修改的数据。可以使用时间戳或递增的ID字段来标记数据变更。每次扫描时只读取比上次时间戳或ID更大的记录,减少查询量。只查询没有被消费任务数据,同时在数据被消费之后会写数据状态。

5.2.2. 分页处理

- 问题描述:一次性加载大量数据到内存中,可能会导致内存溢出或性能下降。

- 解决方案:将数据分批处理,使用分页技术逐页读取数据。例如可以使用SQL的

LIMIT和OFFSET,或游标(cursor)读取数据。这样每次只处理一小部分数据,有助于控制内存消耗和处理时间。

5.2.3. 分区表

- 问题描述:单表中的数据量过大,影响查询效率。

- 解决方案:对数据进行分区,将不同时间段的数据放入不同的分区表。例如按月或按年分区查询,数据库会仅扫描相关的分区,减少查询量。此外,数据库如MySQL、PostgreSQL、Oracle等都支持表分区。就是讲任务已经完成的进行归档处理。

5.2.4. 索引优化

- 问题描述:大数据量下全表扫描耗时较长。

- 解决方案:针对查询条件创建合适的索引,减少扫描行数。特别是增量扫描时,可以在时间戳或ID字段上创建索引,提高查询效率。但要注意,过多的索引可能影响写入性能。

5.2.5. 定期归档历史数据

- 问题描述:历史数据存放在主库中,但不再被频繁查询。

- 解决方案:将旧数据归档到冷数据存储中,比如定期将一年前的数据转移到备份表或历史表中,主库中只保留活跃数据。这种方式也适合使用数据仓库进行历史数据分析。

5.2.6. 缓存热点数据

- 问题描述:同一数据被频繁扫描,导致数据库压力增大。

- 解决方案:对热点数据使用缓存技术,如Redis、Memcached等,将常用数据放在内存中,减少对数据库的直接访问。可以在缓存中设置过期策略,确保数据一致性。

5.2.7. 优化SQL查询

- 问题描述:查询效率低,尤其是复杂查询的性能可能会显著下降。

- 解决方案:优化SQL查询语句,简化复杂的SQL逻辑,避免子查询、JOIN操作过多。可以通过查询计划(如

EXPLAIN命令)查看查询的执行情况并进一步优化。

5.2.8. 数据库分片

- 问题描述:单个数据库存储和处理能力有限,数据量大时难以应对。

- 解决方案:对数据进行分片,按一定规则(如用户ID、地理位置等)将数据分散到不同的数据库中,减小单个数据库的压力。可以使用分布式数据库或中间件来管理分片。

5.2.9. 异步处理和消息队列

- 问题描述:实时处理所有数据的成本高,并且无法保证处理时延。

- 解决方案:将扫描任务异步化,比如使用消息队列(如Kafka、RabbitMQ)将需要处理的数据推送给消费者异步处理,这样可以让生产者和消费者解耦,避免数据库压力过大。

5.2.10. 使用合适的数据存储

- 问题描述:某些数据增长过快,数据库难以处理大量写入。

- 解决方案:根据数据类型和查询模式,考虑将一部分非关系型数据迁移到适合的数据存储中,例如大数据集可以使用NoSQL数据库(如MongoDB、HBase)或分布式文件系统(如HDFS)来存储和处理。关系型数据库和非关系型数据库结合使用,可以提升整体性能。

6. XXL-JOB为什么不采用MQ作为消息存储而是采用DB呢?

XL-JOB 选择数据库(DB)作为任务存储,而非消息队列(MQ),主要是因为其设计初衷和任务调度场景需求与MQ有所不同。以下是一些关键原因:

6.1.1. 任务调度与消息推送的场景不同

- 任务调度:

XXL-JOB主要用于定时任务调度,要求在指定时间或周期内触发任务,而非实时消息处理。这种调度场景更适合使用数据库,便于查询和持久化管理任务状态。 - 消息推送:消息队列适合实时性要求高、数据流量大的场景。它会不断地推送消息给消费者,要求消费者快速响应。对于任务调度来说,这种模式会增加复杂度,且消息的实时性特性在这里并非关键需求。

6.1.2. 任务状态管理需要持久化

- 在任务调度场景中,需要对每个任务的状态进行管理,比如待执行、执行中、成功、失败等状态。数据库的事务机制能够确保任务状态的准确持久化。数据库可以记录任务的执行结果和日志,支持任务重试、任务进度查询等功能。

- 消息队列通常不会记录消息的状态,一旦消费成功消息就会被移除,不适合需要持久化任务状态的场景。

6.1.3. 任务执行的可控性与查询

- 在任务调度系统中,调度器需要定期扫描数据库,查找符合条件的任务,并根据调度策略进行分配。这种任务查询需求在数据库中更易实现。

- 使用数据库可以支持任务的查询、过滤、统计等操作,而MQ更适合直接传递和处理消息,而非支持复杂的查询。使用消息队列进行任务管理,查询和筛选任务状态会变得困难。

6.1.4. 数据库的持久性保证

- 对于定时任务系统,任务的可靠性要求很高,任务需要在系统重启、断电、故障时依然能保持数据一致性。

- 数据库天然具备持久性存储特性,而消息队列(例如Kafka、RabbitMQ)的持久化方式不同,虽然一些队列可以持久化消息,但一般不用于持久存储业务逻辑中的任务数据。

6.1.5. 使用数据库简化架构设计

XXL-JOB的任务存储使用数据库,可以直接利用数据库的事务、查询、索引、关系结构等特性,极大地简化了任务调度的实现。- 如果改为使用消息队列,需要增加一层消息与任务的中间处理逻辑,以保证任务的状态和可靠性,并且可能还需要单独的数据库来记录任务执行的持久化数据,这样反而会增加复杂度。

6.1.6. 适合低频调度的任务管理

XXL-JOB主要用于秒级、分钟级、甚至小时级的任务调度,且调度频率较低。使用数据库进行任务查询和状态管理已经足够。- 对于这种低频调度的任务系统,数据库的查询和状态更新完全能够满足性能需求,使用消息队列可能会造成资源浪费。

6.1.7. 避免分布式事务复杂性

- 如果任务数据和状态分别存在数据库和MQ中,调度系统在更新任务状态时可能需要处理分布式事务(例如,任务状态更新可能涉及DB和MQ的一致性),这会增加系统的复杂性和维护成本。

- 直接使用数据库可以避免分布式事务问题,使得任务数据和状态管理更为简单和一致。

总体来说,XXL-JOB选择数据库作为任务存储是基于任务调度系统的持久性需求、状态管理需求、调度查询需求等考虑。数据库提供的持久化、查询和事务机制非常适合任务调度的场景。而消息队列更适合用于高并发、实时性要求高的消息传递场景,两者的设计初衷和应用场景存在本质差异。

7. XXL-JOB 中类没有使用@Data,为什么?

在 XXL-Job 中,确实很多类并没有使用 Lombok 提供的 @Data 注解,而是手动编写了 getter、setter、toString 等方法。这种做法其实是有意为之,主要出于以下几个原因:

7.1. 💡 原因分析:

7.1.1. 明确控制代码结构,提升可读性

@Data会自动生成 getter/setter、equals、hashCode、toString 等多个方法。- 在公共组件或框架中,如 XXL-Job,开发者往往希望对生成的每个方法有更明确的控制和可读性,避免 Lombok 的黑盒行为。

7.1.2. 避免 Lombok 带来的依赖侵入

- XXL-Job 是一个广泛使用的调度框架,如果底层使用 Lombok,意味着使用者也必须引入 Lombok 依赖,否则编译报错。

- 为了保持框架的“零侵入”性,作者可能选择避免 Lombok,以提升兼容性与移植性。

7.1.3. 可维护性和调试便利性

- 手写方法虽然冗长,但在调试和阅读源码时更加直观,便于定位问题。

@Data生成的toString()、equals()、hashCode()方法,有时会导致日志输出过多或出现性能问题,手写更安全。

7.1.4. 保持编译清晰,避免IDE插件依赖

- Lombok 依赖编译器插件(如 IntelliJ 的 Lombok Plugin)才能正确识别。

- 有些开发者或团队不希望因为 IDE 配置不同导致无法正常阅读源码或编译错误。

7.1.5. 项目历史或团队编码规范

- XXL-Job 是早期开发的项目(最初发布于 2016 年),当时 Lombok 并不如现在流行。

- 很多老项目为了保持一致风格和团队规范,坚持手写 getter/setter。

7.2. @Data 注解总结

XXL-Job 中不使用 @Data 是为了代码清晰、控制力强、避免依赖、增强兼容性和调试友好性,这是一种更适合框架/中间件开发的风格。

8. XXL-JOB 服务启动类

在 XXL-JOB 的调度中心(xxl-job-admin)中,程序的启动入口 是标准的 Spring Boot 方式。

8.1. 初始化逻辑入口XxlJobAdminConfig

@Component

public class XxlJobAdminConfig implements InitializingBean, DisposableBean {private static XxlJobAdminConfig adminConfig = null;@Overridepublic void afterPropertiesSet() throws Exception {adminConfig = this;xxlJobScheduler = new XxlJobScheduler();xxlJobScheduler.init(); // 初始化调度器}

}8.2. 核心调度入口:XxlJobScheduler

在 XxlJobAdminConfig 中初始化的 XxlJobScheduler 是 XXL-JOB 的 调度核心组件:

public class XxlJobScheduler {public void init() throws Exception {// 初始化触发器线程池、注册服务、日志清理等JobTriggerPoolHelper.toStart();JobRegistryMonitorHelper.getInstance().start();...}

}其中会启动多个核心线程模块,如:

JobTriggerPoolHelper(任务触发线程池)JobRegistryMonitorHelper(注册节点监控)JobFailMonitorHelper(失败任务监听)JobLogReportHelper(日志统计线程)

8.3. XXl-job启动总结

| 步骤 | 组件 | 说明 |

| ① |

| Spring Boot 启动入口 |

| ② |

| 加载配置,初始化调度器 |

| ③ |

| 启动调度线程、任务池、注册中心等 |

| ④ | 各种 Helper 类 | 真正执行调度、监控、失败处理、清理日志等任务 |

如果你是在使用 xxl-job-executor 客户端,则入口会是:Spring Boot 应用启动后执行 XxlJobSpringExecutor#start() 注册自己到调度中心。需要我再补充一下 执行器客户端的入口流程 也可以继续发问。

9. XXL-JOB 执行器原理概述

XXL-JOB 执行器项目确实是 借助 Spring 启动机制进行初始化,在初始化阶段完成了各种 任务调度相关线程组件的加载与启动,包括你提到的 JobFailMonitorHelper、JobLogReportHelper、TriggerCallbackThread、ExecutorRegistryThread 等核心线程模块。

9.1. 🧩 XXL-JOB 执行器原理概述

XXL-JOB 执行器是一个内嵌于 Spring Boot 应用中的组件,启动时完成:

- 注册任务处理器(@XxlJob)

- 注册到调度中心(通过心跳线程)

- 启动内嵌 HTTP Server 接收调度请求

- 启动多个线程模块用于调度、监控、日志回调等

9.2. 🧵 核心线程模块一览(执行器中)

| 线程模块 | 作用 | 实现机制 |

|

| 执行器注册&清理失效节点 | 心跳检测 |

|

| 失败任务监控与重试 | 日志表轮询 |

|

| 检测未执行的调度任务 | 时间差+日志判断 |

|

| 异步触发任务执行 | Fast/Slow 线程池 |

|

| 日志报表生成 | 每小时统计一次 |

|

| 按 cron 周期调度任务 | 任务轮询触发 |

9.3. 🧬 初始化顺序原理分析

com.xxl.job.admin.core.conf.XxlJobAdminConfig(spring的对象)

/*** 这个是InitializingBean 实现方式,主要是为了初始化的相关类* @throws Exception*/@Overridepublic void afterPropertiesSet() throws Exception {logger.info(">>>>>>>>>>> xxl-job config init.");adminConfig = this;xxlJobScheduler = new XxlJobScheduler();xxlJobScheduler.init();logger.info(">>>>>>>>>>> xxl-job admin config init end.");}com.xxl.job.admin.core.scheduler.XxlJobScheduler

public void init() throws Exception {logger.info(">>>>>>>>> init xxl-job admin start.");// init i18ninitI18n();// admin registry monitor runJobRegistryMonitorHelper.getInstance().start();// admin fail-monitor runJobFailMonitorHelper.getInstance().start();// admin lose-monitor runJobLosedMonitorHelper.getInstance().start();// admin trigger pool startJobTriggerPoolHelper.toStart();// admin log report startJobLogReportHelper.getInstance().start();// start-scheduleJobScheduleHelper.getInstance().start();logger.info(">>>>>>>>> init xxl-job admin success.");}com.xxl.job.admin.core.scheduler.XxlJobScheduler

public void init() throws Exception {logger.info(">>>>>>>>> init xxl-job admin start.");// init i18ninitI18n();// 执行器注册监控JobRegistryMonitorHelper.getInstance().start();// 任务失败重试监控。JobFailMonitorHelper.getInstance().start();// 任务丢失检测。JobLosedMonitorHelper.getInstance().start();// 初始化任务触发线程池。JobTriggerPoolHelper.toStart();// 日志统计报表线程。JobLogReportHelper.getInstance().start();// 定时任务调度线程。JobScheduleHelper.getInstance().start();logger.info(">>>>>>>>> init xxl-job admin success.");}9.4. ✅ JobRegistryMonitorHelper

com.xxl.job.admin.core.thread.JobRegistryMonitorHelper

作用:监控执行器的注册情况(执行器注册、心跳维持、自动清理失效节点)

实现原理:

- 后台线程每 30 秒扫描注册表(

xxl_job_registry) - 清理超过心跳间隔(

DEAD_TIMEOUT)的死节点 - 类似心跳检测机制

核心方法:

registryMonitorThread = new Thread(() -> {while (!toStop) {// 查找超时的执行器注册记录并删除}

});9.5. ❌ JobFailMonitorHelper

- 作用:监控失败任务,处理失败重试逻辑

- 实现原理:

-

- 扫描日志表(

xxl_job_log)中失败但尚未处理的任务 - 根据任务配置是否允许失败重试

- 重新触发任务执行

- 扫描日志表(

- 核心逻辑:

while (!toStop) {List<XxlJobLog> failLogList = xxlJobLogDao.findFailJobLog(1000);for (...) {// 调用 JobTrigger.trigger() 重新调度任务}

}9.6. ❗JobLosedMonitorHelper

作用:监控被调度中心“调度成功”但未在执行器端实际执行的“丢失任务”

实现原理:

- 根据时间窗口判断是否有任务在应执行时间后一直未开始执行

- 多用于处理网络延迟、执行器崩溃等特殊场景

核心逻辑:

while (!toStop) {List<XxlJobInfo> list = jobInfoDao.findLosedJobList(...);// 调用 trigger 补偿执行

}9.7. 🚀 JobTriggerPoolHelper

作用:任务调度线程池,处理 JobTrigger 调用产生的异步任务触发请求

实现原理:

- 包含 fast/slow 两种线程池

-

- fast:用于频繁/轻量级触发

- slow:用于耗时较长或批量触发

- 使用

ThreadPoolExecutor管理触发请求

核心代码:

static ThreadPoolExecutor fastTriggerPool = new ThreadPoolExecutor(...);

static ThreadPoolExecutor slowTriggerPool = new ThreadPoolExecutor(...);9.7.1. 📊 JobLogReportHelper

- 作用:定时统计任务执行日志(成功/失败数等),用于报表展示

- 实现原理:

-

- 每小时统计一次执行情况,写入报表表(

xxl_job_log_report)

- 每小时统计一次执行情况,写入报表表(

- 核心方法:

for (int i = 0; i < 24; i++) {Date from = ..., to = ...;int runningCount = ..., successCount = ...;logReportDao.save(...);

}9.7.2. 6. ⏰ JobScheduleHelper

- 作用:核心调度线程,按照 cron 表达式周期性触发任务

- 实现原理:

-

- 轮询所有的调度任务,根据 cron 时间判断是否应触发

- 精度通常为秒

- 是调度中心的“大脑”

- 核心逻辑:

while (!scheduleThreadToStop) {List<XxlJobInfo> jobInfoList = jobInfoDao.scheduleJobQuery(...);for (...) {// 计算 cron,触发执行器JobTrigger.trigger(...);}

}10. XXL-JOB 任务状态类型

在 XXL-JOB 中,任务的状态并不是简单的“完成”和“结束”两种状态码,而是通过日志表(xxl_job_log)中的几个字段来间接描述任务状态的。严格来说没有统一的任务“状态枚举”,而是通过执行日志状态组合判断任务状态。

10.1. ✅ 实际的任务状态判断依赖字段

表:xxl_job_log主要字段如下:

| 字段名 | 类型 | 含义 |

|

| int | 调度是否成功(200 表示成功) |

|

| int | 执行器执行是否成功(200 表示成功) |

|

| string | 调度日志 |

|

| string | 执行器处理日志 |

10.2. 🔍 状态码定义(ReturnT)

10.2.1. trigger_code

- 定义在调度中心,表示调度请求是否成功(如调度器能否找到执行器并发出任务)

- 状态码说明:

-

200:调度成功- 其他:调度失败(如路由失败、注册失败)

10.2.2. handle_code

- 由执行器返回,表示任务实际运行的结果

- 状态码说明:

-

200:执行成功- 其他:执行失败

-

-

- 如代码异常、逻辑失败等

-

这些状态码是通过 ReturnT 类统一表示的:

public class ReturnT<T> {public static final int SUCCESS_CODE = 200;public static final int FAIL_CODE = 500;private int code;private String msg;private T content;

}10.3. 💡 状态组合的实际含义示例

| trigger_code | handle_code | 状态解释 |

| 200 | null | 调度成功,但执行器还未返回(执行中) |

| 200 | 200 | 执行成功 ✅ |

| 200 | 500 | 调度成功,执行失败 ❌ |

| 500 | null | 调度失败(如路由不到执行器) ❌ |

| null | null | 尚未调度(如未来定时执行) ⏳ |

10.4. ❓中间状态有吗?

虽然 XXL-JOB 没有像“运行中”、“等待中”这样的状态字段,但你可以通过以下方式判断中间态:

10.4.1. ✅ 判断是否运行中

SELECT * FROM xxl_job_log

WHERE trigger_code = 200 AND handle_code IS NULL;说明:任务已调度,执行器未返回结果 → 正在运行中。

10.4.2. ✅ 判断失败但可重试

SELECT * FROM xxl_job_log

WHERE handle_code != 200 AND retry_count < retry_limit;说明:可以进入 JobFailMonitorHelper 的重试逻辑。

10.5. 🧠 XXL-JOB 任务状态总结

- XXL-JOB 没有统一的“任务状态枚举类”,而是依赖

trigger_code和handle_code的组合判断状态 - 中间态是隐含存在的,例如执行中状态是

handle_code = null。 - 所有状态信息都在

xxl_job_log表中。 - 如果你需要更精确的任务状态跟踪,可以自行扩展日志表或构建任务状态视图。

11. 守护线程(Daemon Thread)是什么?

11.1. 在 Java 中,线程有两种类型:

| 类型 | 描述 |

| 用户线程(User Thread) | 主线程、业务线程等,一般用于完成程序的主要逻辑 |

| 守护线程(Daemon Thread) | 辅助线程,用于服务用户线程,例如垃圾回收线程、日志线程、调度线程 |

11.2. 🔍 守护线程 vs 用户线程

- 当所有“用户线程”都执行完毕时,JVM 会退出运行,不管是否还有守护线程在运行。

- 守护线程是“辅助线程”,JVM 不会等待守护线程执行完毕。

| 对比点 | 用户线程(User Thread) | 守护线程(Daemon Thread) |

| 是否阻止 JVM 退出 | ✅ 是(有用户线程则 JVM 不退出) | ❌ 否(只剩守护线程时,JVM 退出) |

| 是否独立运行 | ✅ 是 | ✅ 也是(从执行逻辑看是独立的) |

| 生命周期关系 | JVM 直到所有用户线程结束才退出 | 所有用户线程结束后即强制结束守护线程 |

| 典型用途 | 业务逻辑线程,如 HTTP 请求处理 | 辅助性线程,如日志写入、GC、调度等线程 |

11.3. ✅ 应用在 XXL-JOB 中的意义:

scheduleThread.setDaemon(true); 说明调度线程是 守护线程,表示:

- 不阻止 JVM 正常退出(避免主线程结束后还因调度线程挂起)

- JVM 在关闭时不会等待调度线程清理或执行完毕。

11.4. ✅ 在 XXL-JOB 中的作用

XXL-JOB 中的很多后台线程(如:调度线程、失败重试线程、日志清理线程等)都被设置为 Daemon,意味着:

- 这些线程是“后台服务线程”

- 当调度中心关闭(比如 Spring 容器关闭),不会阻止 JVM 退出

如果你希望线程 不被 JVM 自动中止(如需要优雅关闭),可以不设置为守护线程,并在 Spring @PreDestroy 或 DisposableBean.destroy() 中做回收逻辑。

12. 多个XXl-job 服务,任务注册到了服务A 但是调度到服务B,显示没有的对应JobHandler 处理器?

12.1. ✅ 问题本质

XXL-JOB 默认调度逻辑是:在“执行器组”中的所有机器中随机选择一个机器调度执行。所以如果服务 A 注册了 JobHandler,但服务 B 没有注册相应的 JobHandler,而调度却派发到服务 B —— 任务就会失败,提示:

com.xxl.job.core.exception.XxlJobException: JobHandler not found12.2. 🔥 场景复现流程

假设:

- 服务 A:注册了 JobHandler

testJob - 服务 B:没有

testJob,但同属于执行器组default - 管理后台的任务绑定了执行器组

default,没有绑定指定执行器地址 - 调度系统从

default组中随机挑选执行器地址时选中了 B

💥 于是任务派发到 B,找不到 testJob,就报错了!

12.2.1. ✅ 方式一:为每个 JobHandler 精准绑定执行器地址(推荐)

在 XXL-JOB 管理后台:

- 进入任务编辑页

- 找到“执行器地址类型”,选择:手动输入地址

- 指定部署了该

JobHandler的服务实例地址,例如:

http://10.0.0.101:9999- 保存

这样调度器就不会再随机分配,而是只发给这个地址。

12.2.2. ✅ 方式二:按业务拆分执行器组

举例:

- 服务 A 的执行器注册为组

group-a - 服务 B 的执行器注册为组

group-b

然后:

testJob任务配置为绑定group-a执行器组testJob2绑定group-b

⚠️ 注册执行器时需配置 appname,例如:

xxl:job:executor:appname: group-a # 服务 A12.2.3. ✅ 方式三:所有服务都部署同样的 JobHandler

将所有任务的 @XxlJob 方法统一打包到一个公共模块中,每个服务都引入它 —— 保证每个服务都有相同 JobHandler。⚠️ 不推荐。虽然能解决问题,但会导致服务臃肿、维护成本高,且不符合职责分离原则。

12.3. 🚫 常见错误用法

- ❌ 仅配置执行器组,不绑定具体地址

- ❌ 不同服务部署不同 JobHandler,却共用一个执行器组

- ❌ 开启自动注册,但未合理管理服务。

13. XXL-job 注册 IP 获取与任务调度目标 IP 的绑定控制

在 XXL-JOB 中,任务注册默认不会返回注册的 IP 地址,但你可以通过以下几种方式实现注册 IP 获取与任务调度目标 IP 的绑定控制,从而达到你想要的“制定任务执行时候 IP”的目标。

13.1. 任务注册返回注册 IP(执行器 IP)

13.1.1. 背景:

执行器(Executor)在启动时会向 XXL-JOB 调度中心进行注册,注册的地址是:

xxl-job.executor.address如果你没有手动指定,它会自动通过网络接口获取本机 IP + 端口注册到调度中心。

13.1.2. ✅ 如何获取注册的 IP 地址?

注册信息会出现在调度中心 Admin 中:

- 打开 XXL-JOB 管理后台 → 执行器管理 → 某执行器 AppName → 查看注册地址列表

- 显示的是注册上来的机器地址(IP:PORT)

这些地址信息被保存在调度中心的内存注册表中,并作为调度路由时的可选地址池。

13.2. ✅ 如何指定任务调度到某个注册 IP(机器)

你可以通过以下方式指定任务执行时调度到哪个 IP:

13.2.1. ✅ 方法一:手动注册执行器地址(强绑定 IP)

在“执行器管理”中设置注册方式为:

- 注册方式:手动录入机器地址

- 地址列表只填你希望绑定的机器 IP,如:

http://192.168.1.101:9999这样,任务只会调度到该地址,不会被路由到其他注册执行器。

13.2.2. ✅ 方法二:使用路由策略“指定机器”进行 IP 定向

如果注册方式为自动发现(自动注册),你仍可以:

- 任务配置时,选择路由策略为:

指定机器(Routing: Specific Machine)- 调度时,调用 Admin 接口触发任务时,传入目标机器地址,例如:

JobTriggerPoolHelper.trigger(jobId,TriggerTypeEnum.MANUAL,-1,null,"http://192.168.1.101:9999", // 指定目标地址null

);这会强制任务发送到你指定的那台机器(即那个注册 IP)。

13.3. 🔧 附加:自动注册时修改 IP 注册行为

如果你想控制执行器注册时的 IP 或端口,可以配置以下属性:

xxl.job.executor.ip=192.168.1.101

xxl.job.executor.port=9999还可以通过 SPI 或代码实现方式自定义注册行为。

13.4. 📌 总结

| 目标 | 方法 |

| 获取执行器注册的 IP | 后台执行器管理中可查看 |

| 控制任务调度到某台 IP | 使用“手动地址注册”或“指定机器”路由策略 |

| 自定义注册 IP 行为 | 设置 |

| 自动注册查看 IP 列表 | 调度中心内存缓存中维护,可查看或打印日志调试 |

博文参考

- 分布式任务调度平台XXL-JOB