基于 TensorFlow 2 的 WGAN来生成表格数据、数值数据和序列数据。 WGAN生成对抗网络。代码仅供参考

WGAN生成对抗网络

基于python tensorflow2以下框架,环境应该如何自己配置?

表格数据、数值数据,序列数据生成

里面是一个标准函数的数据,读取自己数据需要自己改。可以随意替换纬度,需要自己手动改.

如何配置环境并编写一个基于 TensorFlow 2 的 WGAN(Wasserstein Generative Adversarial Network)来生成表格数据、数值数据和序列数据。我们将使用标准函数,并提供一个模板,你可以根据自己的数据进行调整。

代码仅供参考

环境配置

首先,确保你的 Python 环境已经安装了必要的库。你可以使用以下命令来安装所需的库:

pip install tensorflow numpy pandas matplotlib scikit-learn

代码实现

我们将编写一个通用的 WGAN 模型,可以处理不同类型的数值数据。这个模型将包括以下几个部分:

- 数据加载和预处理

- 构建 WGAN 模型

- 训练 WGAN 模型

- 生成数据

1. 数据加载和预处理

我们将编写一个函数来加载和预处理数据。这里我们假设你有一个 CSV 文件作为输入数据。

import os

import numpy as np

import pandas as pd

from sklearn.preprocessing import StandardScalerdef load_and_preprocess_data(file_path):# Load data from CSV filedata = pd.read_csv(file_path)# Separate features and labels if neededX = data.values# Normalize the datascaler = StandardScaler()X_scaled = scaler.fit_transform(X)return X_scaled, scaler# Example usage

data_path = 'your_data.csv'

X_scaled, scaler = load_and_preprocess_data(data_path)

2. 构建 WGAN 模型

我们将定义生成器和判别器网络。

import tensorflow as tf

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Dense, Reshape, Flatten

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.constraints import Constraintclass ClipConstraint(Constraint):def __init__(self, clip_value):self.clip_value = clip_valuedef __call__(self, weights):return tf.clip_by_value(weights, -self.clip_value, self.clip_value)def build_generator(latent_dim, output_shape):model = Sequential()model.add(Dense(128, activation='relu', input_dim=latent_dim))model.add(Dense(256, activation='relu'))model.add(Dense(512, activation='relu'))model.add(Dense(output_shape, activation='tanh'))return modeldef build_discriminator(input_shape):model = Sequential()model.add(Flatten(input_shape=input_shape))model.add(Dense(512, activation='relu', kernel_constraint=ClipConstraint(0.01)))model.add(Dense(256, activation='relu', kernel_constraint=ClipConstraint(0.01)))model.add(Dense(1))return modeldef wasserstein_loss(y_true, y_pred):return tf.reduce_mean(y_true * y_pred)def gradient_penalty_loss(y_true, y_pred, averaged_samples, weight):gradients = tf.gradients(y_pred, averaged_samples)[0]gradients_sqr = tf.square(gradients)gradient_penalty = tf.reduce_mean(tf.reduce_sum(gradients_sqr, axis=np.arange(1, len(gradients_sqr.shape))))return weight * gradient_penalty# Define parameters

latent_dim = 100

output_shape = X_scaled.shape[1]generator = build_generator(latent_dim, output_shape)

discriminator = build_discriminator((output_shape,))discriminator.compile(loss=wasserstein_loss, optimizer=Adam(lr=0.0001, beta_1=0.5), metrics=['accuracy'])discriminator.trainable = Falsegan_input = Input(shape=(latent_dim,))

generated_signal = generator(gan_input)

validity = discriminator(generated_signal)combined = Model(gan_input, validity)

combined.compile(loss=wasserstein_loss, optimizer=Adam(lr=0.0001, beta_1=0.5))

3. 训练 WGAN 模型

我们将编写训练循环来训练 WGAN 模型。

def train(generator, discriminator, combined, X_train, latent_dim, epochs=10000, batch_size=64, sample_interval=1000):valid = -np.ones((batch_size, 1))fake = np.ones((batch_size, 1))g_loss_list = []d_loss_list = []for epoch in range(epochs):idx = np.random.randint(0, X_train.shape[0], batch_size)real_signals = X_train[idx]noise = np.random.normal(0, 1, (batch_size, latent_dim))generated_signals = generator.predict(noise)d_loss_real = discriminator.train_on_batch(real_signals, valid)d_loss_fake = discriminator.train_on_batch(generated_signals, fake)alpha = np.random.random(size=(batch_size, 1, X_train.shape[1]))interpolated_signals = (alpha * real_signals) + ((1 - alpha) * generated_signals)validity_interpolated = discriminator.predict(interpolated_signals)gp_loss = gradient_penalty_loss(None, validity_interpolated, interpolated_signals, 10)d_loss = 0.5 * np.add(d_loss_real, d_loss_fake)[0] + gp_lossnoise = np.random.normal(0, 1, (batch_size, latent_dim))g_loss = combined.train_on_batch(noise, valid)if epoch % sample_interval == 0:print(f"{epoch} [D loss: {d_loss}] [G loss: {g_loss}]")g_loss_list.append(g_loss)d_loss_list.append(d_loss)return g_loss_list, d_loss_list# Train the model

g_loss_list, d_loss_list = train(generator, discriminator, combined, X_scaled, latent_dim)

4. 生成数据

我们将编写一个函数来生成新的数据样本。

def generate_data(generator, latent_dim, num_samples, scaler):noise = np.random.normal(0, 1, (num_samples, latent_dim))generated_signals = generator.predict(noise)generated_signals_rescaled = scaler.inverse_transform(generated_signals)return generated_signals_rescaled# Generate new data samples

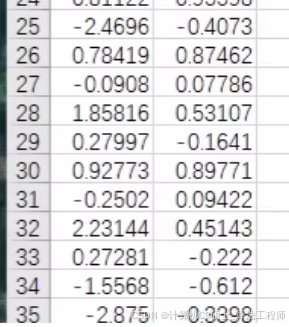

num_samples = 1000

generated_data = generate_data(generator, latent_dim, num_samples, scaler)# Save generated data to a CSV file

pd.DataFrame(generated_data).to_csv('generated_data.csv', index=False)

完整代码

以下是完整的代码示例,包含了从数据加载、模型构建、训练到生成数据的所有步骤。

运行脚本

在终端中运行以下命令来执行整个流程:

python main.py

总结

以上文档包含了从数据加载、模型构建、训练到生成数据的所有步骤。希望这些详细的信息和代码能够帮助你顺利实施和优化你的 WGAN 模型。

自定义说明

- 数据文件路径: 修改

data_path变量以指向你的数据文件。 - 数据维度: 根据你的数据维度调整

latent_dim和output_shape参数。 - 训练参数: 根据需要调整

epochs,batch_size, 和sample_interval等超参数。 - 生成样本数量: 修改

num_samples变量以生成所需数量的数据样本。

通过这些步骤,可以灵活地使用 WGAN 生成各种类型的数值数据。