MLLM常见概念通俗解析(三)

Instruction-Guided Visual Masking

指令遵循在当代大型语言模型(LLM)中至关重要。然而,当扩展到多模态设置时,它常常遭受特定文本指令与图像目标局部区域之间的错位问题。为了实现更准确和细致的多模态指令遵循,我们引入了指令引导视觉遮蔽(Instruction-guided Visual Masking, IVM),这是一种新的、通用的视觉基础模型,与各种多模态模型兼容,例如大型多模态模型(LMM)和机器人模型。通过为指令无关区域构建视觉遮蔽,IVM增强的多模态模型可以有效地关注任务相关的图像区域,从而更好地与复杂指令对齐。具体来说,我们设计了一个视觉遮蔽数据生成流程,并创建了一个包含100万个图像-指令对的IVM-Mix-1M数据集。我们进一步引入了一种新的学习技术——判别器加权监督学习(Discriminator Weighted Supervised Learning, DWSL),用于优先训练高质量数据样本的IVM。在诸如视觉问答(VQA)和具身机器人控制等通用多模态任务上的实验结果证明了IVM的多功能性,它作为一个即插即用的工具,显著提升了各种多模态模型的性能,在具有挑战性的新多模态基准测试中取得了最先进的结果。代码可在 https://github.com/2toinf/IVM 获取。

-

指令遵循是什么意思? (What does “instruction following” mean?)

在论文的上下文中,“指令遵循”指的是人工智能模型(特别是大型语言模型LLM或多模态模型)理解并准确执行以自然语言形式给出的指令或命令的能力。例如,如果给模型一个指令“请描述图片左上角的红色物体”,模型需要首先理解这个指令的意图(定位到左上角,找到红色物体,并进行描述),然后准确地执行这个操作。在多模态场景下,这意味着模型需要将文本指令与图像中的特定区域或概念正确关联起来,并据此作出反应或生成内容。论文提到,当扩展到多模态设置时,模型常常在文本指令与图像目标局部区域的对齐上遇到困难,这就是IVM试图解决的问题。

-

视觉遮蔽数据是什么? (What is “visual masking data”?)

“视觉遮蔽数据”指的是包含了图像、对应指令以及“视觉遮蔽信息”的数据集。这里的“视觉遮蔽 (visual masks)”可以理解为在图像上叠加的一层或多层“掩码”,这些掩码的作用是标示出图像中的特定区域。

根据摘要,“通过为指令无关区域构建视觉遮蔽 (By constructing visual masks for instruction-irrelevant regions)”,这意味着遮蔽的目的是隐藏或区隔出与当前文本指令不相关的图像区域,从而帮助模型将注意力集中在与指令相关的关键区域。

因此,“视觉遮蔽数据”就是由“图像 + 文本指令 + 指示图像哪些区域与指令相关/不相关的遮蔽信息”组成的数据对。论文中提到的“IVM-Mix-1M dataset with 1 million image-instruction pairs”就是一个专门为此创建的包含视觉遮蔽信息的数据集。

-

判别器加权监督学习(Discriminator Weighted Supervised Learning, DWSL)是什么意思?

这是一种新的学习技术,用于改进IVM模型的训练过程。让我们分解来看:

- 监督学习 (Supervised Learning): 这是机器学习的一种基本方法,模型通过学习带有已知答案(标签)的训练数据来进行训练。在这个场景下,训练数据是图像-指令对以及相关的视觉遮蔽信息。

- 判别器 (Discriminator): 这通常是生成对抗网络(GANs)中的一个组件,用于区分真实数据和生成数据。在这里,判别器的作用更可能是评估数据样本的“质量”。

- 加权 (Weighted): 意味着在训练过程中,不同的数据样本对模型更新的贡献是不同的,即被赋予了不同的“权重”。

- 判别器加权监督学习 (DWSL): 综合来看,DWSL是一种监督学习方法,它利用一个判别器来评估训练数据样本的质量。然后,根据这个质量评估给每个数据样本赋予一个权重,高质量的样本获得更高的权重,低质量的样本获得较低的权重。这样,在模型训练时,高质量的样本会对模型的学习过程产生更大的影响。其目的是“优先训练高质量数据样本的IVM (preferential IVM training that prioritizes high-quality data samples)”。

-

为什么说它是即插即用的工具? (Why is it said to be a “plug-and-play tool”?)

当论文称IVM是一个“即插即用 (plug-and-play)”的工具时,意味着它可以被方便地集成到各种现有的多模态模型中(如摘要中提到的大型多模态模型LMM和机器人模型),而不需要对这些现有模型进行大规模的结构性修改或复杂的适配工作。

就像USB设备一样,你可以直接插入电脑就能使用,IVM的设计目标也是为了能够轻松地“插入”到其他系统中,并立即提升它们在遵循复杂指令、对齐文本与图像相关区域方面的性能。它提供了一种模块化的增强能力。

-

用于优先训练高质量数据样本的IVM是什么意思? (What does “IVM training that prioritizes high-quality data samples” mean?)

这句话与上面解释的DWSL直接相关。它指的是在训练指令引导视觉遮蔽(IVM)模型本身的过程中,采用一种策略(即DWSL技术)来侧重于那些被认为是“高质量”的训练数据。

- 高质量数据样本可能指的是那些图像清晰、指令明确、视觉遮蔽信息准确无误、或者能更好地帮助模型学习指令与视觉内容之间关联性的数据。

- 优先训练意味着通过DWSL这类机制,让这些高质量的样本在IVM模型的参数更新中占据更大的影响力。这样做的好处是,可以使IVM模型学习得更有效、更鲁棒,避免受到低质量或噪声数据的不良影响,从而最终提升IVM辅助其他多模态模型时的整体性能。

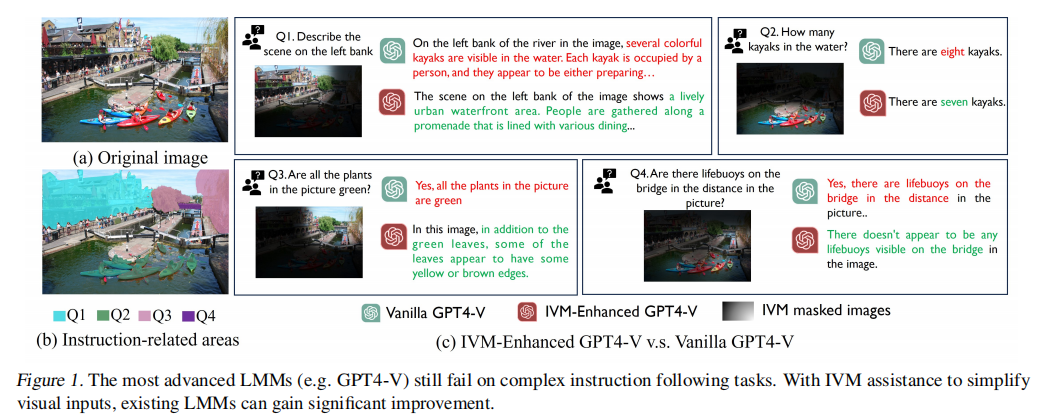

这张图的主要目的是通过具体示例,展示即便是先进的大型多模态模型(LMMs),如GPT-4V,在处理复杂的、需要精确理解指令并定位图像内容的任务时也可能表现不佳,而通过指令引导视觉遮蔽(IVM)的辅助,这些模型的性能可以得到显著提升。

-

(a)Original Image (原始图像):

首先呈现了一张原始的场景照片,包含河流、皮划艇、岸边建筑、植被和行人等元素。这是所有后续提问和分析的视觉基础。 -

(b)Instruction-related areas (与指令相关的区域):

这部分在原始图像上用不同的区域覆盖方式,标示出了与后续四个具体问题(Q1至Q4)分别对应的图像关键区域。每一块被特别标示的区域都代表了该问题指令在视觉上需要关注的重点范围。例如,针对描述左岸场景的指令(Q1),图中标示了左岸的相应范围;针对询问皮划艇数量的指令(Q2),图中标示了水面上的皮划艇区域,依此类推。 -

(c)IVM-Enhanced GPT-4V v.s. Vanilla GPT-4V (IVM增强的GPT-4V 对比 原版GPT-4V):

这是图的核心部分,通过四个具体的问答实例(Q1-Q4)进行对比:- Q1 (描述左岸场景): 原版GPT-4V的回答可能未能准确聚焦于“岸上”的宏观场景,而IVM增强后的GPT-4V则能更准确地描述岸边的环境和活动。

- Q2 (水中皮划艇数量): 原版GPT-4V可能给出错误的计数,而IVM增强后的GPT-4V给出了更准确的数量。

- Q3 (图中植物是否都为绿色): 原版GPT-4V可能给出过于笼统或不完全正确的判断,而IVM增强后的GPT-4V能注意到更多细节,如叶片颜色的细微变化。

- Q4 (远处桥上是否有救生圈): 原版GPT-4V可能错误地肯定或否定,而IVM增强后的GPT-4V则能给出更符合图像实际情况的、可能也更谨慎的判断。

在每个对比案例中,原版模型的回答(标记为 “Vanilla GPT-4V”)显示出在没有帮助时,可能难以精确地将指令与图像的正确部分关联起来,或在细节观察上有所欠缺。相比之下,经过IVM增强的模型(标记为 “IVM-Enhanced GPT-4V”)给出的答案则更为准确、细致,更贴合指令的真实意图。

这张图清晰地阐释了IVM的核心思想主要包括以下几点:

- 识别指令相关的视觉区域: IVM的关键作用在于,它能够根据给定的文本指令,在复杂的视觉场景中识别并定位出与该指令最相关的特定区域。如图(b)所示,不同的指令会对应图像中不同的重点区域。

- 简化视觉输入/引导注意力: 通过某种机制(在IVM中是“视觉遮蔽”,即可能遮蔽掉不相关的区域,或高亮相关区域),IVM有效地“简化”了呈现给后续大型多模态模型的视觉信息。这使得模型不必在整个复杂的图像中漫无目的地搜索,而是可以将注意力集中在最关键的部分。

- 提升指令遵循的准确性和深度: 当LMM的注意力被引导到正确的、与指令紧密相关的图像区域后,它就能更好地理解指令的意图,进行更精确的视觉信息提取和分析,从而在诸如特定区域描述、物体计数、属性判断等复杂指令遵循任务上表现得更好。如图©的对比所示,经过IVM辅助的模型在回答的准确性和细节程度上都有显著提升。

图下方的标题也总结了这一点:“The most advanced LMMs (e.g. GPT-4V) still fail on complex instruction following tasks. With IVM assistance to simplify visual inputs, existing LMMs can gain significant improvement.” (即便是最先进的大型多模态模型,在复杂的指令遵循任务上仍会失败。通过IVM辅助简化视觉输入,现有的大型多模态模型可以获得显著的改进。)

因此,这张图通过具体案例有力地证明了IVM的核心价值在于通过智能地识别并突出与文本指令相关的图像区域,来引导和增强大型多模态模型对复杂视觉语言任务的理解和执行能力。

这张图清晰地传达了以下信息:

- 即使是当前顶尖的LMM,在面对需要精确视觉定位和理解复杂指令的任务时,其能力仍有提升空间,可能会出现理解偏差或观察不够细致的问题。

- IVM技术通过帮助模型聚焦于图像中的指令相关区域(即“简化视觉输入”),能够有效地引导LMM更准确地理解指令、关注正确的视觉内容,并给出更精确、细致的回答,从而显著改善其在复杂指令遵循任务上的表现。

之所以说指令引导视觉遮蔽(Instruction-guided Visual Masking, IVM)是一个“即插即用(plug-and-play)”的工具,主要基于以下几点:

-

高度的兼容性: 摘要中明确提到IVM是“一种新的、通用的视觉基础模型,与各种多模态模型兼容,例如大型多模态模型(LMM)和机器人模型。” 这意味着IVM并非为一个特定的模型或架构设计,而是可以灵活地配合多种现有的、不同的多模态系统使用。

-

作为增强模块运作: 文中提到 “ IVM增强的(IVM-enhanced) 多模态模型可以有效地关注任务相关的图像区域”。这表明IVM是作为一个外部模块或组件被整合进现有多模态模型中,以增强这些模型原有能力的,而不是要求从头构建一个全新的、包含IVM功能的模型。

-

提升现有模型性能: 摘要强调“它(IVM)作为一个即插即用的工具,显著提升了各种多模态模型的性能”。这说明将IVM整合到现有系统中,可以直接带来性能上的好处,而不需要对现有系统进行根本性的重构。其作用方式是帮助这些模型更好地处理视觉信息与文本指令的对齐。

-

提供特定功能(视觉基础/遮蔽): IVM的核心功能是“通过为指令无关区域构建视觉遮蔽”,使模型能“有效地关注任务相关的图像区域”。这种提供特定、清晰功能(视觉遮蔽以引导注意力)的方式,使得它可以作为一个“工具”被其他需要此功能的模型所调用和利用。

“即插即用”意味着IVM被设计成一个相对独立、易于集成、并且能够为多种现有系统带来明确性能提升的模块化解决方案。开发者可以将IVM模块“插入”到他们现有的多模态模型中,以增强模型在复杂指令下对图像特定区域的理解和关注能力,而无需对原有模型进行修改。