深度学习让鱼与熊掌兼得

通常,一个大的复杂的模型的loss会低,但是拟合方面不够,小的模型在拟合方面更好,但是loss高,我们可以通过深度学习来得到一个有着低loss的小模型

我们之前学过,peacewise linear可以用常数加上一堆这个阶梯型函数得到,然后因为peacewise linear可以逼近任何function,所以理论上,用neural network可以实现任何function

所以有人说只要neuron足够多,一层network就可以了,那我们就应该通过矮胖model和高瘦model来对比,看看怎么回事

结果是这样的,这证明同样参数量的时候,深的模型会更好,也更有效率

为什么多层会带来好处?

用逻辑电路是这样子的

在做程序的时候

剪窗花

接下来解释为什么深度比宽度好

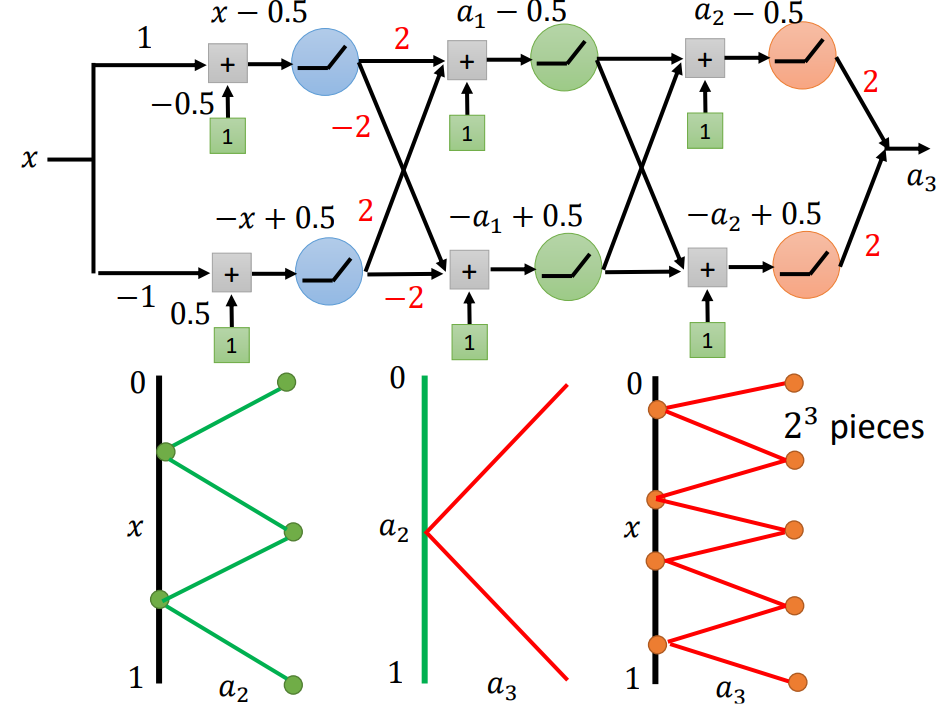

第二层是这样子的一个关系,那么第三层是什么样的关系呢

于是我们可以发现,这是dimension上的差别,neuron数量之间有极大差距,也可以这么说,实现同一个function,shallow的model更复杂,也就更容易overfitting

所以,深度学习是一个鱼与熊掌兼得的方法