【论文阅读】Reconstructive Neuron Pruning for Backdoor Defense

我们的主要贡献包括:

- 我们引入了在相同样本集上进行神经元“遗忘”和“恢复”的新技术,并揭示了这种简单的基于重构的学习过程可以帮助暴露DNNs中的后门神经元。

- 我们提出了一个新的防御方法——重构神经元剪枝(RNP),它通过在神经元级别进行“遗忘”,然后在过滤器级别进行“恢复”,利用少量干净样本检测和剪枝后门神经元。

- 我们通过实验证明,RNP在对抗12种先进后门攻击方面显著优于现有的后门防御方法,并且“遗忘”模型可以用于触发器恢复、后门标签检测和后门样本检测。

我们提出了一种名为“重构神经元剪枝”(Reconstructive Neuron Pruning,RNP)的新方法,通过“遗忘”和“恢复”神经元的过程来暴露和剪枝后门神经元。具体而言,给定一个被后门攻击的模型,RNP首先通过梯度上升最大化模型在干净样本上的误差来“遗忘”模型,然后通过最小化模型在相同样本上的误差来“恢复”(重新学习)神经元。有趣的是,我们发现,如果“遗忘”在神经元级别进行,而“恢复”在过滤器级别进行,那么网络倾向于重新定位后门神经元,以补偿因“遗忘”而失去的干净特征造成的损失。这种不对称操作可以非常有效地仅使用少量干净样本(例如,对于CIFAR-10数据集的500张图像)来定位后门神经元。然后可以从网络中轻松剪枝这些后门神经元。

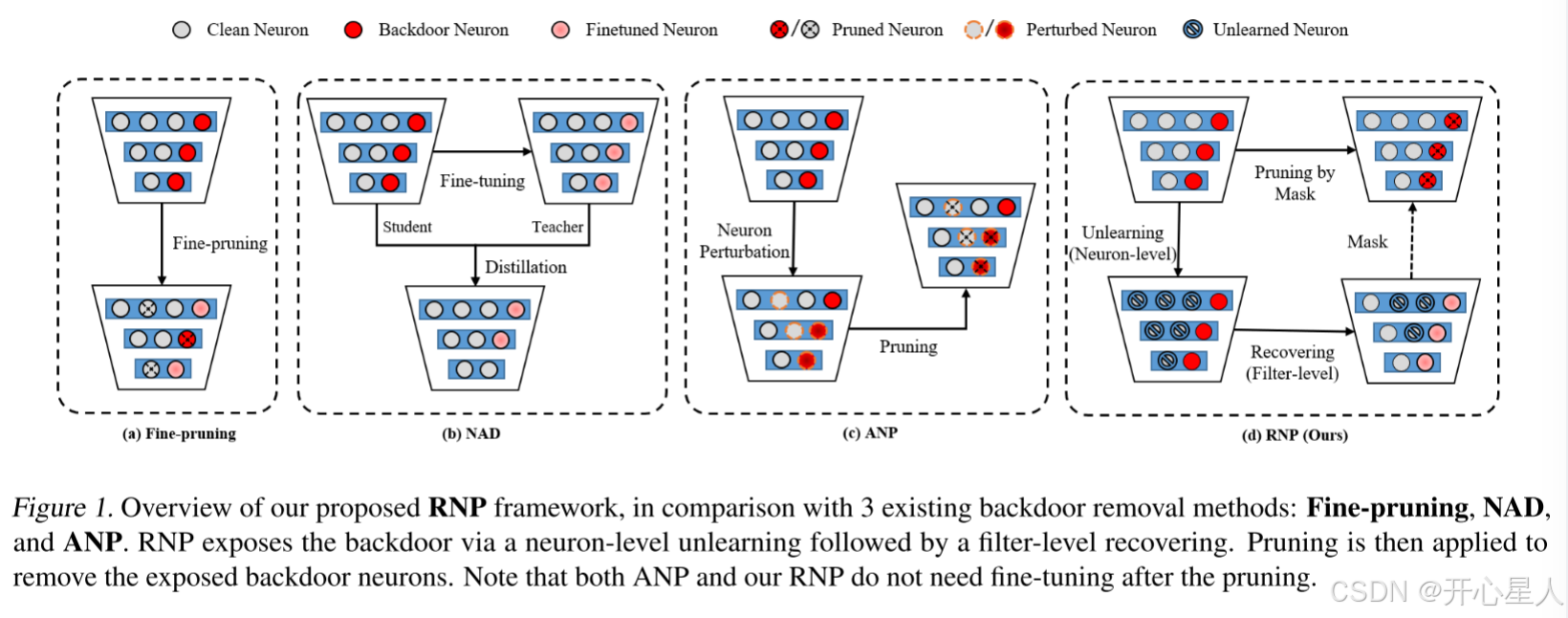

图1展示了我们提出的RNP防御方法。RNP的核心是一个重构学习过程,首先通过神经元遗忘(Neuron Unlearning,NU)在防御数据上遗忘神经元,然后通过滤波器恢复(Filter Recovering,FR)在相同数据上恢复神经元。由于防御数据是干净的,NU倾向于主要遗忘干净神经元,即与干净特征相关的神经元。与后门特征相关的后门神经元在遗忘后的模型中被大量保留。因此,遗忘后的模型可以用于改进其他分析,例如触发器恢复、后门标签检测和后门样本检测。

图1还展示了现有方法(Fine-pruning、NAD和ANP)的机制,以便进行比较。Fine-pruning是一种传统的剪枝方法,从被后门攻击的模型中剪枝那些小范数的神经元,而NAD(Li等人,2021c)采用微调后的模型作为教师来蒸馏被后门攻击模型的神经元。ANP(Wu & Wang,2021)利用对抗性扰动来寻找对对抗性扰动更敏感的神经元作为后门神经元。与ANP使用的对抗性扰动技术相比,我们的RNP通过不对称的遗忘和恢复过程,暴露更多与后门相关的神经元,并在剪枝步骤中实现更好的后门净化。

剪枝(Pruning):滤波器掩码mκ中的所有元素都初始化为1,并在恢复过程中被限制在[0, 1]范围内。恢复后,mκ中接近零的低值表明滤波器(及其相关神经元)主要包含被重用的神经元,这些神经元很可能是与后门相关的。因此,可以剪枝这些神经元以净化被后门攻击的模型。如图2所示,在恢复后的模型中,与触发器模式相关的激活显著减少(掩码值几乎降至零),而干净特征的激活显著增强(由于剪枝操作,掩码值保持接近1)。