DeepSeek 本地部署方法介绍

目录

前言

一、DeepSeek版本与硬件配置

硬件选择建议:

二、版本选择指南

确认电脑硬件配置

三、多操作系统部署方法

1. Windows系统部署(以Ollama为例)

步骤1:安装Ollama

步骤2:下载模型

步骤3:与模型交互

步骤4:配置交互界面(可选)

2. macOS 系统部署

3. Linux 系统部署

四、 断网环境部署

五、验证

前言

DeepSeek 是一系列基于深度学习的语言模型,适用于各种自然语言处理任务。本文档旨在指导用户根据自己的硬件配置和需求选择合适的 DeepSeek 版本,并详细介绍如何在不同的操作系统上进行本地部署。

一、DeepSeek版本与硬件配置

DeepSeek提供多个模型版本,覆盖从轻量级到专业级需求。以下是各版本的最低配置与推荐配置:

1. DeepSeek各版本最低硬件配置表

| 模型版本 | 最低配置 | 推荐配置 | 适用场景示例与适用行业 |

|---|---|---|---|

| 1.5B | |||

| CPU: 4核 (Intel i5-8代或AMD Ryzen 5 2600) | GPU: NVIDIA RTX 3060 (可选) | 日常问答、文本生成、简单代码调试 - 教育、小型客服系统 | |

| 内存: 8GB | 内存: 16GB | ||

| 存储: 3GB | 存储: 10GB | ||

| 7B/8B | |||

| CPU: 8核 | GPU: RTX 4080 (16GB显存) | 中等负载任务(代码生成、数据分析、多语言翻译) - 媒体、内容创作、中型客服系统 | |

| 内存: 16GB | 内存: 32GB | ||

| GPU: RTX 3060 (8GB显存) | 存储: 50GB | ||

| 存储: 8GB | |||

| 14B | |||

| CPU: 8核以上 | GPU: RTX 3080 (10GB显存) | 高级语言理解、长篇文本生成、高级推理 - 科研、专业翻译服务 | |

| 内存: 32GB | 内存: 64GB | ||

| 存储: 16GB | 存储: 50GB | ||

| 32B/70B | |||

| GPU: NVIDIA A100/H100 (24GB+显存) | GPU: RTX 4090/A100 (显存≥40GB) | 复杂推理(科学计算、大规模知识库管理、专业级AI应用) - 法律咨询、医疗信息处理 | |

| 内存: 64GB | 内存: 128GB | ||

| 存储: 200GB | 存储: 500GB (PCIe 5.0 SSD) | ||

| 满血版671B | |||

| 专业服务器(双H100 80G GPU、1TB内存、NVMe SSD) | 仅限企业级服务器部署 | 超大规模AI训练与推理(需云端或高性能计算中心支持) - 企业级AI解决方案 |

2 .硬件选择建议

-

显存:每10B参数约需1GB显存(量化后)。例如,70B模型需至少16GB显存8。

-

硬盘:推荐PCIe 4.0/5.0 NVMe SSD,提升模型加载速度(如致态TiPro9000)8。

-

内存:建议为模型大小的1.5倍(如70B模型需至少64GB内存)

二、版本选择指南

用户可根据以下条件选择适合的模型版本:

-

任务复杂度:

-

1.5B-7B:适合个人开发者或教育用途(如简单代码生成、文档翻译)。

-

32B-70B:适用于企业级AI开发(如药物分子模拟、金融预测)。

-

-

硬件性能:

-

显存不足:选择量化版(如Ollama支持的GGUF格式)或小参数模型。

-

高性能GPU:优先部署32B/70B版本以发挥硬件潜力。

-

-

数据安全性:

-

敏感数据需本地部署蒸馏版模型(如R1-distill),避免云端传输风险。

-

确认电脑硬件配置

- Windows:通过

Win + R-> 输入msinfo32或使用任务管理器查看。

- macOS:点击苹果图标 -> 关于本机 -> 系统报告。

- Linux:使用命令行工具如

lscpu或cat /proc/cpuinfo查看CPU等信息。

三、多操作系统部署方法

1. Windows系统部署(以Ollama为例)

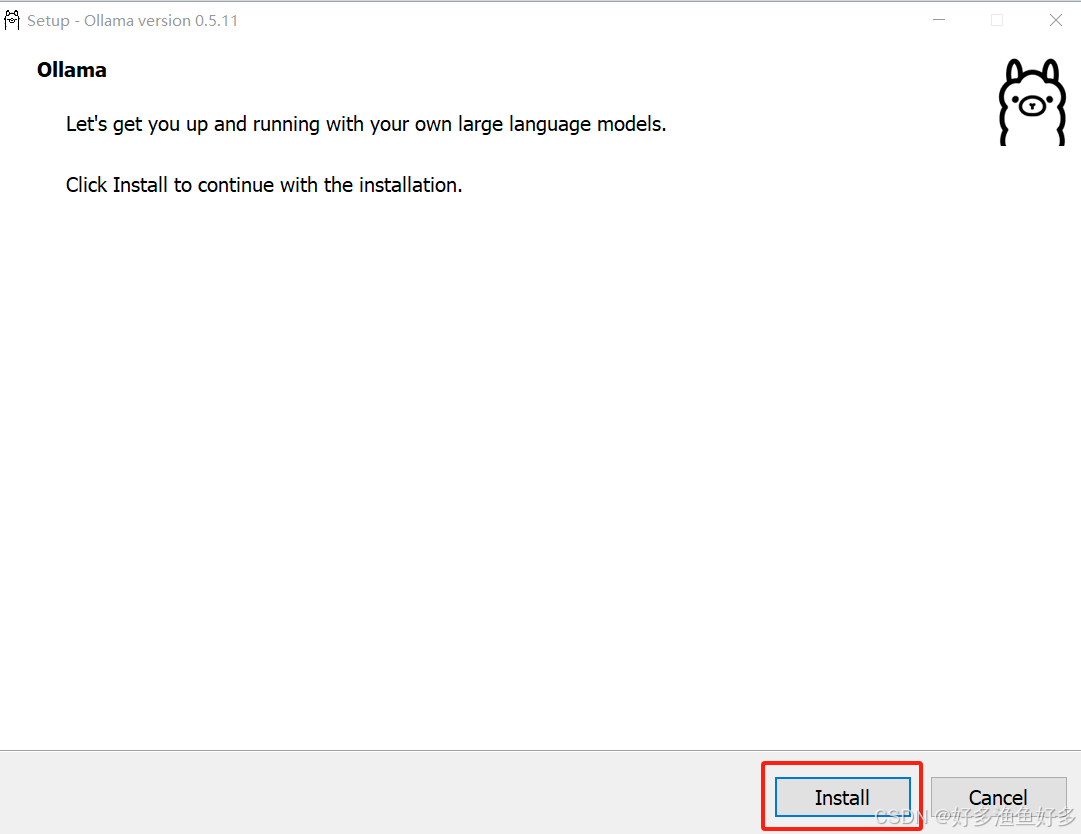

步骤1:安装Ollama

-

访问Ollama官网,下载Windows安装包并运行。

-

验证安装:

-

命令行输入

ollama --version,输出版本号即成功。

步骤2:下载模型

- 选择DeepSeek模型:

在Ollama官网上查找DeepSeek-R1模型的不同参数版本(如1.5b, 7b等),根据你的硬件条件选择合适的版本。

- 下载:

打开命令行工具(在Windows上可以是PowerShell,在MacOS或Linux上则是终端)。

输入相应的命令来安装你所选的DeepSeek模型。例如,如果你选择了1.5b版本,则输入ollama run deepseek-r1:1.5b并回车等待下载。

等待模型下载并自动安装完成。

步骤3:与模型交互

下载完成后,你就可以通过命令行与DeepSeek模型进行对话了。比如,你可以输入一个问题然后等待模型的回答。

步骤4:配置交互界面(可选)

-

安装Chatbox,选择“Ollama API”,设置地址为

http://localhost:11434

2. macOS 系统部署

- 解压下载的DeepSeek版本到应用程序目录。

- 使用终端进入解压目录。

- 安装所需的Python库:

pip install -r requirements.txt - 运行

./deepseek serve启动服务。

3. Linux 系统部署

- 解压DeepSeek版本到/home/user/deepseek/目录下。

- 终端内执行

sudo apt-get update && sudo apt-get install python3-pip确保pip已安装。 - 切换到解压目录后执行

pip3 install -r requirements.txt安装依赖。 - 最后运行

python3 deepseek serve以启动服务。

四、 断网环境部署

-

下载模型文件(如GGUF格式)并保存至本地目录(如

D:\deepseekmodel)。 -

创建

Modelfile文件,内容为FROM D:\deepseekmodel\DeepSeek-R1-7B-Q4_K_M.gguf。 -

生成模型:ollama create DeepSeek-R1-7B -f D:\deepseekmodel\Modelfile