【AI】ragflow + ollama + deepseek-r1本地部署后的配置 目的:给AI大模型输入知识,代替模型微调工作

前提:

ragflow、ollama以及模型deepseek-r1已经本地部署完毕

配置ragflow模型提供商

添加对话模型

依次点击头像,模型提供商,ollama(添加模型链接)

1. 选择chat模型

2. 模型名称从指令获取,不要写错,参考如下

yeqiang@yeqiang-Default-string:/data/src/ragflow/docker$ ollama list

NAME ID SIZE MODIFIED

deepseek-r1:14b ea35dfe18182 9.0 GB 3 hours ago

codegeex4:9b-all-q8_0 9e5f03438298 10.0 GB 4 hours ago

3. 配置uri:http://192.168.1.3:11434/

模型列表多出来本地ollama

系统模型设置

点击右上角系统模型设置,设置聊天模型后发现嵌入模型是空的。。。

添加嵌入模型

修改代码.env文件

让ragflow下载嵌入模型

差异如下:

重新部署

又开始等待

当前可设置的模型情况

先这样吧,暂时不管图片识别这些东西,看看效果

创建知识库

选择中文,其他的都默认

保存后,新增文件,选择《大话设计模式》

开始![]() 解析

解析

哦豁,没有启用gpu加速

算了,下次一定

继续等待

成功解析

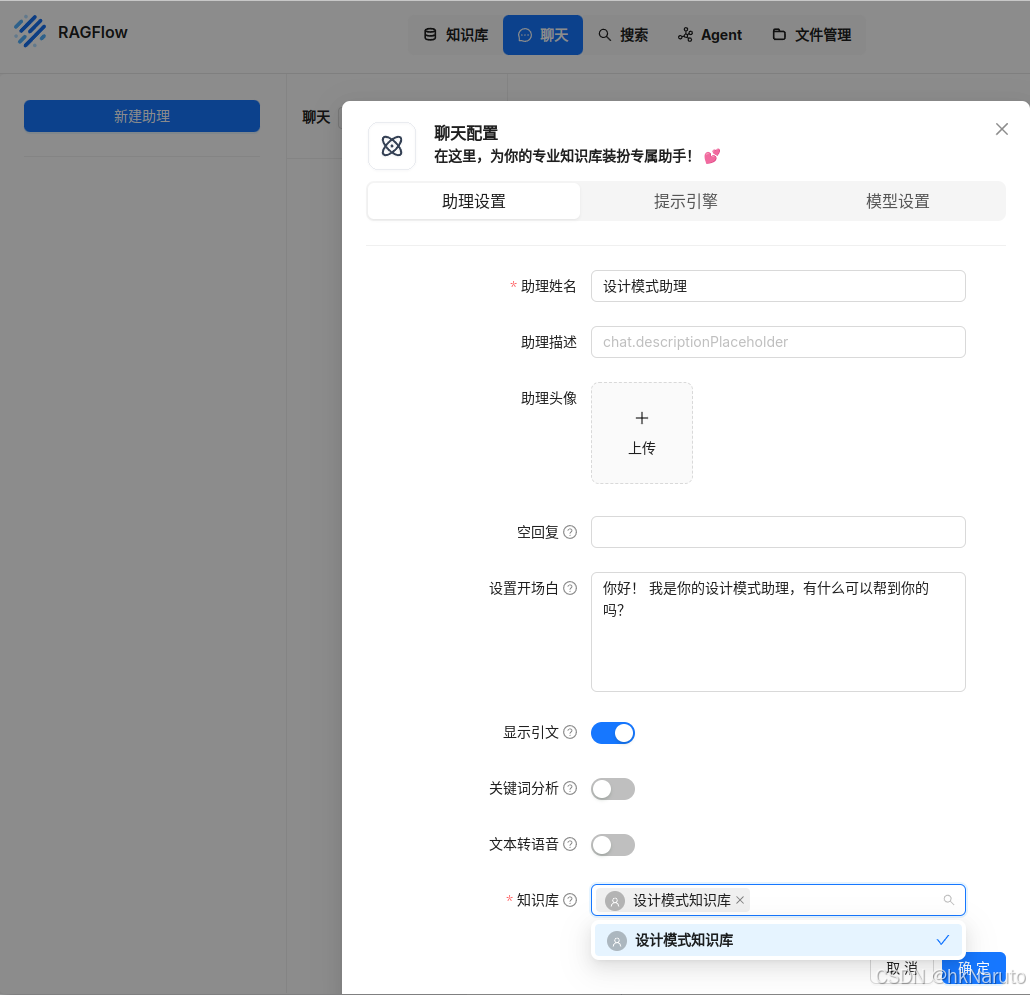

聊天

创建助理

选择知识库

提示引擎,默认

调整下最大token

开始聊天

测试根据文中内容提问。

找到一段内容

提问

“小菜到底如何去改良策略模式呢?”

此时,GPU正常工作。

完整的响应:

对应书中的代码

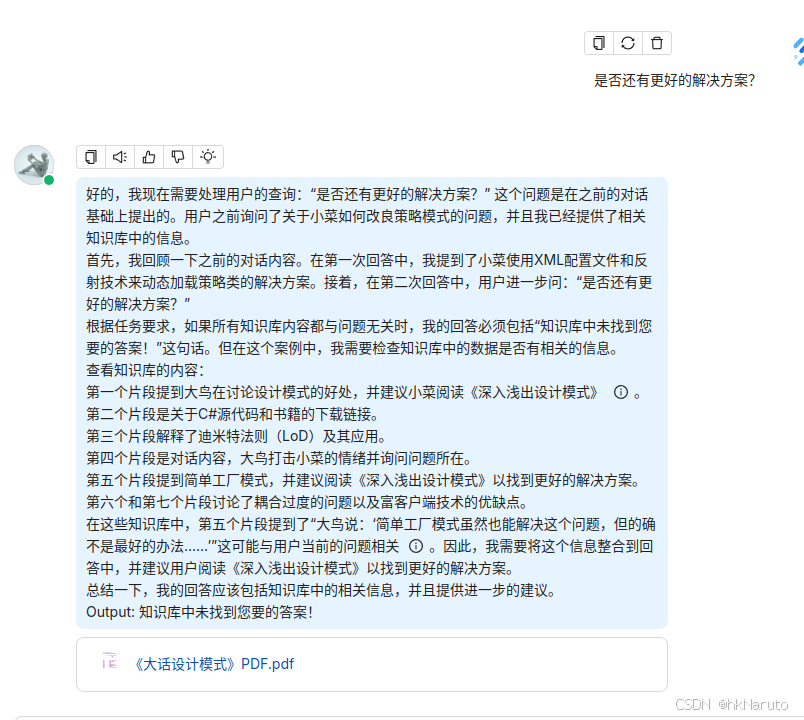

继续提问

是否还有更好的解决方案?

由于前面的提示词内容是:

你是一个智能助手,请总结知识库的内容来回答问题,请列举知识库中的数据详细回答。当所有知识库内容都与问题无关时,你的回答必须包括“知识库中未找到您要的答案!”这句话。回答需要考虑聊天历史。

以下是知识库:

{knowledge}

以上是知识库。

可以看到,助理根据之前的提示词设置,直接返回来未找到答案,这点可以通过调整提示词来让AI输出它的答案。后面再借助DeepSeek生成一个更合适的提示词来尝试。