论文笔记——QWen2.5 VL

目录

- 引言

- 架构创新

- 数据整理与训练策略

- 性能与基准测试

- 精细感知能力

- 应用与现实世界影响

- 与现有模型比较

- 结论

引言

视觉理解和自然语言处理的集成一直是人工智能研究的一个重要焦点,促成了日益复杂的视觉语言模型 (VLMs) 的发展。由阿里巴巴集团 Qwen 团队开发的 Qwen2.5-VL 代表了该领域的重大进步,尤其侧重于增强精细感知能力。

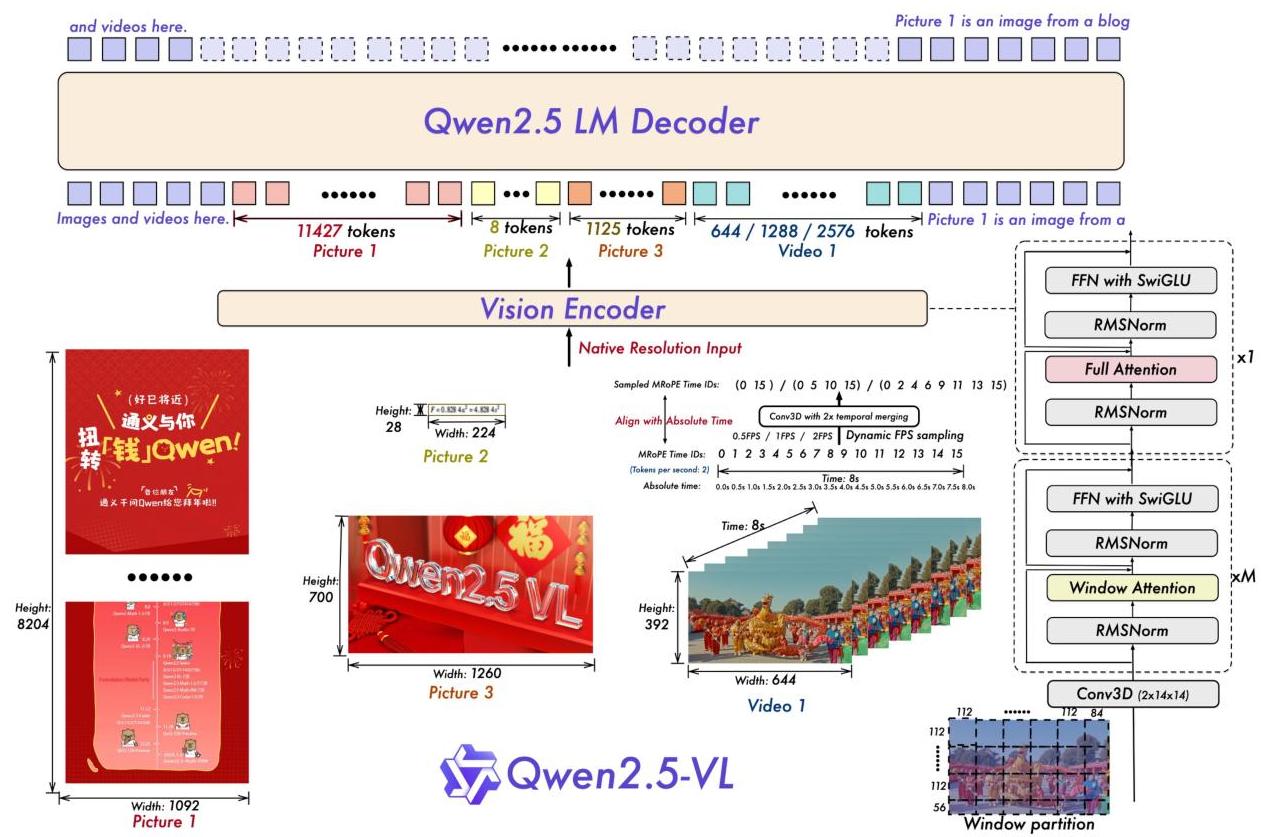

图 1:Qwen2.5-VL 架构,展示了视觉编码器与 Qwen2.5 LM 解码器的集成,突出了原生分辨率输入处理和视频的动态 FPS 采样。

虽然最近的多模态大型语言模型在各种任务中都表现出了令人印象深刻的能力,但它们在卓越性能方面通常表现不足,尤其是在需要详细视觉理解和复杂推理的领域。Qwen2.5-VL 通过专注于研究人员认为的强大视觉语言模型的“基础层”来解决这些限制:精细感知。

该模型建立在 Qwen 系列前辈的优势之上,同时引入了重大的架构改进和训练方法。作为对 AI 社区的开源贡献,Qwen2.5-VL 不仅旨在推进视觉语言理解的最新技术水平,而且还为从事实际应用的的研究人员和开发人员提供宝贵的资源。

架构创新

Qwen2.5-VL 引入了几项关键的架构创新,使其与之前的模型区分开来,并使其能够增强功能:

重新设计的视觉转换器 (ViT)

Qwen2.5-VL 中的视觉编码器采用了一种完全重新设计的视觉转换器,具有以下几个重要的修改:

-

窗口注意力机制:在大多数层中实现,以降低计算复杂性并实现随图像块数量线性缩放。这种方法允许模型更有效地处理高分辨率图像。

-

2D 旋转位置嵌入 (RoPE):与传统的位置嵌入不同,2D RoPE 捕获二维空间中的空间关系,从而增强了模型对视觉布局和空间排列的理解。

-

归一化和激活:该模型采用 RMSNorm 进行归一化,采用 SwiGLU 作为激活函数,从而提高了计算效率和与底层语言模型的兼容性。

2D RoPE 的数学公式可以表示为:

(cos(mθi,j)−sin(mθi,j)sin(mθi,j)cos(mθi,j))(qmqm+d/2)(cos(mθi,j)sin(mθi,j)−sin(mθi,j)cos(mθi,j))(qmqm+d/2)

其中 (i,j)(i,j) 表示图块的二维位置,θi,jθi,j 是对应的角频率。

原生动态分辨率处理

Qwen2.5-VL 最重要的创新之一是它能够处理不同尺寸的图像和具有可变帧率的视频,而无需依赖传统的归一化技术。这是通过以下方式实现的:

- 以其原生分辨率直接处理图像

- 基于输入尺寸的动态窗口分区

- 绝对时间编码,将时间 ID 与视频处理的时间戳对齐

对于视频处理,该模型实现了一种动态帧率采样方法,其中:

# 动态FPS采样伪代码

def sample_frames(video, target_fps=None):if target_fps is None:# 基于视频内容的自适应采样target_fps = determine_optimal_fps(video)timestamps = np.arange(0, video.duration, 1/target_fps)sampled_frames = [video.get_frame(t) for t in timestamps]return sampled_frames, timestamps

跨模态整合

视觉和语言组件通过一个基于MLP的视觉-语言融合器连接,该融合器有效地将视觉特征投影到语言模型的嵌入空间中。这种方法在保持两种模态完整性的同时,实现了无缝集成。

数据整理和训练策略

Qwen2.5-VL成功的根本在于其细致的数据整理和全面的训练方法:

数据规模和多样性

预训练语料库从1.2万亿扩展到惊人的4.1万亿tokens,包括:

- 交错的图像-文本数据: 经过仔细评分和清理,以确保质量

- 定位数据: 包括用于空间推理的绝对位置坐标

- 文档数据: 结构化的HTML格式,用于文档理解

- OCR数据: 来自不同来源和语言,以增强图像中的文本识别

- 视频数据: 具有动态FPS采样和详细字幕

- Agent数据: 带有UI元素注释的屏幕截图,用于交互式应用程序

多阶段训练方案

训练过程遵循一个复杂的三阶段方法:

- 第一阶段: 专注于使用图像-文本配对数据的基本视觉理解

- 第二阶段: 引入更复杂的数据类型和任务,包括文档理解

- 第三阶段: 集成用于定位、Agent能力和视频理解的专门数据

为了优化计算效率,数据样本根据其相应的输入序列长度进行打包,以确保训练期间一致的计算负载。

训练后对齐

在主要训练阶段之后,Qwen2.5-VL 经历了:

- 监督式微调 (SFT):以增强指令遵循能力

- 直接偏好优化 (DPO):使模型与人类偏好和期望保持一致

这种全面的训练策略使 Qwen2.5-VL 能够在各种任务中实现卓越的性能,同时保持连贯且上下文相关的响应。

性能和基准

Qwen2.5-VL 在各种基准测试中表现出卓越的性能,使其成为视觉语言模型领域的领先竞争者:

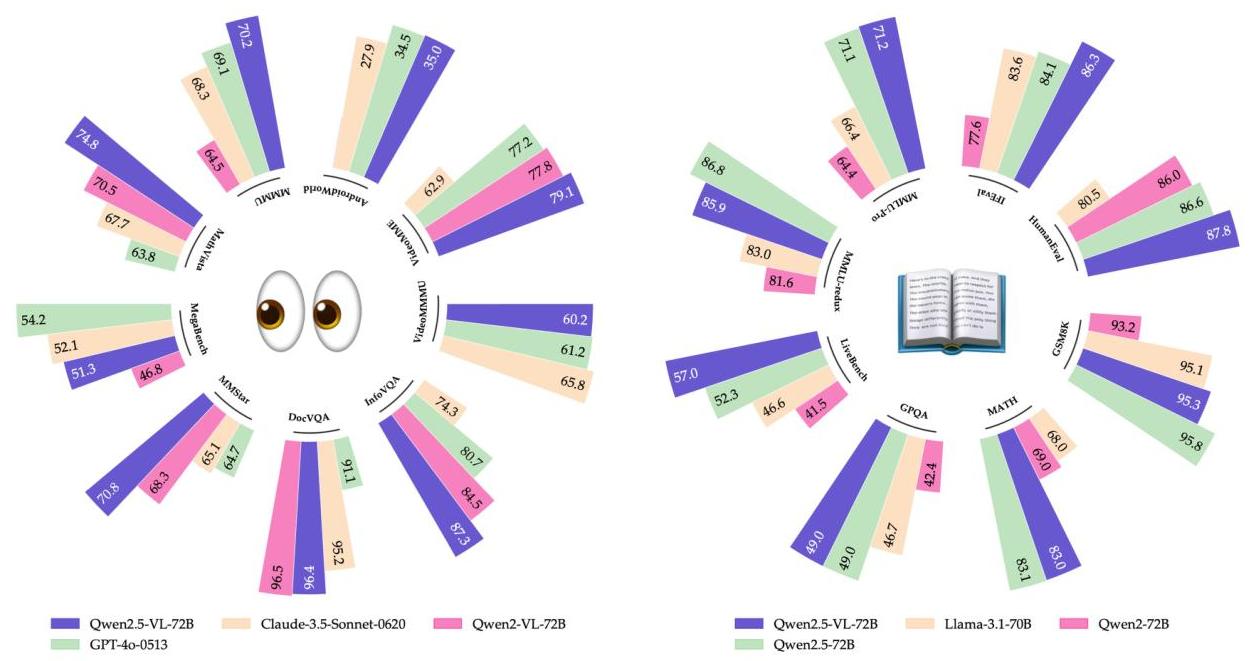

图 2:基准比较显示了 Qwen2.5-VL-72B 在各种任务中与其他领先模型(包括 GPT-4o、Claude-3.5-Sonnet 和之前的 Qwen 模型)的性能比较。

学术和复杂推理任务

- MMMU 和 MMMU-Pro:该模型擅长大学水平的问题,表现出强大的推理能力。

- MathVista、MATH-Vision、MathVerse:在数学相关任务中表现出色,表明该模型能够处理和推理视觉环境中的数学概念。

通用视觉理解

- MegaBench:对各种视觉任务的综合评估

- MMBench 系列:在多语言视觉问答中表现出色

- MuirBench 和 BLINK:展示了强大的通用视觉理解能力

文档理解和 OCR

该模型在以下方面表现出特别强大的能力:

- AI2D:图表解释

- TextVQA 和 DocVQA:文档中的文本识别和理解

- InfoVQA、ChartQA、OCRBench:专门的文档分析任务

空间理解和定位

Qwen2.5-VL 在以下方面展现了令人印象深刻的空间推理能力:

- RefCOCO: 通过自然语言进行对象指代

- ODinW: 多样化语境下的对象检测

- PointGrounding: 精确的空间定位

- CountBench: 场景中对象的准确计数

视频理解

该模型在以下方面展示了强大的时间推理能力:

- Video-MME 和 Video-MMMU: 通用视频理解

- LVBench: 长视频理解

- Charades-STA: 动作识别和时间定位

细粒度感知能力

Qwen2.5-VL 的核心进步在于其细粒度感知能力,这是其在各种任务中表现的基础:

框和点定位

该模型可以精确地定位和识别图像中的特定区域或点,从而实现:

- 图像组件的详细分析

- 指代理解(“左边的红色物体”)

- 对空间关系进行视觉推理

文档结构理解

Qwen2.5-VL 可以理解复杂的文档结构,包括:

- 具有复杂布局的表格

- 包含数值数据的图表

- 具有各种字段和注释的表单

多层次视觉推理

该模型展示了以下能力:

- 提取低级视觉特征(颜色、形状、纹理)

- 识别中级模式和对象

- 对关系和含义进行高级推理

这种分层理解使 Qwen2.5-VL 能够处理复杂的视觉推理任务,这些任务需要详细的感知和抽象思维。

应用和实际影响

Qwen2.5-VL 增强的功能开启了众多实际应用:

文档处理和分析

该模型强大的 OCR 和文档理解能力使其适用于:

- 自动文档分类

- 从表单和发票中提取信息

- 合同分析和合规性检查

交互式代理和 UI 导航

凭借其在以下基准测试中展示的代理能力:

- ScreenSpot: UI 元素识别

- Android Control: 移动界面导航

- OSWorld: 操作系统交互

Qwen2.5-VL 可以为能够与用户界面交互的虚拟助手提供支持,从而可能彻底改变辅助功能工具和自动化系统。

教育应用

该模型在学术基准测试中的表现表明其在以下方面具有应用前景:

- 交互式辅导系统

- 视觉作业的自动评分

- 创建具有视觉解释的教育内容

内容分析和创作

Qwen2.5-VL 可以协助:

- 视觉内容审核

- 基于详细描述的图像和视频搜索

- 使用精确的视觉规格进行创意内容生成

与现有模型的比较

Qwen2.5-VL 在开源和闭源模型中都具有竞争优势:

对比闭源模型

旗舰版 Qwen2.5-VL-72B 模型在多个基准测试中实现了与顶级闭源模型(如 GPT-4o 和 Claude 3.5 Sonnet)相当甚至超越的性能。考虑到以下几点,这一点尤其令人印象深刻:

- 闭源模型通常具有更大的资源和专有优势

- Qwen2.5-VL 的透明方法和可复制方法

- 模型权重和代码完全可用于研究目的

对比以前的开源模型

与以前的版本(Qwen2-VL)和其他开源 VLM 相比,Qwen2.5-VL 表现出显着改进:

- 更强大的细粒度感知

- 更好地处理可变分辨率输入

- 增强了在文档理解和空间推理等专业任务中的性能

可扩展性优势

规模较小的 Qwen2.5-VL-7B 和 Qwen2.5-VL-3B 模型优于同类竞争对手,即使在资源受限的环境中也提供强大的功能。这种可扩展性使该技术可在各种部署场景中使用,从边缘设备到云基础设施。

结论

Qwen2.5-VL 代表了视觉语言模型的重大进步,其主要贡献在于增强了细粒度感知能力。通过重新设计视觉编码器架构、实施原生动态分辨率处理以及采用精细的数据管理和训练策略,该模型在各种基准测试中均取得了显著的性能。

该模型理解文档、定位视觉元素、处理视频以及作为交互式代理的能力,使其成为众多实际应用的多功能工具。它在保持开源理念的同时,与闭源模型相比具有竞争力的性能,这为先进人工智能能力的民主化做出了重大贡献。

随着视觉语言模型的不断发展,Qwen2.5-VL 为未来的发展奠定了重要的原则,特别是在强调细粒度感知作为强大的多模态理解的基础方面。该模型的成功表明,有针对性的架构改进,结合周到的数据管理和训练策略,可以显著提高人工智能能力。

通过解决现有模型中的关键限制并为视觉语言理解提供全面的解决方案,Qwen2.5-VL 为更复杂的 AI 系统铺平了道路,这些系统能够以空前的细节和准确性感知和推理视觉世界。

——————————————————————————————

Qwen VL2.5 与 InternVL3 的OCR能力对比

以下从技术实现、多语言支持、结构化输出等维度总结二者的核心差异:

一、OCR技术特性对比

| 特性 | Qwen VL2.5 | InternVL3 |

|---|---|---|

| 动态分辨率支持 | 原生支持任意分辨率输入,无需分割图像块,保持图像信息完整性26 | 未明确提及动态分辨率设计,依赖传统预处理方法1 |

| 多语言OCR能力 | 支持任意方向、多语言文本识别(如中文、英文、日文等),文档理解能力突出36 | 通过原生多模态预训练提升整体文本性能,但未具体说明多语言覆盖范围18 |

| 结构化输出 | 支持发票、表格等结构化数据的高精度抽取与JSON格式输出,适配金融、商业场景36 | 未明确提及结构化输出能力,更侧重通用文本理解与幻觉抑制1 |

| 长文本解析 | 支持百万级Token长文档解析,精准还原版面格式(如PDF、表格)67 | 未提及长文本处理能力,主要聚焦多模态推理与工具交互1 |

二、性能表现差异

-

基准测试

- Qwen VL2.5:在OCRBenchV2评测中位列榜首,擅长图表解析与文档问答(如DocVQA)67。

- InternVL3:整体文本性能优于Qwen2.5系列,但在OCR专项评测中未公开具体排名1。

-

实际应用

- Qwen VL2.5:支持精准定位图像中的物体(如生成Bounding Boxes),适配安防、工业质检领域36。

- InternVL3:强调多模态联合推理能力,更适合复杂场景的图文混合任务(如GUI代理操作)1。

Qwen VL系列开源地址总结

以下是Qwen VL系列模型的官方开源仓库(截至2025年5月):

- Qwen2.5-VL系列(含3B/7B/72B):

- Hugging Face仓库:

https://huggingface.co/Qwen/Qwen2.5-VL36 - ModelScope仓库:

https://modelscope.cn/organization/qwen46

- Hugging Face仓库:

- 部署工具支持:

- 本地部署推荐使用

transformers库(需安装开发测试版)4,或通过vLLM、Ollama框架加速推理8。

- 本地部署推荐使用

总结:Qwen VL2.5在动态分辨率适配、多语言OCR、结构化数据抽取等场景表现更优,而InternVL3在整体文本理解与多模态联合推理上更具优势16。开发者可根据任务需求选择模型:

- 优先Qwen VL2.5:需高精度文档解析、工业级结构化输出的场景;

- 优先InternVL3:需复杂多模态交互(如GUI操作)或跨模态对齐的场景。