Windows11下本地化部署AI开发环境(Dify+Ollama)

前言

本次实践希望在Windows环境下本地化部署AI开发环境,通过Ollama下载运行模型,通过Dify搭建管理AI应用。

硬件环境

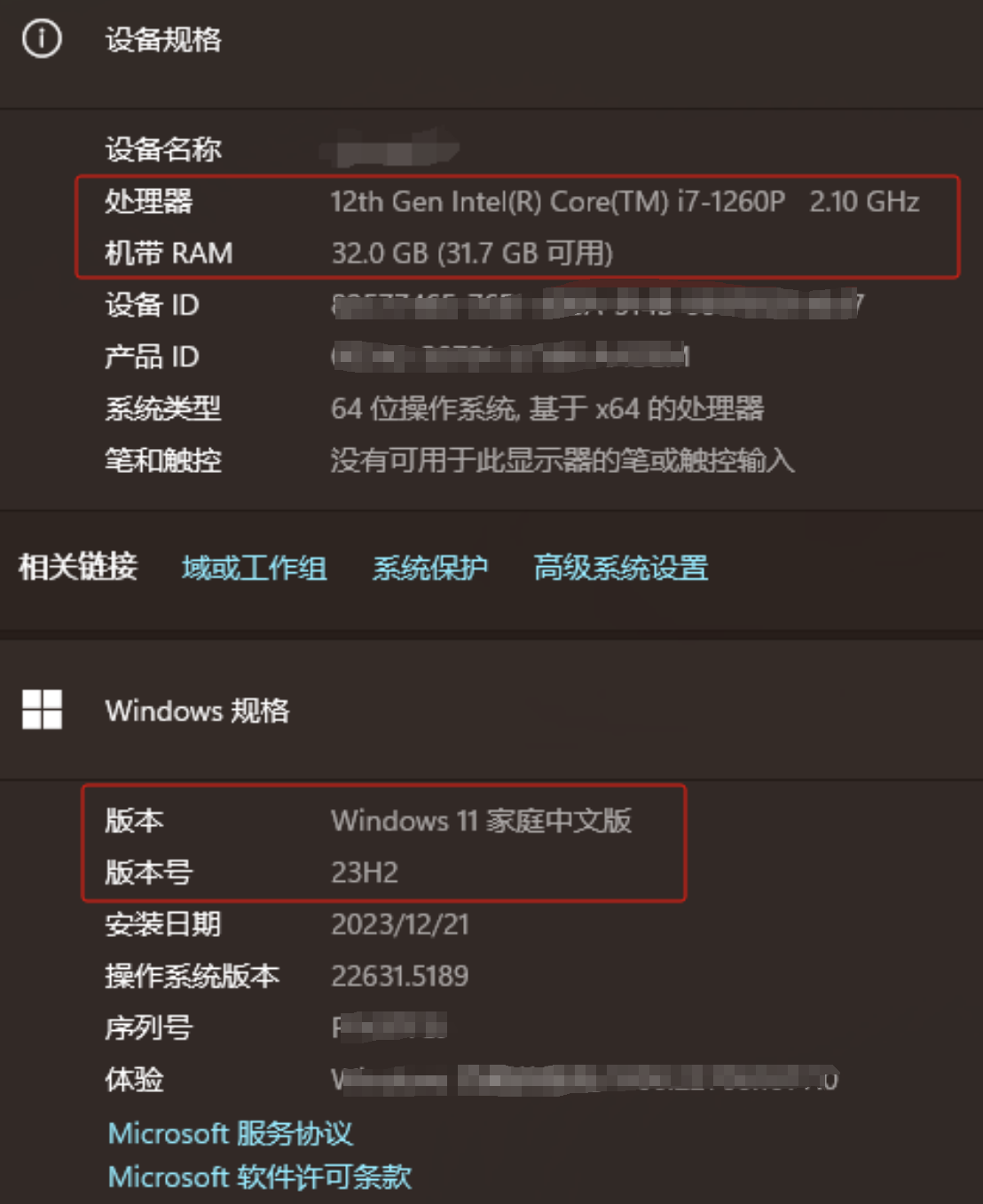

AI大模型开发对硬件要求较高,理论上配置越高越好。本次搭建环境如下:

Windows系统(Windows11)+ CPU(i7-1260P)+ 内存(32G)+ 硬盘(越大越好)

Docker安装及使用

Docker 是一个软件平台,让您可以快速构建、测试和部署应用程序。Docker 将软件打包成名为容器的标准化单元,这些单元具有运行软件所需的所有功能,包括库、系统工具、代码和运行时。

Windows系统下docker的安装及使用参考文章【Windows11安装Docker-CSDN博客】

Ollama安装及使用

ollama国内下载是一款开源的本地化大模型部署工具,用户可以一键轻松安装、配置和运行各种开源大模型。

Windows系统下Ollama的安装及使用参考文章【Windows下Ollama安装及使用-CSDN博客】

Dify安装及使用

Dify 是开源的 LLM 应用开发平台。提供从 Agent 构建到 AI workflow 编排、RAG 检索、模型管理等能力,轻松构建和运营生成式 AI 原生应用。

Windows系统下Dify的安装及使用参考文章【Windows下Dify安装及使用-CSDN博客】

Dify配置Ollama

Dify的大模型配置通过【设置】中的【模型供应商】进行配置。

Dify安装Ollama

找到Ollama,点击【安装】进行安装。

添加Ollama模型

模型名称

基础URL

Ollama在本地安装,Dify通过Docker容器安装,并不在同一个机器上,故不能用http://localhost:11434

应该用本地局域网的IP地址,http://192.168.43.32:11434

环境变量

设置完名称及URL后,点击保存报错。继续设置环境变量。

环境变量中添加系统变量 OLLAMA_HOST 值为 0.0.0.0:11434

错误提示

如还提示错误信息

重启Ollama

右下角找到下羊驼,点击【Quit Ollama】,退出。然后再在安装的程序里找到小羊驼重启。

退出

重启

添加完成

重启再次保存不会报错,并且在Ollama的下面,多了一个添加好的llama3.2模型。

应用Ollama模型

测试通过