文档处理利器Docling,基于LangChain打造RAG应用

大家好,人工智能应用持续发展,对文档信息的有效处理、理解与检索提出了更高要求。大语言模型虽已在诸多领域发挥重要作用,但在文档处理方面仍有提升空间。

本文将详细阐述如何整合Docling 和 LangChain,创建检索增强生成(RAG)系统,以突破局限,为大语言模型赋能,提升其处理文档信息的能力。

1.Docling:IBM打造的文档处理神器

Docling是IBM推出的创新型开源库,变革了文档处理模式。

其特别之处在于,以单一且统一的接口搞定多种文档格式的处理。不管是PDF、Word文档,还是PPT、Excel表格、网页内容,Docling都能简化处理并理解它们。

Docling具备以下几个主要特性,使其极具价值:

-

高级PDF处理:拥有智能布局分析功能,可对PDF文档进行高效处理。

-

智能阅读顺序检测:能让文档内容自然流畅,符合阅读习惯。

-

内置OCR支持:可识别扫描文档中的文字,便于处理。

-

无缝格式转换:不同文档格式之间能轻松转换。

-

原生集成:与流行的人工智能框架无缝对接,协同工作。

2.RAG的重要性

检索增强生成(RAG)的重要性在于解决传统大语言模型(LLM)局限。

传统LLM虽强大但有不足:

-

仅能用训练数据知识。

-

不能获取实时或特定领域信息。

-

可能产生幻觉或提供过时信息。

RAG的作用:

-

使LLM可访问外部最新知识。

-

为回答提供可验证来源。

-

实现特定领域知识整合。

-

依检索内容生成回答减少幻觉。

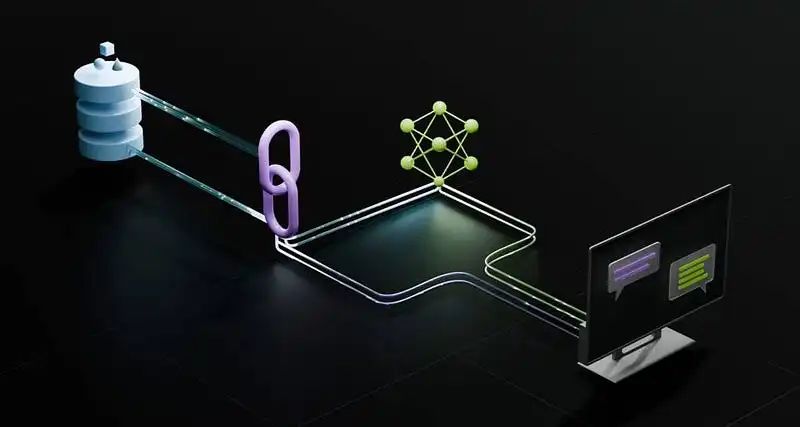

3.RAG架构剖析

典型RAG系统有三个主要组件:

-

文档处理:把各种文档格式转为适合嵌入的形式。

-

检索:从知识库找相关信息。

-

生成:用大语言模型依检索上下文生成回答。

Docling与LangChain完美结合于此:Docling擅长文档处理,LangChain提供检索和生成组件的框架。

4.Docling适配RAG应用

在深入实现之前,有必要了解Docling适合RAG应用的缘由。Docling能够支持包括PDF、DOCX、PPTX、XLSX、图像、HTML等在内的多种通用格式;且具备先进的文档理解能力,能深入挖掘文档的内在信息。

Docling与LangChain可实现无缝集成,为构建RAG系统奠定了良好基础。

此外,其内置的OCR功能有助于处理扫描文档,而且不管文档格式如何,Docling都能保证文档表示的统一性,这些特点使得Docling成为RAG应用的理想之选。

5.动手构建RAG系统

5.1 创建文档加载器

首先需要一个自定义加载器,用于连接 Docling 和 LangChain,其代码如下:

from typing import Iterator

from langchain_core.document_loaders import BaseLoader

from langchain_core.documents import Document as LCDocument

from docling.document_converter import DocumentConverter

class DoclingPDFLoader(BaseLoader):

def __init__(self, file_path: str | list[str]) -> None:

self._file_paths = file_path if isinstance(file_path, list) else [file_path]

self._converter = DocumentConverter()

def lazy_load(self) -> Iterator[LCDocument]:

for source in self._file_paths:

dl_doc = self._converter.convert(source).document

text = dl_doc.export_to_markdown()

yield LCDocument(page_content=text)

此加载器类的主要作用是把文档转换为 LangChain 可以处理的格式。在这个过程中,通过使用 Docling 的export_to_markdown()方法,能够保证文本表示的一致性,这一点很重要,能为后续处理提供稳定、统一的文本基础。

5.2 文档拆分

为了有效检索,需要把文档拆分成可管理的块:

from langchain_text_splitters import RecursiveCharacterTextSplitter

loader = DoclingPDFLoader(file_path="../data/docling-tech-report.pdf")

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200,

)

docs = loader.load()

splits = text_splitter.split_documents(docs)

在本示例中,使用了 docling 技术报告 pdf。

5.3 设置嵌入

借助 Hugging Face 的嵌入来构建向量表示:

from langchain_huggingface.embeddings import HuggingFaceEmbeddings

embeddings = HuggingFaceEmbeddings(

model_name="BAAI/bge-small-en-v1.5"

)

5.4 配置向量存储

这里选用 Milvus(https://milvus.io/)作为向量存储,如有需要也可更换为其他:

from langchain_milvus import Milvus

URI = "./milvus_example.db"

vectorstore = Milvus.from_documents(

splits,

embeddings,

connection_args={"uri": URI},

drop_old=True,

)

5.5 设置语言模型

选用 Phi - 4:14B 的 4 位量化版本,并且以 Ollama 作为模型托管框架。先安装 Ollama,安装链接为 https://ollama.com/download。

然后使用 “ollama pull vanilj/Phi - 4:latest” 命令来拉取所需模型。接着通过以下代码进行设置:

from langchain_ollama import OllamaLLM

llm = OllamaLLM(

model="vanilj/Phi-4:latest"

)

5.6 构建RAG链

现在要把前面的各个部分整合起来,构建一个完整的 RAG 管道:

from typing import Iterable

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import PromptTemplate

from langchain_core.runnables import RunnablePassthrough

def format_docs(docs: Iterable[LCDocument]):

return"\n\n".join(doc.page_content for doc in docs)

retriever = vectorstore.as_retriever()

prompt = PromptTemplate.from_template("""

Context information is below.

---------------------

{context}

---------------------

Given the context information and not prior knowledge, answer the query.

Query: {question}

Answer:

""")

rag_chain = (

{"context": retriever | format_docs, "question": RunnablePassthrough()}

| prompt

| llm

| StrOutputParser()

)

6.使用RAG系统

现在对文档进行查询,使用以下代码:

response = rag_chain.invoke("Which AI models have been released by docling team?")

print(response)

7.最佳实践和优化技巧

用Docling和LangChain构建RAG应用时,请参考这些要点:

-

文档分块:依用例调块大小,设重叠保持连贯,用语义拆分提升效果。

-

向量存储:按需选,顾扩展、托管维护及查询性能。

-

提示工程:设计巧用上下文的提示,注明应对不确定情况的方法,加系统提示稳格式。

Docling强大的文档处理能力与LangChain灵活的RAG框架相结合,为构建复杂文档类AI应用开启新可能。无论是文档问答、研究助手还是知识管理工具,二者组合都能夯实RAG应用基础。

Docling正积极开发LangChain原生扩展,将让集成更简便,未来会有这些功能:

-

支持LangChain直接加载。

-

增强元数据提取。

-

改进文档结构保留。

-

原生支持表格处理。