Rust 并发实战:使用 Tokio 构建高性能异步 TCP 聊天室

摘要: 在当今这个高并发、高I/O的网络时代,构建一个稳定、高性能、可维护的网络服务是所有后端开发者的核心诉求。然而,传统编程语言在“并发安全”和“性能”之间总是让我们做出艰难的取舍。C/C++ 给予我们极致性能,却也带来了内存泄漏和数据竞争的无尽梦魇;Java/Go 提供了并发便利性(GC与Goroutine),却在性能和内存占用上有所妥协。

Rust,作为一门以“内存安全、高性能、并发可靠”为核心优势的语言,提供了一个全新的答案。它提出了“无畏并发”(Fearless Concurrency)的口号——即你可以在编译时就消除所有的数据竞争。

本文将以一个“实践类案例”为切入点,从零开始,使用 Rust 的现代异步生态(tokio)构建一个功能完整、支持多人广播的异步 TCP 聊天室。本文的核心目的不是“炫技”,而是通过这个虽小但“五脏俱全”的项目,与读者一起深入探索:

- 为什么

async/await是 Rust I/O 的未来? 它与多线程模型有何不同? tokio** 是如何工作的?** 我们将解构TcpListener、tokio::spawn、broadcast通道以及tokio::select!宏的核心作用。- Rust 如何在编译时保证并发安全? 我们将深入分析

Send、SyncTrait 和所有权系统在异步代码中的体现。 - 最终代码的性能和安全性 与 Node.js、Go 的同类实现相比,优势何在?

希望通过这篇详细的实践指南,能让更多对 Rust 感兴趣的开发者,直观地感受到 Rust 语言在构建高性能网络应用方面的独特魅力和强大能力。

1. 问题的起点:为什么并发编程如此困难?

在开始编码之前,我们必须先理解我们要解决的问题。构建一个“聊天室”在本质上是构建一个“C10K”问题(即单机处理成千上万个并发连接)的微缩模型。

一个客户端连接到服务器,它会做两件事:

- 写: 发送消息给服务器。

- 读: 接收来自服务器的其他人的消息。

服务器需要同时为 N 个客户端处理这两件事。

在“古老”的年代(甚至现在很多 C/C++ 项目中),我们通常有几种处理方式:

- 同步阻塞 I/O + 多线程(Thread-Per-Connection):

- 做法: 每当一个新客户端

accept(),就为它spawn一个新线程。这个线程通过一个while(true)循环,阻塞地read()来自客户端的数据。 - 优点: 逻辑简单粗暴,代码易于理解。

- 缺点: 灾难性的。线程是昂贵的系统资源。创建成千上万个线程会迅速耗尽操作系统的内存和调度能力。这就是所谓的“C10K”问题的由来。

- 做法: 每当一个新客户端

- 同步非阻塞 I/O + I/O 多路复用(

select/poll/epoll):- 做法: 使用一个(或少量)线程,通过

epoll(Linux)、kqueue(BSD) 或iocp(Windows) 来同时“监视”成千上万个文件描述符(Socket)。当某个 Socket “就绪”(可读或可写)时,操作系统会通知我们,我们再去处理它。 - 优点: 性能极高,是 Nginx、Redis 等高性能组件的基石。

- 缺点: 极其复杂。你需要手动管理状态机。代码(尤其是使用 C 语言编写时)会变得支离破碎,难以维护,也就是“回调地狱”(Callback Hell)。

- 做法: 使用一个(或少量)线程,通过

- 异步非阻塞 I/O + 事件循环(Node.js):

- 做法: Node.js 将 I/O 多路复用封装在一个单线程的事件循环(Event Loop)中,并提供了

async/await的语法糖。 - 优点: 极大地简化了异步编程的心智负担,

async/await让我们能用“同步的逻辑”编写“异步的代码”。 - 缺点: “成也单线程,败也单线程”。如果任何一个计算任务(非 I/O 任务)阻塞了事件循环,所有其他并发请求都会被卡住。它无法原生利用多核 CPU 的优势进行并行计算。

- 做法: Node.js 将 I/O 多路复用封装在一个单线程的事件循环(Event Loop)中,并提供了

- 轻量级线程/协程(Go 的 Goroutine):

- 做法: Go 在语言层面内置了协程(Goroutine)和

select机制。go handle_client()会启动一个由 Go 运行时管理的轻量级“线程”。 - 优点: 兼具了多线程模型的“同步”心智和

epoll模型的“高性能”。非常易于使用。 - 缺点: 它依赖于一个庞大且复杂的 Go 运行时和垃圾回收器(GC)。GC 带来的 STW(Stop-The-World)停顿对于某些硬实时或延迟敏感的系统(如游戏服务器、高频交易)是不可接受的。

- 做法: Go 在语言层面内置了协程(Goroutine)和

那么,Rust 的答案是什么?

Rust 选择了与 C++ (Asio)、JavaScript (Node.js) 类似的 async/await 道路,但它做到了**“零成本抽象**”**和“多线程运行时”**的完美结合。

async/await: 是一种语言层面的语法糖。async fn会返回一个Future(一个“未来才会完成的值”)。它本身什么也不做。- 运行时(Runtime): 真正执行

Future的“引擎”。tokio就是目前 Rust 社区最主流的异步运行时。它内部封装了 I/O 多路复用(如epoll)、一个高效的任务调度器和一个多线程的线程池。

tokio 可以在一个线程池上(充分利用多核 CPU),以非阻塞的方式,高效地调度和执行成千上万个异步任务(Future)。这一切,没有垃圾回收器,并且保证编译时的并发安全。

这就是我们要构建的聊天室所依赖的技术基石。

2. 实践开始:构建项目

我们的目标是实现一个服务器,它能:

- 接受任意多个 TCP 客户端连接。

- 当一个客户端发送消息时,将其广播给所有其他连接的客户端。

- 处理客户端的连接和断开。

步骤 1:项目设置 (Cargo.toml)

首先,我们创建项目并引入 tokio。

cargo new tcp_chat_server

cd tcp_chat_server

打开 Cargo.toml 文件,添加我们的依赖:

[package]

name = "tcp_chat_server"

version = "0.1.0"

edition = "2021"[dependencies]

# 我们需要 tokio 的 "full" 特性

# "full" 包含了 I/O, 运行时, mpsc, broadcast, time, macros 等所有常用功能

tokio = { version = "1.38.0", features = ["full"] }

步骤 2:服务器骨架 (src/main.rs)

我们先来编写服务器的“主循环”。它只做两件事:监听端口,以及接受(Accept)新连接。

use tokio::{net::TcpListener,sync::broadcast,

};#[tokio::main]

async fn main()

{// 1. 绑定监听器到 127.0.0.1:8080let listener = TcpListener::bind("127.0.0.1:8080").await.unwrap();println!("🚀 聊天室服务器已启动,监听 127.0.0.1:8080");// 2. 创建一个“广播通道” (Broadcast Channel)// 这是我们聊天室的核心。// 它允许多个发送者和多个接收者。// 当一个消息被 send 时,所有活跃的 receiver 都会收到它。// 我们指定通道的容量为 100 条消息。let (tx, _rx) = broadcast::channel::<(String, std::net::SocketAddr)>(100);// 3. 循环接受客户端连接loop{// 接受新的 TCP 连接。`accept` 是一个异步函数,// 它会“暂停”执行,直到有一个新连接进来,// 在此期间它不会阻塞当前线程。let (socket, addr) = listener.accept().await.unwrap();// 克隆广播发送端 `tx`let tx = tx.clone();// 为 `tx` 创建一个新的接收端 `rx`// 每个客户端都需要自己的 `rx` 副本,才能收到广播let mut rx = tx.subscribe();// 4. 为每个连接创建一个新的异步任务 (Task)// `tokio::spawn` 会在 tokio 的多线程运行时上调度这个任务。// 这个任务是并发执行的,不会阻塞我们的 `accept` 循环。// `move` 关键字强制闭包获取其引用的所有变量的“所有权”。tokio::spawn(async move {println!("[{}] 已连接。", addr);// 在这里处理客户端的逻辑...// 但为了代码清晰,我们稍后将把逻辑移到一个单独的函数中});}

}

代码解析 (1-4):

#[tokio::main]:这是一个宏,它会将async fn main包装成一个同步的main函数,并启动tokio运行时。TcpListener::bind(...):异步绑定一个 TCP 监听器。.await关键字表示“在此暂停,等待这个异步操作完成”。broadcast::channel(100):这是我们实现“聊天室”的核心。broadcast通道是“多生产者、多消费者”(MPMC)模型。我们创建了一个通道tx(发送端)和_rx(接收端)。tokio::spawn(async move { ... }):这是并发的魔法所在。每当listener.accept().await成功返回一个新socket,我们不会阻塞等待它的消息,而是立刻spawn一个新任务来处理它,然后loop回去继续accept下一个连接。tx.clone()和tx.subscribe()至关重要。tx(发送端) 可以被克隆,rx(接收端) 不能。我们为每个新任务克隆tx,并为tx订阅一个新的rx。move关键字将socket,addr,tx,rx的所有权转移(move)进了这个新的异步任务中。

步骤 3:处理单个客户端(process_client 函数)

现在,让我们把 tokio::spawn 内部的逻辑抽离出来,放到一个专门的 process_client 异步函数中。这会让 main 函数更清晰。

我们将 src/main.rs 修改为如下结构:

use tokio::{io::{AsyncBufReadExt, AsyncWriteExt, BufReader},net::{TcpListener, TcpStream},sync::broadcast,

};

use std::net::SocketAddr;#[tokio::main]

async fn main()

{let listener = TcpListener::bind("127.0.0.1:8080").await.unwrap();println!("🚀 聊天室服务器已启动,监听 127.0.0.1:8080");let (tx, _rx) = broadcast::channel::<(String, SocketAddr)>(100);loop{let (socket, addr) = listener.accept().await.unwrap();let tx = tx.clone();let mut rx = tx.subscribe();// 将处理逻辑交给 `process_client` 函数tokio::spawn(async move {process_client(socket, addr, tx, rx).await;});}

}/*** @brief 处理单个客户端连接的异步函数* @param socket: 客户端的 TcpStream* @param addr: 客户端的 SocketAddr* @param tx: 广播通道的发送端 (克隆)* @param rx: 广播通道的接收端 (新订阅)*/

async fn process_client(mut socket: TcpStream,addr: SocketAddr,tx: broadcast::Sender<(String, SocketAddr)>,mut rx: broadcast::Receiver<(String, SocketAddr)>,

)

{println!("[{}] 已连接。", addr);// 1. 将 `socket` 拆分为一个“读半部”和“写半部”// `split()` 允许我们在两个不同的任务中(如果需要的话)// 并发地读和写同一个 Socket。let (reader, mut writer) = socket.split();// 2. 我们使用 `BufReader` 来获得带缓冲的读取,// 这使我们可以用 `read_line` 来读取一行let mut buf_reader = BufReader::new(reader);let mut line = String::new();// 3. 使用 `tokio::select!` 宏并发地处理两个事件:// - 事件 1: 从客户端 `buf_reader` 读取数据 (用户发送消息)// - 事件 2: 从广播通道 `rx` 接收数据 (其他人发送消息)loop{tokio::select! {// --- 事件 1: 从客户端读取数据 ---// `read_line` 是异步的,它会返回一个 Resultresult = buf_reader.read_line(&mut line) => {// `read_line` 返回 0 表示连接已关闭 (EOF)let bytes_read = match result {Ok(bytes) => bytes,Err(e) => {eprintln!("[{}] 读取错误: {}", addr, e);break; // 发生错误,退出循环}};if bytes_read == 0 {println!("[{}] 连接断开。", addr);break; // 客户端主动断开}// 将收到的消息 (line) 格式化并通过广播 `tx` 发送出去let msg_to_send = format!("[{}] {}", addr, line.trim());println!("转发消息: {}", msg_to_send);// `tx.send` 可能会失败(例如通道已满或没有接收者),// 在聊天室场景中,我们暂时忽略这个错误if let Err(e) = tx.send((msg_to_send, addr)) {eprintln!("[{}] 广播发送失败: {}", addr, e);}// 清空缓冲区以便下次读取line.clear();}// --- 事件 2: 从广播 `rx` 接收数据 ---result = rx.recv() => {match result {Ok((msg, other_addr)) => {// 我们只将消息发送给 *其他* 客户端// 避免自己给自己发消息if addr != other_addr {// `write_all` 是异步的if writer.write_all(format!("{}\n", msg).as_bytes()).await.is_err() {// 写入失败(例如客户端已断开),退出循环eprintln!("[{}] 写入失败,断开连接。", addr);break;}}}Err(broadcast::error::RecvError::Lagged(n)) => {// 如果这个客户端的消息处理过慢,导致它“落后”了// `broadcast` 通道会丢弃旧消息并报告eprintln!("[{}] 接收滞后,丢失了 {} 条消息。", addr, n);}Err(e) => {// 其他接收错误(例如 `tx` 已关闭)eprintln!("[{}] 广播接收错误: {:?}", addr, e);break;}}}}}println!("[{}] 任务结束。", addr);

}

代码解析 (核心:tokio::select!)

tokio::select! 宏是 tokio 中最强大的工具之一。它允许你等待多个不同的异步操作,并只处理第一个完成的那个。

在我们的 process_client 函数中,一个客户端任务在 loop 中只做两件事:

- 等待自己(通过

buf_reader.read_line)发送消息。 - 等待别人(通过

rx.recv())发送消息。

select! 宏让我们可以同时“监听”这两个 Future。

- 如果

buf_reader.read_line(&mut line).await先完成了(即客户端发送了一行字),select!宏就会进入第一个分支(result = ... => { ... })。 - 如果

rx.recv().await先完成了(即广播通道里收到了来自其他人的新消息),select!宏就会进入第二个分支(result = ... => { ... })。

这就是 Rust (Tokio) 版本的 I/O 多路复用!

它用一种极其优雅且易读的方式,解决了“同时处理读和写”这个经典的网络编程难题。我们不需要手动管理状态,也不需要复杂的 epoll 回调。

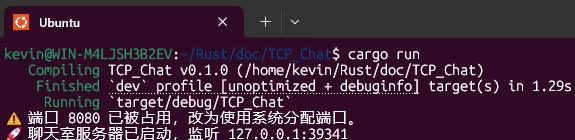

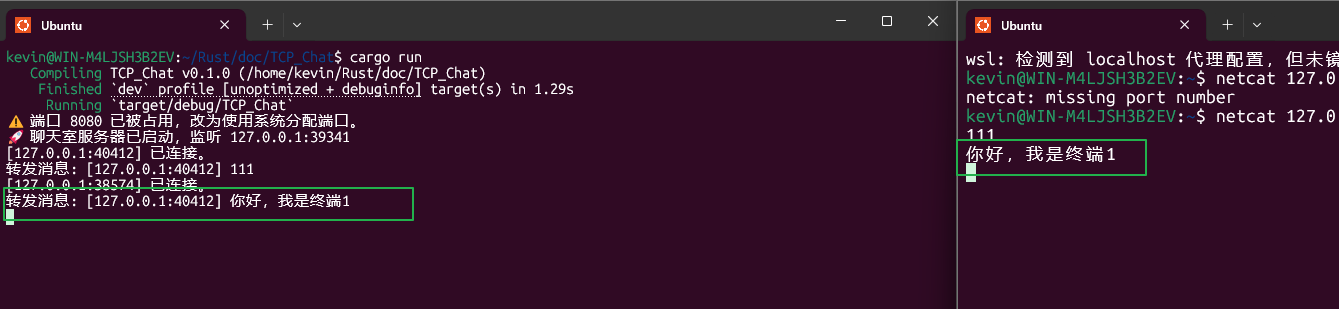

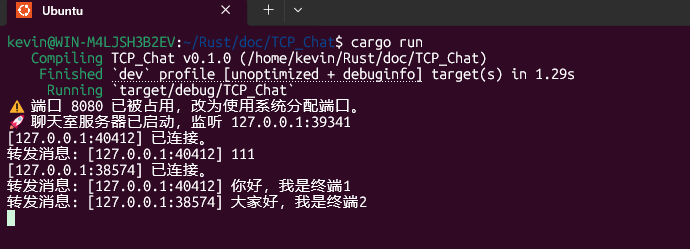

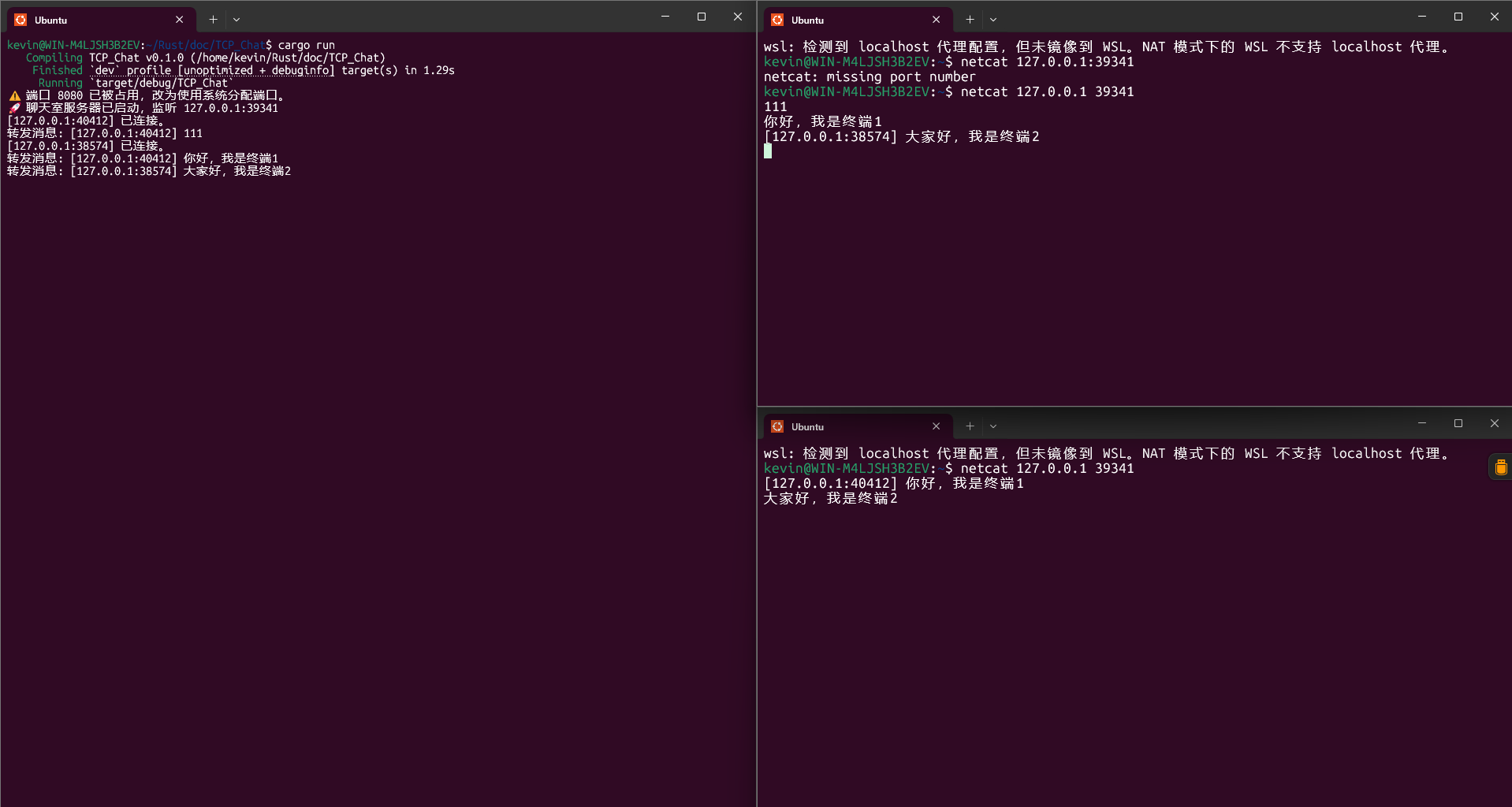

步骤 4:测试运行

现在,我们的代码已经完成了。

- 运行服务器:

cargo run

你将看到:🚀 聊天室服务器已启动,监听 127.0.0.1:8080

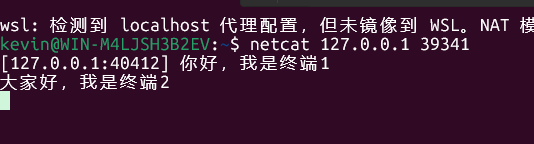

- 打开三个新的终端窗口,使用

netcat(或telnet) 模拟客户端:- 终端 1:

netcat 127.0.0.1 8080

你好,我是终端1

- **终端 2:**

netcat 127.0.0.1 8080

大家好,我是终端2

- **终端 3:**

netcat 127.0.0.1 8080

我是终端3,有人吗?

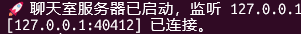

(此时服务器会打印: [127.0.0.1:zzzz] 已连接。)

- 见证奇迹:

- 当终端 1 发送 “你好,我是终端1” 时,终端 2 和 终端 3 会立刻收到:

[127.0.0.1:xxxx] 你好,我是终端1 - 当终端 3 发送 “我是终端3,有人吗?” 时,终端 1 和 终端 2 会立刻收到:

[127.0.0.1:zzzz] 我是终端3,有人吗?

- 当终端 1 发送 “你好,我是终端1” 时,终端 2 和 终端 3 会立刻收到:

我们成功构建了一个并发的、异步的、多客户端的 TCP 聊天室。

3. 深入反思:为什么 Rust 的实现如此“无畏”?

我们已经用大约 100 行 Rust 代码实现了一个功能强大的网络服务。但“能跑”不是我们的目的,我们的目的是理解 Rust 为何能让我们“自信地”写出这样的并发代码。

让我们回到征文的主题:内存安全、高性能、并发可靠。

A. 并发可靠 (Fearless Concurrency)

请仔细回想我们的代码:我们从头到尾,有没有使用过任何一个 Mutex (互斥锁)?

没有。

在传统的 Java 或 C++ 中,要实现一个“广播”功能,你不可避免地需要一个“全局”的客户端列表 List<Client>。当一个客户端发送消息时,你需要:

lock()这个列表(防止其他线程正在添加或删除客户端)。- 遍历列表,给每个客户端发送消息。

unlock()列表。

当一个新客户端连接或断开时,你也需要 lock() 这个列表来进行增删。

这里充满了风险:

- 死锁: 你

lock()了列表,然后尝试lock()某个客户端,而另一个线程反向操作。 - 性能瓶颈: 这个全局锁会成为热点,极大地限制服务器的并发能力。

- 数据竞争: 你忘记

lock()了吗?恭喜,你遇到了一个在测试环境永远无法复现,但在生产环境高并发下随机崩溃的 “Heisenbug”。

Rust 是如何解决的?

Rust 通过所有权系统和**通道(Channel)**彻底改变了游戏规则。

“Do not communicate by sharing memory; instead, share memory by communicating.”

(不要通过共享内存来通信;而要通过通信来共享内存。)

— Go 语言的座右铭 (同样适用于 Rust)

我们没有共享一个 Vec<Client>。我们使用了一个 broadcast::channel。

- 所有权: 当

tx.send((msg, addr))时,msg(一个String) 和addr(一个SocketAddr) 的所有权被转移到了通道中。- 克隆与订阅:

tx(发送端) 可以被安全地克隆(Clone),rx(接收端) 被订阅。tokio的broadcast通道内部使用了(类似Arc的)原子引用计数来管理其内部状态,这一切对用户是透明的。- 数据隔离: 每个

tokio::spawn任务都拥有它自己的socket,addr,tx(克隆体) 和rx(订阅体)。它们之间没有共享任何可变状态。它们只通过channel这一个“中介”来通信。

Rust 的编译器(Borrow Checker)在编译时,就通过所有权规则,强制我们写出了没有数据竞争的代码。 这就是“无畏并发”的真正含义。我们不是“希望”我们的代码是线程安全的,我们是**“知道”**它在编译时就已经被证明是安全的。

B. 内存安全与高性能 (零成本抽象)

我们的代码中充满了 String, Vec<u8> (在 write_all 内部) 和 BufReader。在 C++ 中,这些都是最容易出错的地方(缓冲区溢出、use-after-free)。

BufReader帮我们高效地处理缓冲,read_line(&mut line)会安全地将数据追加到String中。如果line的容量不够,String会自动扩容。这个过程 100% 内存安全,绝不会发生缓冲区溢出。- 当

process_client函数结束时(客户端断开),它所拥有的socket,addr,tx,rx,buf_reader,line… 所有这些变量,都会被 Rust 的所有权系统自动、确定性地释放(Drop)。没有free(),也没有 GC。

这就是 Rust 的零成本抽象(Zero-Cost Abstraction):

- 抽象(我们写的): 我们写的是

async/await,tokio::select!,broadcast::channel这样高级、易读的代码。 - 成本(编译后):

async/await在编译时会被展开成一个高效的状态机(Future)。tokio::select!会被编译成一个(类似poll)的高效轮询。tokio运行时底层调用的是操作系统最高效的epoll/kqueue/iocp。

我们获得了与手写 C 语言 epoll 相媲美的极致性能,同时享受了(甚至超越了)Go 和 Node.js 的高级抽象和开发效率,并且这一切都建立在 C++ 和 Java 梦寐以求的编译时内存和并发安全之上。

C. 与 Go 和 Node.js 的横向对比

- 对比 Node.js: 我们的 Rust 服务器是多线程的。

#[tokio::main]默认会启动一个与你 CPU 核心数相等的多线程池。tokio::spawn会自动将任务分发到这些线程上。我们无需修改任何代码,就获得了远超 Node.js 单线程事件循环的并发处理能力。如果某个任务(未来可能)需要做密集的 CPU 计算(如图像处理),它不会像在 Node.js 中那样“卡死”整个服务器。 - 对比 Go: Go 的

go handle_client()非常易用。但 Goroutine 依赖于一个有 GC 的运行时。这个 GC 可能会在任何时候暂停你的程序(STW)。而我们的 Rust 版本是无 GC 的。它的内存释放是确定性的(在变量离开作用域时),这使得 Rust 非常适合对延迟(latency)极其敏感的应用,如游戏服务器、金融交易和嵌入式系统。Rust 赋予了你 C/C++ 级别的底层控制力。

4. 结语与展望

我们从一个简单的问题出发,使用 tokio 和 async/await 构建了一个看似简单,实则蕴含了 Rust 核心设计哲学的 TCP 聊天室。

这个项目展示了 Rust 如何巧妙地解决了并发编程中最棘手的几个问题:

- 它通过

async/await+tokio提供了处理高并发 I/O 的高性能模型。 - 它通过

tokio::select!提供了优雅的、非阻塞的事件处理能力。 - 它通过

broadcast::channel和所有权系统,在编译时就根除了数据竞争,实现了“无畏并发”。

对于国内广大挣扎于 C++ 内存安全泥潭,或是受限于 Node.js/Python 性能,亦或是想摆脱 Go GC 束缚的互联网开发者而言,Rust 提供了一个极具吸引力的“未来选项”。

诚然,Rust 的学习曲线(尤其是所有权和生命周期)是陡峭的,但正如我们今天所见,一旦你跨越了那道门槛,Rust 编译器——这个“最严格的导师”——将成为你最可靠的战友,帮助你构建出那些你以往不敢想象的、既高性能又极其健壮的系统。

这个聊天室只是一个开始。你还可以尝试:

- 添加用户名,在

tx.send时发送(username, message)。 - 实现“房间”功能,使用多个

broadcast::channel。 - 使用

tokio::sync::Mutex(当你真的需要共享状态时)来安全地管理一个全局的用户列表。

Rust 的生态正在以前所未有的速度蓬松发展。现在,就是加入这场“范式革新”的最好时机。

如果您对更多前沿技术、开源项目和深度应用感兴趣,欢迎访问 华为开放原子旋武开源社区(https://xuanwu.openatom.cn/)。在这里,您可以与开发者们一同探索技术的无限可能!