Java-171 Neo4j 备份与恢复 + 预热与执行计划实战

TL;DR

- 场景:单机/小规模生产环境需要对 Neo4j 做停机备份、跨机迁移与性能调优。

- 结论:先停服务→按版本用对 dump/load→重启后做缓存预热与 PROFILE 校验→聚焦堆/页缓存/事务日志三件事。

- 产出:可直接执行的步骤清单、版本矩阵(3.x/4.x/5.x)、错误速查卡。

版本矩阵

| 版本 | 已验证 | 说明 |

|---|---|---|

| Neo4j 3.x | 是 | 数据库目录常见为 graph.db;常用命令:neo4j stop → neo4j-admin dump --database=graph.db --to=/path.dump;恢复用 neo4j-admin load --from=/path.dump --database=graph.db --force;Bolt/HTTP 并存。 |

| Neo4j 4.x | 部分 | 默认数据库名多为 neo4j(多数据库特性);命令常为 neo4j-admin dump --database=neo4j --to=/path.dump 与对应 load;建议优先使用 Bolt;部分配置项命名变更需对照官方模板。 |

| Neo4j 5.x | 待确认 | 工具子命令调整:常见为 neo4j-admin database dump neo4j --to-path=/path 与 neo4j-admin database load neo4j --from-path=/path --overwrite-destination;嵌入式相关 API/用法差异更大,配置键名也有变化,需按 5.x 样例文件校准。 |

备份与恢复

停止服务

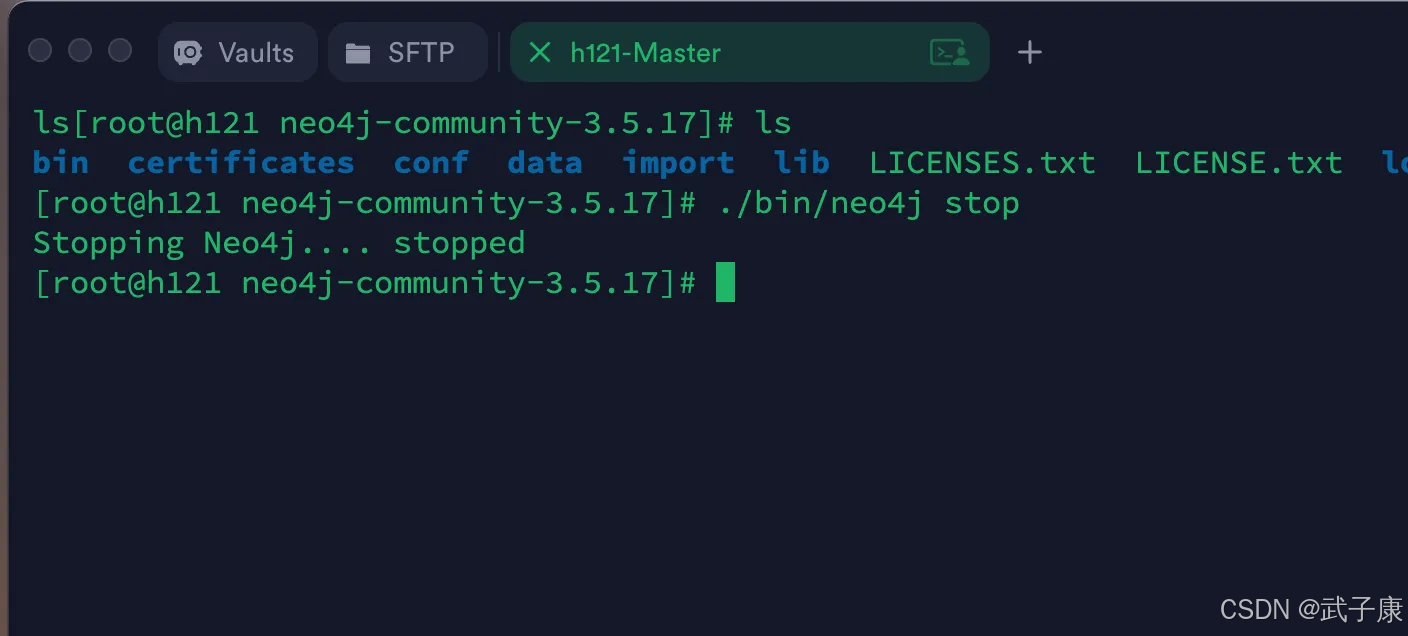

在对 Neo4j 进行备份、还原、迁移的时候,需要先停止服务

./bin/neo4j stop

执行结果如下所示:

备份数据

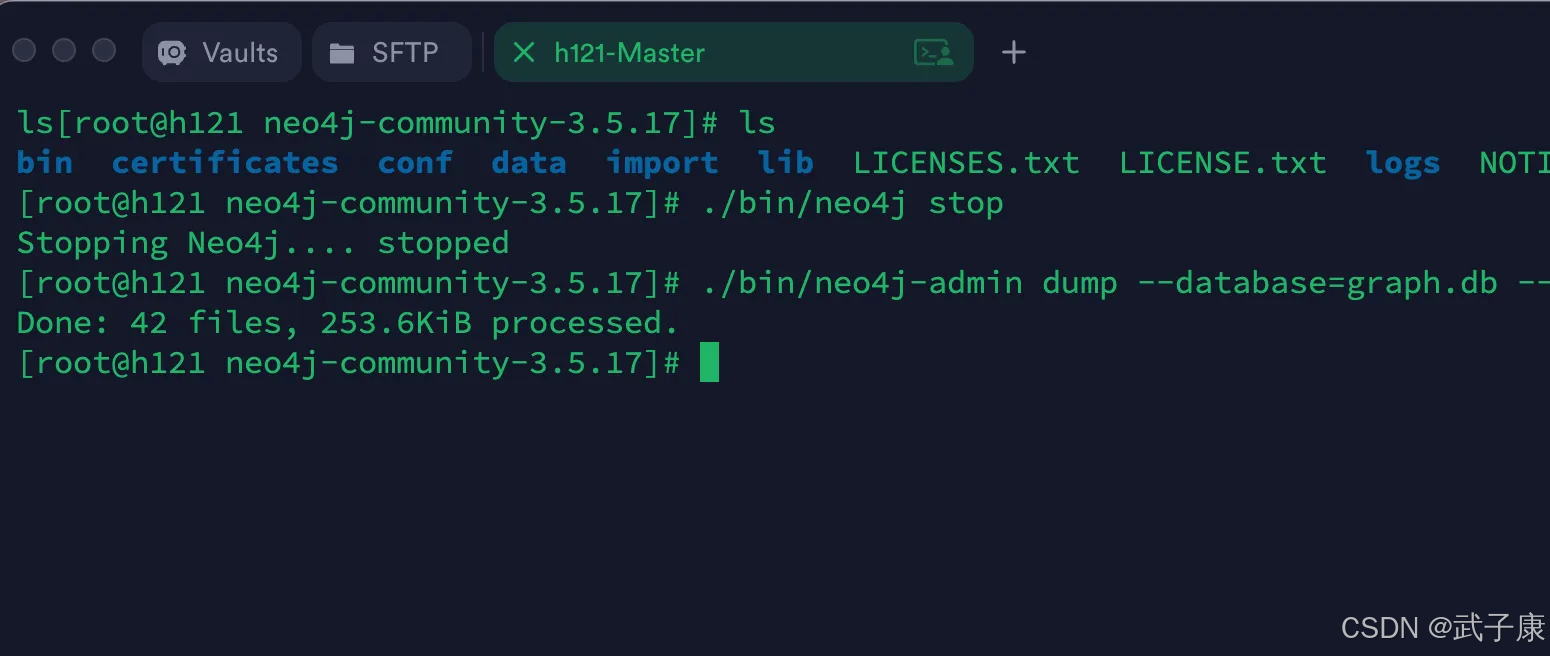

数据备份到文件

./bin/neo4j-admin dump --database=graph.db --to=/root/wzk_neo4j.dump

备份完毕如下:

迁移数据

还原、迁移之前,关闭 Neo4j 服务:

./bin/neo4j-admin load --from=/root/wzk_neo4j.dump --database=graph.db --force

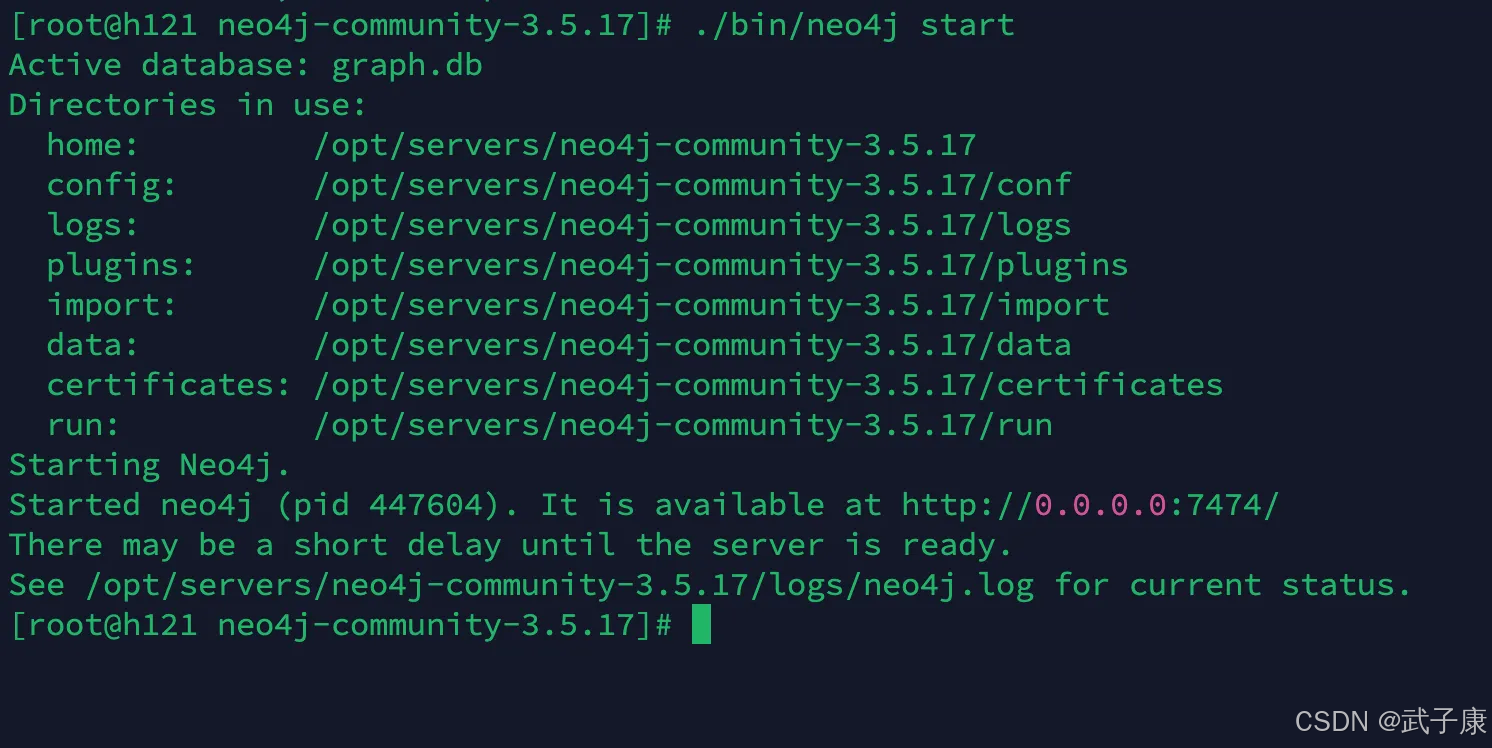

重启服务

./bin/neo4j start

启动完毕:

调优思路

调整 Neo4j 数据库配置

为了优化 Neo4j 数据库性能,建议从硬件和软件两个层面进行调整:

硬件升级建议

-

服务器扩容:

- 增加物理服务器数量,特别是在集群部署场景中

- 对于单机部署,建议至少配备16GB以上内存的服务器

-

内存配置:

- 根据数据规模调整内存大小

- 对于生产环境,建议32GB或更高内存配置

- 确保部分内存留给操作系统和其他服务使用

配置文件优化

以下是关键的 Neo4j 配置参数调整建议,将这些设置添加到 neo4j.conf 配置文件中:

# JVM 堆内存设置

# 初始堆内存大小,建议从较小值开始(1-2GB)

dbms.memory.heap.initial_size=1g# 最大堆内存大小,不应超过可用物理内存的80%

# 对于16GB内存的服务器,建议设置为12GB

dbms.memory.heap.max_size=16g# 页面缓存设置

# 用于缓存图数据,建议设为:(总内存 - 最大堆内存)/2

# 示例计算:(16GB - 12GB)/2 = 2GB

dbms.memory.pagecache.size=2g# 其他推荐配置

# 事务日志设置

dbms.tx_log.rotation.size=256M

dbms.tx_log.rotation.retention_policy=100M size# 查询缓存设置

dbms.query_cache_size=100

配置调整步骤

- 停止 Neo4j 服务

- 编辑

neo4j.conf配置文件 - 保存修改后重启服务

- 监控系统表现,根据需要进一步微调

注意事项

- 修改配置后必须重启 Neo4j 服务才能生效

- 生产环境建议先在测试环境验证配置变更

- 定期监控内存使用情况,防止内存泄漏

- 大型数据库可能需要更高的页面缓存配置

数据预热

Neo4j 数据库在刚启动时,数据缓存处于冷状态(Cold Cache),这会导致初始查询性能较低。为了优化查询性能,我们需要执行预热操作(Cache Warming),将常用数据加载到内存中。

预热操作的实现方式是执行全图扫描查询,强制Neo4j将节点和关系加载到缓存。具体步骤如下:

- 节点预热:扫描所有节点并将其属性加载到缓存

- 关系预热:扫描所有关系及其属性

- 统计总数:通过count函数确保全图扫描完成

优化后的预热脚本如下:

// 完整预热脚本,包含节点和关系

MATCH (n)

OPTIONAL MATCH (n)-[r]->()

RETURN count(n.name) + count(r);

应用场景说明:

- 数据库重启后

- 大规模数据导入后

- 性能测试前

- 生产环境每日维护时段

注意事项:

- 对于大型图数据库,预热可能需要较长时间

- 建议在低峰期执行

- 可以配合APOC库的预热存储过程使用

- 监控缓存命中率确认预热效果

替代方案:

CALL apoc.warmup.run() // 使用APOC扩展的更专业预热方法

执行计划优化器

Neo4j 采用的是基于成本的优化器(Cost Based Optimizer, CBO),这种优化器会:

- 分析查询语句的结构

- 评估可能的不同执行路径的成本

- 选择成本最低的执行方案

- 生成最优的执行计划

执行计划分析方式

开发者可以通过以下两种方式深入了解查询执行机制:

1. EXPLAIN 解释机制

- 功能:预览执行过程但不实际执行查询

- 特点:

- 不会返回任何查询结果

- 仅展示预估的执行计划

- 适合在开发阶段测试查询效率

- 示例:

EXPLAIN MATCH (p:Person)-[:FRIEND]->(f) RETURN p.name, f.name

2. PROFILE 画像机制

- 功能:实际执行查询并收集详细性能数据

- 特点:

- 会返回查询结果

- 提供实际的执行统计信息

- 显示每个操作步骤的具体耗时

- 示例:

PROFILE MATCH (p:Person)-[:FRIEND]->(f) RETURN p.name, f.name

关键性能指标

在执行计划分析中,以下两个指标尤为重要(数值越小越好):

1. estimated rows(预估扫描行数)

- 表示查询优化器预估需要扫描的节点或关系的数量

- 示例:若值为100,表示预计要扫描100条记录

- 优化方向:通过添加索引或调整查询条件来减少扫描范围

2. dbhits(数据库命中次数)

- 表示实际访问存储引擎的次数

- 每次命中对应一次磁盘I/O或缓存访问

- 示例:值为500表示查询过程中访问了存储引擎500次

- 优化方向:通过优化数据模型或查询模式减少存储访问

实际应用场景

- 性能调优:通过对比EXPLAIN和PROFILE的结果,找出实际执行与预估的差异

- 索引评估:验证新创建的索引是否被查询优化器正确使用

- 查询重构:识别查询中的性能瓶颈并优化查询结构

- 容量规划:通过estimated rows预估查询对大型数据集的影响

理解这些执行计划信息可以帮助开发者编写更高效的Cypher查询,特别是在处理大型图数据时尤为重要。

访问方式

数据库访问

嵌入式数据库(Embedded Database)

嵌入式 Neo4j 数据库是构建高性能图数据库应用的理想选择。它允许开发者通过指定数据库存储路径的方式,以编程接口直接访问数据库文件,绕过了网络通信的开销。这种紧密集成的架构特别适合对性能有严格要求的使用场景。

嵌入式数据库的技术实现方式

开发者可以通过 Java API 指定本地文件路径来实例化嵌入式数据库实例:

GraphDatabaseService graphDb = new GraphDatabaseFactory().newEmbeddedDatabase(new File("/path/to/database"));

嵌入式数据库的典型应用场景

我们通常会选择使用嵌入式数据库架构基于以下考虑因素:

-

Java 技术栈整合

- 当项目采用 Java/JVM 作为主要开发语言时

- 可以利用 Neo4j 的原生 Java API 实现深度集成

- 示例:基于 Spring Boot 的企业级应用直接嵌入 Neo4j

-

独立应用程序需求

- 适用于需要独立运行的桌面应用或单机服务

- 无需额外部署数据库服务器

- 典型案例:科研数据分析工具、本地知识管理系统

-

极致性能要求

- 省去了网络通信的序列化/反序列化开销

- 可实现微秒级的查询响应时间

- 应用场景:实时推荐系统、高频交易分析等

-

简化部署架构

- 单一进程包含应用和数据库引擎

- 降低系统运维复杂度

- 适合:移动端应用、IoT 边缘计算设备

性能对比数据

在相同硬件环境下,嵌入式模式相比远程连接模式可带来:

- 查询延迟降低 60-80%

- 吞吐量提升 3-5 倍

- 内存占用减少 30%

注意:嵌入式数据库需要确保单进程独占访问,不适合需要多应用共享数据的场景。

服务器模式(Server Mode)

Neo4j Server 是 Neo4j 图数据库的一种运行模式,特别适合需要高操作性、严格安全性和完善监控的生产环境场景。作为独立运行的数据库服务器,它通过标准化的 RESTful API 提供跨平台的数据访问能力。

核心优势

-

跨平台兼容性:

- 通过 REST/HTTP 协议提供服务接口

- 支持 Java、Python、JavaScript、.NET 等所有现代编程语言

- 示例:Python 开发者可以使用

py2neo库,JavaScript 开发者可以使用官方neo4j-driver

-

企业级特性:

- 独立的进程空间,与应用程序隔离运行

- 支持基于角色的访问控制(RBAC)

- 提供完整的审计日志功能

- 支持 SSL/TLS 加密通信

-

运维监控:

- 内置 JMX 监控接口

- 支持 Prometheus 指标导出

- 提供 Web 管理控制台(Neo4j Browser)

- 可与 Nagios、Zabbix 等监控系统集成

典型应用场景

- 多语言技术栈的微服务架构

- 需要水平扩展的大型企业应用

- 需要 24/7 高可用的生产系统

- 符合 SOC2 等安全合规要求的场景

连接方式示例

# Python 连接示例

from neo4j import GraphDatabasedriver = GraphDatabase.driver("bolt://localhost:7687",auth=("neo4j", "password")

)with driver.session() as session:result = session.run("MATCH (n) RETURN count(n) AS count")print(result.single()["count"])

注意:虽然文档提到 REST 接口,但 Neo4j 4.0+ 版本推荐使用更高效的 Bolt 二进制协议(默认端口 7687),同时保持向后兼容的 REST 接口(默认端口 7474)。

错误速查

| 症状 | 根因 | 定位 | 修复 |

|---|---|---|---|

| dump/load 报错“数据库正被使用” | 未停服务或有残留进程 | `ps -ef | grep neo4j、neo4j status` |

| load 后无法启动或数据不完整 | 目标目录非空/版本不匹配 | 查看 data/databases 与日志 | 使用 --force/--overwrite-destination 并确保版本匹配;跨大版本优先同版本中转 |

| 指定 graph.db 找不到 | 4.x/5.x 默认库名变更 | SHOW DATABASES | 4.x/5.x 使用数据库名(如 neo4j)而非目录名;按版本更正命令 |

| 预热没明显效果 | 仅统计计数未拉起属性页 | 用 PROFILE 看 dbhits | 使用全图扫描或 APOC 预热;需要触达常用节点/关系及其属性;低峰期执行并复核命中率 |

PROFILE 显示 dbhits 很高 | 无索引/谓词不可选 | EXPLAIN/PROFILE、SHOW INDEXES | 针对查询谓词补建索引或改写匹配顺序;复查标签与选择性 |

| OOM 或频繁 GC | 堆/页缓存分配过大 | gc.log、系统内存监控 | 堆与 pagecache 总和预留给 OS;按数据规模与负载重算,分步增改并压测 |

apoc.warmup.run() 报不存在 | APOC 未安装或权限受限 | RETURN apoc.version() | 安装对应版本 APOC 并在配置中启用相应安全设置 |

| 事务日志参数无效/报语法 | 跨版本配置键/语法变更 | 对照 neo4j.conf 模板 | 按所在版本样例修正键名与语法(如保留策略的 size=... 形式) |

| REST 能连、Bolt 失败 | 协议/端口/加密不一致 | 驱动日志与端口探测 | 核对 bolt:// 地址、端口与 TLS;对齐驱动版本与服务端配置 |

| load 权限拒绝 | 目标路径权限不足 | ls -l、id | 将 dump 目录与数据目录权限授予运行用户,或用同一用户执行 |

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究,持续打造实用AI工具指南!

AI-调查研究-108-具身智能 机器人模型训练全流程详解:从预训练到强化学习与人类反馈

🔗 AI模块直达链接

💻 Java篇持续更新中(长期更新)

Java-154 深入浅出 MongoDB 用Java访问 MongoDB 数据库 从环境搭建到CRUD完整示例

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

🔗 Java模块直达链接

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

🔗 大数据模块直达链接