人工智能分支——深度学习、机器学习与神经网络初概览

神经网络与深度学习的发展历程

第一阶段:

1943年,提出了** M-P 模型** ,首次用数学模型模拟神经元的工作方式,被认为是人工神经网络的起点。该模型通过模拟生物元的工作原理 ,实现了信号的加权求和与阈值激活机制。

第二阶段:

1958年,提出了感知机(Perceptron) 学习算法,这是一种分类线性分类器 ,能够处理线性问题,对于非线性问题(比如:异或等问题,没办法解决)

第三阶段:

1982年,提出 Hopfield 网络 ,引入能量函数概念,可用于联想记忆。

1986年,David Rumelhart、Geoffrey Hinton 等人重新发现并推广 反向传播算法(Backpropagation)(BP算法) ,使得多层感知机(MLP) 能够有效训练,解决了非线性问题。 这一时期也出现了 卷积神经网络(CNN)的雏形。深度学习通过增加网络层数 ,提升复杂任务的处理能力,该阶段主要解决了图像识别、语音识别等任务。

LeNet-5(1998):Yann LeCun 等人开发的 CNN,成功用于手写数字识别(如银行支票识别)

第四阶段:

2006年,提出 深度置信网络(DBN) ,使用逐层预训练缓解梯度消失问题 ,标志“深度学习”时代的开启。

2012年,Alex Krizhevsky 等人在 ImageNet 图像识别竞赛中使用 AlexNet(深度 CNN),错误率大幅降低,引爆深度学习热潮。

2020年代,大模型时代到来(如 GPT、BERT、LLaMA、Stable Diffusion),神经网络参数规模达百亿甚至万亿级。

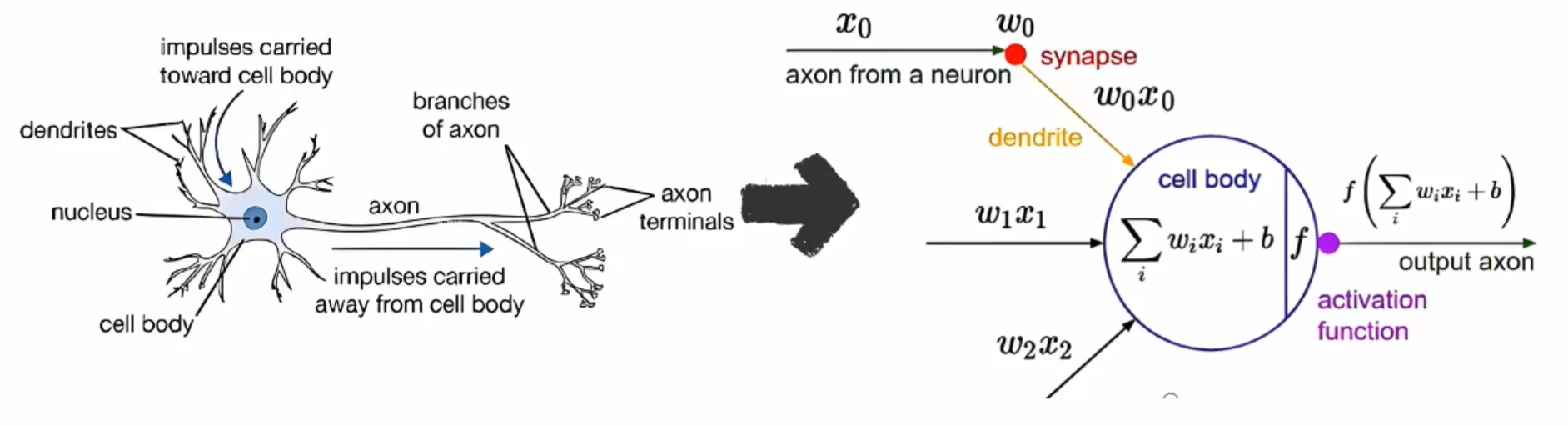

类比生物神经网络

每个神经元含细胞体、树突(用于接收信号)、轴突(用于传递信号)和突触(用于连接神经)

树突:接收来自其他神经元的信号

细胞体:进行信号处理传给轴突

轴突:输出到下一个神经元

突触:使神经网络具备分布式存储和高效处理能力(其中神经元通过电信号传递信息,当输入信号超过阈值时,神经元被激活)

此图来源于网络:

什么是BP神经网络?

BP神经网络(Backpropagation Neural Network,反向传播神经网络)是一种多层前馈人工神经网络,其核心训练算法是反向传播算法(Backpropagation)。

BP神经网络通常包含三层(也可扩展为更多层):

- 输入层(Input Layer):接收原始数据(如图像像素、特征向量等)。

- 隐藏层(Hidden Layer):一个或多个中间层,用于提取数据的抽象特征。这是实现非线性映射的关键。

- 输出层(Output Layer):输出最终结果(如分类标签、回归值等)。

注意:只有包含至少一个隐藏层的网络才能称为**“多层感知机”(MLP)** ,也即典型的BP网络。单层感知机无法解决非线性问题。

工作原理

BP网络训练分为两个阶段:

-

- 前向传播(Forward Propagation)

输入数据从输入层逐层传递到输出层。

每个神经元对输入加权求和,加上偏置后通过激活函数(如 Sigmoid、ReLU)产生输出。

最终得到网络的预测值。

- 前向传播(Forward Propagation)

-

- 反向传播(Backpropagation)

计算预测值与真实值之间的误差(通常用均方误差或交叉熵)。

利用链式法则(微积分)将误差从输出层反向逐层传递,计算每一层参数(权重和偏置)对总误差的梯度。

使用梯度下降法(如 SGD、Adam)更新网络参数,使误差逐步减小。

- 反向传播(Backpropagation)

BP神经网络 = 多层感知机 + 反向传播算法 ,是连接传统机器学习与现代深度学习的桥梁。尽管如今已被更复杂的架构(如 CNN、Transformer)超越,但其核心思想——通过梯度反向传播自动调整参数——仍是所有深度神经网络训练的基石。

深度学习侧重点

首先是机器学习在处理图像 和 文本 数据方面,能力较弱。

因此,对于这两个弱点,我们要对于这两个问题做一个处理。引出了CNN(卷积神经网络,处理图像问题)和RNN(循环神经网络,处理文本问题 )。

CNN又分了几个关键层:

- 卷积层(提取图像局部特征,会涉及到卷积核,也叫滤波器,会得到特征图叫futuremap)

- 池化层(关键作用就是图像降维 ,因为图像一般用的是HWC这三个参数(这三个参数分别表示:高、宽、通道 )),图像是这样分的,但是层却不是这么处理的(一般层是把通道这个参数放前面)。这里面就涉及到了维度转换。所以为什么要维度转换就是这个原因:其实是由于卷积层和池化层对参数处理顺序不一致导致的。(这里就引出了张量)。

- 全连接层: 1.每个输出节点与输入节点之间都有一个可学习的权重 ;2.输出是输入的线性变换 + 偏置 ,通常再经过一个非线性激活函数;

在结构上,它就是一个多层感知机(MLP, Multi-Layer Perceptron)的基本组成单元

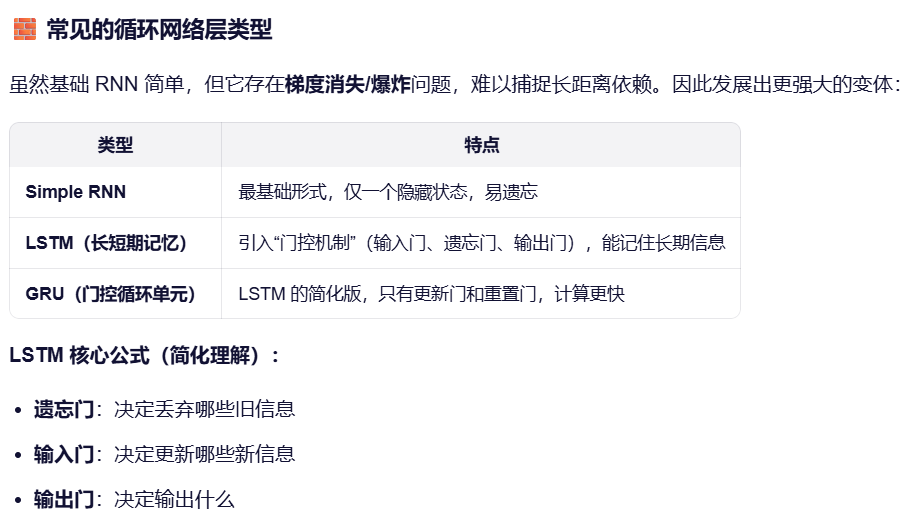

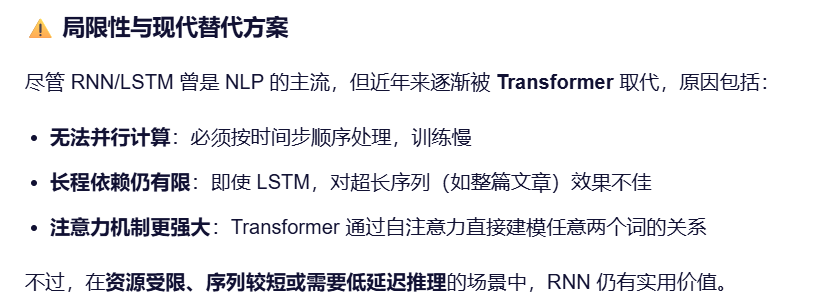

RNN分了几个关键层:

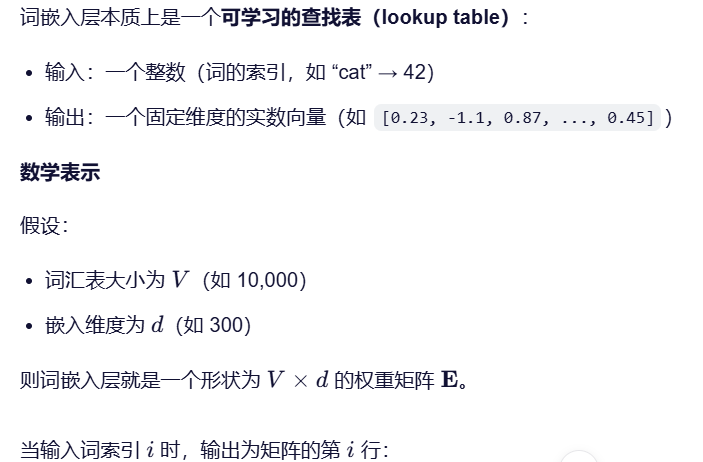

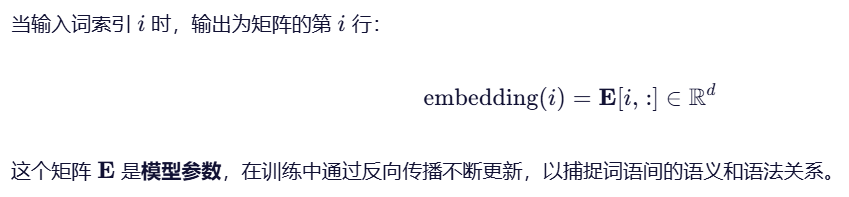

- 词嵌入层:用于将文本数据转换为神经网络可以处理的数值形式。

- 为什么需要词嵌入层?

- 计算机无法直接理解“苹果”“跑步”这样的词语。传统方法(如 one-hot 编码)虽然能将词表示为向量,但存在严重问题。因此需要使用词嵌入层,词嵌入通过低维稠密向量(如 128 维、300 维)来表示词语,并在训练过程中自动学习语义关系(例如:

国王 - 男人 + 女人 ≈ 女王)。

- 循环网络层:通常指循环神经网络(Recurrent Neural Network, RNN) 中的核心计算单元,是一种专门用于处理序列数据(如文本、语音、时间序列)的神经网络层。它的关键特点是:具有记忆能力,能利用先前时刻的信息来影响当前时刻的输出。

核心思想:参数共享 + 隐藏状态传递

- 全连接层: 与机器学习的全连接层概念上一致。但是,在日常中,往往有语义上的不同

从上面机器学习与深度学习的全连接层当中,要引出ANN( Artificial Neural Network) 人工神经网络。这时候就要考虑张量了。

因此,对于张量这个概念,一定要理解这个东西的由来,这样学习深度学习就有了一定的基础了。