【03】SIFT算法解析:两张图片的关键点匹配

简介

本文详解SIFT(尺度不变特征变换)算法的核心原理与特性,结合OpenCV+Python完整演示两张图片的关键点检测→描述符计算→特征匹配流程。从SIFT的尺度不变性原理到BFMatcher的kNN匹配策略,再到ratio阈值优化误匹配,帮你掌握传统计算机视觉中最经典的特征匹配技术,解决图像旋转、缩放后的匹配难题。

一、SIFT算法简介

1. 什么是SIFT?

SIFT(Scale-Invariant Feature Transform)是2004年由David G. Lowe提出的局部特征描述算法,核心目标是从图像中提取尺度、旋转不变的关键点,并生成具有区分度的描述向量。这些特征能在图像缩放、旋转、光照变化甚至局部变形时保持稳定,是图像匹配、目标识别、全景拼接等任务的基础。

2. SIFT的核心特性

SIFT能成为传统CV的“巅峰算法”,源于以下5点优势:

- 不变性强:对旋转、尺度缩放、亮度变化完全不变,对视角变换、仿射变形、噪声有一定鲁棒性;

- 区分度高:每个关键点对应128维描述向量,包含丰富局部梯度信息,能在百万级特征库中快速匹配;

- 数量充足:即使小物体(如Logo、文字)也能生成数十甚至上百个特征点;

- 效率可观:优化后的匹配算法(如FLANN)可接近实时;

- 扩展性好:能与HOG、SURF等特征联合使用,提升任务性能。

二、SIFT特征检测流程

SIFT的特征提取分4步,每一步都围绕“尺度不变性”设计:

1. 尺度空间极值检测

要找到尺度不变的关键点,首先需要构建尺度空间——用不同标准差的高斯核(G(x,y,σ)G(x,y,\sigma)G(x,y,σ))模糊图像,模拟不同观察尺度。然后通过**高斯差分(DoG)**计算相邻尺度的差异:D(x,y,σ)=(G(x,y,kσ)−G(x,y,σ))∗I(x,y)D(x,y,\sigma) = (G(x,y,k\sigma) - G(x,y,\sigma)) * I(x,y)D(x,y,σ)=(G(x,y,kσ)−G(x,y,σ))∗I(x,y)其中:

- G(x,y,σ)G(x,y,\sigma)G(x,y,σ)是二维高斯函数:G(x,y,σ)=12πσ2e−x2+y22σ2G(x,y,\sigma) = \frac{1}{2\pi\sigma^2}e^{-\frac{x^2+y^2}{2\sigma^2}}G(x,y,σ)=2πσ21e−2σ2x2+y2

- kkk是尺度因子(通常取2\sqrt{2}2),I(x,y)I(x,y)I(x,y)是输入图像。

DoG图像能突出不同尺度下的边缘与角点,我们只需搜索DoG空间中的局部极值点(比周围8个邻域及上下2个尺度的点都大或小),就能得到潜在的尺度不变兴趣点。

2. 关键点定位

候选极值点中存在低对比度或边缘点(不稳定),需要进一步筛选:

- 用二次函数拟合极值点的位置与尺度,精确调整坐标;

- 剔除对比度低于阈值(如0.03)的点;

- 通过Hessian矩阵判断点是否在边缘上(边缘点的Hessian矩阵特征值差异大,剔除)。

最终保留的是稳定、具有尺度不变性的关键点。

3. 方向确定

为了实现旋转不变性,需要给每个关键点分配主方向:

- 以关键点为中心,取16×1616\times1616×16的邻域(尺度由关键点的σ\sigmaσ决定);

- 计算邻域内每个像素的梯度方向θ\thetaθ和梯度幅值mmm:θ(x,y)=arctan(Iy(x,y)Ix(x,y)),m(x,y)=Ix2+Iy2\theta(x,y) = \arctan\left(\frac{I_y(x,y)}{I_x(x,y)}\right),\quad m(x,y) = \sqrt{I_x^2 + I_y^2}θ(x,y)=arctan(Ix(x,y)Iy(x,y)),m(x,y)=Ix2+Iy2其中IxI_xIx、IyI_yIy是x/y方向的梯度(用Sobel算子计算);

- 统计梯度方向直方图(16个bins),取直方图峰值对应的方向作为主方向。若次峰值超过主峰值的80%,则添加副方向,确保多方向的旋转不变性。

4. 关键点描述

最后,生成128维的描述向量,用于特征匹配:

- 以关键点为中心,取16×1616\times1616×16的邻域,分成4×44\times44×4个子块(每个子块4×44\times44×4像素);

- 对每个子块,计算8个方向的梯度直方图(共4×4×8=1284\times4\times8=1284×4×8=128维);

- 归一化描述向量(消除光照变化影响),得到最终的SIFT描述符。

三、实战:两张图片的关键点匹配

接下来用OpenCV+Python实现完整流程,代码已优化变量名与注释,确保可读性。

1. 环境准备

需要安装:

- OpenCV-python(注意:SIFT属于xfeatures2d模块,需安装

opencv-contrib-python):pip install opencv-contrib-python - NumPy:

pip install numpy

2. 代码实现

(1)导入库与加载图像

import numpy as np

import cv2

from matplotlib import pyplot as plt# 图像路径(替换为你的图片路径)

img_path1 = "im1.jpg"

img_path2 = "im2.jpg"

(2)初始化SIFT检测器

# 实例化SIFT检测器(OpenCV 3+版本用xfeatures2d.SIFT_create())

sift_detector = cv2.xfeatures2d.SIFT_create()

(3)图像灰度化与显示

SIFT处理灰度图即可,先将彩色图转灰度:

# 读取图像并转灰度

img1 = cv2.imread(img_path1)

gray1 = cv2.cvtColor(img1, cv2.COLOR_BGR2GRAY)

img2 = cv2.imread(img_path2)

gray2 = cv2.cvtColor(img2, cv2.COLOR_BGR2GRAY)# 水平拼接灰度图,显示对比

merged_gray = np.hstack((gray1, gray2))

cv2.imshow("Grayscale Images", merged_gray)

cv2.waitKey(0) # 按任意键继续

(4)检测关键点与描述符

用detectAndCompute()同时检测关键点(kp)和计算描述符(des):

# 检测关键点+计算描述符(des是128维向量,形状为(N,128))

kp1, des1 = sift_detector.detectAndCompute(img1, None)

kp2, des2 = sift_detector.detectAndCompute(img2, None)# 打印关键点数量

print(f"Image 1 Key Points: {len(kp1)}")

print(f"Image 2 Key Points: {len(kp2)}")

关键点的属性(可通过kp.pt、kp.size等获取):

pt:关键点坐标(x,y);size:关键点的尺度(邻域大小);angle:关键点的主方向(0~360度);response:关键点的响应强度(越大越稳定);octave:关键点所在的尺度层级。

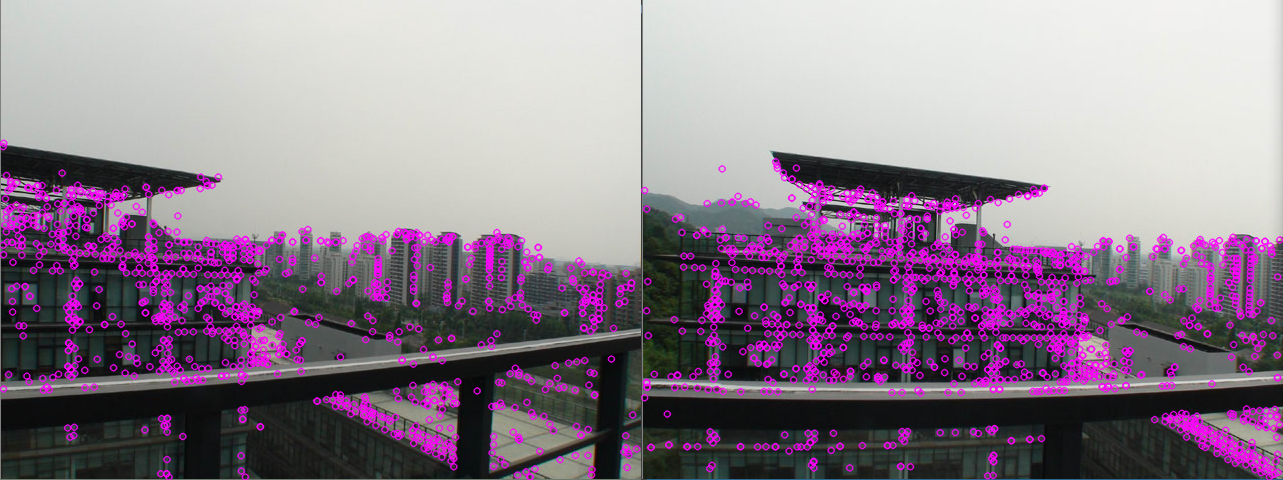

(5)绘制关键点

用drawKeypoints()将关键点可视化(紫红色圆圈):

# 绘制关键点(参数:输入图,关键点,输出图,颜色)

img_with_kp1 = cv2.drawKeypoints(img1, kp1, None, color=(255, 0, 255))

img_with_kp2 = cv2.drawKeypoints(img2, kp2, None, color=(255, 0, 255))# 拼接显示

merged_kp = np.hstack((img_with_kp1, img_with_kp2))

cv2.imshow("Key Points", merged_kp)

cv2.waitKey(0)

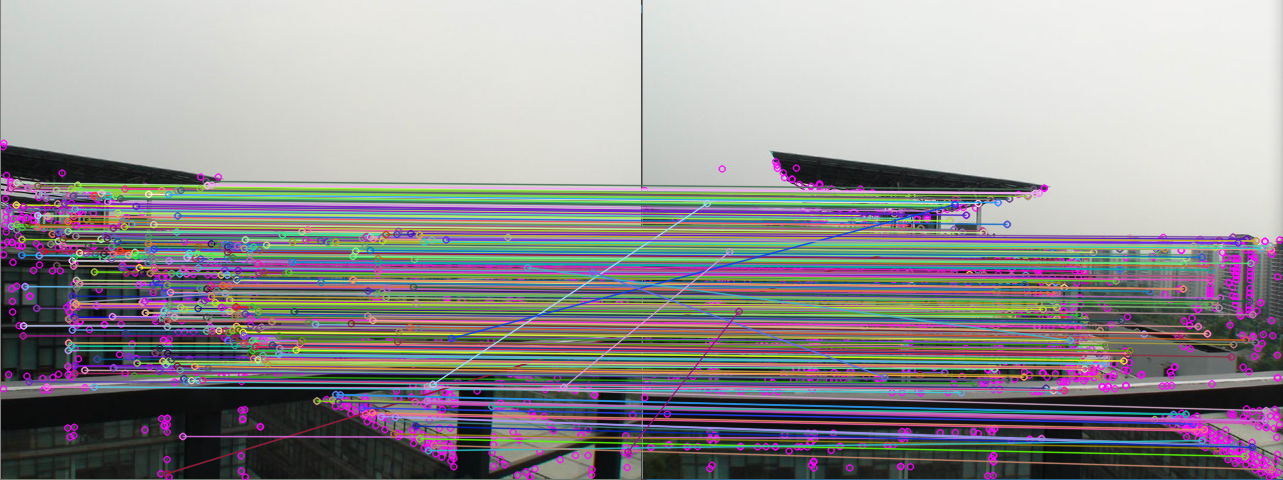

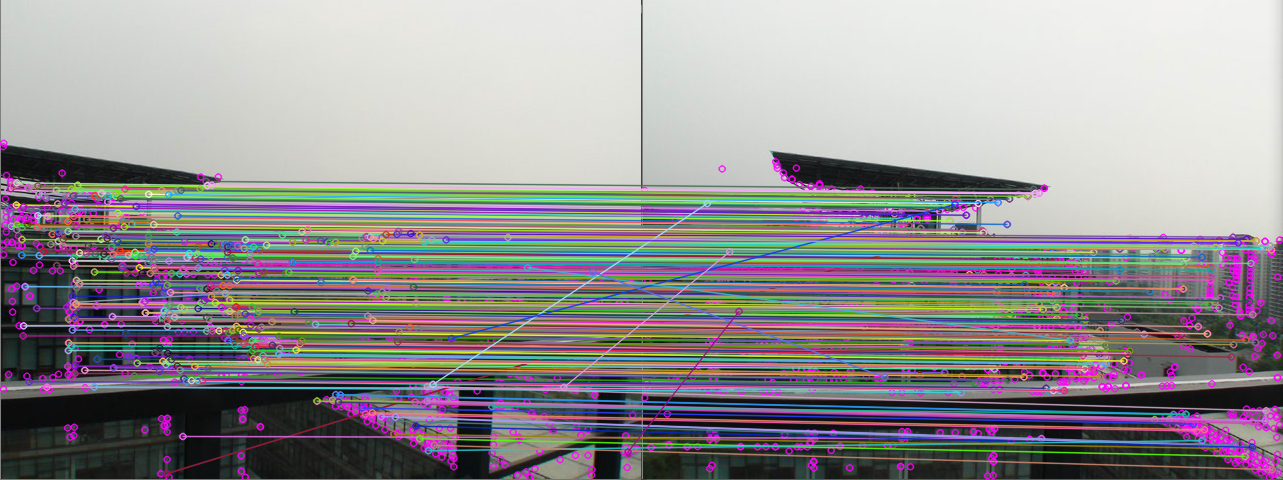

(6)关键点匹配

用暴力匹配器(BFMatcher)进行kNN匹配(k=2,取前两个最相似的特征点),再用ratio阈值筛选优质匹配:

# 初始化BFMatcher(默认用L2距离,适合SIFT描述符)

bf_matcher = cv2.BFMatcher()# kNN匹配:每个特征点找2个最相似的匹配

knn_matches = bf_matcher.knnMatch(des1, des2, k=2)# 筛选优质匹配(ratio阈值,经验值0.75)

good_matches = []

for m, n in knn_matches:# 若第一个匹配的距离远小于第二个,则保留if m.distance < 0.75 * n.distance:good_matches.append([m])# 绘制匹配结果(flags=2表示只画匹配线,不画关键点)

matched_img = cv2.drawMatchesKnn(img1, kp1, img2, kp2, good_matches, None, flags=2

)# 显示与保存结果

cv2.imshow("Good Matches", matched_img)

cv2.waitKey(0)

cv2.destroyAllWindows() # 关闭所有窗口

3. 结果分析

- 未筛选的匹配(直接用

knn_matches):线条杂乱,误匹配多(比如背景点匹配到前景); - 筛选后的匹配(

good_matches):线条清晰,误匹配少,能准确对应两张图中的相同物体。

实际应用中,ratio阈值可调整(通常取0.6~0.7)——阈值越小,匹配越严格,但可能漏掉部分正确匹配;阈值越大,匹配越宽松,但误匹配增多。