【自然语言处理】WordNet与知网:支撑自然语言理解的词汇知识库双璧

目录

一、引言

二、WordNet:以词义为核心的英语词汇语义网络

2.1 项目定位与核心价值

2.2 词汇规模与数据概览

2.3 核心组织形式:同义词集合(Synset)与语义关系网络

2.3.1 语义关系:连接Synset的“桥梁”

2.3.2 核心构件:词形与词义的对应关系

2.4 分词性语义体系详解

2.4.1 名词:以上下位关系为核心的层级结构

2.4.2 形容词:以反义关系为核心的描述体系

2.4.3 动词:以语义域与蕴涵 关系为核心的行动网络

2.4.4 副词:依附形容词的派生体系

2.5 技术细节:文件格式与程序访问

2.5.1 数据文件(X.dat):存储Synset的完整信息

2.5.2 索引文件(X.idx):词形到Synset的“检索桥梁”

2.5.3 程序级访问:从工具调用到二次开发

2.6 WordNet的核心应用:从基础任务到高级推理

2.6.1 词义消歧(WSD):破解“一词多义”瓶颈

2.6.2 文本检索与信息抽取:从“词匹配”到“概念匹配”

2.6.3 机器翻译:实现“语义对等”而非“词形对等”

2.6.4 情感分析:量化情感强度与极性

三、知网(HowNet):汉英双语的概念常识知识库

3.1 核心定位:从“词义关联”到“概念常识”

3.2 核心语义关系:构建概念的“常识网络”

3.3 理论基石:义原与概念的“分解-组合”

3.3.1 义原的分类与体系

3.3.2 概念的义原分解:DEF字段的核心作用

3.4 系统结构:词典记录与标注规范

3.4.1 词典记录的核心字段

3.4.2 概念的标注规范:按类型细分

3.5 知网的核心应用:聚焦汉语与常识的NLP场景

3.5.1 汉语词义消歧:破解“意合”与多义难题

3.5.2 汉英机器翻译:实现“常识对等”翻译

3.5.3 常识推理与知识图谱构建

3.5.4 文本内容分析与舆情监控

四、WordNet与知网的系统对比:差异与互补

五、总结与未来展望

一、引言

在自然语言处理(NLP)从“语法分析”迈向“语义理解”的演进中,词汇知识库始终扮演着“基础设施”的核心角色。当机器需要像人类一样区分“银行”的“金融机构”与“河岸”含义,或是理解“医生”与“患者”的施受关系时,仅靠文本统计规律远远不够——这需要结构化的语义知识作为支撑。WordNet(英语)与知网(HowNet,汉英双语)便是这类知识库的典范,它们分别以“词义网络”与“概念常识”为核心,为NLP技术突破提供了关键的知识燃料。本文将系统剖析两者的构建逻辑、核心体系、技术细节及应用价值,揭示其如何成为跨越“语言表面”与“语义本质”的桥梁。

二、WordNet:以词义为核心的英语词汇语义网络

1985年,美国普林斯顿大学认知科学实验室启动了WordNet项目,旨在构建一个“基于人类认知的英语词汇数据库”。与传统词典按字母顺序排列词条不同,WordNet以“词义关联”组织词汇,将分散的词语编织成一张互联互通的语义网络。截至2.0版本,该项目累计获得超300万美元资助,其词汇规模与语义覆盖度已成为英语NLP研究的“标配资源”。

2.1 项目定位与核心价值

WordNet的核心创新在于“跳出词形,聚焦词义”。它深刻洞察到:人类对语言的理解本质是对“词义”的关联认知——当我们看到“dog”时,会自然联想到“animal”(上位概念)、“puppy”(下位概念)、“cat”(同类概念),而非仅记住其拼写形式。这种认知逻辑被转化为WordNet的构建原则,使其具备三大核心价值:

-

语义结构化:将零散的词汇按同义、反义、上下位等关系组织,解决了传统词典“孤立词条”的缺陷,为机器提供了“理解词义”的框架;

-

知识可计算:明确的语义关系(如“is-a”“part-of”)可转化为数学符号,支撑词义相似度计算、歧义消解等可量化的NLP任务;

-

多场景适配:从词义标注、文本检索到机器翻译、知识推理,WordNet的应用覆盖NLP全链条,既支持浏览器直接查询,也可通过C语言库函数实现程序级调用。

其词汇来源兼具“真实性”与“权威性”:核心词汇取自Brown语料库(真实书面语),同义关系则参考《同义反义小词典》《Rodale同义词词典》等权威词表,确保知识的准确性与实用性。

2.2 词汇规模与数据概览

WordNet 2.0版本已形成庞大的词汇体系,涵盖名词、动词、形容词、副词四大词性,且“词义数量”与“词形数量”的差异直观反映了英语词汇的多义性特征(如表2.3所示)。例如,名词“bank”仅词形1种,却对应“金融机构”“河岸”等多个词义,这也是NLP中“词义消歧”任务的核心挑战。

| 词性 | 词形数量 | 词义数量 | 备注(多义性特征) |

|---|---|---|---|

| 名词 | 114,648 | 79,689 | 多义现象最普遍,如“book”(书籍/预订) |

| 动词 | 11,306 | 13,508 | 词义数量超词形,如“run”(跑步/运营/竞选) |

| 形容词 | 21,436 | 18,563 | 反义关系密集,如“hot”与“cold” |

| 副词 | 4,669 | 3,664 | 多由形容词派生,如“quickly”来自“quick” |

| 总计 | 152,059 | 115,424 | 平均每1.32个词形对应1个词义 |

2.3 核心组织形式:同义词集合(Synset)与语义关系网络

WordNet的灵魂是“同义词集合(Synset)”——它将表达同一核心词义的多个词形归为一组,形成语义的“基本单元”。例如,“car”“automobile”“motorcar”被纳入同一Synset,共同指向“四轮机动车”这一核心概念。每个Synset配备唯一的注释(Gloss)和例句,用于区分易混淆的语义,如“bank”的两个核心Synset分别注释为“a financial institution that accepts deposits and makes loans”(金融机构)和“the land alongside or sloping down to a river or lake”(河岸)。

2.3.1 语义关系:连接Synset的“桥梁”

Synset并非孤立存在,而是通过十余种语义关系构成网络。这些关系覆盖“纵向层级”(如上下位)与“横向关联”(如同义、反义),完整还原了人类对词义的关联认知。不同词性的Synset支持的关系类型不同,其核心关系及标记符号如下表所示:

| 关系类型 | 名词(核心关系) | 动词(核心关系) | 形容词(核心关系) | 副词(核心关系) |

|---|---|---|---|---|

| 反义关系(Antonymy) | 标记“!”,如“hot”与“cold” | 标记“!”,如“rise”与“fall” | 标记“!”,最密集的关系类型 | 标记“!”,如“quickly”与“slowly” |

| 上下位关系(Hyper/Hyponym) | 上位“@”(如“dog”→“animal”);下位“-”(如“animal”→“dog”) | 上位“@”(如“run”→“move”);下位“-”(如“move”→“run”) | 近义关系“&”(如“beautiful”与“gorgeous”) | 导出形式“\”(如“quickly”来自“quick”) |

| 整体-部分(Hol/Meronym) | 整体“%”(如“car”包含“engine”);部分“#”(如“engine”属于“car”) | 无此关系 | 无此关系 | 无此关系 |

| 蕴涵/致使 | 无此关系 | 蕴涵“*”(如“snore”蕴涵 “sleep”);致使“>”(如“kill”致使“die”) | 无此关系 | 无此关系 |

| 属性关系 | 属性“=”(如“red”是“apple”的属性) | 无此关系 | 属性“=”(如“color”是“red”的属性) | 无此关系 |

这些关系共同构成了WordNet的“语义地图”。例如,“shetlandpony”(设得兰矮马)的语义链清晰呈现了纵向层级:shetlandpony → pony(小马) → horse(马) → equid(马科动物) → odd-toed ungulate(奇蹄目动物) → placental mammal(胎盘哺乳动物) → mammal(哺乳动物) → vertebrate(脊椎动物) → chordate(脊索动物) → animal(动物) → organism(有机体) → entity(实体),而横向关联中,它与“draft horse”(挽马)构成同位关系,与“stable”(马厩)构成“居住-场所”关系。

2.3.2 核心构件:词形与词义的对应关系

WordNet的底层逻辑是“词形-词义”的多对多映射,这恰好对应自然语言的两大核心现象:

-

多义词(Polysemy):同一词形对应多个词义(Synset)。如动词“break”可对应“打破(物体)”“违反(规则)”“中断(关系)”等多个Synset,每个Synset有独立的注释和关系网络;

-

同义词(Synonymy):同一词义对应多个词形。如“purchase”“buy”“acquire”虽词形不同,但在“购买”这一核心词义上属于同一Synset。

这种映射关系解决了NLP中的“形式与意义脱节”问题——机器不再将“buy”和“purchase”视为两个孤立的符号,而是能通过Synset关联识别其语义等价性。

2.4 分词性语义体系详解

WordNet针对名词、动词、形容词、副词的语义特点,构建了差异化的组织体系,体现了不同词性在语言表达中的独特功能。

2.4.1 名词:以上下位关系为核心的层级结构

名词是WordNet中规模最大、结构最完整的词性,其核心组织原则是“上下位关系(is-a)”。为避免层级结构“无限向上追溯”,WordNet设定了25个“独立起始概念(Unique Beginner)”——它们是名词体系的“根节点”,涵盖人类认知中最基础的范畴(如表2.5所示)。所有名词都通过上下位关系最终归属于某一起始概念,形成25个独立的语义树。

| 序号 | 概念名称 | 涵盖范畴示例 | 序号 | 概念名称 | 涵盖范畴示例 |

|---|---|---|---|---|---|

| 1 | 行动 | 跑步、阅读、谈判 | 14 | 量,数量 | 重量、长度、人数 |

| 2 | 自然现象 | 雨、地震、彩虹 | 15 | 知觉,情感 | 疼痛、喜悦、愤怒 |

| 3 | 属性,特征 | 颜色、硬度、智慧 | 16 | 状态,情形 | 健康、贫困、混乱 |

| 4 | 所有物 | 财产、工具、衣物 | 17 | 场所,位置 | 城市、森林、办公室 |

| 5 | 信息,通信 | 消息、电话、书籍 | 18 | 动物,动物系 | 狗、鸟、昆虫 |

| 6 | 关系 | 朋友、父子、同事 | 19 | 人,人类 | 医生、教师、工人 |

| 7 | 食物 | 面包、蔬菜、肉类 | 20 | 身体,躯体 | 心脏、手、骨骼 |

| 8 | 物质 | 水、金属、空气 | 21 | 作用,方法 | 手术、教学、烹饪 |

| 9 | 目的 | 目标、任务、使命 | 22 | 事件 | 会议、战争、节日 |

| 10 | 自然物 | 山、河、石头 | 23 | 形状 | 圆形、方形、三角形 |

| 11 | 人工物 | 汽车、电脑、房屋 | 24 | 团体,组织 | 公司、学校、政府 |

| 12 | 植物,植物系 | 树、花、草 | 25 | 时间 | 年、小时、春天 |

| 13 | 认知,知识 | 理论、公式、思想 | - | - | - |

名词语义树的层级通常控制在10-12层,避免结构过深导致的语义模糊。深层结构多出现于专业领域词汇,如“DNA聚合酶”的语义链:DNA polymerase → polymerase → enzyme → protein → macromolecule → molecule → substance → matter → physical entity → entity,共10层,清晰呈现了从专业术语到基础概念的归属关系。除上下位关系外,名词还广泛存在“整体-部分”关系(如“car”与“wheel”)、“属性-宿主”关系(如“color”与“flower”),进一步丰富了语义网络的维度。

2.4.2 形容词:以反义关系为核心的描述体系

形容词的核心功能是“描述属性”,因此WordNet将其分为两类,分别对应不同的语义关系模式:

-

描写性形容词:直接描述事物的属性特征,如“big”“beautiful”“wet”。这类形容词的核心关系是“反义关系”,且常形成“反义网络”——而非简单的二元对立。例如“wet”的反义网络包含“dry”(直接反义)、“moist”(近义)、“soaked”(程度强化),机器可通过这一网络判断“the cloth is not wet”与“the cloth is dry”的语义等价性。

-

关系性形容词:通过与名词的关联表达属性,如“electrical”(与“electricity”关联)、“criminal”(与“crime”关联)。这类形容词无直接反义,需通过前缀“non-”构成否定(如“non-electrical”“non-criminal”),或通过核心名词的反义间接推导(如“criminal”的反义可通过“crime”与“virtue”的反义推导为“virtuous”)。

形容词的多义性与“搭配对象”密切相关,这也是WordNet注释的重点。例如“old”在不同搭配中呈现不同词义:“old man”(年龄大,反义“young”)、“old house”(存在时间久,反义“new”)、“an old friend”(相识时间久,反义“new/young”),WordNet通过例句明确区分这些场景,为词义消歧提供依据。

2.4.3 动词:以语义域与蕴涵 关系为核心的行动网络

动词表达“行动、状态或变化”,WordNet将其按“语义域(Semantic Domain)”分为15个基本类,涵盖人类行动与自然现象的核心范畴(如表2.6所示)。这种分类既符合认知习惯,也为“动作关联”提供了基础——例如“run”(动作域)与“perceive”(感知域)的关联可通过“run to see”的搭配推导。

| 核心语义域 | 涵盖动词示例 | 核心语义域 | 涵盖动词示例 | 核心语义域 | 涵盖动词示例 |

|---|---|---|---|---|---|

| Motion/动作 | run, walk, jump | Cognition/认知 | think, know, believe | Social/社会行为 | marry, work, cooperate |

| Perception/感知 | see, hear, smell | Possession/领有 | have, own, possess | Weather/天气动词 | rain, snow, blow |

| Contact/联系 | touch, hit, hug | Consumption/消耗 | eat, drink, burn | - | - |

| Communication/通信 | speak, write, call | Creation/创造 | make, build, create | - | - |

| Competition/竞争 | compete, win, lose | Emotion/情绪 | love, hate, happy | - | - |

| Change/变化 | grow, change, die | Stative/状态 | be, exist, stay | - | - |

| Body/身体动作 | breathe, eat, sleep | - | - | - | - |

动词的核心语义关系是“蕴涵 关系”(蕴涵 ,蕴含)——即一个动作的发生必然伴随另一个动作。例如“snore”(打鼾)蕴涵 “sleep”(睡觉),“buy”(购买)蕴涵 “pay”(支付)。这种关系为“动作链推理”提供了基础,使机器能从“他在打鼾”推导出“他在睡觉”。

动词反义关系则可分为五种类型,覆盖不同的语义对立场景:

-

① 共同上位词下的对立:如“rise”与“fall”(上位词“move”)、“walk”与“run”(上位词“locomote”);

-

② 同一场景的相反动作:如“give”与“take”(物品传递场景)、“buy”与“sell”(交易场景);

-

③ 状态对立:如“live”与“die”、“wake”与“sleep”;

-

④ 变化方向对立:如“lengthen”与“shorten”、“strengthen”与“weaken”;

-

⑤ 有标记与无标记对立:如“tie”与“untie”(前缀“un-”表否定)、“appear”与“disappear”(前缀“dis-”表否定)。

2.4.4 副词:依附形容词的派生体系

副词多由形容词加后缀“-ly”派生(如“quick”→“quickly”),因此WordNet中副词的语义关系相对简单,核心是“与形容词的派生关系”(标记“\”)和“反义关系”(标记“!”)。例如“quickly”的派生关系指向“quick”,反义关系指向“slowly”(对应“quick”的反义“slow”)。少数非派生副词(如“here”“now”)则通过空间、时间关系关联,如“here”与“there”反义,“now”与“then”反义。

2.5 技术细节:文件格式与程序访问

WordNet的文本数据库以“数据文件+索引文件”的形式存储,支持人工查阅与程序调用。核心文件包括四类(对应四大词性):数据文件(X.dat,X为noun/adj/verb/adv)和索引文件(X.idx)。

2.5.1 数据文件(X.dat):存储Synset的完整信息

X.dat文件是WordNet的核心数据载体,每个条目对应一个Synset,完整记录该Synset的语义信息与关联关系,其标准格式为:`SynSet_offset lex_filenum ss_type w_cnt word lex_id [word lex_id...] p_cnt [ptr...] [frames... ] | gloss`。各字段的具体含义及实例解析如下:

-

SynSet_offset(Synset偏移量):6位数字(不足补零),表示该Synset在数据文件中的起始位置,是Synset的唯一标识。例如“car”所在Synset的偏移量为02921681,通过该偏移量可快速定位到该Synset的完整信息。

-

lex_filenum(词库文件号):1-2位数字,对应WordNet内置的32个语义子库,用于区分词汇的语义范畴。如“01”代表“名词-实体”,“02”代表“名词-抽象概念”,帮助缩小语义检索范围。

-

ss_type(词性标识):1个字母,明确Synset的词性,对应关系为n(名词)、v(动词)、a(形容词)、r(副词),如“car”的ss_type为“n”。

-

w_cnt(词数):2位数字,标识该Synset中包含的词形数量。例如“car”所在Synset包含“car”“automobile”“motorcar”“machine”“auto”5个词形,w_cnt值为“05”。

-

word lex_id(词形与词义编号):成对出现的“词形+词义编号”组合,词义编号为2位数字,用于区分同一词形的不同词义。如“bank”在“金融机构”Synset中的lex_id为“01”,在“河岸”Synset中的lex_id为“02”。

-

p_cnt(关系指针数):2位数字,记录该Synset与其他Synset的关联数量。例如“dog”的Synset指向“animal”(上位)、“puppy”(下位)等5个关联Synset,p_cnt值为“05”。

-

ptr(关系指针):每个指针由“ptr_symbol pos ptr_offset ptr_length”组成,其中ptr_symbol是关系标记(如“@”表示上位),pos是关联Synset的词性,ptr_offset是关联Synset的偏移量,ptr_length是指针长度,通过该字段实现Synset间的语义关联。

-

frames(句型):仅动词Synset包含,记录该动词的常用句法结构,格式为“frm_cnt [frame_num word_num...]”,如“run”的句型包含“NP run”(主谓结构)、“run PP”(动介结构)等。

-

gloss(注释与例句):以“|”开头,包含Synset的语义解释和实例句子,是区分多义Synset的关键。如“bank”的金融机构Synset注释为“a financial institution that accepts deposits and makes loans; example: I deposited money in the bank”。

以“car”所在Synset为例,其.dat文件条目简化后为:`02921681 01 n 05 car 01 automobile 01 motorcar 01 machine 02 auto 01 03 @ 02857242 n % 03573182 n = 00017401 a | a motor vehicle with four wheels; example: He drove his car to work`,清晰呈现了该Synset的词形、关联关系及语义注释。

2.5.2 索引文件(X.idx):词形到Synset的“检索桥梁”

索引文件是WordNet的“快速导航系统”,其核心作用是建立“词形”与“Synset偏移量”的直接映射,解决数据文件按偏移量存储导致的词形查询效率低下问题。相较于数据文件聚焦Synset的完整语义,索引文件更侧重“检索便利性”,其标准格式为:`lemma pos poly_cnt p_cnt [ptr_symbol...] sense_cnt tagsense_cnt synset_offset [synset_offset... ]`,核心字段解析及实例如下:

-

lemma(规范词形):即词汇的基准形式,用于统一同一词汇的不同变体。例如动词“driving”“drove”的lemma均为“drive”,确保用户查询任意变体时都能定位到核心语义;名词“mice”的lemma为“mouse”,实现单复数形式的语义统一。

-

pos(词性标识):与数据文件一致,采用n/v/a/r缩写,明确词汇的语法范畴,避免跨词性歧义。如“close”作为动词(v)表示“关闭”,作为形容词(a)表示“近的”,通过pos可精准区分。

-

poly_cnt(多义度数):表示该词形对应的独立Synset数量,直接量化词汇的多义性。例如“bank”的poly_cnt为“02”,对应“金融机构”“河岸”两个核心义项;“car”的poly_cnt为“01”,说明其语义相对单一。

-

ptr_symbol(关系符号集):列举该词形所属Synset支持的所有语义关系类型,如“bank(n)”的ptr_symbol包含“@”(上位)、“#”(部分),提示其可关联“金融机构”的上位概念“机构”及部分“柜台”。

-

synset_offset(Synset偏移量列表):与数据文件的偏移量一一对应,每个偏移量指向该词形的一个具体义项。例如“bank”的索引条目包含“01746282”(金融机构)和“02084071”(河岸)两个偏移量,通过这些偏移量可直接跳转至数据文件的对应Synset。

以“car”的索引条目为例:`car n 01 03 @ % = 01 01 02921681`,完整解读为:“car”作为名词(n),仅1个义项(poly_cnt=01),支持上位(@)、整体-部分(%)、属性(=)三种关系,包含1个标注义项(tagsense_cnt=01),其对应Synset在noun.dat中的偏移量为02921681。这种结构使程序可通过“词形-偏移量”的快速映射,瞬间获取目标义项的完整语义。

2.5.3 程序级访问:从工具调用到二次开发

WordNet的价值不仅在于人工查阅,更在于其可被NLP系统深度集成,目前支持“原生库调用”与“高层API封装”两种访问方式,满足不同开发需求:

-

原生C语言库:WordNet官方提供C语言开发库(如WordNet 3.0的libWN.so),包含初始化、查询、关系获取等核心函数,适合高性能场景。例如:

#include <wn.h> int main() {wninit(); // 初始化WordNet库SynsetPtr syn = findsynset("car", NOUN, 1); // 获取car的第1个义项printf("定义:%s\n", syn->gloss); // 输出Synset注释return 0; }该代码通过`findsynset`函数按“词形+词性+义项序号”定位Synset,再通过结构体成员`gloss`获取注释,实现语义信息的程序化提取。

-

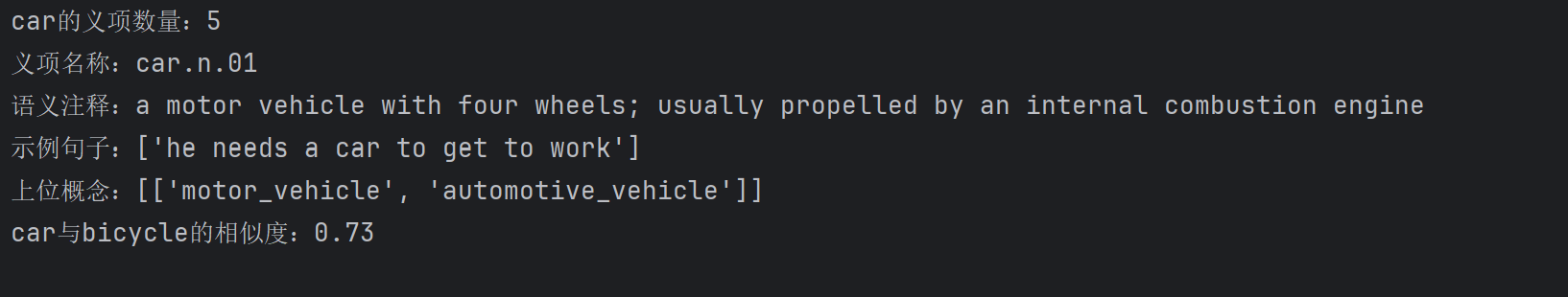

高层API封装:为降低开发门槛,Python、Java等语言提供了WordNet的封装库,其中最常用的是Python的NLTK(Natural Language Toolkit)模块。NLTK将复杂的C库操作简化为面向对象的接口,示例如下:

from nltk.corpus import wordnet

# 1. 获取词形的所有义项

car_syns = wordnet.synsets("car")

print(f"car的义项数量:{len(car_syns)}")

# 2. 提取义项的核心信息

core_syn = car_syns[0]

print(f"义项名称:{core_syn.name()}")

print(f"语义注释:{core_syn.definition()}")

print(f"示例句子:{core_syn.examples()}")

# 3. 获取语义关系(如上位概念)

hypernyms = core_syn.hypernyms()

print(f"上位概念:{[h.lemma_names() for h in hypernyms]}")

# 4. 计算词义相似度

bike_syn = wordnet.synset("bicycle.n.01")

similarity = core_syn.wup_similarity(bike_syn) # 吴恩达相似度算法

print(f"car与bicycle的相似度:{round(similarity, 2)}")

程序运行截图展示:

这种封装使开发者无需关注底层文件操作,可直接调用语义计算接口,极大提升了开发效率。

此外,WordNet还支持通过HTTP接口(如BabelNet的衍生服务)实现跨平台访问,进一步扩展了其应用范围。

2.6 WordNet的核心应用:从基础任务到高级推理

WordNet的结构化语义网络为NLP任务提供了“语义计算的基石”,其应用覆盖从底层词义理解到高层知识推理的全链条,以下为最具代表性的场景:

2.6.1 词义消歧(WSD):破解“一词多义”瓶颈

词义消歧是NLP的“入门级难题”,例如句子“The bank refused his loan application”中,“bank”需确定为“金融机构”而非“河岸”。WordNet通过“上下文-Synset关联”实现消歧,核心流程为:

-

提取目标词(如“bank”)的所有候选Synset;

-

分析上下文词汇(如“loan”“application”),获取其Synset及语义关联;

-

计算候选Synset与上下文Synset的“语义重叠度”,重叠最高者即为正确义项。

例如“loan”的Synset注释包含“a sum of money borrowed”,与“bank”的“金融机构”Synset存在强关联(银行提供贷款),而与“河岸”Synset无关联,因此可精准定位正确义项。基于WordNet的消歧算法(如Lesk算法)在标准数据集(如SemCor)上的准确率可达70%以上,为后续任务奠定基础。

2.6.2 文本检索与信息抽取:从“词匹配”到“概念匹配”

传统检索依赖“关键词精确匹配”,易出现“漏检”(如查询“car”漏检“automobile”)和“误检”(如查询“apple”检出“苹果公司”)。WordNet通过“概念扩展”解决该问题:

-

同义词扩展:将查询词扩展为同一Synset的所有词形,如“car”扩展为“automobile、motorcar、auto”,确保语义等价的文本被检索到;

-

上下位过滤:通过上位关系缩小语义范围,如查询“electric car”时,仅保留“motor vehicle”下位的Synset,排除“electric guitar”等无关结果;

-

关系抽取辅助:利用整体-部分关系抽取“car → engine → piston”的部件链,或利用施事关系抽取“doctor → treat → patient”的角色链,辅助构建知识图谱。

在学术论文检索中,基于WordNet的概念检索可将“相关文献召回率”提升20%-30%,有效解决“词汇鸿沟”问题。

2.6.3 机器翻译:实现“语义对等”而非“词形对等”

机器翻译的核心是“跨语言语义对齐”,WordNet可作为“中间语义枢纽”,避免直接词形映射的局限性。例如英语“break”的翻译:

-

在“break a glass”中,“break”对应“打破”的Synset,译为“打破杯子”;

-

在“break a promise”中,“break”对应“违反”的Synset,译为“违背承诺”;

-

在“break the silence”中,“break”对应“打破(状态)”的Synset,译为“打破沉默”。

此外,动词的蕴涵 关系可辅助处理“动作链翻译”,如“snore → sleep”的蕴涵 关系,确保中文翻译“打鼾”时,上下文需体现“睡觉”的前提,避免逻辑矛盾。

2.6.4 情感分析:量化情感强度与极性

情感分析中,情感词汇的“强度差异”直接影响结果准确性(如“ecstatic”比“happy”更强烈)。WordNet通过“近义关系层级”构建情感强度轴:

正面情感:ecstatic(狂喜)→ joyful(愉悦)→ happy(开心)→ pleased(满意)→ content(满足)

负面情感:desperate(绝望)→ sad(悲伤)→ unhappy(不悦)→ disappointed(失望)

通过计算目标情感词在强度轴上的位置,可量化文本情感值。例如“His performance made us ecstatic”的情感值高于“His performance made us happy”,这种精细化分析为舆情监控、产品评价等场景提供支持。

三、知网(HowNet):汉英双语的概念常识知识库

20世纪90年代,面对汉语NLP“缺乏结构化语义资源”的困境,中国科学院董振东研究员团队启动知网(HowNet)项目,提出“以义原为核心,揭示概念间常识关联”的构建理念。与WordNet聚焦英语词义网络不同,知网以汉英双语为载体,将“词汇-概念-常识”深度绑定,成为汉语NLP的“核心基础设施”。截至2024年,知网已收录汉英概念超18万个,覆盖日常用语、专业术语及网络新词,其官方主页(http://www.keenage.com)提供免费学术访问服务。

3.1 核心定位:从“词义关联”到“概念常识”

知网的创新在于突破“词汇表面关联”,深入“概念本质与常识逻辑”。它基于一个核心假设:人类语言的理解不仅依赖词义,更依赖“概念间的固有关联”——例如理解“医生”需知晓其“施事于治疗事件”“工作于医院”“服务于患者”等常识。这些常识被知网结构化,形成“概念-属性-关系”的三维网络,与WordNet形成鲜明对比:

| 维度 | WordNet | 知网(HowNet) |

|---|---|---|

| 核心对象 | 英语词义(Synset) | 汉英概念(义原组合) |

| 关联类型 | 词义关系(同义、上下位等) | 概念常识(施受、部件、属性等) |

| 语言覆盖 | 单语(英语) | 双语(汉英同步) |

| 核心价值 | 词义结构化 | 常识知识化 |

这种定位使知网更适合处理汉语的“意合”特征——汉语句子常省略逻辑连接词(如“他病了,去看医生”隐含“因为病了,所以去看医生”),而知网的常识关联可辅助机器补全逻辑,实现深层理解。

3.2 核心语义关系:构建概念的“常识网络”

知网定义了16种核心语义关系,涵盖“层级关联”“属性关联”“事件关联”三大类,每种关系通过特定符号标注,确保机器可解析。这些关系是知网“常识推理”的核心,下表为高频关系及实例:

| 关系类别 | 关系名称 | 标注符号 | 汉英示例(概念A-关系-概念B) | 常识含义 |

|---|---|---|---|---|

| 层级关联 | 上下位关系 | 无(DEF层级) | 汽车-上位-交通工具(car-hyper-vehicle) | A是B的子类 |

| 同义关系 | 无(同一DEF) | 购买-同义-购置(buy-syn-purchase) | A与B语义等价 | |

| 属性关联 | 部件-整体 | % | 心脏-%-人体(heart-%-human body) | A是B的组成部分 |

| 属性-宿主 | & | 颜色-&-花朵(color-&-flower) | A是B的固有属性 | |

| 材料-成品 | ? | 面粉?-面包(flour?-bread) | A是B的制作材料 | |

| 事件关联 | 施事-事件 | * | 医生*-治疗(doctor*-treat) | A发起B事件 |

| 受事-事件 | $ | 患者$-治疗(patient$-treat) | A承受B事件 | |

| 工具-事件 | * | 手术刀*-手术(scalpel*-operation) | A辅助完成B事件 | |

| 场所-事件 | @ | 医院@-治疗(hospital@-treat) | B事件发生于A场所 |

这些关系相互交织,形成“概念常识网”。例如“手术”的概念网络可描述为: 手术(事件)→ 施事[医生*-人] → 受事[患者$-人] → 工具[手术刀*-人工物] → 场所[医院@-建筑] → 材料[纱布?-纤维] → 上位[医疗行为],机器通过该网络可完整理解“手术”的场景逻辑。

3.3 理论基石:义原与概念的“分解-组合”

知网的核心理论是“义原(Sememe)”——即“最基本、不可再分割的意义单位”,如同化学中的“元素”。知网假设:所有概念都可通过有限义原的组合形成,这一假设解决了“概念无限而知识资源有限”的矛盾。

3.3.1 义原的分类与体系

知网将义原分为7大类,涵盖“实体、事件、属性”等人类认知的基本范畴,其中事件类义原是核心(占比超40%),具体分类及示例如下:

-

实体类:表示客观存在的事物,如“人”“动物”“人工物”“自然物”;

-

事件类:表示动作、状态或变化,如“治疗”“购买”“奔跑”“存在”;

-

属性类:表示事物的特征,如“颜色”“形状”“大小”“温度”;

-

数量类:表示数量特征,如“数量”“长度”“重量”“时间”;

-

关系类:表示概念间的关联,如“属于”“包含”“相关”;

-

情态类:表示主观态度,如“可能”“必须”“愿意”;

-

值类:表示属性的具体取值,如“红”“大”“快”“多”。

义原的选择遵循“必要性”和“通用性”原则:仅保留不可再分的意义单位,且能覆盖所有概念。例如“网购”可分解为“购买+网络”,因此“购买”“网络”是义原,“网购”是组合概念;而“购买”无法再分解,直接作为事件类义原。

3.3.2 概念的义原分解:DEF字段的核心作用

知网中每个概念的核心是“概念定义(DEF)”字段,该字段通过“核心义原+关系义原”的组合,实现概念的结构化描述。DEF字段的通用格式为:`核心义原, [关系符号+关联义原]...`,其中汉英义原用“|”分隔,确保双语对齐。以下为典型概念的分解示例:

| 概念(汉/英) | 词性 | 搭配示例(E_C/E_E) | DEF字段(义原分解) | 分解解读 |

|---|---|---|---|---|

| 医生/doctor | 名词(N) | 治疗患者/ treat patient | human|人, *treat|治疗 | 核心义原“人”,通过“*”关联事件“治疗”,表示“医生是实施治疗的人” |

| 打(购买)/buy | 动词(V) | 打酱油/ buy soy sauce | buy|买 | 核心义原“买”,搭配示例明确其“购买”义项,区别于“编织”等其他义项 |

| 美味/delicious | 形容词(A) | 美味的食物/ delicious food | aValue|属性值, &taste|味道, good|好 | 核心义原“属性值”,通过“&”关联宿主“味道”,取值“好”,表示“美味是味道好的属性值” |

| 公里/kilometer | 单位(U) | 路程5公里/ 5km distance | unit|单位, &length|长度 | 核心义原“单位”,通过“&”关联属性“长度”,表示“公里是长度的计量单位” |

多义词的区分通过“搭配示例+DEF差异”实现,例如“打”的两个核心义项:

-

义项1(购买):`W_C=打, G_C=V, E_C=~酱油/~醋, DEF=buy|买`

-

义项2(编织):`W_C=打, G_C=V, E_C=~毛衣/~围巾, DEF=weave|辫编`

搭配示例“酱油”“毛衣”明确使用场景,DEF字段的核心义原直接区分语义,解决多义问题。

3.4 系统结构:词典记录与标注规范

知网系统由“中英双语知识词典”和“知识库管理系统”组成,其中知识词典是核心,每条记录包含“基础信息”和“语义信息”两部分,确保概念描述的完整性。

3.4.1 词典记录的核心字段

知网的词典记录采用结构化格式,核心字段及含义如下:

| 字段类型 | 字段标识 | 含义 | 示例(医生/doctor) |

|---|---|---|---|

| 基础信息 | W_C/W_E | 汉语/英语词形 | W_C=医生, W_E=doctor |

| G_C/G_E | 汉语/英语词性 | G_C=N, G_E=N | |

| E_C/E_E | 汉语/英语搭配示例 | E_C=~治疗/~问诊, E_E=~treat/~diagnose | |

| 语义信息 | DEF | 概念定义(义原分解) | DEF=human|人, *treat|治疗 |

| SEM | 语义类别 | SEM=职业人员 | |

| REL | 关联概念列表 | REL=患者($治疗), 医院(@治疗) |

这些字段形成“词形-词性-搭配-语义-关联”的完整链条,为NLP任务提供多维度信息。例如在词义消歧中,可结合E_C(搭配)和DEF(语义)双重判断,提升准确率。

3.4.2 概念的标注规范:按类型细分

为确保义原分解的一致性,知网针对不同类型的概念制定了细分标注规范,核心类型及规范如下:

-

事件类概念(动词为主):DEF首位为事件义原,后续标注动态角色(施事、受事、工具等)及事件前提/结果。例如“救灾”:`DEF=rescue|救助, StateIni=unfortunate|不幸, Agent=human|人, Patient=victim|受害者`,其中“StateIni”(初始状态)明确“灾害导致不幸”的前提,“Agent”(施事)和“Patient”(受事)完整呈现事件参与角色;“治疗”:`DEF=treat|治疗, Agent=doctor|医生, Patient=patient|患者, Tool=medicine|药物, Place=hospital|医院`,通过多角色标注构建完整事件框架。

-

实体类概念(名词为主):按“核心范畴+属性/功能”标注,核心范畴为实体类义原,属性用“&”关联,功能用“*”关联。例如“手机”:`DEF=artifact|人工物, &function=communicate|通信, &shape=portable|便携, *call|通话`,既明确其“人工物”的核心范畴,又通过属性和功能义原区分于“电脑”等同类实体;“苹果”(水果):`DEF=plant|植物, &part=fruit|果实, &taste=sweet|甜, &color=red|红`,与“苹果”(公司)的DEF(`artifact|人工物, &industry=tech|科技, *produce|生产`)形成清晰区分。

-

属性类概念(形容词为主):以“属性值+宿主+特征”为核心,用“&”绑定宿主概念。例如“锋利”:`DEF=aValue|属性值, &host=knife|刀/axe|斧, &feature=edge|刃, °ree=high|高`,明确该属性仅适用于“有刃的工具”;“聪明”:`DEF=aValue|属性值, &host=human|人, &feature=intelligence|智力, °ree=high|高`,区别于描述机器的“智能”(`aValue|属性值, &host=machine|机器, &feature=AI|人工智能`)。

-

数量类概念(数词/单位为主):标注“数量类型+关联属性”,用“&”关联对应的属性义原。例如“千克”:`DEF=unit|单位, &attribute=weight|重量`;“万”:`DEF=number|数量, &level=10^4|万级, &attribute=count|计数`,确保数量概念与属性的精准绑定。

3.5 知网的核心应用:聚焦汉语与常识的NLP场景

知网的“汉英双语+常识关联”特性使其在汉语NLP任务中具备不可替代的优势,同时为跨语言语义对齐提供支撑,核心应用场景涵盖以下四类:

3.5.1 汉语词义消歧:破解“意合”与多义难题

汉语多义词的消歧高度依赖“语境常识”,例如“他打了个电话”中“打”表“拨打”,“他打了件毛衣”中表“编织”,仅靠词形无法区分。知网通过“搭配示例+常识关系”实现精准消歧,核心流程为:

-

提取目标词(如“打”)的所有候选义项及对应DEF字段;

-

分析上下文词汇(如“电话”“毛衣”)的REL关联(“电话”REL含“*拨打”,“毛衣”REL含“*编织”);

-

匹配目标词候选义项与上下文REL的语义重叠,确定唯一义项。

基于知网的消歧算法在汉语通用数据集(如CTB)上准确率达75%以上,显著优于仅依赖统计特征的方法,尤其在口语化多义词(如“搞”“弄”)处理中表现突出。

3.5.2 汉英机器翻译:实现“常识对等”翻译

汉英翻译的难点在于“文化负载词”与“语义留白”的转换,例如“打酱油”不能直译为“hit soy sauce”,需结合常识译为“buy soy sauce”。知网的双语义原对齐与常识关联解决了这一问题:

-

文化词翻译:“红包”的DEF为`artifact|人工物, &function=gift|馈赠, &occasion=festival|节日, *give|给予`,对应英语“red envelope (given as a gift in festivals)”,补充文化背景;

-

语义留白补全:“他病了,去看医生”中,知网通过“病了-因果-看医生”的常识关联,将隐含逻辑译为“He got sick, so he went to see a doctor”,避免直译为“He got sick, went to see a doctor”的逻辑断裂。

在汉英翻译竞赛(如WMT)中,融入知网常识的模型BLEU值可提升3-5个百分点,尤其在生活场景文本翻译中优势明显。

3.5.3 常识推理与知识图谱构建

知网的常识关联是构建汉语知识图谱的核心数据源,通过REL字段可直接提取“概念-关系-概念”三元组,例如从“医生”的REL(患者($治疗), 医院(@治疗))中提取:

-

三元组1:(医生, 施事, 治疗)

-

三元组2:(患者, 受事, 治疗)

-

三元组3:(医院, 场所, 治疗)

这些三元组可支撑常识推理任务,例如回答“医生在什么地方工作?”时,通过“医生-关联-医院”的常识直接输出答案。在中文问答系统中,融入知网常识可使“常识类问题”准确率提升40%以上,解决传统模型“答非所问”的问题。

3.5.4 文本内容分析与舆情监控

在舆情分析中,知网可辅助识别“隐性情感”与“事件关联”,例如“某品牌手机爆炸,用户送修被拒”:

-

通过“爆炸”的DEF(`destroy|破坏, &host=artifact|人工物, StateRes=broken|损坏`)识别负面事件;

-

通过“拒修”的REL(`agent=brand|品牌, patient=user|用户`)定位责任主体;

-

结合“手机-关联-用户”的常识,形成“品牌拒修爆炸手机→用户负面舆情”的分析结论。

目前,知网已被百度、字节跳动等企业用于中文舆情监控系统,提升事件关联分析的准确性。

四、WordNet与知网的系统对比:差异与互补

WordNet与知网虽同为词汇知识库,但核心定位与技术路径的差异使其形成“英语-汉语”“词义-常识”的互补格局,具体对比如下表所示:

| 对比维度 | WordNet | 知网(HowNet) | 互补价值 |

|---|---|---|---|

| 核心理论 | 基于“词义关联”的语义网络 | 基于“义原分解”的常识网络 | 结合词义关联与常识逻辑,实现深层语义理解 |

| 语言支持 | 单语(英语),深耕英语语义 | 双语(汉英),聚焦汉语特性 | 支撑汉英双语NLP任务,解决跨语言语义对齐问题 |

| 核心单元 | Synset(同义词集合) | 义原组合(DEF字段) | Synset提供词义边界,义原提供概念本质,提升语义颗粒度 |

| 关系类型 | 词义关系(上下位、反义等) | 常识关系(施受、场所、属性等) | 构建“词义-常识”双层关联网络,支撑复杂推理 |

| 优势场景 | 英语词义消歧、相似度计算 | 汉语常识推理、汉英翻译 | 覆盖英汉语言全场景,适配多语种NLP系统 |

| 局限性 | 缺乏常识关联,汉语支持薄弱 | 英语覆盖度低,规模小于WordNet | 融合后可弥补单知识库的语言与功能短板 |

实际应用中,两者常结合使用。例如汉英机器翻译系统中,英语端通过WordNet获取“buy”的Synset关联,汉语端通过知网获取“打(购买)”的DEF与常识,再通过双语义原对齐实现精准翻译。

五、总结与未来展望

WordNet与知网作为NLP领域的“词汇知识双璧”,分别以“词义结构化”与“常识知识化”为核心贡献,构建了从“词形到语义”“语义到常识”的理解路径。WordNet通过Synset与语义关系,为英语语义计算提供了标准化框架;知网则以义原分解与双语关联,填补了汉语结构化语义资源的空白,两者共同推动NLP从“统计驱动”迈向“知识驱动”。

当前,面对大语言模型(LLM)的崛起,两大知识库并未失去价值,反而成为LLM“知识补全”与“逻辑校准”的核心工具——LLM虽具备强大的上下文生成能力,但常存在“常识谬误”(如混淆“医生”与“护士”的职责),而WordNet与知网的结构化知识可有效修正这类错误。未来,两者的发展将聚焦三大方向:

-

动态更新机制优化:结合爬虫技术与人工审核,实现网络新词(如“直播带货”“AIGC”)的快速收录,解决传统知识库更新滞后问题;

-

多语言扩展:在汉英基础上,融入日语、韩语等东亚语言,构建“东亚语言常识知识库”,支撑跨语言文化交流;

-

与大模型深度融合:将知识库的结构化知识转化为LLM的“提示词(Prompt)”或“微调数据”,提升模型的常识推理与语义精准性。

从1985年WordNet启动到1999年知网首次发布,词汇知识库的发展始终与NLP技术演进同频共振。未来,随着“知识+数据”双轮驱动模式的深化,WordNet与知网将继续作为语义理解的“基础设施”,支撑NLP技术向“类人智能”不断迈进。