深入洞察:大模型推理能力及MindIE引擎

大模型推理需兼顾 “成本 - 性能 - 效果” 三个目标架构图,可从核心目标、技术痛点、优化方向及核心技术方法展开解析:

一、核心目标:成本、性能、效果的协同优化

大模型推理需在三者间实现平衡,最终支撑大模型落地应用的效果满足、性能提升与成本压缩,这也是 “大模型推理优化” 的核心内涵:

成本:涵盖经济成本(算力、存储资源投入)与时间、人力、迁移、适配成本(模型部署、迭代的隐性成本)。

性能:聚焦服务级 SLA(服务等级协议),包括时效性(如 T1/T1’、TP90、Q2 延迟)、吞吐量(RPS、TPS)、稳定性(延时、失败率、流量波动耐受度),直接影响用户体验。

效果:强调服务的准确率、丰富性、全面性,是 “场景 - 效果 - 性能” 联合约束下的核心价值体现。

二、技术痛点:传统推理模式的局限

在大模型推理需求激增的背景下,传统推理模式暴露出明显不足:

前期推理平台功能重复、服务能力不足,难以支撑多业务场景的差异化需求。

系统优化多为单任务场景导向,缺乏对复杂业务的多样性支持,无法兼顾多业务目标。

三、优化方向:推理系统 + 推理优化的技术融合

通过 “推理系统架构革新” 与 “推理优化技术迭代”,实现大模型推理的多目标兼顾:

(一)推理系统架构:模块化、适配化设计

系统架构(PD 分离):采用 “模型与推理 Pipeline 解耦(PD 分离)” 设计,提升架构的灵活性与可扩展性,支持多模型、多场景的快速适配。

典型新模型适配:针对LLM / 多模态模型(大语言模型、多模态大模型)、MoE 架构(混合专家模型,通过路由机制提升推理效率)等新型大模型,设计专属推理流程与资源调度策略。

典型场景适配:覆盖长上下文处理(如多轮对话、文档理解场景的大窗口推理)、低时延 / 高并发 / 流量波动场景(如实时智能客服、大规模用户访问场景),通过架构分层、资源弹性调度等技术满足场景需求。

(二)推理优化核心技术与方法

为实现 “成本 - 性能 - 效果” 目标,大模型推理优化需围绕以下核心技术展开:

模型压缩技术:

量化(Quantization):将模型参数从浮点数(如 FP32)压缩为低精度整数(如 INT8、INT4),在几乎不损失精度的前提下,减少显存占用与计算量,降低硬件成本并提升推理速度。

剪枝(Pruning):移除模型中对推理效果贡献低的权重或神经元,精简模型结构,同时保持核心能力,实现 “瘦身增效”。

推理加速框架:

TensorRT、ONNX Runtime:通过图优化、算子融合、内核自动调优等技术,针对 GPU、CPU 等硬件进行推理流程加速,提升吞吐量与降低延迟。

专用推理芯片适配:针对 NVIDIA Tensor Core、昇腾 AI 芯片等专用硬件,开发定制化推理算子与并行策略,最大化硬件算力利用率。

分布式推理与服务化部署:

模型并行(Model Parallelism):将大模型的不同层或模块分散到多个设备上并行计算,突破单设备显存与算力瓶颈,支持超大模型的推理落地。

服务化框架(如 Triton Inference Server):提供多模型、多框架的统一推理服务接口,支持动态批量推理、模型版本管理、负载均衡等功能,提升推理服务的稳定性与资源利用率。

上下文学习与推理增强:

思维链(Chain of Thought, CoT):在推理提示中加入 “分步思考” 逻辑,引导大模型生成更严谨的推理过程,提升复杂任务的效果,同时通过结构化输出减少无效计算。

检索增强生成(RAG):结合外部知识库(如向量数据库),在推理时动态检索相关知识,弥补大模型 “幻觉” 问题,提升效果的同时,可通过知识复用降低重复推理成本。

综上,大模型推理优化是一项系统工程,需通过架构革新 + 技术组合拳(模型压缩、硬件加速、分布式部署、推理增强等),在 “成本可控、性能达标、效果满足” 的目标下,推动大模型从 “实验室创新” 走向 “规模化产业落地”,最终实现大模型赋能的持续、健康、经济发展。

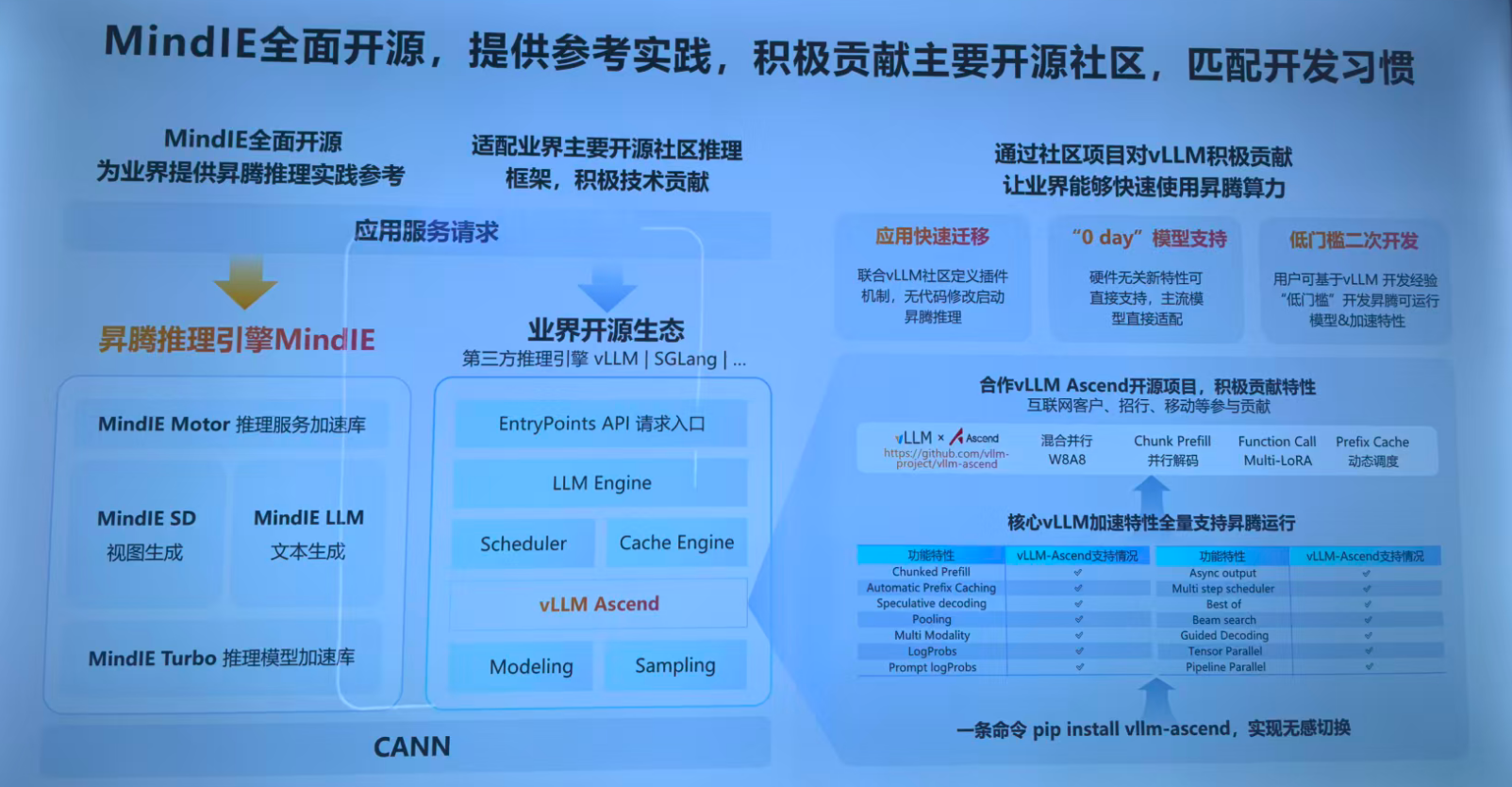

介绍MindIE推理引擎:

一、核心组件:昇腾推理引擎 MindIE 的模块化架构

MindIE 作为昇腾生态下的推理引擎,采用分层模块化设计,为大模型推理与多模态应用提供技术支撑:

MindIE Motor 推理服务加速库:聚焦推理服务的性能加速,为上层应用提供低延迟、高吞吐的服务能力。

场景化加速模块:

MindIE SD(视图生成):针对 Stable Diffusion 等文生图模型,提供多模态(文本→图像)推理的专属加速能力。

MindIE LLM(文本生成):面向大语言模型(LLM)的文本生成任务,优化推理效率与效果。

MindIE Turbo 推理模型加速库:从模型层面进行优化,通过量化、剪枝、算子融合等技术,提升模型推理的硬件利用率与速度。

底层依赖:CANN:昇腾异构计算架构(CANN)是 MindIE 的硬件支撑层,提供昇腾芯片的算力调度、算子优化等基础能力,使推理任务能高效利用昇腾硬件资源。

二、开源适配:兼容业界主流开源生态,降低开发门槛

为匹配开发者习惯、融入开源生态,MindIE 通过技术适配实现与业界主流推理框架的协同:

对接第三方推理引擎(如 vLLM、SGLang):通过EntryPoints API 请求入口、LLM Engine、Scheduler(调度器)、Cache Engine(缓存引擎)、Modeling(模型层)、Sampling(采样层)等模块,实现对 vLLM 等开源推理框架的深度集成,让昇腾算力能支持这些框架的推理任务。

生态价值:这种适配让开发者无需改变原有基于开源框架的开发习惯,即可将推理任务迁移到昇腾硬件上,推动昇腾生态与开源生态的融合。

三、社区贡献:深度参与 vLLM 开源项目,赋能昇腾算力规模化应用

通过参与 vLLM 社区的开源项目,MindIE 将昇腾算力的能力注入主流开源生态,具体体现为:

核心特性支持:在 vLLM-Ascend 项目中,全面支持 vLLM 的核心加速特性,如Chunked Prefill(分块预填充)、Automatic Prefix Caching(自动前缀缓存)、Speculative Decoding(推测解码)、Multi Modality(多模态)等,确保昇腾硬件能充分发挥 vLLM 的性能优势。

创新特性贡献:向社区贡献混合并行W8A8、Chunk Prefill并行解码、Function Call Multi-LoRA(多 LoRA 函数调用)、Prefix Cache动态调度等特性,提升昇腾在大模型推理场景的竞争力。

开发者友好性:

应用快速迁移:联合 vLLM 社区定义插件机制,开发者无需修改代码即可启动昇腾推理,降低迁移成本。

“0 day” 模型支持:具备硬件无关新特性直接支持能力,主流模型可直接适配昇腾,实现新模型的快速落地。

低门槛二次开发:开发者可基于 vLLM 的开发经验,“低门槛” 开发昇腾可运行的模型与加速特性,拓展昇腾生态的应用边界。

部署便捷性:通过pip install vllm-ascend一条命令即可完成安装,实现无感切换。

综上,MindIE 通过模块化架构设计、开源生态适配、深度社区贡献,构建了 “昇腾硬件 + 开源软件 + 开发者生态” 的协同体系,既为业界提供了昇腾推理的实践参考,又通过融入主流开源社区让昇腾算力能被更广泛的开发者使用,最终推动昇腾在大模型推理与多模态应用场景的规模化落地。