AI研究-117 特斯拉 FSD 视觉解析:多摄像头 - 3D占用网络 - 车机渲染,盲区与低速复杂路况安全指南

TL;DR

- 场景:很多人把中控 3D 渲染当“真实世界”,这很危险。

- 结论:常规场景下可高度依赖,但5 类边缘场景必须降级人工;文内给出“可依赖/不可依赖”清单与验证方法。

- 产出:场景决策表 + 盲区/感知缺陷速查卡,附 HW3/HW4 差异对照

车机渲染模型的原理与真实一致性

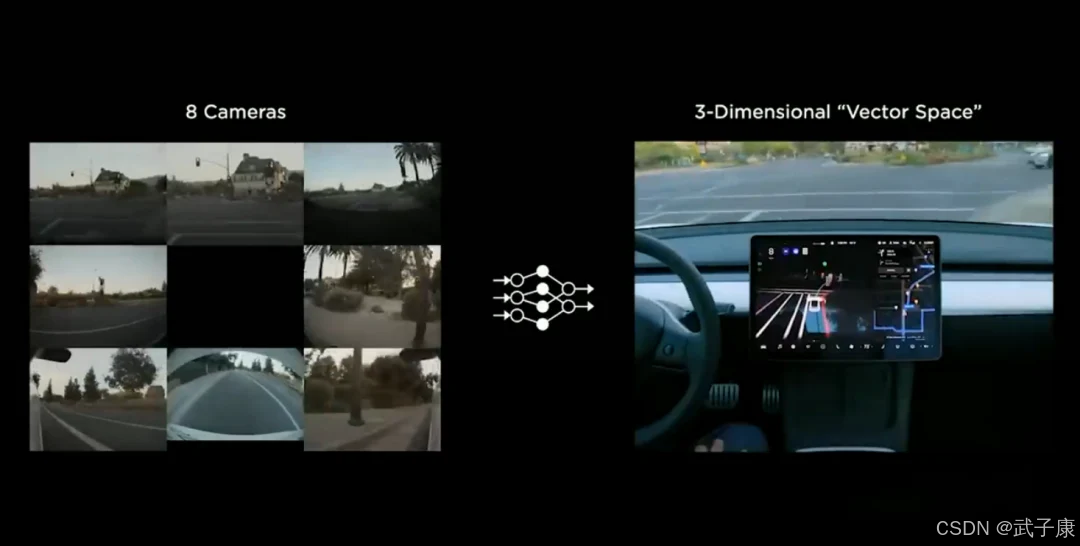

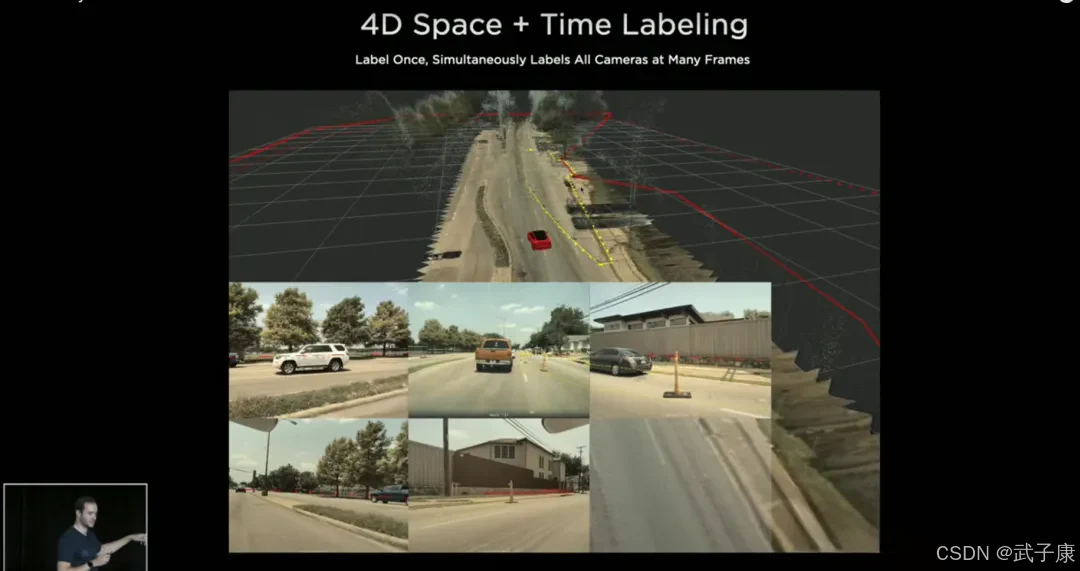

特斯拉Model Y行车时,中控屏幕会实时渲染车辆周围环境模型,包括车道线、路缘、行人、车辆、锥筒等元素。其背后的工作原理是特斯拉自研的神经网络视觉感知框架:车辆的8个摄像头图像经过神经网络处理,被投影到统一的鸟瞰坐标系下,形成三维Occupancy Network(占用网格)。

占用网络将汽车周围空间划分成细小网格体素,神经网络判别每个体素是否被物体占据,从而构建出一幅高精度三维环境地图。与此同时,网络也输出每个物体的语义标签(如车辆、行人、道路标线)和运动信息。这种方法等效于3D重建:把多路摄像头的2D图像“拼接”成车辆周围的动态3D场景。

早期(HW2.0/2.5时代)特斯拉视觉主要依赖特征识别+几何模型,比如侦测到车辆的特征点再推算距离。这容易漏检非常规障碍物(如不规则形状的碎片)。而引入Occupancy Network后,系统只要检测到空间中存在实体,无论它是否属于已知类别,都会在3D地图中标记出来。这极大提升了感知全面性,弥补了过去“非典型物体”导致碰撞的隐患。

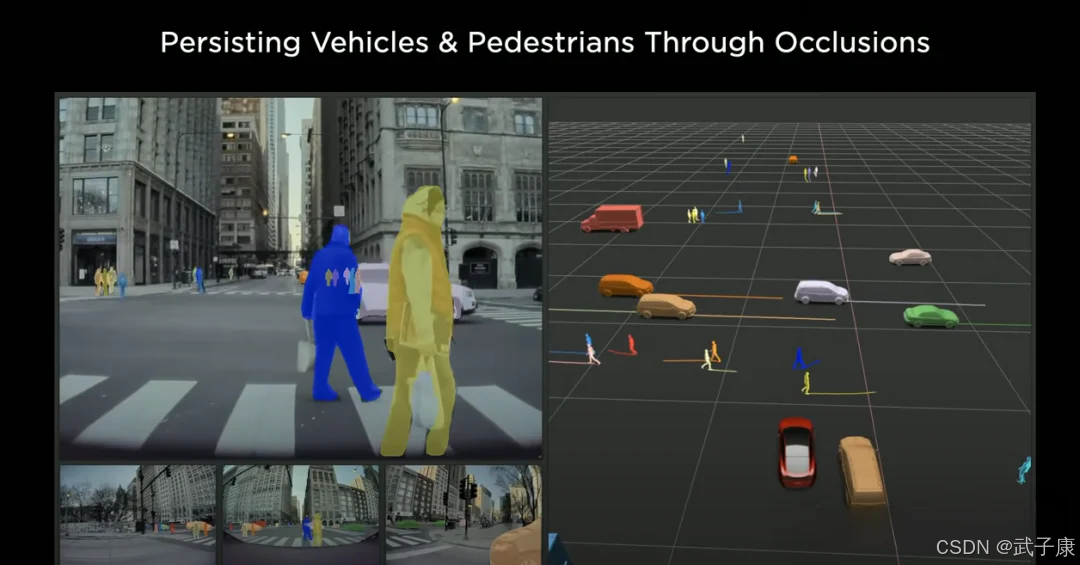

特斯拉FSD团队负责人Ashok在AI Day上也解释过,他们用摄像头+占用网络来解决通用障碍物检测问题。渲染模型底层采用卷积神经网络+Transformer架构,对摄像头图像进行时空融合,保证输出的环境模型在时间上连续稳定,不会每帧乱跳。即使有物体瞬间因遮挡消失,网络通过上下文也能保持该物体的存在(即对象永久性),减少可视化中的闪烁。

在车机屏幕上,我们看到的就是这个经过处理的鸟瞰视角3D模型:车辆自己位于中央,其它车辆以矩形图标显示,道路边界以半透明墙体或线条显示,行人以小人图标显示,动态箭头和路牌也同步呈现。这套模型实际上就是FSD决策的输入,它与真实世界环境的一致性非常高,因为是从摄像头画面直接“学”出来的。

例如,有用户停车测试中控屏渲染,发现连地面停车位的白线都准确画出,周围停的车距车身几寸都拿捏到位。再比如在黑暗小巷,屏幕模型能显示出两侧建筑墙面的大致轮廓和停放的垃圾桶位置,帮助驾驶者感知肉眼难以看到的细节。可以说,特斯拉的渲染模型并非简单动画,而是基于神经网络的实时3D感知重建,大体上可信地反映了周围环境。

然而,这个模型的可靠性也有局限。一方面,摄像头视野有限,视觉盲区(如车身正前正后贴近车头/车尾的区域)在模型中可能缺失或滞后更新——之前提到的停车场景,当障碍物近到摄像头看不到时,渲染将依赖记忆,导致位置不够精准。

另一方面,神经网络有时会出现误检或漏检:早期版本FSD曾在屏幕上漏掉粗大的柱子(因为未识别为已知类别)从而撞上 ;也曾把悬空的招牌阴影误判为路障急刹(即幽灵刹车)。最新Occupancy算法已减少此类错误,但在非常复杂的场景下,模型仍可能出现不稳定。

例如,一些用户报告当周围环境瞬息变化时,屏幕上的行人或车辆图标会轻微抖动或位置跳变,这反映神经网络在边缘情况下的不确定性。另外,渲染模型在识别道路属性上有时也和实际不符,比如把浅色的水坑渲染成固体障碍。这些都是当前视觉AI的挑战。

总体而言,特斯拉车机渲染模型在常见场景下与真实世界环境高度一致,已经足以让驾驶者“只看屏幕也能停车”。但在特殊场景(极端光照、怪异物体、超近距离等),渲染模型仍可能存在偏差,提醒我们不能过度依赖视觉显示而忽视了用肉眼和后视镜去确认真实情况。

驾驶者盲区信息与低速复杂环境可靠性

侧后方盲区监测

传统汽车多用后视镜警示灯或后方雷达提供并线盲区提醒,特斯拉则依赖摄像头视觉和屏幕显示。Model Y的B柱摄像头朝后斜看,覆盖车身两侧后方区域;侧后视摄像头(翼子板上的)正后看,覆盖并线盲区。当有车辆在你后侧方接近时,Autopilot视觉会在屏幕上将该车辆显示为紧邻Model Y,并高亮相邻车道线为红色,以示警告。

另外,打转向灯时中控会自动弹出对应侧摄像头的实时影像,小车图标也会变红,提示“盲区有车”。在良好条件下(白天、视野开阔),这套视觉盲点监测能够可靠地探测到大多数车辆或摩托车,覆盖角度几乎相当于肉眼+后视镜。

然而,用户反馈指出一些局限:首先,纯视觉盲区警示没有蜂鸣或振动提示,驾驶者必须注意看屏幕或镜子才能发现警示信号。有些司机觉得低头看屏幕不如直接看侧镜自然,而且屏幕上车辆图标的位置不容易快速感知距离远近。

其次,在雨夜或逆光等情况下,侧向摄像头画质下降,可能漏判快速靠近的车辆。此外,特斯拉没有配备后保险杠侧向雷达,所以倒车出车位时的横向来车提醒较弱 。许多其他品牌车在倒车时都有后方交叉车流警报(RCTA),一旦有侧后方来车会嘟嘟报警甚至自动刹车。但特斯拉依赖摄像头视觉——如果侧后方来车被旁边车辆挡住,Model Y要等其驶入摄像头视野才会在屏幕显示,可能已经比较靠近了。

因此在倒车离位这种驾驶员视线受限的情况,Model Y的渲染模型虽可提供一定辅助(比如屏幕上会出现侧方来车的红色高亮箭头),但远不如雷达式RCTA那样预见性强。特斯拉官方也在用户手册中提示,倒车时需要司机自行通过左右后视镜观察横向来车,系统只是辅助而非主导。

低速复杂环境依赖程度

低速场景包括狭窄小巷、拥堵城市街道、施工路段、停车场等。在这些环境中,静态和动态障碍物众多且随机,视觉感知面临很高挑战。Model Y在开启FSD Beta或Autopilot时会尝试处理此类场景,但经验表明:对于特别复杂或不可预测的情况,驾驶者应降低对自动驾驶的依赖。

有长期FSD Beta用户总结,在拥堵路段或复杂交通下最好暂时关闭FSD,因为系统有时会因为犹豫或尝试空间不足的变道而陷入僵局,影响通行。例如,当在没有红绿灯的路口要穿过繁忙主路时,FSD通常表现不佳:它要么迟迟不敢动弹,要么贸然窜出导致危险,这种情况下驾驶员往往需要立刻接管。又比如在施工区域,路线导引不清晰且锥筒密布,视觉模型可能混淆临时车道,于是错乱决策。

专业评测人员也多次强调,在这些极端场景FSD仍是L2级别,需要人类全程警戒,一旦系统行为不当要瞬时接管。用户社区也分享了一些FSD的失败案例:如某次Beta版在郊区道路遇对向来车时错误地转向左侧逆行,险些撞车;又如在有停车标志的路口,旧版本曾几乎没有减速直接闯过STOP标志。虽然新版软件已经修正了闯停的问题,但这些事例提醒我们FSD目前不可完全信任。

总结社区经验,可以较为信赖渲染模型和自动驾驶的场景包括:高速公路巡航(车道清晰、车流简单,Model Y视觉足以保持车距和居中行驶),简单城市道路(有清晰车道线和信号灯的常规路况,FSD可处理大部分车辆和行人交互),以及标准停车操作(在障碍物清楚的停车位,屏幕3D模型可准确引导停车 )。在这些场景下,众多车主反馈特斯拉视觉驾驶表现令人满意,渲染模型所见即所得,可以给予相当程度的信心。

反之,以下场景不建议依赖甚至坚决不能依赖自动驾驶和屏幕模型:

- 繁忙无控路口/并道: 没有红绿灯的路口、需强行并线的场合,FSD无法通晓人类驾驶者的礼让意图,容易进退失据甚至违规,务必由驾驶人掌控 。

- 极端天气: 暴雨大雾大雪中,摄像头视野受阻,尽管车可能仍显示环境模型,但其准确性和完整性大打折扣,此时应当人工驾驶或安全地点停车,切勿迷信屏幕显示。

- 复杂施工及突发异物: 面对施工改道、前方出现掉落货物、坑洞等非常规障碍,视觉模型可能无法及时、正确地呈现。这类情况下坚决不要依赖车辆自动反应,驾驶者必须提前绕行或减速避让。曾有案例中自动驾驶对前方巨大落物未做任何显示和反应,差点撞击。

- 狭窄曲折山路高速行驶: 前述急弯场景下,如果以较高速度行驶(尤其夜间山路),自动驾驶可能无法完美判断路况并控制车速,不能盲信系统,应该减速并人工掌舵。

- 不明交通手势/指挥: 当遇到交警手势指挥、临时交通管制等需要社会化理解的情况,当前视觉AI无能力理解人类手势或临时标语,驾驶者切勿依赖车辆自己“读懂”这些信息,必须自行接管。

最后,从社区反馈来看,多数Model Y车主对特斯拉视觉感知的优势和局限有清醒认识——在常规驾驶中,它是强大的辅助工具,但在边缘场景下仍需人来兜底。随着HW4.0硬件的铺开和FSD软件的演进,视觉系统的可靠性将继续提升。例如,HW4.0更高清摄像头和占用网络让停车场景已经几乎可以“盲停”依赖屏幕。

但正如马斯克所言,HW3硬件车主未来可能无法实现真正L4级别自动驾驶,这暗示即便有再多软件更新,旧硬件受限可能终究无法覆盖所有极端场景。而HW4.0带来的增强传感和算力,为特斯拉朝更高自动化迈进提供了基础。在那之前,谨慎地使用和监督自动驾驶,是对自身安全和他人负责的表现。

综上,我们可以依赖Model Y的视觉渲染模型在多数日常情形下提升感知范围和驾驶便利,但也必须明确在哪些场景下绝不能完全信赖它,从而做出正确的驾驶决策,充分发挥人机协同的优势。

参考文献

参考文献:

1. Yeslak博客:《Tesla Hardware 4 vs Hardware 3: 如何辨识版本》- 摄像头和算力升级

2. AutoPilot Review网站:《Tesla Hardware 4 (HW4)最新详情》- HW4传感器套件(新增摄像头位置、Phoenix雷达)

3. InsideEVs新闻:《硬件3 vs 硬件4区别解析》- HW4处理器性能提升及新摄像头套件

4. 博客Blog or Die:《我的Model Y HW4新硬件探秘》- HW4摄像头分辨率与帧率实测

5. Autoevolution评测:《特斯拉高保真泊车辅助准确度实测》- 纯视觉泊车方案的效果与缺陷

6. Reddit论坛:HW4 vs HW3车主对比FSD体验 – 性能差异和相似之处

7. CleanTechnica专栏:《FSD Beta 10.69改进与不足》- 用户长测总结FSD易失败场景

8. Reddit论坛:Vision泊车 vs 超声波对比测试 – 精度及问题分析

9. EET-China电子工程专辑:《特斯拉HW4.0与HW3.0硬件对比》- 新老硬件传感器和芯片详细差异

10. 华泰证券研报:《如何理解特斯拉的当下与未来》- 硬件迭代配置对比表(摄像头、雷达、算力)

场景对比

| 场景 | 推荐级别 | 你应当怎么做 | 系统常见问题 | 兜底动作 |

|---|---|---|---|---|

| 高速巡航(线清晰) | ✅ 可依赖 | 看远端 + 屏幕近距 | 切入车反应滞后 | 提前松油 + 增加跟车 |

| 简单城市路口(信号清晰) | ✅ | 观察屏幕箭头与车道 | 行人/非机动车密集犹豫 | 保持人工优先 |

| 停车位/地库低速 | ✅ | 低速+看屏幕盲区 | 极近距更新滞后 | 切换镜面+小幅点刹 |

| 无控路口/强并道 | ❌ 不建议 | 人工主导礼让 | 博弈失败 | 关闭/降级辅助 |

| 极端天气/逆光雨夜 | ❌ | 人工主导 | 画面噪声大 | 降速/择机停车 |

| 施工改道/非典型落物 | ❌ | 人工主导 | 锥桶/临时线混淆 | 早减速绕行 |

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究,持续打造实用AI工具指南!

AI-调查研究-108-具身智能 机器人模型训练全流程详解:从预训练到强化学习与人类反馈

🔗 AI模块直达链接

💻 Java篇持续更新中(长期更新)

Java-154 深入浅出 MongoDB 用Java访问 MongoDB 数据库 从环境搭建到CRUD完整示例

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

🔗 Java模块直达链接

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

🔗 大数据模块直达链接