ollma dify 搭建合同审查助手

目录

ollma下载地址:

qwen3 模型下载

这个自动下载,下载后自动运行。

配置环境变量:

ollma下载地址:

Download Ollama on macOS

qwen3 模型下载

ollama pull qwen3:8b

这个自动下载,下载后自动运行。

ollama run qwen3:0.6b

ollama run qwen3:8b

配置环境变量:修改监听后很慢

OLLAMA_HOST

0.0.0.0:11434

OLLAMA_MODELS

C:\Users\Administrator\.ollama\models

变快的方法:

OLLAMA_HOST:127.0.0.1:11434

测试命令:

curl http://192.168.1.8:11434/api/tags

ollama list 模型配置url:

参考:https://zhuanlan.zhihu.com/p/1925558582130217565

http://host.docker.internal:11434

模型名称: qwen3:8b

在模型名称中填写上一步下载的模型,如果不知道模型名称可以打开cmd,输入ollama list查看已经安装的模型。基础URL代表的是Ollama 服务地址,Ollama是默认暴露11434端口进行API调用,如果Dify是通过Docker部署的话,在基础URL中填入http://host.docker.internal:11434即可,如果是其他方式部署的Dify,可以参考帮助文档:https://docs.dify.ai/zh-hans/development/models-integration/ollama。剩余参数保持默认即可。最后点击保存

如果保存按钮变成灰色并且迟迟没有保存成功,可以参考一下步骤重新启动Dify的Docker服务以及重新启动大模型。

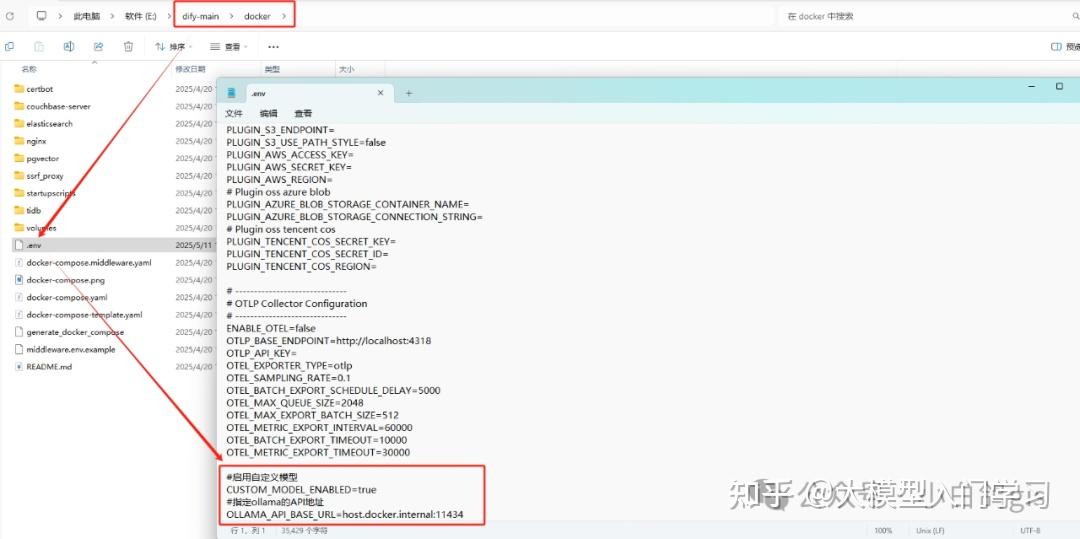

进入到Dify的工程文件,找到docker文件夹里的.env文件,用记事本打开,并在最后添加以下内容:

#启用自定义模型

CUSTOM_MODEL_ENABLED=true

#指定ollama的API地址

OLLAMA_API_BASE_URL=host.docker.internal:11434