上交具身机器人的视觉运动导航!HTSCN:融合空间记忆与语义推理认知的导航策略

- 作者:Qiming Liu 1 ^{1} 1, Guangzhan Wang 2 ^{2} 2, Zhe Liu 3 , 4 ^{3,4} 3,4 and Hesheng Wang 1 , 3 , 5 , 6 ^{1,3,5,6} 1,3,5,6

- 单位: 1 ^{1} 1上海交通大学自动化系, 2 ^{2} 2上海交通大学软件学院, 3 ^{3} 3上海交通大学教育部人工智能重点实验室, 4 ^{4} 4人工智能研究院, 5 ^{5} 5教育部海洋智能装备与系统重点实验室, 6 ^{6} 6上海智能控制与管理工程技术研究中心

- 论文标题:Visuomotor Navigation for Embodied Robots With Spatial Memory and Semantic Reasoning Cognition

- 论文链接:https://ieeexplore.ieee.org/abstract/document/10682097

- 出版信息:IEEE Transactions on Neural Networks and Learning Systems ( Volume: 36, Issue: 5, May 2025)

主要贡献

- 统一的双层图结构:将记忆和推理能力分别表示为拓扑图和语义关系图,并在一个统一的双层图结构中进行处理。

- 跨模态关系学习:引入基于神经的认知提取过程,捕捉层次化图之间的跨模态关系,增强了决策性能和整体智能水平。

- 在线层次关系学习:通过图池化实现在线跨层关系学习,建立了两个不同认知模态之间的有机连接,充分利用综合认知对决策的增强效果。

- 实验验证:在仿真和真实环境中验证了HTSCN的有效性,实验结果表明HTSCN在导航性能和路径效率方面显著优于现有的单模态认知导航方法。

研究背景

- 在机器人自主导航领域,传统的基于几何环境建模和规划的方法虽然能够实现自主导航,但由于缺乏高层次的信息表示,难以支持主动思考和智能决策。

- 近年来,基于神经网络的导航方法逐渐受到关注,这些方法通过模仿人类的认知过程,利用记忆和推理能力来提升导航性能。然而,现有研究大多只关注记忆或推理中的某一方面,而忽视了它们之间的有机联系。

- 记忆和推理在功能和表示形式上存在显著差异,如何将它们有效地整合在一起,成为了一个亟待解决的问题。

相关工作

- 基于学习的导航方法:传统导航技术基于几何环境建模和规划,虽然实现了自主导航,但缺乏高层次信息表示,难以支持主动思维和智能决策。近年来,基于神经网络的导航方法在探索、目标导向导航、图像目标导航和视觉-语言导航等任务中得到了广泛应用。

- 空间记忆:记忆能力通过保存情景观察来创建场景表示。现有研究通过引入外部记忆结构(如RNN、LSTM、NTM等)来扩展机器人的时空视野。HTSCN框架采用拓扑图作为空间记忆结构,并在线构建拓扑图,利用图卷积网络(GCN)提取全局记忆特征。

- 语义推理:推理能力基于长期先验经验进行任务目标的概率推断。现有研究通过构建语义关系图来提供先验知识,利用视觉关系检测和大规模图像数据集进行关系推理。HTSCN设计了一个双层图结构,将记忆和推理能力表示为拓扑图和语义关系图,并通过层次化学习实现两者的有机结合。

- 记忆与推理能力的结合:现有研究大多单独考虑单一认知模态或将两者简单拼接,未能充分利用两者的协同效应。HTSCN通过层次化学习机制,在线融合记忆和推理能力,提升导航性能。

方法

- 本文提出了一种名为分层拓扑-语义认知导航(HTSCN)的端到端视觉导航框架,旨在通过将空间记忆和语义推理能力无缝集成到一个统一的系统中,提升机器人在未知环境中的自主认知和决策能力。

- HTSCN通过将记忆和推理能力分别表示为拓扑图和语义关系图,并在一个统一的双层图结构中进行处理,从而实现两者的有机结合。

基于拓扑图的空间记忆

基于检索网络的拓扑图构建

- HTSCN采用拓扑图作为记忆结构,通过检索网络评估输入图像对的相似性,在线构建拓扑图并定位查询图像的节点。

- 检索网络的架构处理两个RGB图像作为输入,生成一个从0到1的相似度评分,值越接近1表示感知相似度越高。机器人通过比较当前图像与每个节点观察的相似性来构建拓扑图。

拓扑记忆的节点特征

拓扑图由邻接矩阵 A [ M × M ] t A_{[M\times M]}^{t} A[M×M]t 和节点矩阵 X [ M × D ] t X_{[M\times D]}^{t} X[M×D]t 组成。邻接矩阵存储拓扑节点之间的连接关系,节点矩阵存储每个节点的向量,包含视觉信息、机器人定位向量和目标定位向量。具体编码如下:

- 视觉观察:使用ResNet50提取并转换为256维视觉特征。

- 机器人定位向量:通过比较当前观察与存储观察的相似性设置。

- 目标定位向量:通过比较拓扑节点图像与目标图像的相似性设置。

记忆特征提取

利用三层GCN提取拓扑图中的空间记忆特征。第一层的输入为节点矩阵 X [ M × D ] t X_{[M\times D]}^{t} X[M×D]t,输出为:

H t ( 1 ) = σ ( F ( A [ M × M ] t , H t ( 0 ) , W t ( 0 ) ) ) H^{t(1)}=\sigma\left(F\left(A_{[M\times M]}^t, H^{t(0)}, W^{t(0)}\right)\right) Ht(1)=σ(F(A[M×M]t,Ht(0),Wt(0)))

其中, W t ( 0 ) W^{t(0)} Wt(0) 是可训练权重矩阵, σ ( ⋅ ) \sigma(\cdot) σ(⋅) 是激活函数, F ( ⋅ , ⋅ , ⋅ ) F(\cdot,\cdot,\cdot) F(⋅,⋅,⋅) 表示图卷积操作。通过引入第二和第三层GCN进一步提取空间记忆特征,最终将节点特征转换为256维的记忆向量。

基于关系图的语义推理

语义关系图构建

- 语义关系图是对象关系的结构化表示,节点表示对象类别,边表示它们之间的连接。

- 通过获取模拟环境中的对象类别作为语义节点,并基于Visual Genome数据集建立节点之间的边。

- 边的相关性通过对象在同一图像中的共现频率确定。

语义关系图的节点特征

语义关系图由邻接矩阵 A [ N × N ] s A_{[N\times N]}^{s} A[N×N]s 和特征矩阵 X [ N × d ] s X_{[N\times d]}^{s} X[N×d]s 组成。邻接矩阵存储对象之间的关系,特征矩阵包含视觉信息、目标对象信息和当前观察的检测结果编码。具体编码如下:

-

对象图像:使用ResNet50提取并转换为256维视觉特征。

-

目标对象信息:通过ResNet50提取目标对象的视觉特征。

-

检测结果编码:从模拟器API获取当前观察中的语义标签,并转换为256维向量。

语义关系特征提取

利用三层GCN提取语义关系图中的语义关系特征。第一层的输入为节点特征矩阵 X [ N × d ] s X_{[N\times d]}^{s} X[N×d]s,输出为:

H s ( 1 ) = σ ( F ( A [ N × N ] s , H s ( 0 ) , W s ( 0 ) ) ) H^{s(1)}=\sigma\left(F\left(A_{[N\times N]}^s, H^{s(0)}, W^{s(0)}\right)\right) Hs(1)=σ(F(A[N×N]s,Hs(0),Ws(0)))

通过引入第二和第三层GCN进一步提取语义关系特征,最终将节点特征转换为256维的语义向量。

层次化关系学习

HTSCN通过在线融合语义关系图和拓扑图,实现记忆和推理能力的无缝集成。具体过程如下:

-

生成分配矩阵S:通过粗图池化生成分配矩阵S,用于粗略聚类和合并语义关系图的N个节点。

-

建立映射关系并生成关系矩阵C:基于分配矩阵S和拓扑图的邻接矩阵,生成两个图之间的关系矩阵C。

-

提取层次化关系信息Z:通过GCN从双层关系图中提取层次化关系信息Z。

策略生成

- 策略生成模块在每个时间步接收当前和目标观察,利用预训练的ResNet50提取视觉特征,并与认知特征Z结合,通过全连接层生成导航策略。

- 在训练过程中,计算输出动作与专家指令之间的交叉熵损失,并结合两个辅助任务的损失优化整个网络。

实施

任务和超参数设置

- 本文在iGibson仿真器中进行图像目标视觉导航任务,机器人需在最多500个时间步内到达目标位置。

- 机器人配备单目RGB摄像头,分辨率为144×192,水平视场角为90°,动作空间包括左转15°、前进0.15米和右转15°。

- 语义关系图节点数N设为26,拓扑图节点数M动态变化,其他参数如相似性比较阈值参考相关文献。

训练策略和测试设置

训练分为三个阶段:

- 首先预训练检索网络,其次单独训练策略输出模块,最后联合训练整个HTSCN模型。

- 第二和第三阶段通过模仿学习优化,收集72个训练场景中的3.12K个专家策略。

- 测试在14个不同场景中进行,包含519个测试任务,难度分为简单、中等和困难三个等级。

- 评估指标包括成功率(SR)、路径长度加权成功率(SPL)和成功距离(DTS)。

基线和消融模型

- 比较了多种基线模型和消融模型的性能,包括Reactive、Nav A3C、HGCNN、VGM、TSGM、HTSCN及其消融模型(如仅使用空间记忆或语义推理的模型)。

- HTSCN在所有难度等级的任务中均表现出显著的性能提升,特别是在困难任务中,成功率显著高于其他模型。

实验结果与分析

图像目标导航

- 导航指标:

- HTSCN在所有难度级别的任务中表现出显著的导航性能提升,成功率达到78.74%(简单)、56.58%(中等)和41.14%(困难),显著高于基线模型如Reactive和Nav A3C。

- 与VGM和TSGM模型相比,HTSCN的成功率分别提高了28.18%和45.88%,在困难任务中,相对成功率提升进一步扩大到35.19%和89.49%。

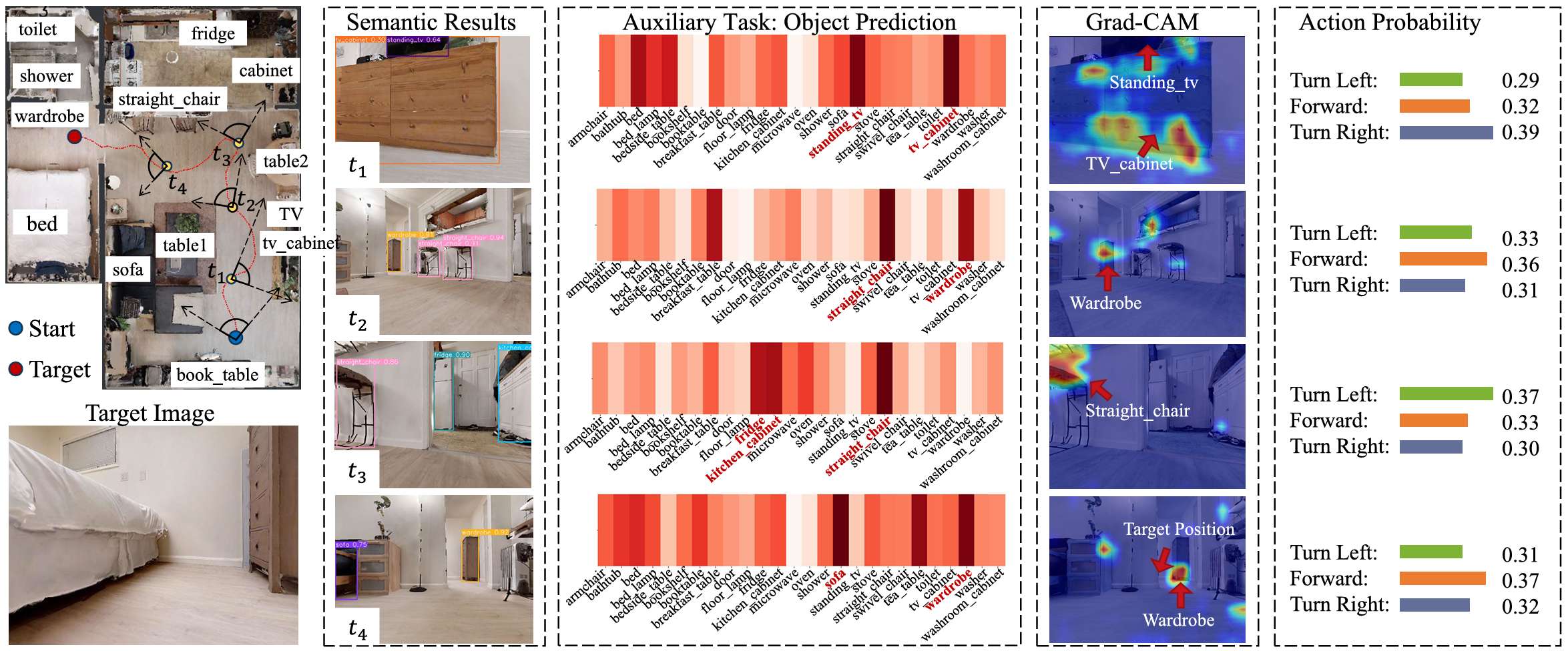

- 典型导航行为可视化:

- HTSCN表现出更少的重复探索行为,并且在交叉路口更倾向于朝向目标移动,导航步数也更少,这与表格中的SPL得分一致。

可视化与解释结果

- 拓扑记忆解释:

- 通过辅助任务预测目标方向,验证了拓扑记忆模块能够有效提取和利用任务相关特征。

- 语义推理解释:

- 语义推理模块成功学习了利用语义关系图中的信息来优化导航策略,Grad-CAM分析显示网络注意力集中在与目标高度相关的对象上。

- 层次关系学习解释:

- 图融合操作有效学习了记忆和推理之间的跨模态关系,节点映射矩阵显示了语义节点和拓扑节点之间的连接概率。

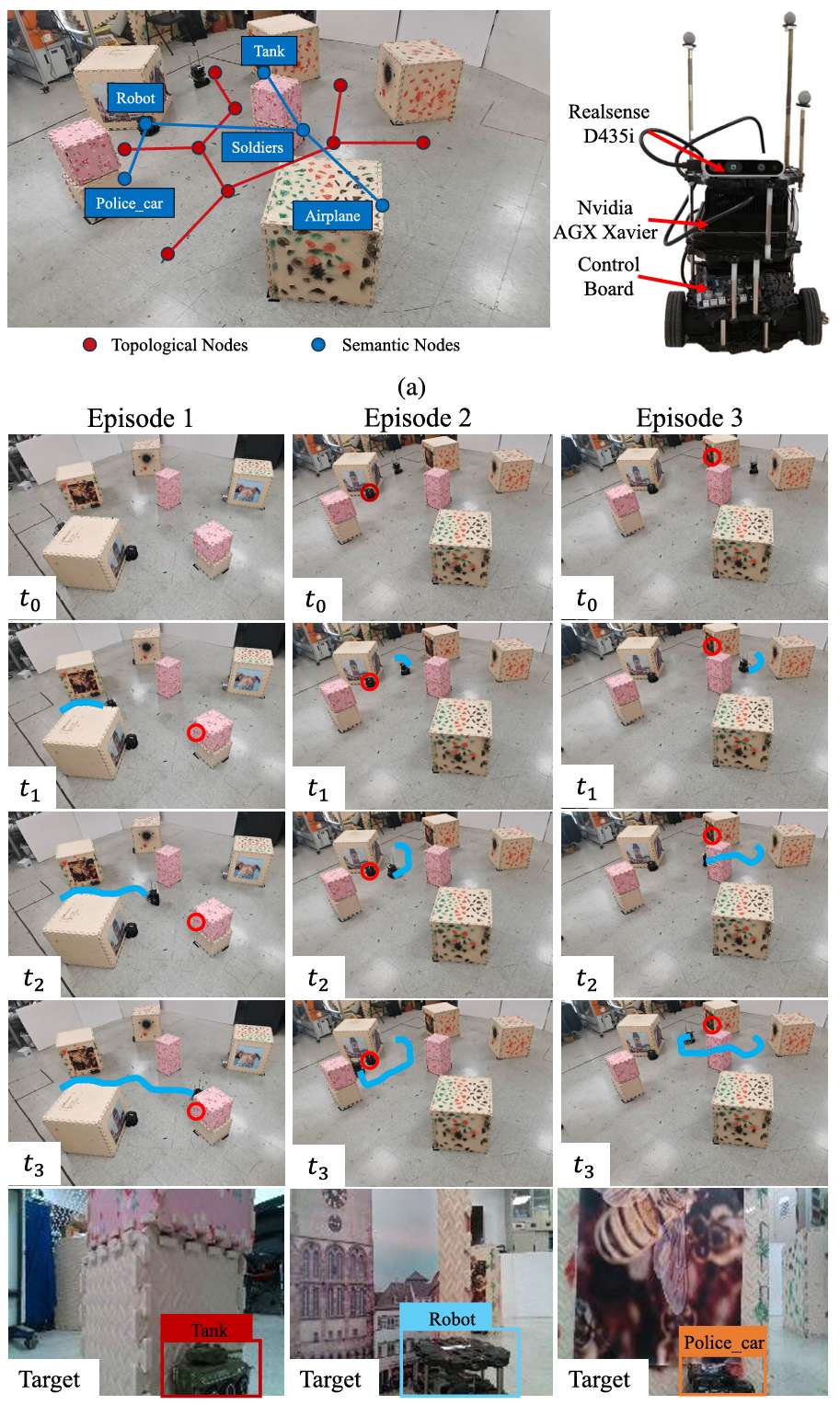

实际场景部署

- 真实世界测试:

- 在Turtlebot机器人上部署HTSCN模型,使用Realsense D435i摄像头和Nvidia AGX Xavier平台,成功完成了导航任务,验证了系统的实际应用潜力。

- 实时性能:

- 在模拟环境中,HTSCN的推理速度为76.12ms,在真实环境中为160.61ms,满足实时性能要求。

实时性能

- HTSCN在模拟和真实环境中的推理速度分别为76.12ms和160.61ms,尽管在真实环境中速度较慢,但仍能满足实时性能需求。

总体结论

- 论文提出的HTSCN框架通过将空间记忆和语义推理能力无缝集成到一个端到端的系统中,显著提升了机器人在未知环境中的导航性能和路径效率。

- 实验结果表明,HTSCN在仿真和真实环境中均表现出色,验证了其在实际应用中的潜力。

- 未来的工作将致力于设计更统一的多模态认知表示方法,以进一步提高系统性能和效率。